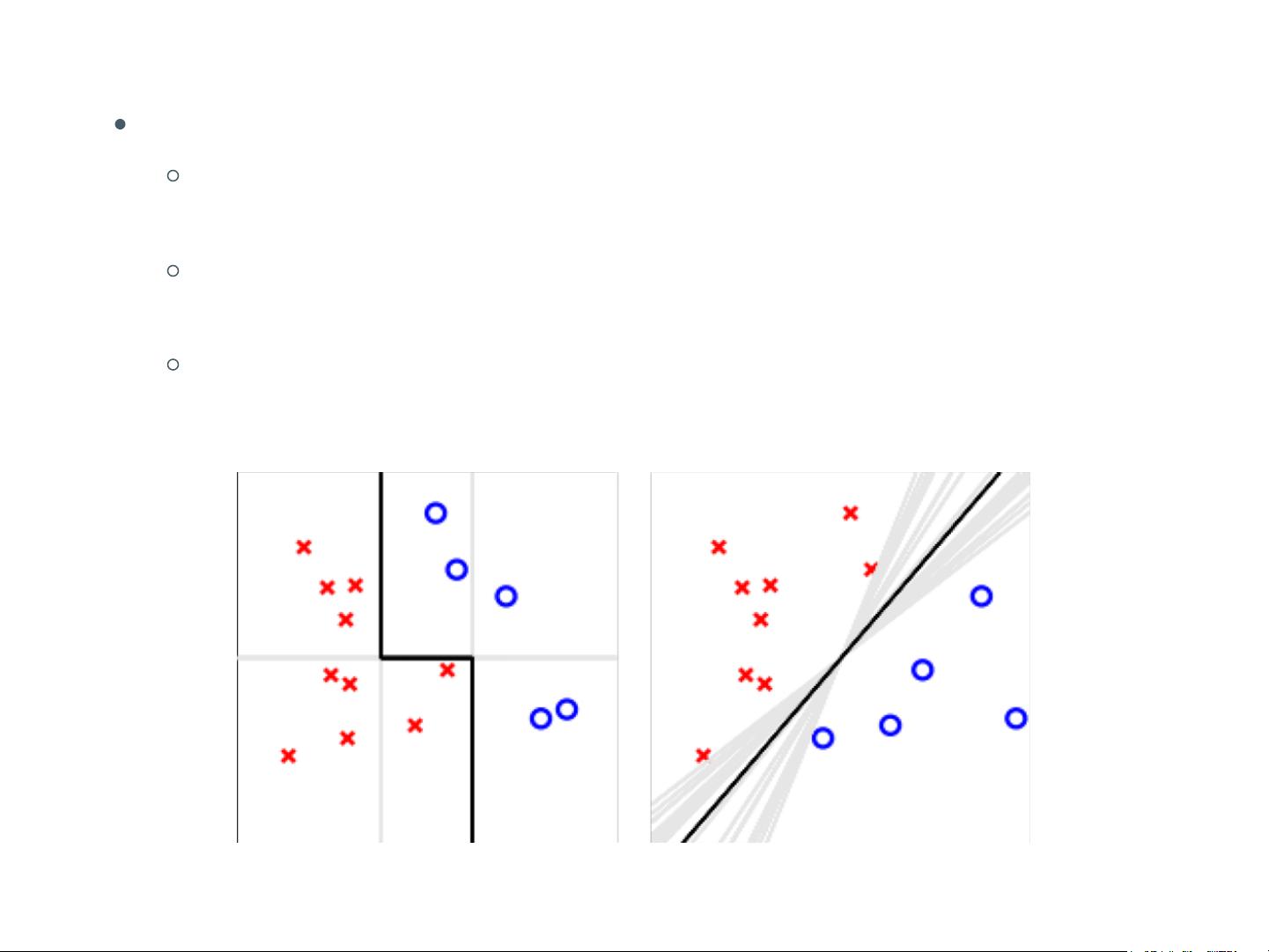

集成学习(Ensemble Learning)是一种机器学习方法,其核心思想是通过组合多个学习器(也称为基学习器或组件学习器)的预测结果来提升整体的预测准确性和稳定性。这种技术广泛应用于各种复杂的机器学习任务,如分类和回归,尤其在大数据和复杂模式识别中效果显著。 集成学习的基础是理解弱学习器和强学习器的概念。弱可学习是指一个概念可以通过学习算法以略高于随机猜测的正确率进行学习,而强可学习则意味着存在一个学习算法能够在多项式时间内以很高的正确率学习该概念。在PAC学习框架下,一个概念是强可学习的充分必要条件是它是弱可学习的。 集成学习的优势主要体现在三个方面: 1. 统计角度:集成多个学习器可以减少因单一学习器误选导致的泛化性能下降,因为可能存在多个假设在训练集上有相近的性能。 2. 计算角度:通过多次运行和结合学习器,可以降低陷入局部最优的风险,增加找到全局最优解的可能性。 3. 表示角度:结合不同学习器的特性,可能学习到更接近真实假设的近似。 集成学习的结合策略主要包括: - 均匀组合(Uniform Combination):所有学习器的权重相同,预测结果通常是这些预测的平均值或多数投票。 - 加权平均(Weighted Average):根据每个学习器的性能给予不同的权重,然后求和。 - 绝对多数投票(Majority Voting):选择最常出现的分类作为最终预测。 - 相对多数投票和加权投票:与绝对多数投票类似,但可以考虑学习器的权重。 Stacking是一种特殊的集成学习方法,它使用一个次级学习器(元学习器)来融合初级学习器的输出。初级学习器在原始训练集上训练,然后它们的输出(如分类概率)被构造成新的特征,形成次级训练集。次级学习器在次级训练集上训练,用于做出最终决策。多响应线性回归(Multi-response Linear Regression, MLR)常被用作次级学习算法。 多样性是集成学习的关键因素,因为不同的学习器能够捕捉数据的不同方面。通过引入随机性,如数据样本扰动、输入属性扰动、算法参数扰动和输出表示扰动,可以增加学习器之间的差异,从而提高整体性能。例如,Bagging(Bootstrap Aggregating)通过自助采样产生有交叠的子集来训练个体学习器,其中约有36.8%的数据未被采样,这部分未被采样的数据可以用于包外验证(out-of-bag estimation)以评估学习器的性能。 集成学习方法如Bagging的一个重要实例是随机森林(Random Forest),它在每个决策树的构建过程中引入随机性,以增加多样性。其他方法,如AdaBoost,通过动态调整样本权重,使后续学习器关注先前学习器处理不好的样本,从而逐步改进集成。 集成学习是一种强大的机器学习技术,通过结合多个学习器的智慧,能够提高模型的泛化能力和稳定性。通过精心设计的结合策略和多样性的增强方法,我们可以构建出比单个学习器更强大的学习系统。

剩余14页未读,继续阅读

- 粉丝: 30

- 资源: 328

我的内容管理

展开

我的内容管理

展开

我的资源

快来上传第一个资源

我的资源

快来上传第一个资源

我的收益 登录查看自己的收益

我的收益 登录查看自己的收益 我的积分

登录查看自己的积分

我的积分

登录查看自己的积分

我的C币

登录后查看C币余额

我的C币

登录后查看C币余额

我的收藏

我的收藏  我的下载

我的下载  下载帮助

下载帮助

前往需求广场,查看用户热搜

前往需求广场,查看用户热搜最新资源

- 从XML生成可与Ajax共同使用的JSON中文WORD版最新版本

- silverlight通过WebService连接数据库中文WORD版最新版本

- 使用NetBeans连接SQLserver2008数据库教程中文WORD版最新版本

- XPath实例中文WORD版最新版本

- XPath语法规则中文WORD版最新版本

- XPath入门教程中文WORD版最新版本

- ORACLE数据库管理系统体系结构中文WORD版最新版本

- Sybase数据库安装以及新建数据库中文WORD版最新版本

- tomcat6.0配置oracle数据库连接池中文WORD版最新版本

- hibernate连接oracle数据库中文WORD版最新版本

信息提交成功

信息提交成功

评论0