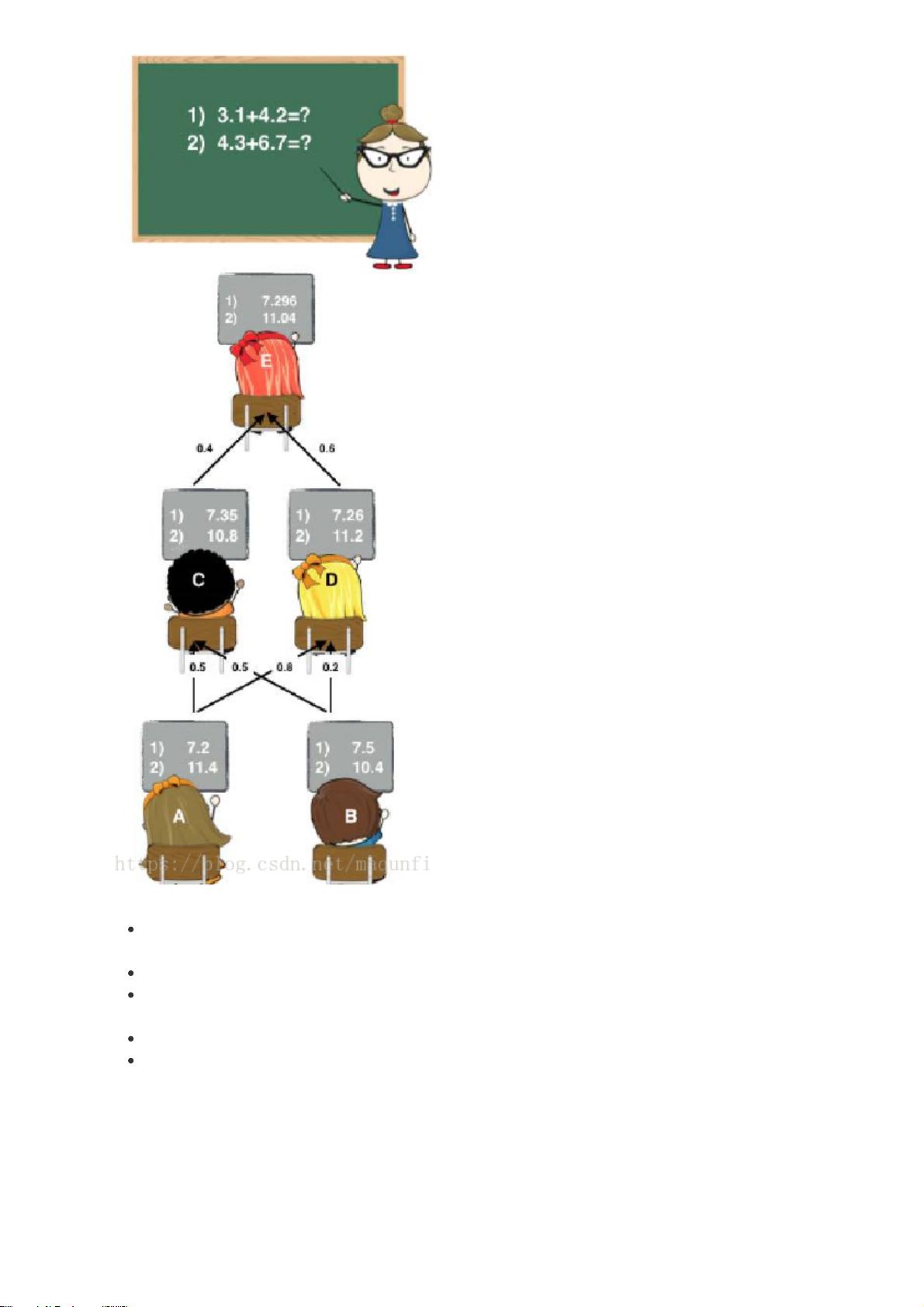

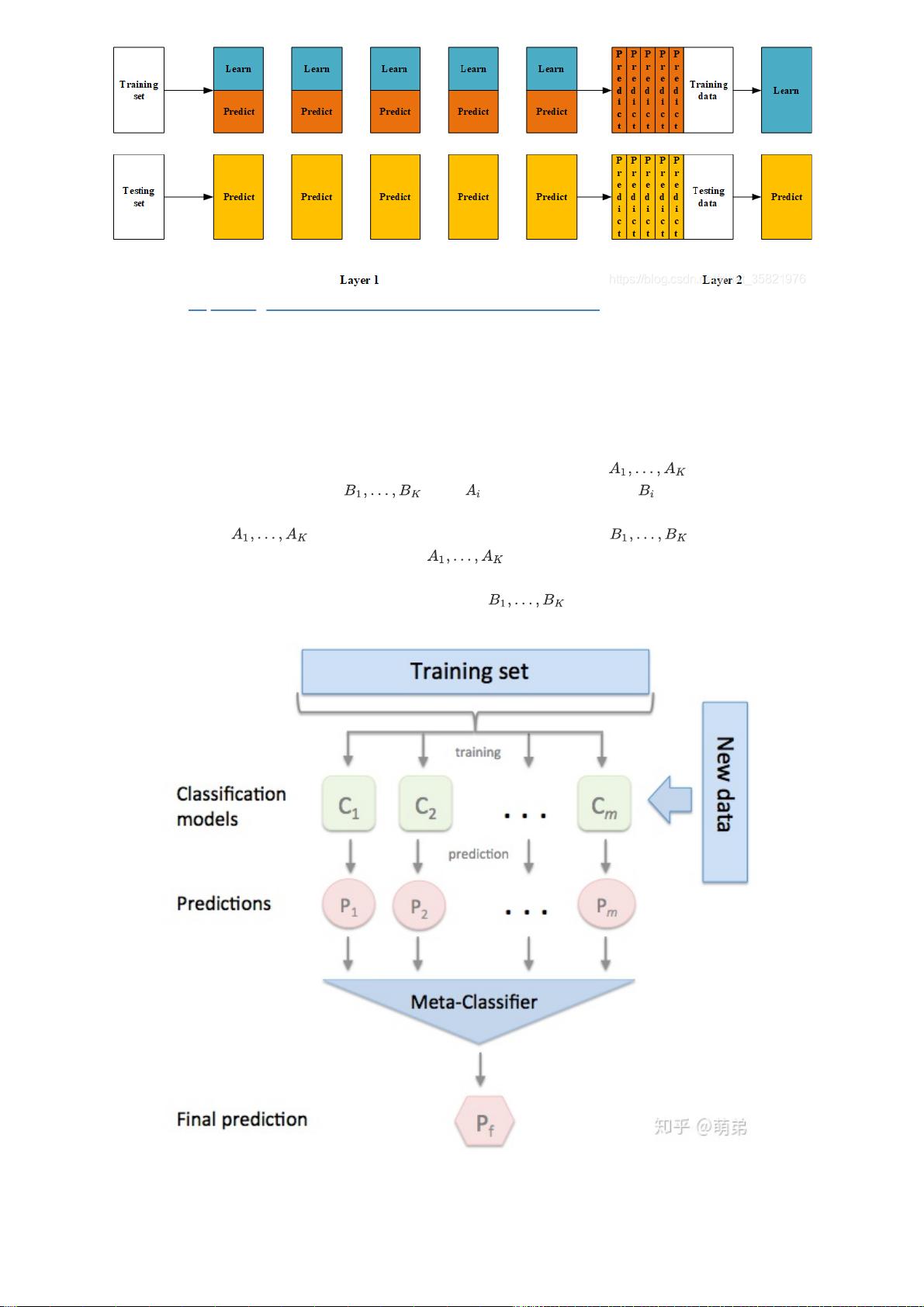

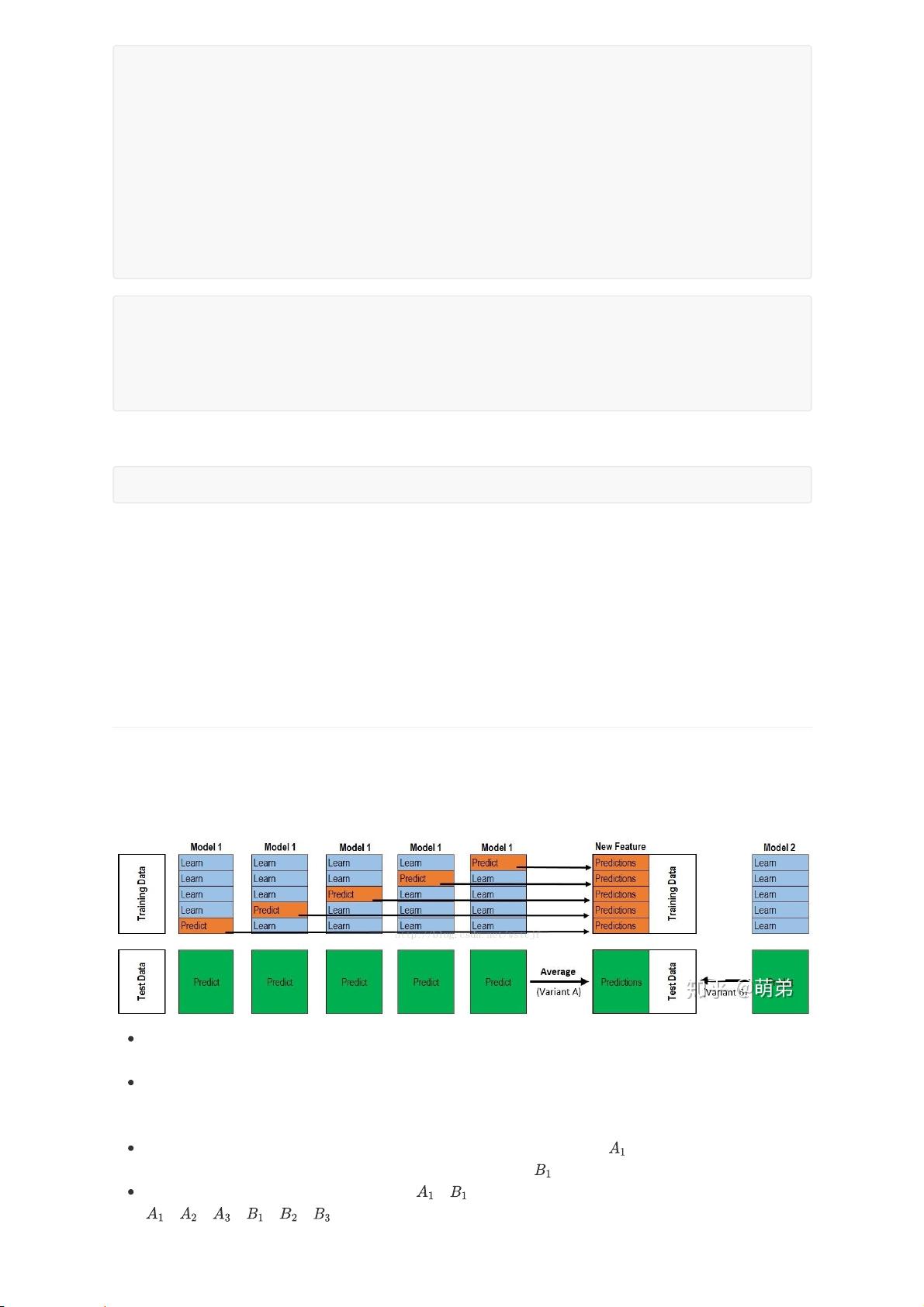

集成学习是一种将多个弱预测器组合成一个强预测器的技术,它可以显著提高模型的泛化能力和预测准确性。在本文中,我们将重点讨论集成学习的两个重要方法:Blending和Stacking,它们都是通过多模型融合来提升性能的策略。 1. Blending集成学习算法 Blending类似于团队合作解决问题的过程,各个模型如同团队成员,各自给出自己的答案,最后通过整合这些答案得出最终的决策。在Blending中,数据集被分为训练集、验证集和测试集。训练集进一步划分为训练子集和验证子集。构建多个第一层的模型,可以是相同类型的(同质)或不同类型的(异质),如SVM、随机森林、XGBoost等。这些模型在训练子集上进行训练,然后分别对验证子集和测试集进行预测,得到多个预测结果。验证集的预测结果用于训练第二层模型,通常是逻辑回归,它将这些预测结果作为新特征。第二层模型的训练完成后,使用其对测试集的预测结果进行预测,形成最终的测试集预测。 2. Stacking集成学习算法 Stacking相比Blending更复杂,它包含了一个额外的层次。除了上述Blending的步骤外,Stacking在第二层模型训练时会包括原始特征以及第一层模型的预测结果。这意味着第二层模型不仅使用第一层模型的预测作为特征,还保留了原始输入数据,从而能更好地捕捉模型之间的差异和互补性。Stacking通常在数据集较大、特征较多,且需要更高精度的预测任务中表现优越。 3. 集成学习的优势 - 提升性能:集成学习通过组合多个模型,可以降低过拟合的风险,提高模型的稳定性和泛化能力。 - 多样性:不同的弱学习器可以带来多样性,使得集成更健壮,能捕捉数据的复杂性。 - 容易实现:Blending和Stacking相对其他集成方法(如Bagging和Boosting)来说,实现较为简单,不需要深度理解每个模型的内部工作原理。 4. 应用场景 集成学习在各种机器学习任务中都得到了广泛应用,特别是在数据竞赛中,由于其优秀的性能和易于实现的特点,Stacking和Blending经常被用来构造最终的提交模型。 总结,Blending和Stacking都是集成学习的重要组成部分,它们通过组合不同模型的预测结果来提高预测准确性和模型稳定性。在实际应用中,选择哪种方法取决于数据集的特性、问题的复杂度以及可用计算资源。通过理解和熟练掌握这些方法,我们可以构建出更为强大的机器学习系统,以应对复杂的数据预测挑战。

剩余62页未读,继续阅读

- 粉丝: 817

- 资源: 270

我的内容管理

展开

我的内容管理

展开

我的资源

快来上传第一个资源

我的资源

快来上传第一个资源

我的收益 登录查看自己的收益

我的收益 登录查看自己的收益 我的积分

登录查看自己的积分

我的积分

登录查看自己的积分

我的C币

登录后查看C币余额

我的C币

登录后查看C币余额

我的收藏

我的收藏  我的下载

我的下载  下载帮助

下载帮助

前往需求广场,查看用户热搜

前往需求广场,查看用户热搜最新资源

信息提交成功

信息提交成功

评论0