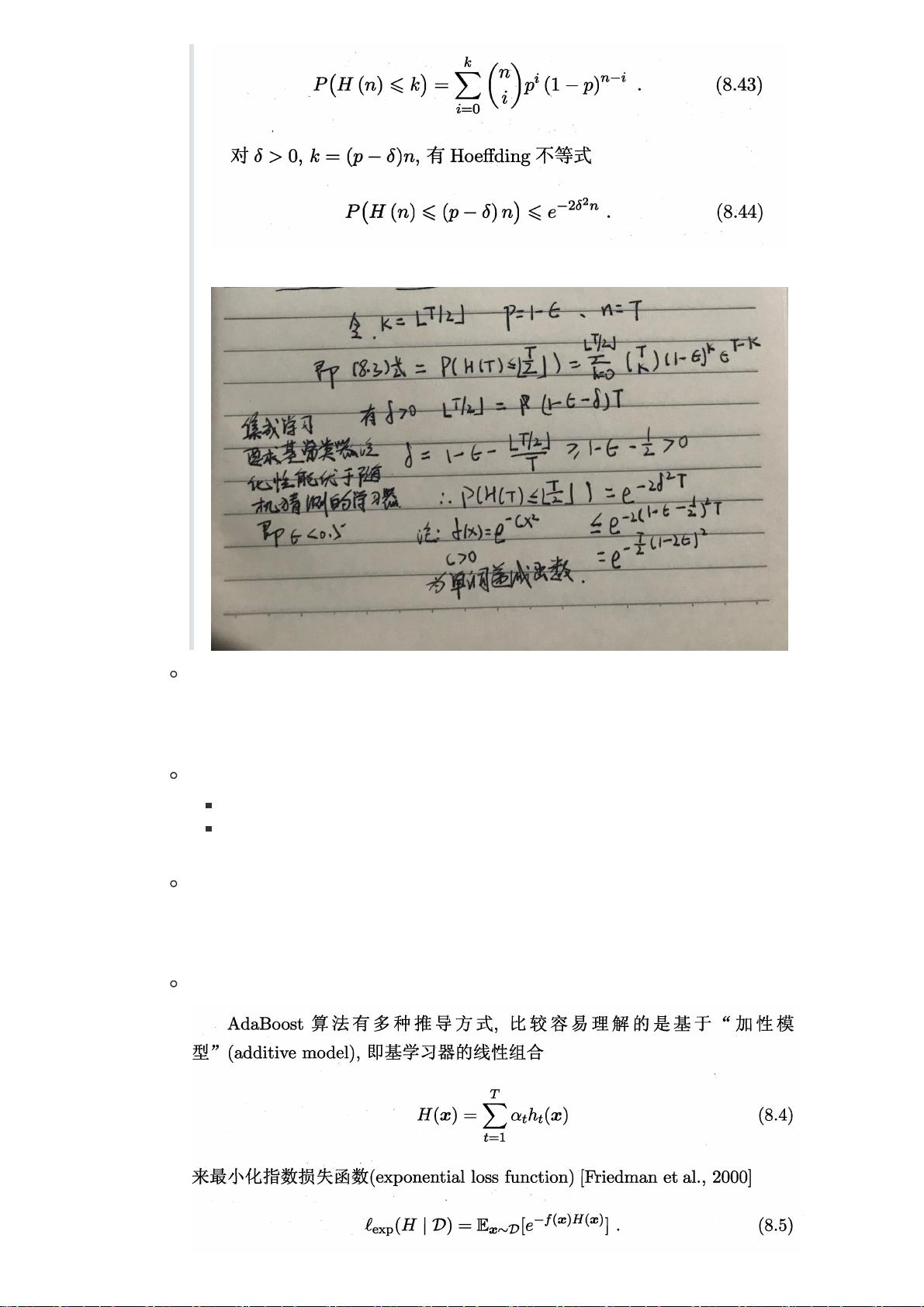

集成学习是一种机器学习方法,通过组合多个学习器(也称为模型或分类器)来提高整体的预测性能。这种策略的基本思想是,通过结合多个可能有缺陷但各具特色的个体学习器,可以创建一个更强大、更稳健的综合模型。集成学习通常分为两类:同质集成和异质集成。同质集成使用相同类型的学习算法生成所有个体学习器,如决策树的集合;而异质集成则使用多种不同的学习算法。 集成学习的优势在于其能够减少过拟合,提高泛化能力。通过某种策略结合多个学习器,比如投票或加权平均,可以降低单一学习器的错误率,尤其是在错误率彼此独立的情况下。例如,对于二分类问题,如果每个基学习器的错误率是ε,并且集成中有T个这样的学习器,那么通过多数投票的集成错误率会随着T的增加而指数级下降。 Boosting是一种序列化的集成学习方法,旨在将弱学习器提升为强学习器。以AdaBoost为例,它通过迭代调整样本权重,让后续的学习器专注于前一轮分类错误的样本。在每次迭代中,错误分类的样本权重增加,使得它们在后续训练中更加重要。这样,最终的集成模型是由一系列基学习器加权组合而成,其中每个学习器的权重与其在训练中的表现相关,尤其是对正确分类的贡献。 Bagging(Bootstrap Aggregating)是另一种并行集成方法,它利用自助采样法创建多个有放回的样本集,然后在每个样本集上训练一个个体学习器。由于每个学习器是在不同的随机子集上训练的,它们之间具有较低的相关性,从而降低了整体模型的方差。Bagging在诸如决策树等对样本扰动敏感的学习器上表现出色。 随机森林是Bagging的一种变体,专门针对决策树。在构建随机森林时,除了使用自助采样外,还在每个节点的划分过程中引入了额外的随机性。在选择最佳分割属性时,不是考虑所有属性,而是从一个随机属性子集中选取。这增加了决策树之间的多样性,提高了整个森林的泛化能力。参数k控制了这种随机性的程度。 集成学习通过结合多个学习器的预测,实现了整体性能的提升,其有效性体现在能够处理复杂的任务和数据,同时减少了模型对噪声和过拟合的敏感性。无论是Boosting的逐轮增强,还是Bagging和随机森林的并行多样化,都是为了构建更强大、更稳定的预测系统。

剩余16页未读,继续阅读

- 粉丝: 28

- 资源: 300

我的内容管理

展开

我的内容管理

展开

我的资源

快来上传第一个资源

我的资源

快来上传第一个资源

我的收益 登录查看自己的收益

我的收益 登录查看自己的收益 我的积分

登录查看自己的积分

我的积分

登录查看自己的积分

我的C币

登录后查看C币余额

我的C币

登录后查看C币余额

我的收藏

我的收藏  我的下载

我的下载  下载帮助

下载帮助

前往需求广场,查看用户热搜

前往需求广场,查看用户热搜最新资源

- tomcat6.0配置oracle数据库连接池中文WORD版最新版本

- hibernate连接oracle数据库中文WORD版最新版本

- MyEclipse连接MySQL的方法中文WORD版最新版本

- MyEclipse中配置Hibernate连接Oracle中文WORD版最新版本

- MyEclipseTomcatMySQL的环境搭建中文WORD版3.37MB最新版本

- hggm - 国密算法 SM2 SM3 SM4 SM9 ZUC Python实现完整代码-算法实现资源

- SQLITE操作入门中文WORD版最新版本

- Sqlite操作实例中文WORD版最新版本

- SQLITE特性分析中文WORD版最新版本

- ORACLE创建表空间中文WORD版最新版本

信息提交成功

信息提交成功

评论0