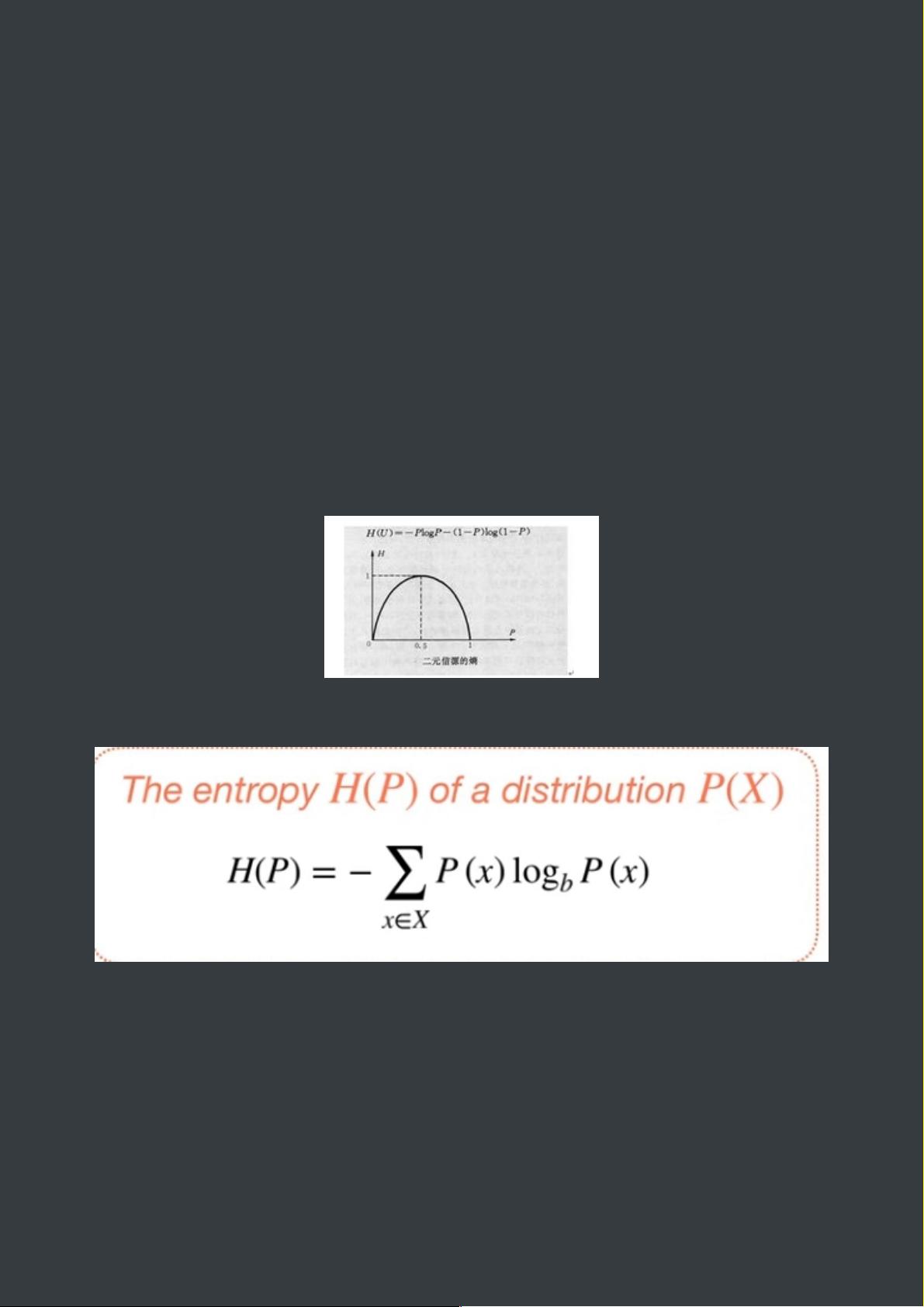

相对熵(KL-Divergence) 相对熵(KL-Divergence)是信息论中的一种度量方式,用于衡量两个概率分布之间的差异。相对熵的概念最早由 Solomon Kullback 和 Richard Leibler 于1951年提出,故也称为 Kullback-Leibler divergence。 在机器学习和信息论中,相对熵是一个非常重要的概念。它可以用来评估两个概率分布之间的差异,有助于我们更好地理解和分析数据。 定义 相对熵的定义可以表示为: KL(P || Q) = ∑[p(x) * log(p(x) / q(x))] 其中,P和Q是两个概率分布,p(x)和q(x)分别是P和Q的概率密度函数。 性质 相对熵满足以下几个重要性质: 1. 非负性:KL(P || Q) >= 0 2. 非对称性:KL(P || Q) != KL(Q || P) 3. 凸性:KL(P || Q) = ∑[p(x) * log(p(x) / q(x))] >= 0 应用 相对熵有很多实践应用,例如: 1. 机器学习:相对熵可以用来评估机器学习模型的性能,例如,计算模型预测结果与真实结果之间的相对熵。 2. 信息论:相对熵可以用来衡量信息的量,从而评估信息的重要性。 3. 数据压缩:相对熵可以用来评估数据压缩算法的性能。 Python 实现 使用 Python 实现相对熵计算可以使用 NumPy 和 SciPy 库。下面是一个简单的示例代码: ``` import numpy as np import scipy.stats p = np.array([0.65, 0.25, 0.07, 0.03]) q = np.array([0.6, 0.25, 0.1, 0.05]) kl1 = np.sum(p * np.log(p / q)) print(kl1) kl2 = scipy.stats.entropy(p, q) print(kl2) ``` 在上面的代码中,我们首先定义了两个概率分布P和Q,然后使用 NumPy 库计算相对熵,最后使用 SciPy 库计算相对熵。 相对熵是一个非常重要的概念,在机器学习和信息论中有着广泛的应用。了解相对熵可以帮助我们更好地理解和分析数据。

- 粉丝: 621

- 资源: 310

我的内容管理

展开

我的内容管理

展开

我的资源

快来上传第一个资源

我的资源

快来上传第一个资源

我的收益 登录查看自己的收益

我的收益 登录查看自己的收益 我的积分

登录查看自己的积分

我的积分

登录查看自己的积分

我的C币

登录后查看C币余额

我的C币

登录后查看C币余额

我的收藏

我的收藏  我的下载

我的下载  下载帮助

下载帮助

前往需求广场,查看用户热搜

前往需求广场,查看用户热搜最新资源

信息提交成功

信息提交成功

评论0