林轩田《机器学习基石》课程笔记7 -- The VC Dimension1

需积分: 0 13 浏览量

更新于2022-08-03

收藏 1.78MB PDF 举报

【VC Dimension】是机器学习中一个重要的概念,用于衡量一个假设空间(Hypothesis Space)的复杂度。它表示在给定的最大输入数量下,一个假设空间能够完全分类(shatter)不同数据点的最多个数。VC Dimension的全称是Vapnik-Chervonenkis Dimension,它是由Alexey Chervonenkis和Vladimir Vapnik两位科学家提出的。

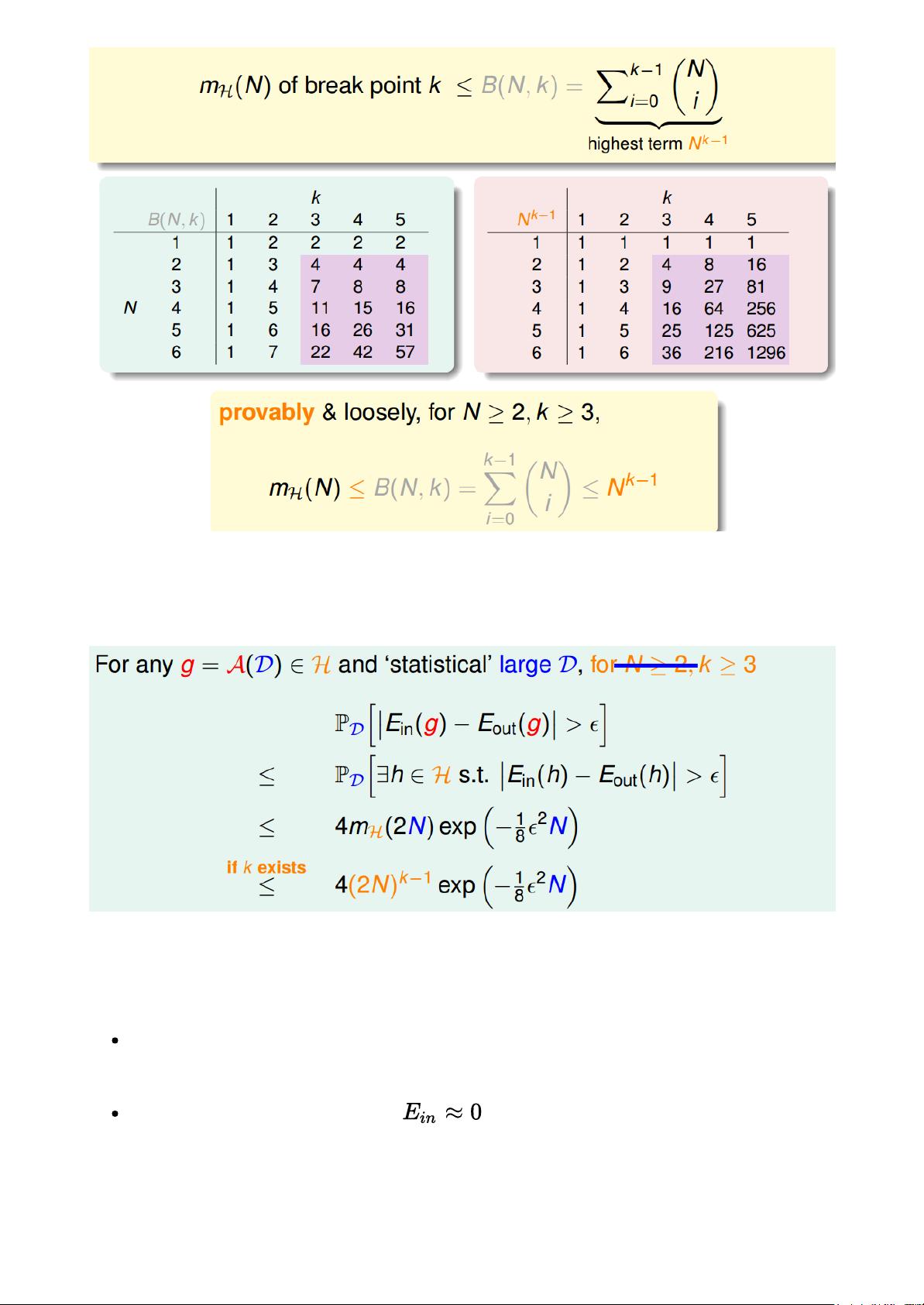

在林轩田的《机器学习基石》课程中,提到VC Dimension与模型的泛化能力紧密相关。如果一个假设空间有break point k,这意味着在k个输入点上,这个假设空间的成长函数是有界的。成长函数描述了随着输入点数量增加,假设空间能够正确分类的组合方式的最大数量。Break point k即为使成长函数不再增长的最小输入点数。

VC Bound是评估模型泛化性能的一个指标,它表明了在假设空间H中选择一个假设g,使得训练集上的误差率很小,那么在全数据集上的错误率也会相对较低。当样本数量N足够大时,我们主要关注break point k的值,因为VC Bound只与k和N有关。

VC Dimension等于假设空间能shatter的输入点的最大数量减一。例如,如果一个假设空间可以对N个输入点进行所有可能的分类组合,那么它的VC Dimension就是N。而如果一个假设空间无法对任何输入分布进行完全分类,其VC Dimension将是0。

课程中提到了感知机(Perceptrons)的VC Dimension。在二维(2D)情况下,感知机的VC Dimension是4,意味着在二维平面上,最多可以有4个点被正确分类。对于更高维度的感知机,如d维,其VC Dimension可以通过证明d+1个点可以被shatter来得出,即。这证明了感知机在高维空间中具有一定的学习能力。

VC Dimension的实际意义在于,它限制了模型过拟合的可能性。较高的VC Dimension意味着模型更复杂,可能过度拟合训练数据,而低的VC Dimension则可能导致模型过于简单,欠拟合。因此,选择合适的VC Dimension对于构建具有良好泛化性能的模型至关重要。

在实际应用中,理解VC Dimension可以帮助我们控制模型的复杂度,通过调整模型参数或者选择不同的模型结构,以达到平衡模型的复杂性和泛化能力。同时,VC Dimension也与Model Complexity Penalty相关,后者是在模型训练过程中用来惩罚复杂模型的机制,以防止过拟合。

VC Dimension是衡量机器学习模型复杂度的关键指标,它直接影响模型的泛化性能。通过理解并合理控制模型的VC Dimension,我们可以更好地构建能够从数据中学习并有效地应用于新数据的机器学习系统。

村上树树825

- 粉丝: 23

- 资源: 292

最新资源

- 《能源转型投资展望:2025年及长远规划》.pdf

- PPTAAD DADAA

- SM2258XT-BGA144-4BGA180-6L-R1019 三星KLUCG4J1CB B0B1颗粒开盘工具 , EC, 3A, 94, 43, A4, CA 七彩虹SL300这个固件有用

- 基于Java开发的日程管理FlexTime应用设计源码

- 基于JavaScript、CSS、HTML的简易DOM版飞机游戏设计源码

- 【C++初级程序设计·配套源码】第1期-语法基础

- 基于华为消费者业务官网的仿制前端首页设计源码

- 影驰战将PS3111 东芝芯片TT18G23AIN开卡成功分享,图片里面画线的选项很重要

- 基于Java和Vue的kopsoftKANBAN车间电子看板设计源码

- 基于Go语言的SharpWxDump微信取证信息分析设计源码

- 基于C语言的USB光盘资料操作教学源码

- 基于GitHub的TypeScript文档中文翻译设计源码

- 【C++初级程序设计·配套源码】第2期-基本数据类型

- 基于Vue和SpringBoot的企业员工管理系统2.0版本设计源码

- 没用333333333333333333333333333333

- C++ STL 高级教程深入浅出版.zip