Introduction to Deep Learning-香港中文王晓刚教授

需积分: 0 83 浏览量

更新于2016-04-11

收藏 8.91MB PDF 举报

王晓刚教授在其讲座《深度学习介绍》中详细梳理了深度学习的发展历程、经典深度模型的介绍、深度学习工作原理的探讨、深度特征表示的属性以及如何应对机器学习中的小数据和大数据问题。

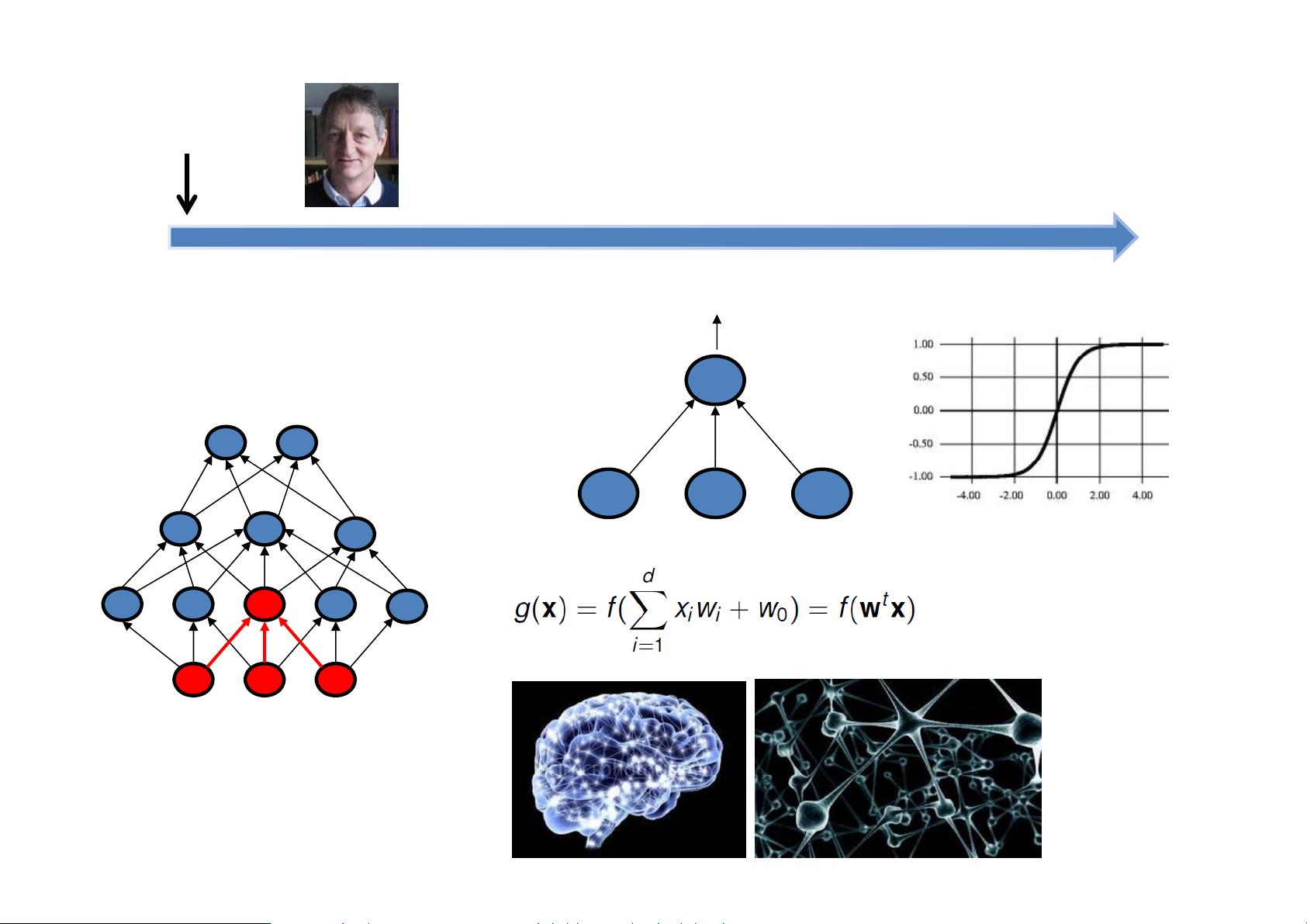

教授回顾了深度学习的历史,从1986年反向传播算法(Backpropagation)的提出开始,该算法为神经网络训练提供了基础。早期的神经网络由于训练困难、计算资源匮乏以及训练集较小等问题而被放弃使用。但后来,随着支持向量机(SVM)、提升方法(Boosting)、决策树、K最近邻(KNN)等机器学习方法的涌现,人们开始尝试用更扁平化的结构和与生物系统较弱的联系来解决特定问题,依赖手工制作的特征如高斯混合模型-隐马尔可夫模型(GMM-HMM)、尺度不变特征变换(SIFT)、局部二值模式(LBP)和方向梯度直方图(HOG)等。

在深度学习的黄金时期,人们重新发现了深度信念网络(Deep Belief Net)和自编码器等无监督学习和逐层预训练方法,这些方法在设计模型和训练方面都得到了更好的发展,特别是归一化、非线性激活函数、Dropout等技术的引入。硬件方面,计算机架构的新发展,如图形处理单元(GPU)和多核计算机系统的出现,为深度学习提供了更强大的计算能力。大数据(Big Data)的到来则进一步推动了深度学习的发展,使机器学习能够处理大规模数据集。

接着,教授介绍了深度学习中的经典模型,例如用于解决通用学习问题的神经网络。神经网络模型的提出与生物系统紧密相关,但在很长一段时间里未能得到广泛应用。深度学习成功的原因不仅在于深度神经网络能够解决传统机器学习方法难以处理的复杂问题,还包括了深度网络能够学习层次化的特征表示。王晓刚教授讲解了深度学习如何通过学习分层的特征转换(Blessing of dimensionality),来处理对象识别(如动物、花卉等)和超分辨率等任务,将低分辨率图像转换为高分辨率图像。这种方法的核心在于从数据中自动学习复杂度和表达能力越来越强的特征。

在深度学习的核心问题探讨中,教授提出了为何深度学习能够工作的疑问,并讨论了深度特征表示的属性。深度学习之所以有效,部分原因在于它能够通过多层网络学习到数据的深层次特征,这使得网络在面对复杂的数据分布时,能有更好的泛化能力和表现。

王晓刚教授讨论了在小数据环境下机器学习的过拟合问题,以及在大数据环境下如何通过增加模型复杂度和计算资源来解决欠拟合问题。教授指出,小数据情况下容易出现过拟合现象,降低模型复杂度可以缓解这个问题;而在大数据情况下,模型通常会出现欠拟合,此时需要通过提高模型复杂度和优化算法来提升学习能力。在提到如何增加模型容量时,教授提出了“维度的诅咒”与“维度的祝福”这两个概念,强调了学习分层特征变换的重要性。通过深度结构学习特征(Learning hierarchical feature transforms),深度学习模型能够在大数据驱动的机器学习中发挥关键作用。

王晓刚教授的这次讲座对深度学习进行了全面而深入的介绍,不仅让听众对深度学习的发展有了清晰的认识,也对其理论和应用的关键点有了深刻理解,为后续的学习和研究提供了扎实的基础。

pxp201

- 粉丝: 0

- 资源: 4

最新资源

- Python 实现TCN-GRU时间卷积门控循环单元多输入单输出回归预测(含模型描述及示例代码)

- 创新流固耦合模拟煤层塌陷模型:基于fipy与pfc2d联合方法的多功能代码干货分享,创新流固耦合模拟煤层塌陷模型:基于fipy与pfc2d联合方法的多功能代码干货分享,该模型是模拟的煤层塌陷的pfc2

- Python 实现GA-RF遗传算法优化随机森林算法多输入单输出回归预测的详细项目实例(含完整的程序,GUI设计和代码详解)

- 电机模型、PI控制器与PLL锁相环的标幺化处理详解:从理论到实践,采样时间处理全解析,电机模型、PI控制器与PLL锁相环的标幺化处理详解:从理论到实践,采样时间处理全解析,电机标幺化、PI标幺化、锁相

- 基于西门子S7-1200PLC的现代化创新立体车库:传统与未来科技结合的简约程序与仿真图纸及新能源汽车充电解决方案,基于西门子S7-1200PLC的立体车库创新设计:融合新能源汽车充电功能,简约而不简

- Python 实现WOA-BP鲸鱼优化算法优化BP神经网络多输入单输出回归预测的详细项目实例(含完整的程序,GUI设计和代码详解)

- Python 实现SA-BP模拟退火算法优化BP神经网络多输入单输出回归预测的详细项目实例(含完整的程序,GUI设计和代码详解)

- HCIP-Datacom题库.zip

- Python 实现GA-ELM遗传算法优化极限学习机多输入单输出回归预测的详细项目实例(含完整的程序,GUI设计和代码详解)

- MinGW-w64安装指南.pdf

- Python 实现SA-ELM模拟退火算法优化极限学习机多输入单输出回归预测的详细项目实例(含完整的程序,GUI设计和代码详解)

- numpy-2.2.0-cp311-cp311-win_amd64.whl

- Python 实现DRN深度残差网络多输入分类预测的详细项目实例(含完整的程序,GUI设计和代码详解)

- PFC 5.0 流体与固体相互作用-流固耦合模型实战指南(实用干货版),PFC5.0流固耦合模型应用手册:干货满载的水力压裂与达西渗流常用案例集锦,该模型是“PFC2D流固耦合常用案例合集”: 其中

- Python 实现TSO-SVM金枪鱼群算法优化支持向量机多输入单输出回归预测的详细项目实例(含完整的程序,GUI设计和代码详解)

- Yoast SEO Premium v24.6 – WordPress SEO 插件 全功能版-20250306-134428.zip