tensorflw循环神经网络详解

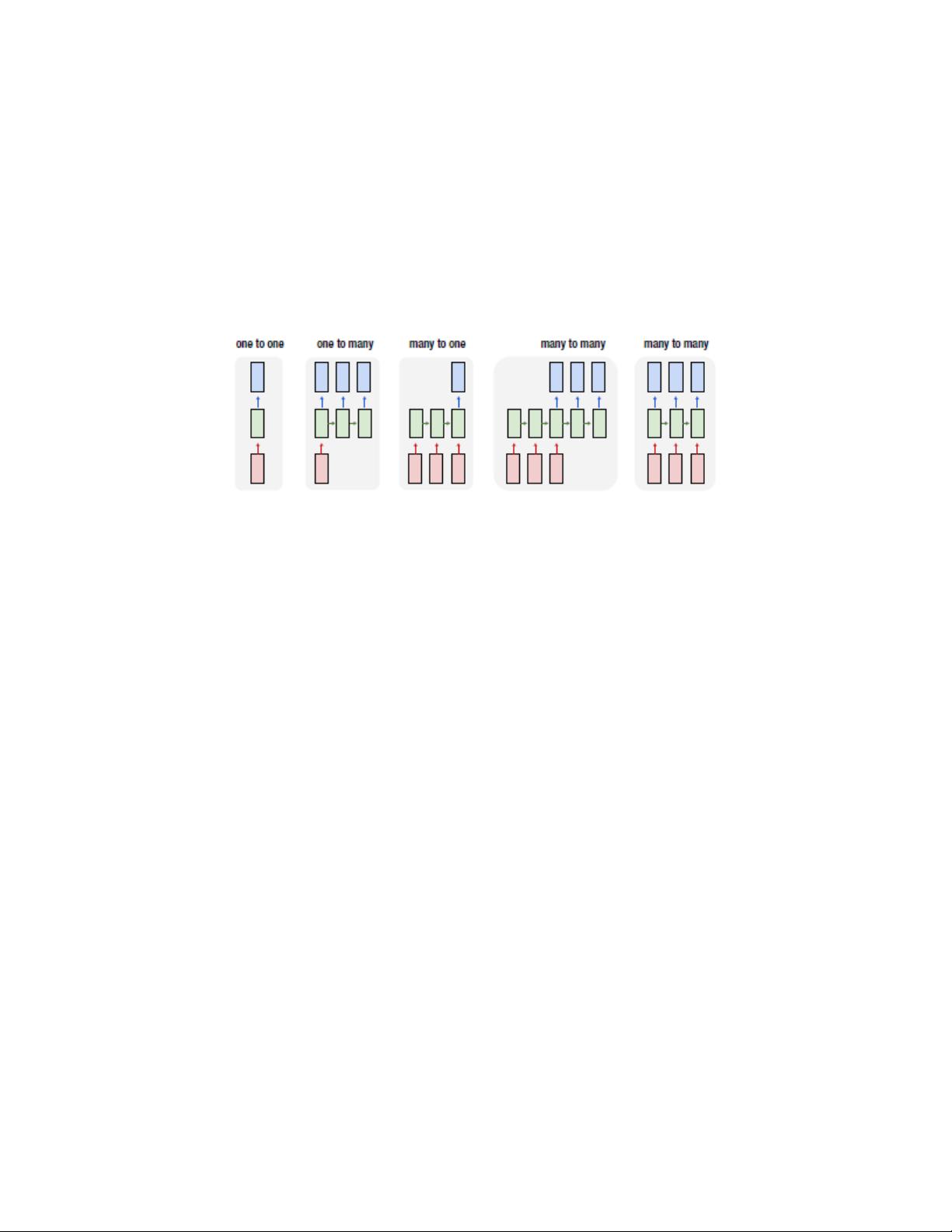

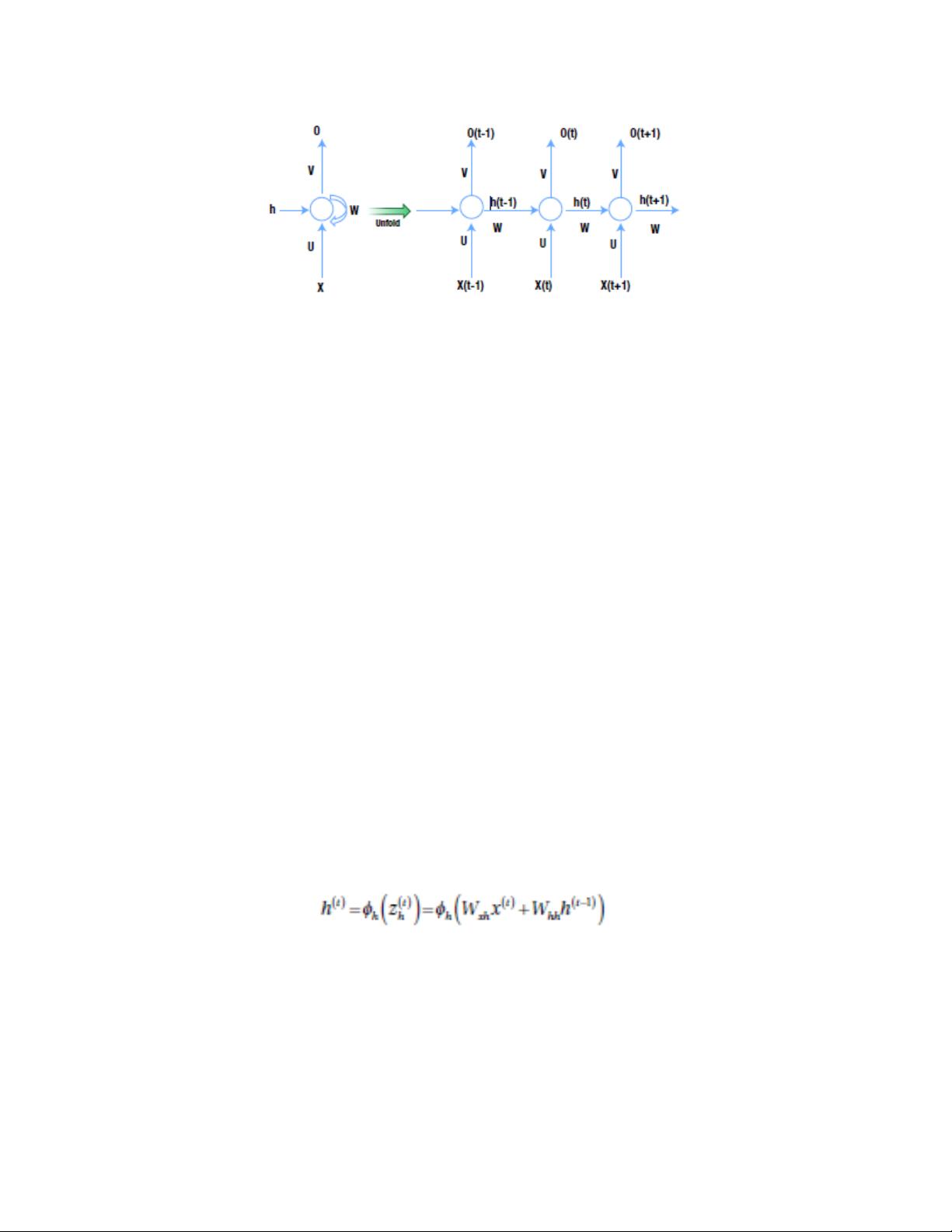

尽管CNNs能很好的分类图像,其中平移和旋转能关注到,但是它们不能识别时间模式。根本上,我们可以认为 CNNs只能认别静态模式。Recurrent neural networks (RNNs) 是设计来解决认别时间模式的。 RNNs与CNNs很不同,特别是用来处理序列数据。 【TensorFlow循环神经网络详解】 循环神经网络(Recurrent Neural Networks, RNNs)是一种针对序列数据处理的深度学习模型,特别适用于识别和理解时间序列中的模式。与卷积神经网络(CNNs)相比,虽然CNNs在图像分类中表现出色,能够捕捉平移和旋转不变性,但它们无法有效地处理时间上的依赖关系。RNNs正是为了解决这一问题而设计的,它们能够理解和利用先前序列中的信息来预测后续序列。 RNNs的核心特性在于其“循环”结构,这使得网络能够对序列中的每个元素进行处理,并将前一时刻的状态信息传递到下一时刻。这种机制使得RNNs能够捕获序列数据中的长期依赖性,比如在自然语言处理中预测句子的下一个单词。例如,对于句子“Paris is the capital of ——”,RNN可以通过理解上下文信息来预测填空应该是“France”。 RNNs在多个领域有广泛的应用: 1. 生成文本:通过训练RNNs,可以生成类似莎士比亚风格的文本。 2. 翻译:输入一种语言的序列,输出另一种语言的对应序列。 3. 语音识别:从一系列音频信号中预测对应的文本。 4. 生成图像标签:结合CNNs,RNNs可用于生成图像的描述。 5. 聊天机器人:输入用户的话语,RNNs生成合适的回复。 RNNs的结构有多种变体,如图10-1所示,包括一对一、一对多、多对一和多对多的架构。每种架构对应不同的任务,例如,一对多用于图像标题生成,多对多则常用于机器翻译。 理解RNN的工作原理,关键在于其隐藏层。隐藏层不仅与当前输入相连,还与自身相连(图10-3),形成循环。这种循环使得隐藏层的状态可以随时间动态变化,存储了过去的序列信息。例如,在预测句子的下一个单词任务中,RNN会依次处理每个单词,将每个单词的信息和前一个单词的隐藏状态相结合,生成新的隐藏状态,最后这个隐藏状态被用来预测下一个单词。 然而,标准的RNNs在处理长序列时可能存在梯度消失或梯度爆炸问题,这限制了它们学习长期依赖的能力。为了解决这些问题,出现了长短期记忆网络(Long Short-Term Memory, LSTM)和门控循环单元(Gated Recurrent Unit, GRU)等改进模型。这些模型引入了控制信息流动的门控机制,更好地解决了长距离依赖的问题。 在TensorFlow中实现RNNs,我们需要理解如何使用嵌入(embeddings)将离散的词汇映射到连续的向量空间,以及如何构建RNN单元并训练模型。此外,还需要掌握反向传播算法和优化策略,如动量法、Adam优化器等,以调整模型参数。同时,为了防止过拟合,可能还需要应用正则化技术,如dropout和早停策略。 TensorFlow中的RNNs是一个强大的工具,可以处理各种序列数据任务。但要充分利用RNNs的潜力,需要深入理解其工作机制,并掌握相关的训练技巧。通过实践和不断学习,我们可以构建更复杂、更高效的RNN模型,以应对更多挑战性的序列数据问题。

剩余36页未读,继续阅读

- 粉丝: 160

- 资源: 28

我的内容管理

展开

我的内容管理

展开

我的资源

快来上传第一个资源

我的资源

快来上传第一个资源

我的收益 登录查看自己的收益

我的收益 登录查看自己的收益 我的积分

登录查看自己的积分

我的积分

登录查看自己的积分

我的C币

登录后查看C币余额

我的C币

登录后查看C币余额

我的收藏

我的收藏  我的下载

我的下载  下载帮助

下载帮助

前往需求广场,查看用户热搜

前往需求广场,查看用户热搜最新资源

- 数据分析-19-Thera Bank信贷业务数据(包含数据代码)

- halcon视觉检测之毛刺检测案例

- 数据挖掘-10-酒店预订需求(包含数据和代码)

- gaussian-splatting项目百度网盘资料

- Linxu 5.4版本内核 移植适配正点原子IMX6ULL(2.4版本)开发板

- 数据挖掘-11-利用python进行信用卡欺诈检测(包含数据代码)

- 数据分析-20-宠物小精灵数据挖掘(包含数据代码)

- 巴特沃兹滤波判定正逆转摩擦力矩产品

- 数据分析-21-黑色星期五消费者用户画像(包含数据代码)

- 基于51单片机光控人体感应灯论文

- 该VI为电动助力转向系统,在测试助力状态下输入输出曲线时,曲线的对称度算法

- 【完结21章附电子书】2024全新GO工程师面试总攻略,助力快速斩获offer

- 基于QT/C++开发的WEB框架

- 桥梁地震易损性分析中的Python随机森林算法应用-含代码及使用解释

- 修改Hosts文件,解决IP与电脑名称绑定,或屏蔽某些网站访问

- 数据分析-22-双12活动前后(包含数据代码)

信息提交成功

信息提交成功