没有合适的资源?快使用搜索试试~ 我知道了~

内容概要:该文针对大规模语言模型(LLMs)微调技术展开深入讨论,涵盖所需硬件规格、微调时常见的灾难性遗忘、领域知识注入方法以及数据质量和数量的选择等多个议题,并提供了训练及微调的实用技巧和经验分享。 适用人群:适用于具有一定机器学习基础知识的研发人员,特别是关注大模型微调的技术专家、数据科学家及NLP从业者。 使用场景及目标:本文适用于希望对既有语言模型在某一特定领域或应用进行效能提升的研究员和开发者。 其他说明:通过对多个技术要点的具体阐述和建议,帮助从业者有效地实施大模型的微调工作,解决常见挑战,并最大化提升特定任务性能。

资源推荐

资源详情

资源评论

大模型(LLMs)微调面

来自: AiGC面试宝典

宁静致远 2023年12月24日 00:44

大模型(LLMs)微调面

1. 如果想要在某个模型基础上做全参数微调,究竟需要多少显

存?

• 1. 如果想要在某个模型基础上做全参数微调,究竟需要多少显存?

• 2. 为什么SFT之后感觉LLM傻了?

• 3. SFT 指令微调数据 如何构建?

• 4. 领域模型Continue PreTrain 数据选取?

• 5. 领域数据训练后,通用能力往往会有所下降,如何缓解模型遗忘通用能力?

• 6. 领域模型Continue PreTrain ,如何 让模型在预训练过程中就学习到更多的知识?

• 7. 进行SFT操作的时候,基座模型选用Chat还是Base?

• 8. 领域模型微调 指令&数据输入格式 要求?

• 9. 领域模型微调 领域评测集 构建?

• 10. 领域模型词表扩增是不是有必要的?

• 11. 如何训练自己的大模型?

• 12. 训练中文大模型有啥经验?

• 13. 指令微调的好处?

• 14. 预训练和微调哪个阶段注入知识的?

• 15. 想让模型学习某个领域或行业的知识,是应该预训练还是应该微调?

• 16. 多轮对话任务如何微调模型?

• 17. 微调后的模型出现能力劣化,灾难性遗忘是怎么回事?

• 18. 微调模型需要多大显存?

• 19. 大模型LLM进行SFT操作的时候在学习什么?

• 20. 预训练和SFT操作有什么不同

• 21. 样本量规模增大,训练出现OOM错

• 22. 大模型LLM进行SFT 如何对样本进行优化?

• 23. 模型参数迭代实验

• 24. 微调大模型的一些建议

• 25. 微调大模型时,如果 batch size 设置太小 会出现什么问题?

• 26. 微调大模型时,如果 batch size 设置太大 会出现什么问题?

• 27. 微调大模型时, batch size 如何设置问题?

• 28. 微调大模型时, 优化器如何?

• 29. 哪些因素会影响内存使用?

• 30. 进行领域大模型预训练应用哪些数据集比较好?

• 31. 用于大模型微调的数据集如何构建?

• 32. 大模型训练loss突刺原因和解决办法

• 32.1 大模型训练loss突刺是什么?

• 32.2 为什么大模型训练会出现loss突刺?

• 32.3 大模型训练loss突刺 如何解决?

扫码加

查看更多

一般 n B的模型,最低需要 16-20 n G的显存。(cpu offload基本不开的情况下)

vicuna-7B为例,官方样例配置为 4*A100 40G,测试了一下确实能占满显存。(global batch size

128,max length 2048)当然训练时用了FSDP、梯度累积、梯度检查点等方式降显存。

2. 为什么SFT之后感觉LLM傻了?

SFT的重点在于激发大模型的能力,SFT的数据量一般也就是万恶之源alpaca数据集的52k量级,

相比于预训练的数据还是太少了。

如果抱着灌注领域知识而不是激发能力的想法,去做SFT的话,可能确实容易把LLM弄傻。

指令微调是为了增强(或解锁)大语言模型的能力。

其真正作用:

指令微调后,大语言模型展现出泛化到未见过任务的卓越能力,即使在多语言场景下也能有不错表

现 。

3. SFT 指令微调数据 如何构建?

4. 领域模型Continue PreTrain 数据选取?

技术标准文档或领域相关数据是领域模型Continue PreTrain的关键。因为领域相关的网站和资讯重

要性或者知识密度不如书籍和技术标准。

5. 领域数据训练后,通用能力往往会有所下降,如何缓解模型遗

忘通用能力?

那么这个比例多少比较合适呢?

目前还没有一个准确的答案。主要与领域数据量有关系,当数据量没有那么多时,一般领域数据与

通用数据的比例在1:5到1:10之间是比较合适的。

6. 领域模型Continue PreTrain ,如何 让模型在预训练过程中就

学习到更多的知识?

领域模型Continue PreTrain时可以同步加入SFT数据,即MIP,Multi-Task Instruction

PreTraining。

预训练过程中,可以加下游SFT的数据,可以让模型在预训练过程中就学习到更多的知识。

7. 进行SFT操作的时候,基座模型选用Chat还是Base?

• 原版答案:

• 新版答案:

1. 代表性。应该选择多个有代表性的任务;

2. 数据量。每个任务实例数量不应太多(比如:数百个)否则可能会潜在地导致过拟合问题并影

响模型性能;

3. 不同任务数据量占比。应该平衡不同任务的比例,并且限制整个数据集的容量(通常几千或几

万),防止较大的数据集压倒整个分布。

• 动机:仅仅使用领域数据集进行模型训练,模型很容易出现灾难性遗忘现象.

• 解决方法:通常在领域训练的过程中加入通用数据集

仅用SFT做领域模型时,资源有限就用在Chat模型基础上训练,资源充足就在Base模型上训练。

(资源=数据+显卡)

资源充足时可以更好地拟合自己的数据,如果你只拥有小于10k数据,建议你选用Chat模型作为基

座进行微调;如果你拥有100k的数据,建议你在Base模型上进行微调。

8. 领域模型微调 指令&数据输入格式 要求?

在Chat模型上进行SFT时,请一定遵循Chat模型原有的系统指令&数据输入格式。

建议不采用全量参数训练,否则模型原始能力会遗忘较多。

9. 领域模型微调 领域评测集 构建?

领域评测集时必要内容,建议有两份,一份选择题形式自动评测、一份开放形式人工评测。

选择题形式可以自动评测,方便模型进行初筛;开放形式人工评测比较浪费时间,可以用作精筛,

并且任务形式更贴近真实场景。

10. 领域模型词表扩增是不是有必要的?

领域词表扩增真实解决的问题是解码效率的问题,给模型效果带来的提升可能不会有很大。

11. 如何训练自己的大模型?

如果我现在做一个sota的中文GPT大模型,会分2步走:1. 基于中文文本数据在LLaMA-65B上二次

预训练; 2. 加CoT和instruction数据, 用FT + LoRA SFT。

提炼下方法,一般分为两个阶段训练:

当然,有低成本方案,因为我们有LoRA利器,第一阶段和第二阶段都可以用LoRA训练,如果不用

LoRA,就全参微调,大概7B模型需要8卡A100,用了LoRA后,只需要单卡3090就可以了。

12. 训练中文大模型有啥经验?

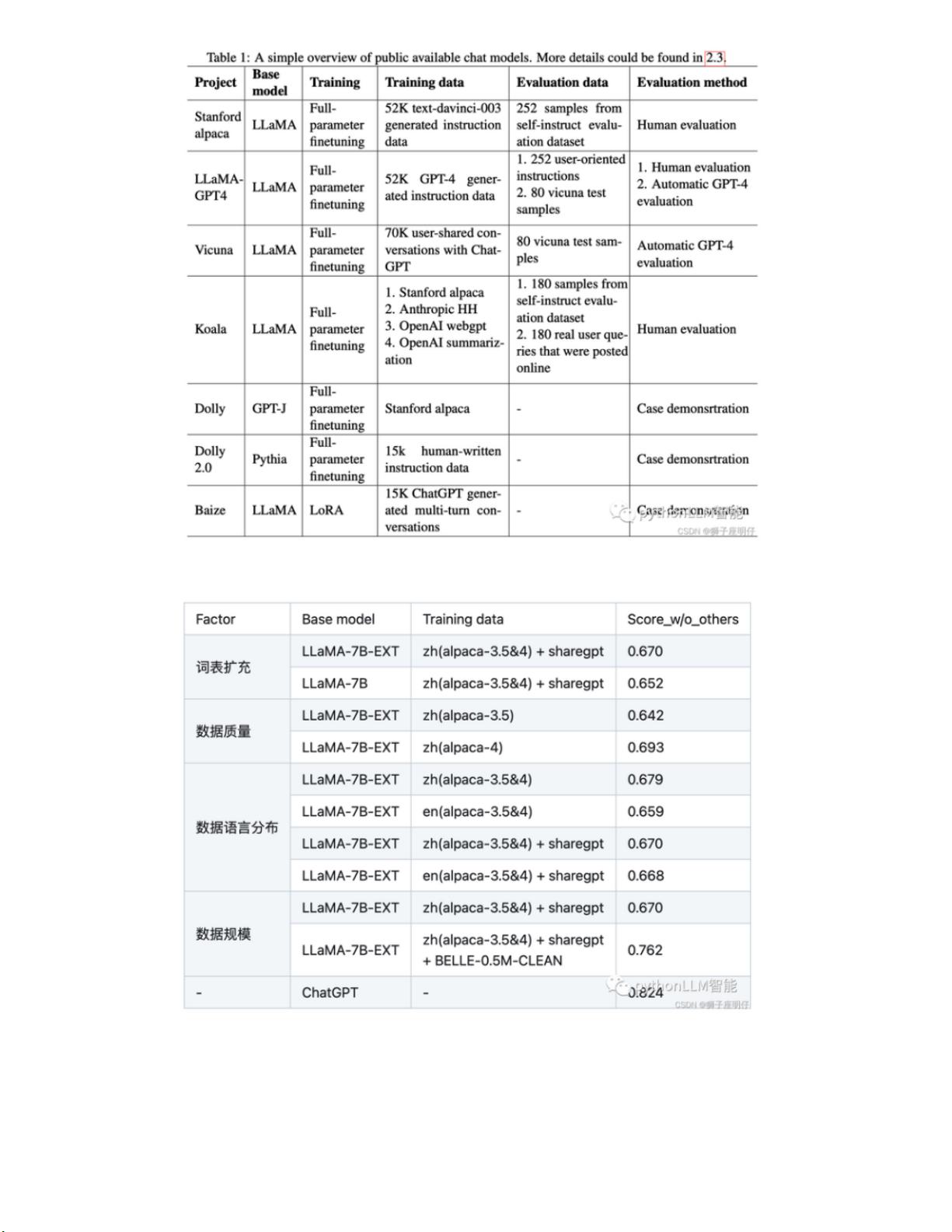

链家技术报告《Towards Better Instruction Following Language Models for Chinese: Investigating

the Impact of Training Data and Evaluation》中,介绍了开源模型的训练和评估方法:

• 第一阶段:扩充领域词表,比如金融领域词表,在海量领域文档数据上二次预训练LLaMA模

型;

• 第二阶段:构造指令微调数据集,在第一阶段的预训练模型基础上做指令精调。还可以把指令

微调数据集拼起来成文档格式放第一阶段里面增量预训练,让模型先理解下游任务信息。

还对比了各因素的消融实验:

消融实验结论:

• 扩充中文词表后,可以增量模型对中文的理解能力,效果更好

• 数据质量越高越好,而且数据集质量提升可以改善模型效果

• 数据语言分布,加了中文的效果比不加的好

• 数据规模越大且质量越高,效果越好,大量高质量的微调数据集对模型效果提升最明显。解释

下:数据量在训练数据量方面,数据量的增加已被证明可以显著提高性能。值得注意的是,如

剩余15页未读,继续阅读

资源评论

zhangbijun1230

- 粉丝: 6946

- 资源: 18

上传资源 快速赚钱

我的内容管理

展开

我的内容管理

展开

我的资源

快来上传第一个资源

我的资源

快来上传第一个资源

我的收益 登录查看自己的收益

我的收益 登录查看自己的收益 我的积分

登录查看自己的积分

我的积分

登录查看自己的积分

我的C币

登录后查看C币余额

我的C币

登录后查看C币余额

我的收藏

我的收藏  我的下载

我的下载  下载帮助

下载帮助

前往需求广场,查看用户热搜

前往需求广场,查看用户热搜最新资源

- springboot-基于javaweb宿舍管理系统

- 手检测18-YOLO(v5至v9)、COCO、CreateML、Darknet、Paligemma、TFRecord、VOC数据集合集.rar

- Inter-Task自适应增强:基于规划与执行轨迹的智能体自演化策略研究

- 大规模语言模型智能代理自动化生成与选择情境感知指南的方法

- 手检测16-YOLO(v5至v9)、COCO、CreateML、Darknet、Paligemma、VOC数据集合集.rar

- 利用多轮反馈机制提升大型语言模型在开放世界环境中的探索能力与任务完成度

- 大规模语言模型在社会科学中的应用:自动化假设生成与验证系统

- 交通信号灯数据集,可识别红绿黄三种颜色并使用coco格式标记.zip

- share_6c773ee2e6abf44995111d91677835171733220471775.mp4

- Video_2024-12-03_183654.wmv

资源上传下载、课程学习等过程中有任何疑问或建议,欢迎提出宝贵意见哦~我们会及时处理!

点击此处反馈

安全验证

文档复制为VIP权益,开通VIP直接复制

信息提交成功

信息提交成功