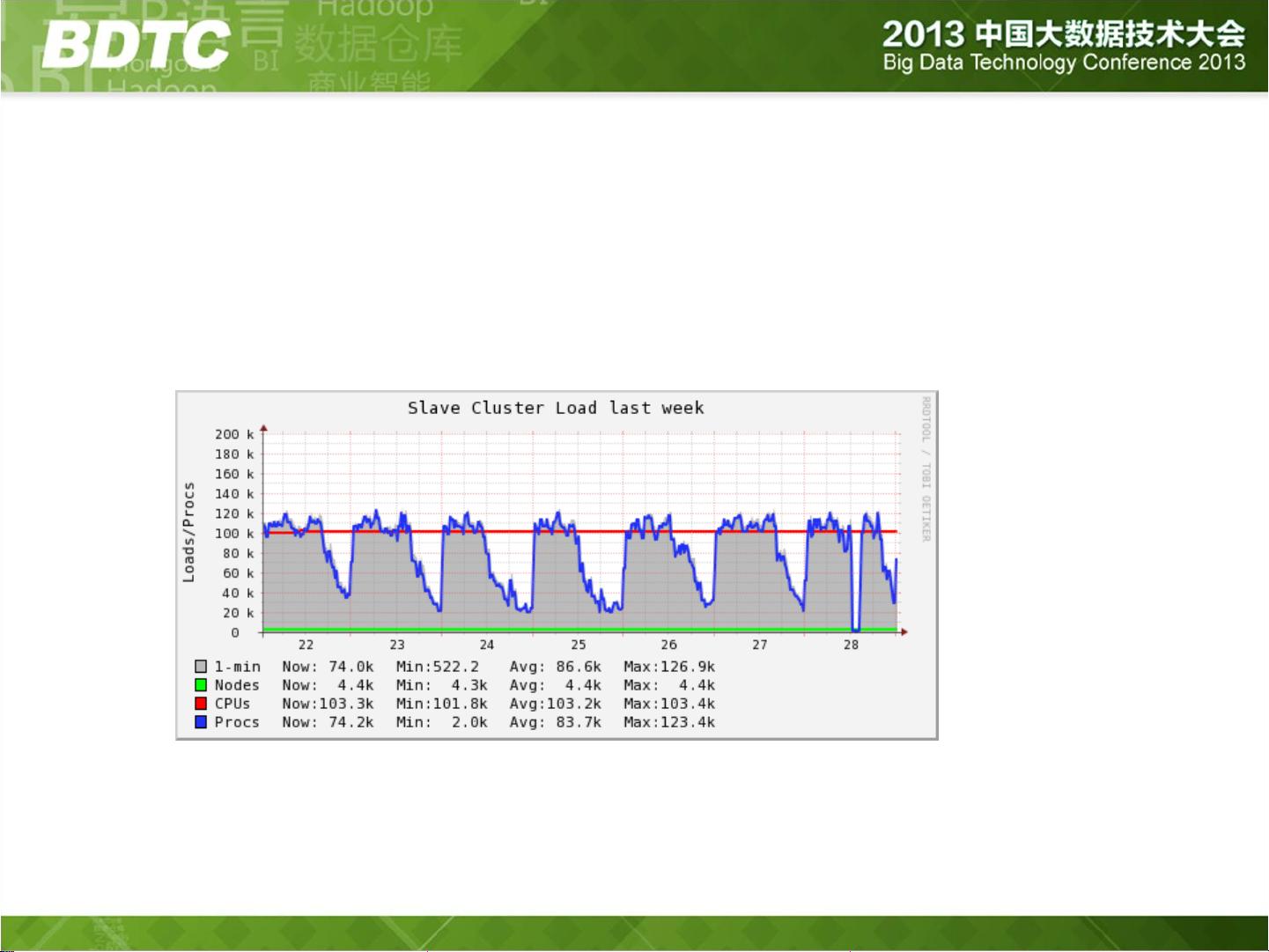

在构建跨机房的Hadoop集群时,会遇到诸多挑战,主要分为以下几点: 1. NameNode的扩展性问题 在Hadoop集群中,NameNode负责管理文件系统的命名空间和客户端对文件的访问,是整个HDFS的关键点。随着集群规模的扩大,NameNode会遇到RPC请求处理性能的压力和内存的限制。此外,JobTracker处理RPC性能、带宽以及JDK的限制等问题也会成为限制集群规模扩展的因素。为解决这些问题,需要对NameNode进行水平扩展,即使用多个NameNode分散请求压力。Facebook采用的HDFS Federation方案就是一个成功的例子,它通过拆分NameSpace来提升集群的可扩展性。 2. 机房间网络限制问题 在不同机房间,网络带宽限制和网络延时问题会显著影响集群的性能。原有的单机房内部带宽为1Gbps,但跨机房间的带宽却只有约20Mbps,这容易成为性能瓶颈。另外,网络延时从1ms增加到5-10ms,对离线作业有一定影响。因此,需要考虑如何处理网络故障,保障服务的连续性和数据的完整性。 3. 数据和计算如何跨机房分布问题 数据和计算资源跨机房分布是一个复杂的问题。集群中可以有多个资源组分布在不同的机房,但任意资源组的计算/存储资源不超过单个机房的总量。默认情况下,一个计算任务的所有任务在同一机房运行,产生的数据也只写到本地机房,这样可以尽量减少跨机房的数据流量。对于读取文件副本,也默认只读取本机房的数据,少部分作业直接跨机房读。 4. 数据迁移和升级问题 随着集群规模的扩大,几十PB级别的数据迁移是一个巨大的挑战。数据迁移不仅要带数据升级,同时要确保整个过程对用户透明,不影响现有业务。 5. 多机房扩展性问题 除了双机房架构外,方案是否能扩展到多个机房(>=3)也需要考虑。这需要更加复杂的架构设计和策略以保证跨更多机房的资源调度和数据一致性。 为了应对上述问题,阿里数据平台事业部在构建跨机房Hadoop集群时,采用了以下技术实现方案: - 采用了HDFS Federation方案,目的是拆分NameSpace,实现多NameNode,从而分散单点的压力,并借鉴了Facebook的成熟经验。 - 在网络限制问题上,通过限制跨机房的带宽和流量,尽量减少网络瓶颈对集群性能的影响。 - 在数据和计算的跨机房分布上,实现了特定的调度策略,确保了计算任务和数据读写的本地性,减少了对跨机房网络资源的依赖。 - 对于大规模数据迁移,需要利用像FastCopy这样高效的数据迁移工具,虽然它比distcp更快且不需要物理拷贝,但仍然需要注意迁移过程的资源消耗和时间成本。 - 在保证用户透明度方面,可能需要实现一些高级的调度和数据副本管理策略,使得用户无需关心数据存储的具体位置,同时也能够在数据迁移和升级期间保证业务的连续性。 以上就是根据文档《构建一个跨机房的Hadoop集群》的核心内容提炼出的知识点,这些信息有助于理解如何在实际操作中解决构建大规模跨机房Hadoop集群时可能遇到的技术挑战。

剩余27页未读,继续阅读

- 粉丝: 136

- 资源: 11

我的内容管理

展开

我的内容管理

展开

我的资源

快来上传第一个资源

我的资源

快来上传第一个资源

我的收益 登录查看自己的收益

我的收益 登录查看自己的收益 我的积分

登录查看自己的积分

我的积分

登录查看自己的积分

我的C币

登录后查看C币余额

我的C币

登录后查看C币余额

我的收藏

我的收藏  我的下载

我的下载  下载帮助

下载帮助

前往需求广场,查看用户热搜

前往需求广场,查看用户热搜最新资源

- 人和箱子检测2-YOLO(v5至v11)、COCO、CreateML、Paligemma、TFRecord、VOC数据集合集.rar

- 清华大学2022年秋季学期 高等数值分析课程报告

- GEE错误集-Cannot add an object of type <Element> to the map. Might be fixable with an explicit .pdf

- 清华大学2022年秋季学期 高等数值分析课程报告

- 矩阵与线程的对应关系图

- 人体人员检测46-YOLO(v5至v9)、COCO、Darknet、TFRecord数据集合集.rar

- GEMM优化代码实现1

- java实现的堆排序 含代码说明和示例.docx

- 资料阅读器(先下载解压) 5.0.zip

- 人、垃圾、非垃圾检测18-YOLO(v5至v11)、COCO、CreateML、Paligemma、TFRecord、VOC数据集合集.rar

信息提交成功

信息提交成功