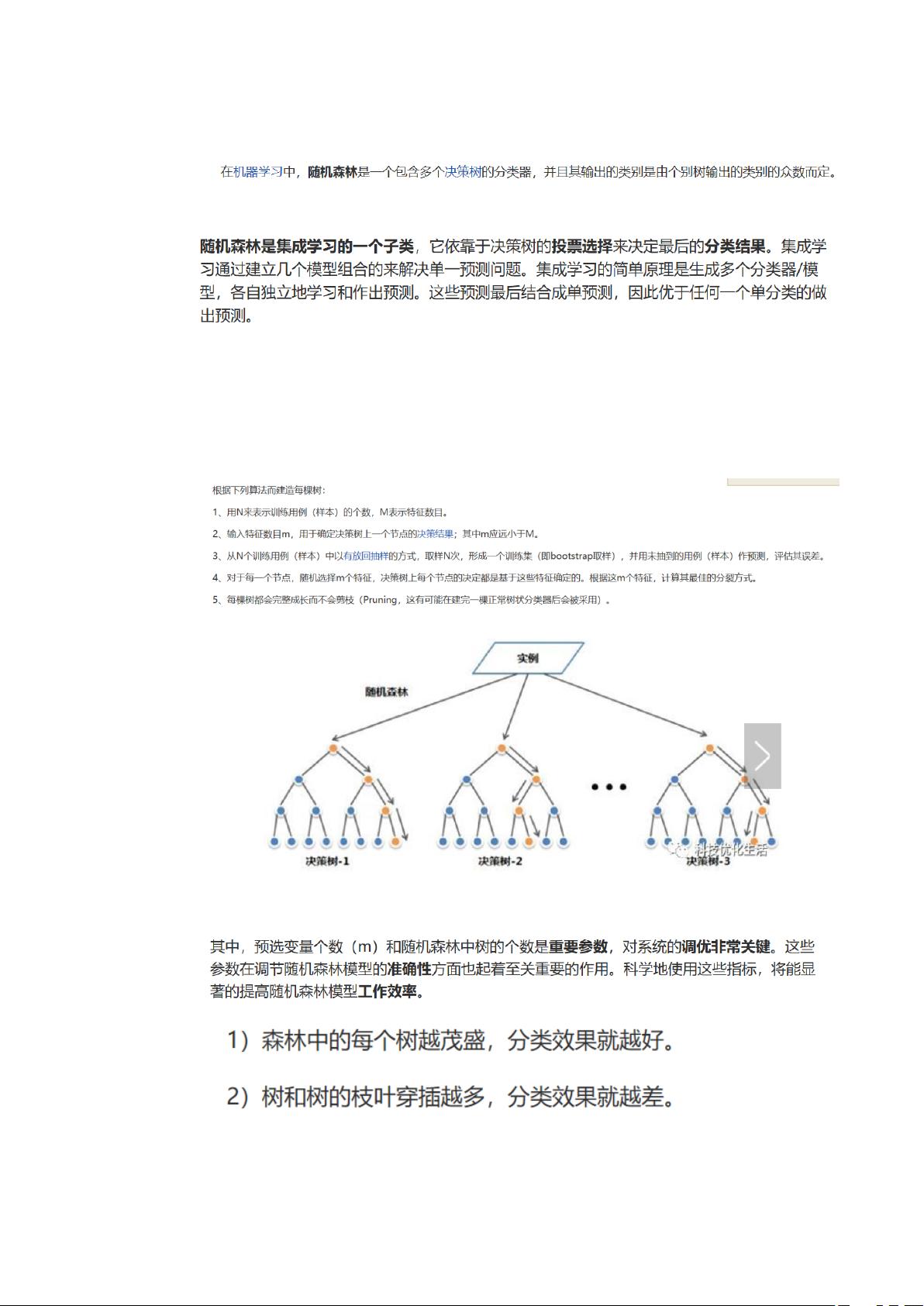

随机森林是一种集成学习方法,由Leo Breiman在2001年提出,它结合了多个决策树的结果,以提高预测的准确性和模型的稳定性。在机器学习领域,随机森林广泛应用于分类和回归任务,尤其在大数据集上表现优秀,因为它能够处理高维数据并有效地减少过拟合。 一、随机森林的工作原理 随机森林通过构建多棵决策树来形成一个“森林”,每棵树在训练时都会对数据进行随机抽样,并在每个节点分裂时仅考虑一小部分特征。这样,每棵树都有不同的决策路径,从而增加了整个模型的多样性。最终,模型的预测结果是所有决策树预测结果的平均或多数投票。 二、影响性能的因素 1. 特征数量:随机森林在构建决策树时,会在每个节点随机选择一定数量的特征进行分割。这个数量通常取特征总数的平方根,但可以根据具体问题进行调整。更多的特征可能导致过拟合,而太少的特征则可能导致欠拟合。 2. 子树及叶子节点数:决策树的深度和分支数量也会影响随机森林的性能。较深的树可能捕获更复杂的模式,但容易过拟合;较浅的树则可能过于简单,无法充分学习数据。 3. 训练样本数量:足够的训练样本有助于模型更好地学习数据分布,但过多的样本可能会增加计算负担。 4. 模块选择:在Python中,常用的随机森林库有scikit-learn,其提供了丰富的参数调整选项和易于使用的接口。 三、评估方式 随机森林的评估指标通常包括准确率、精确率、召回率、F1分数、AUC值等。对于分类任务,可以使用混淆矩阵来分析各个类别预测的准确性。此外,还可以利用交叉验证来评估模型的泛化能力。 四、参数调优 1. n_estimators:这是随机森林中决策树的数量,通常增加此数值会提高模型性能,但也会增加计算成本。 2. max_features:控制每个节点分裂时考虑的特征数量。 3. max_depth:限制决策树的最大深度,防止过拟合。 4. min_samples_split 和 min_samples_leaf:设定内部节点再划分所需的最小样本数和叶子节点最少样本数,以控制树的生长。 五、特征选择 随机森林自身就具有特征选择的能力,通过对每个特征的重要性评分,可以找出对模型预测贡献最大的特征。特征选择步骤包括构建随机森林模型,计算特征重要性,然后根据重要性排序选择最相关的特征。 基于随机森林的特征选择算法包括递归特征消除(RFE)和基于特征重要性的单变量选择等方法,这些策略可以帮助减少特征维度,同时保持模型的预测能力。 随机森林是一种强大的机器学习工具,通过对模型参数的优化和特征选择,可以得到高质量的预测结果。理解并掌握随机森林的工作原理、影响因素以及调优技巧,对于解决实际问题至关重要。

- 粉丝: 26

- 资源: 320

我的内容管理

展开

我的内容管理

展开

我的资源

快来上传第一个资源

我的资源

快来上传第一个资源

我的收益 登录查看自己的收益

我的收益 登录查看自己的收益 我的积分

登录查看自己的积分

我的积分

登录查看自己的积分

我的C币

登录后查看C币余额

我的C币

登录后查看C币余额

我的收藏

我的收藏  我的下载

我的下载  下载帮助

下载帮助

前往需求广场,查看用户热搜

前往需求广场,查看用户热搜最新资源

- 柯尼卡美能达Bizhub C266打印机驱动下载

- java游戏之我当皇帝那些年.zip开发资料

- 基于Matlab的汉明码(Hamming Code)纠错传输以及交织编码(Interleaved coding)仿真.zip

- 中国省级新质生产力发展指数数据(任宇新版本)2010-2023年.txt

- 基于Matlab的2Q-FSK移频键控通信系统仿真.zip

- 使用C++实现的常见算法

- travel-web-springboot【程序员VIP专用】.zip

- 基于Matlab, ConvergeCase中部分2D结果文件输出至EXCEL中 能力有限,代码和功能极其简陋.zip

- java桌面小程序,主要为游戏.zip学习资源

- Java桌面-坦克大战小游戏.zip程序资源

信息提交成功

信息提交成功

评论0