20_随机森林思想1

需积分: 0 54 浏览量

更新于2022-08-03

收藏 555KB PDF 举报

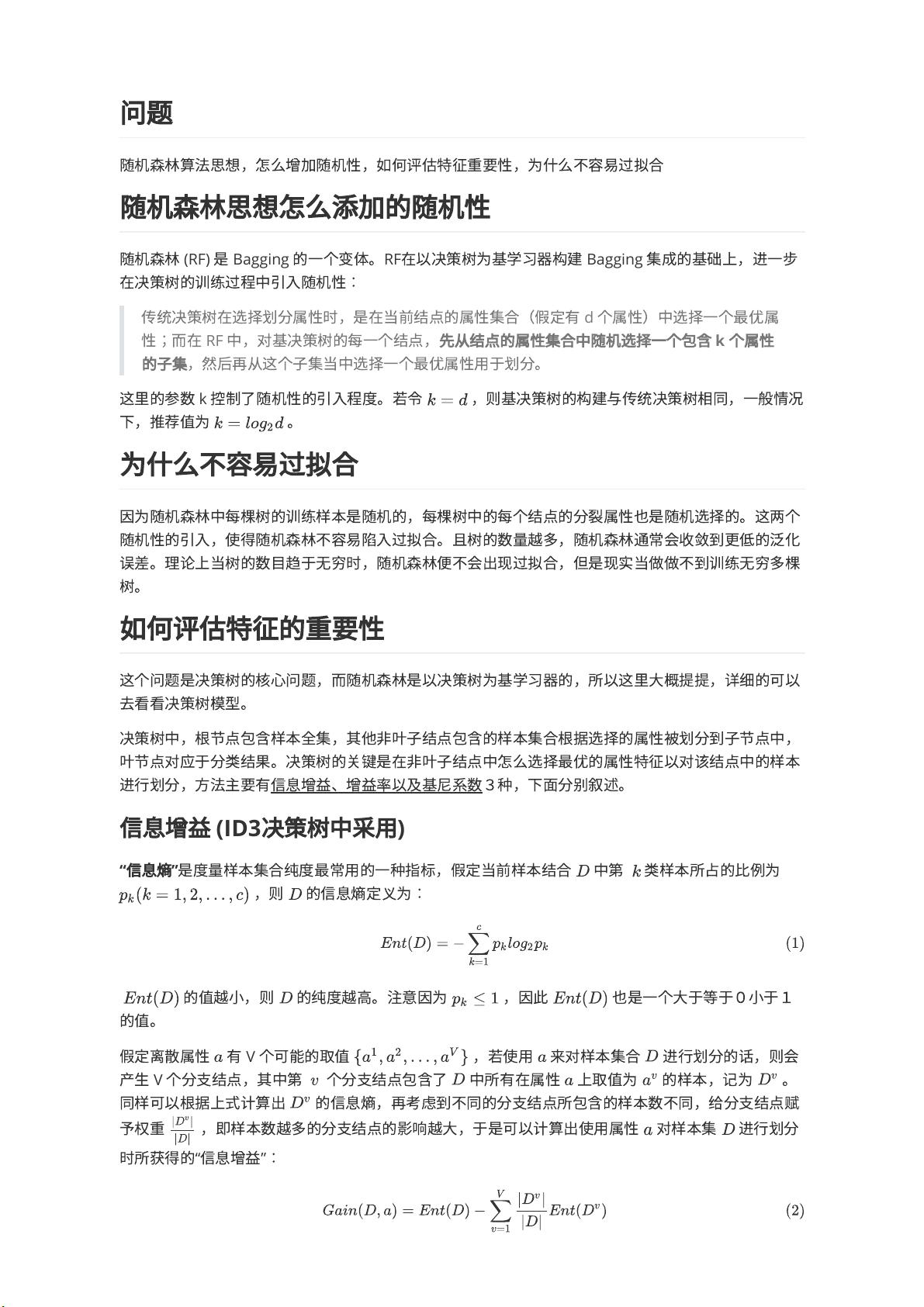

随机森林(Random Forest)是一种集成学习方法,主要用于分类和回归任务。它是基于决策树的bagging策略,并引入了额外的随机性来增强模型的泛化能力。随机森林通过构建大量的决策树并结合它们的预测结果来做出最终的决策,从而减少了单棵决策树可能产生的过拟合问题。

**随机性的引入**

随机森林在构建每棵决策树时引入了两方面的随机性:

1. **样本随机性**:每棵树不是用全部训练样本进行训练,而是从原始样本集中采用Bootstrap抽样(有放回抽样)的方式来生成一个子样本集,这个子样本集被称为“自助样本”。

2. **特征随机性**:在选择划分属性时,不是考虑所有特征,而是从特征集中随机选取一个较小的子集,然后在子集中选择最优属性进行划分。具体来说,如果特征总数为d,通常会随机选取k个特征,其中k通常取sqrt(d)或log2(d)。

**防止过拟合的原因**

由于随机森林的这两个特性,每棵树都是在不同的样本子集和特征子集上训练,这样就使得每棵树都有一定的差异。当这些树的预测结果进行投票或平均时,它们的错误或过拟合倾向会相互抵消,从而提高了整体模型的泛化能力。此外,随着树的数量增加,随机森林的预测性能通常会逐渐提高,直到达到一个稳定状态,这进一步降低了过拟合的风险。

**特征重要性的评估**

在随机森林中,特征重要性的评估主要基于以下几种方法:

1. **基尼指数**:在决策树构建过程中,计算每个特征在划分数据时降低的基尼指数总和,这个总和越大,表明特征的重要性越高。

2. **信息增益**:类似地,也可以计算每个特征在划分数据时增加的信息熵,信息增益越大,特征越重要。

3. **增益率**:为了克服信息增益对多值特征的偏好,可以使用增益率,它通过除以属性的固有信息来调整信息增益,使评价更加公平。

在随机森林中,通常会综合考虑每棵树中各个特征的选择频率,或者使用上述方法计算的得分,来确定特征的重要性排名。

总结来说,随机森林通过引入随机性,避免了过拟合,同时通过构建多棵树和评估特征重要性,提供了强大的预测能力和对特征的洞察。它广泛应用于各种机器学习问题,如信用评分、医学诊断、文本分类等。

张景淇

- 粉丝: 42

- 资源: 275

最新资源

- MBR污水一体化处理系统(集装箱)工程图机械结构设计图纸和其它技术资料和技术方案非常好100%好用.zip

- lattice diamond3.11的license文件

- vsvbxcygsyzgvytfvdyvs

- DJS-042-锁螺丝机方案工程图机械结构设计图纸和其它技术资料和技术方案非常好100%好用.zip

- FMASTERSW3.2版本

- qemu上运行Linux系统开启并验证IMA功能

- HE-Drive-main.zip

- mysql安装配置教程.txt

- mysql安装配置教程.txt

- mysql安装配置教程.txt

- 汇川伺服6V30-EOE-MXL文件-037515

- 2024中国CIO&CDO现状、挑战及未来趋势研究报告

- 鼠标连点器+自动单机+录制点击

- 4G DTU串口数据采集网关设计全套资料(源码、原理图、外壳文件、产品手册).zip

- 利用Python绘制装饰圣诞树的技术实例

- 测试程序:qabstractvideosurface