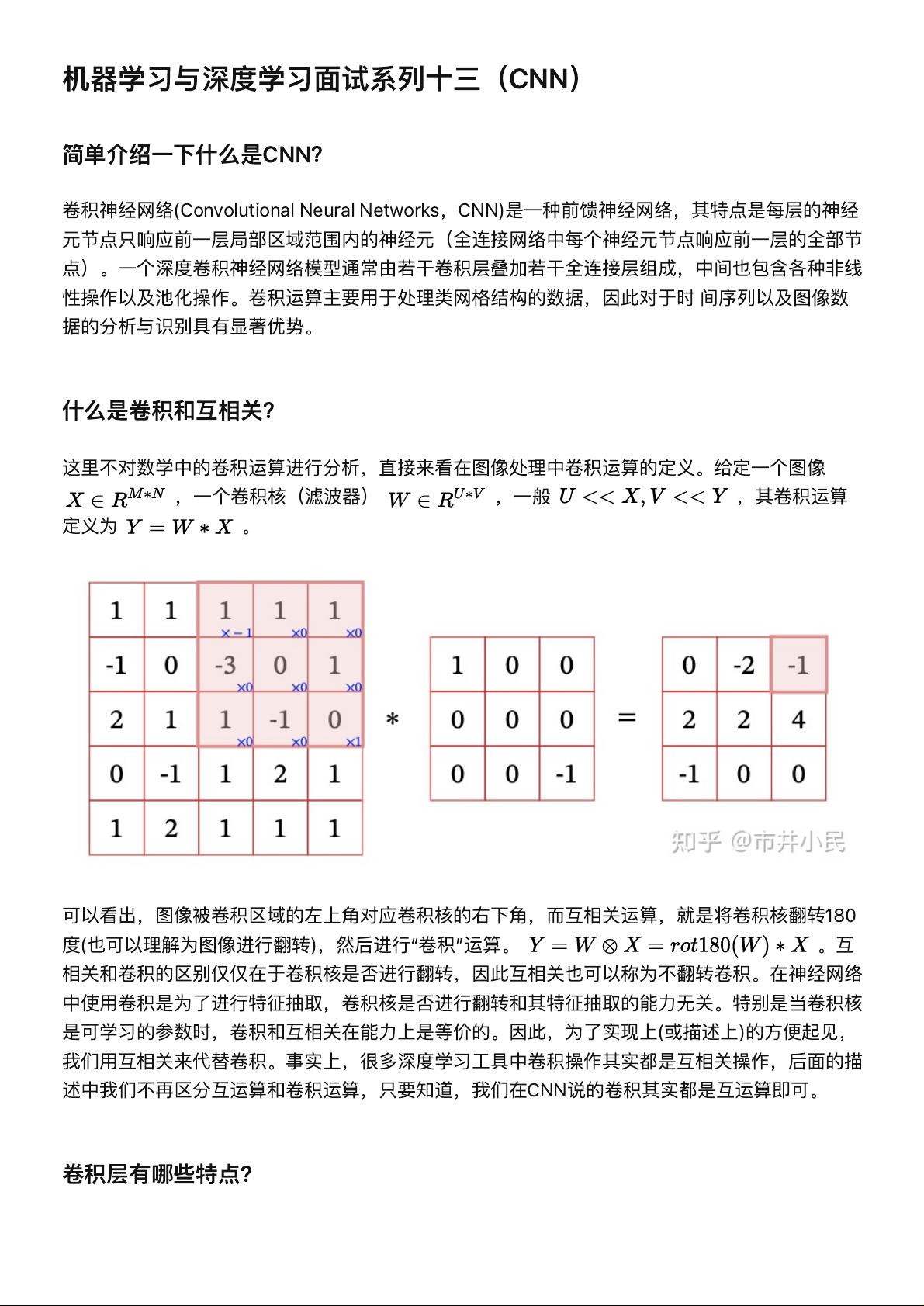

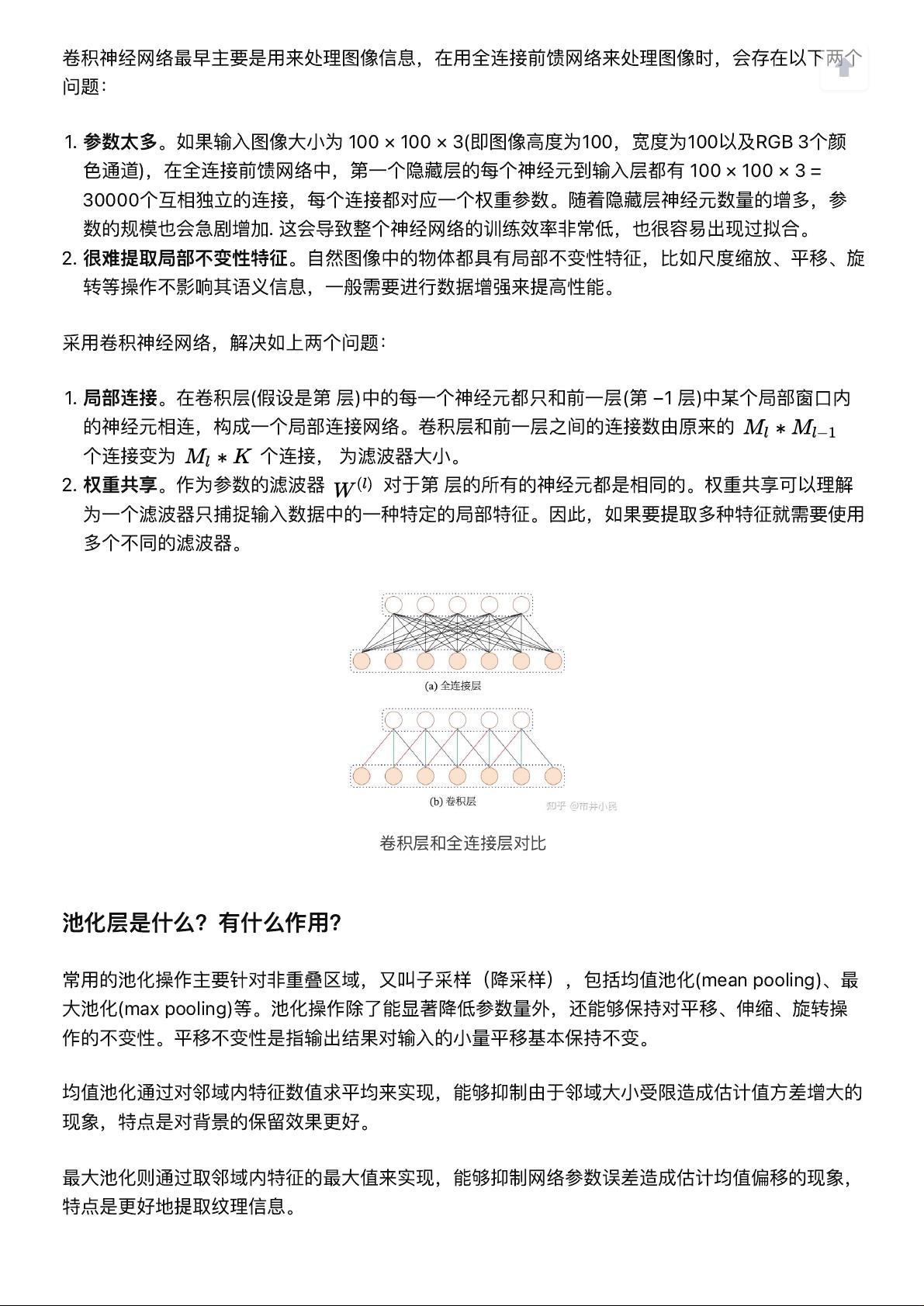

卷积神经网络(CNN)是一种在机器学习和深度学习领域广泛应用的神经网络架构,特别适合处理图像数据。CNN的核心特性在于其卷积层和池化层。 卷积层是CNN的基础,它解决了传统全连接网络在处理图像时面临的两个主要问题。参数太多。在全连接网络中,每一层神经元与前一层的所有神经元都有连接,导致参数数量庞大,这不仅增加了计算复杂性,还容易引起过拟合。全连接网络难以捕捉局部不变性特征,即图像中的物体在尺度变化、平移或旋转后,其基本特征应保持不变。为了解决这些问题,CNN引入了局部连接和权重共享。局部连接意味着卷积层的每个神经元只与其前一层的一个小区域内的神经元相连,减少连接数。权重共享则是每个卷积核在整个卷积层中都使用同一组参数,用于检测特定的局部特征,从而减少参数数量并提高模型的泛化能力。 卷积运算在图像处理中扮演着关键角色,它可以通过卷积核(滤波器)对输入图像进行扫描,提取特征。卷积和互相关在实际应用中并无本质区别,因为卷积核是否翻转并不影响特征抽取的能力。在CNN中,通常采用互相关操作来实现卷积。 池化层是CNN的另一重要组件,它通过下采样技术减小数据维度,降低计算复杂性,同时增强模型对位置变化的鲁棒性。常见的池化操作有均值池化和最大池化。均值池化通过计算邻域内的平均值来平滑结果,而最大池化则选取邻域的最大值,更有利于捕捉关键特征。 卷积和池化都可以看作是矩阵运算的一种形式。例如,卷积可以通过卷积核对输入图像进行扫描,池化则可以视为特殊形式的卷积,如最大池化相当于使用所有元素为1的卷积核进行最大值选择。计算卷积层和池化层的输出尺寸以及参数量,需要考虑卷积核大小、步长、填充等因素。 感受野是描述卷积神经网络中某一层神经元对输入数据响应的区域大小。通过从输出层向输入层逆向计算,我们可以得到每个神经元的感受野大小。 除了基本的卷积,还有许多变种,如分组卷积(Group Convolution),它将输入通道分割成若干组,每组进行独立的卷积运算,减少了计算量,常用于ResNet等模型;转置卷积(Transposed Convolution)或上采样层,用于增大输出尺寸,常用于生成对抗网络(GANs)和图像超分辨率任务;以及深度卷积(Deep Convolution),通过增加卷积层的堆叠深度来提取更复杂的特征。这些变种进一步丰富了CNN的表达能力和应用场景。

剩余10页未读,继续阅读

- 粉丝: 38

- 资源: 324

我的内容管理

展开

我的内容管理

展开

我的资源

快来上传第一个资源

我的资源

快来上传第一个资源

我的收益 登录查看自己的收益

我的收益 登录查看自己的收益 我的积分

登录查看自己的积分

我的积分

登录查看自己的积分

我的C币

登录后查看C币余额

我的C币

登录后查看C币余额

我的收藏

我的收藏  我的下载

我的下载  下载帮助

下载帮助

前往需求广场,查看用户热搜

前往需求广场,查看用户热搜最新资源

信息提交成功

信息提交成功

评论0