LSTM(Long Short-Term Memory)一种特殊的循环神经网络(RNN)架构

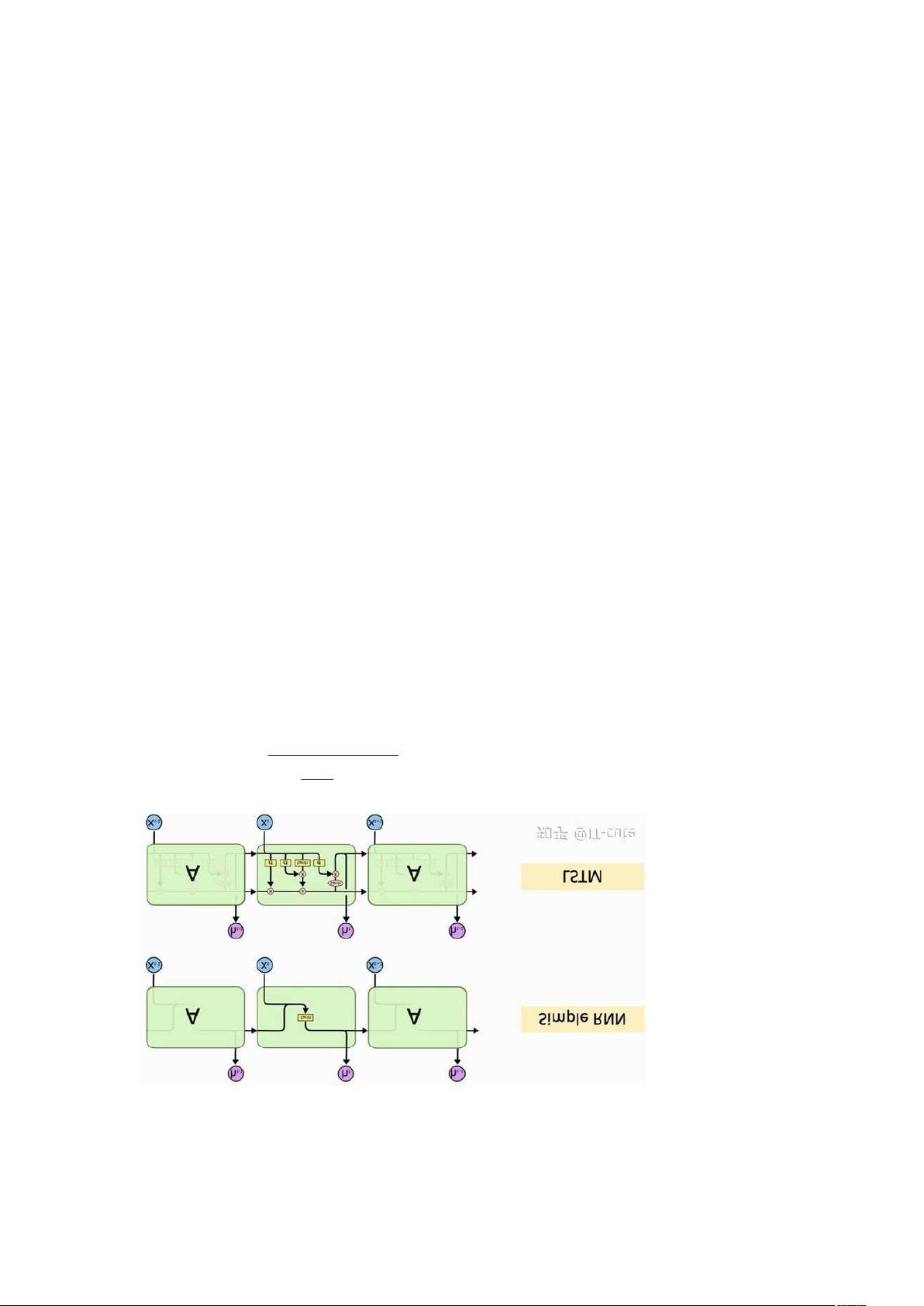

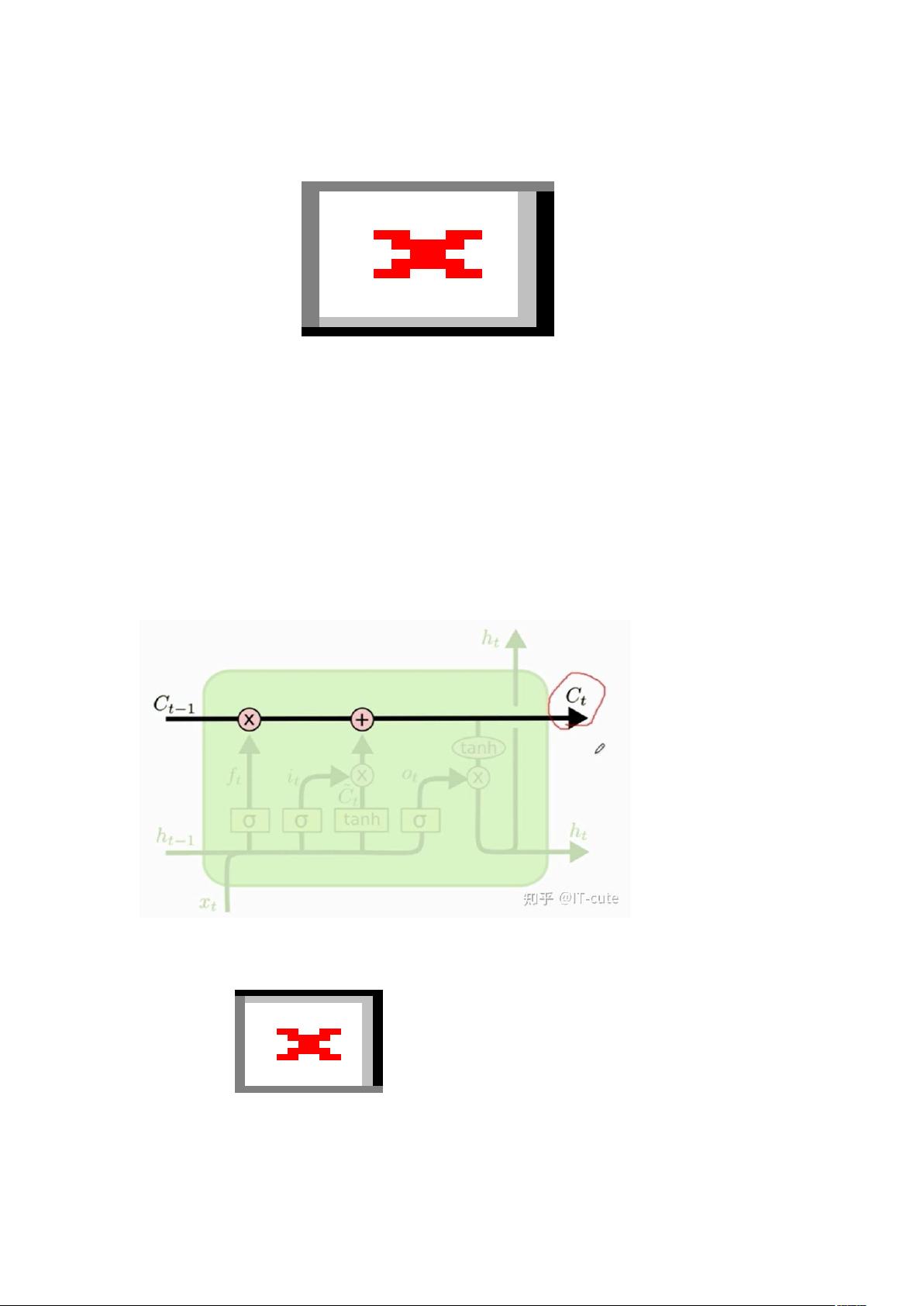

LSTM(Long Short-Term Memory)是一种特殊的循环神经网络(RNN)架构,用于解决传统RNN在处理长期依赖问题时遇到的梯度消失或梯度爆炸问题。LSTM通过引入“门”机制(遗忘门、输入门、输出门)来控制信息的流动,从而能够在较长的时间序列上有效地保存和传递信息。 LSTM 的核心组件 遗忘门(Forget Gate):决定从单元状态中丢弃哪些信息。它读取上一时刻的隐藏状态 h t−1 和当前时刻的输入 x t ,然后输出一个0到1之间的数值给单元状态 C t−1 中的每个元素。1表示“完全保留”,0表示“完全遗忘”。 输入门(Input Gate):决定哪些新信息将被存储在单元状态中。首先,一个称为“候选单元状态”的 C ~ t 被创建出来,它同样基于 h t−1 和 x t 。然后,输入门通过另一个sigmoid层来决定哪些信息将被更新到单元状态中。 单元状态更新:将遗忘门和输入门的输出结合起来,更新单元状态。具体来说,就是先使用遗忘门丢弃掉单元状态中的部分信息,然后再添加新的候选单元状态信息。 输 ### LSTM(Long Short-Term Memory)一种特殊的循环神经网络(RNN)架构 #### 引言 LSTM(Long Short-Term Memory)是一种特殊的循环神经网络(RNN)架构,旨在解决传统RNN处理长期依赖问题时遇到的梯度消失或梯度爆炸问题。通过对信息流动的精细控制,LSTM能够在较长的时间序列上有效地保存和传递信息。 #### LSTM的核心组件 ##### 遗忘门(Forget Gate) 遗忘门决定从单元状态中丢弃哪些信息。它读取上一时刻的隐藏状态 \( h_{t-1} \) 和当前时刻的输入 \( x_t \),然后输出一个0到1之间的数值给单元状态 \( C_{t-1} \) 中的每个元素。该输出表示“遗忘比率”,其中1表示“完全保留”,0表示“完全遗忘”。这一机制使得LSTM能够自主地选择遗忘哪些历史信息,从而减轻了长期依赖问题的影响。 **数学表达式**: \[ f_t = \sigma(W_f[h_{t-1}, x_t] + b_f) \] 其中,\( W_f \) 和 \( b_f \) 是权重矩阵和偏置项,\(\sigma\) 表示sigmoid函数。 ##### 输入门(Input Gate) 输入门决定哪些新信息将被存储在单元状态中。一个称为“候选单元状态”的 \( \tilde{C}_t \) 被创建出来,它同样基于 \( h_{t-1} \) 和 \( x_t \)。然后,输入门通过另一个sigmoid层来决定哪些信息将被更新到单元状态中。 **数学表达式**: \[ i_t = \sigma(W_i[h_{t-1}, x_t] + b_i) \] \[ \tilde{C}_t = \tanh(W_C[h_{t-1}, x_t] + b_C) \] 其中,\( W_i \) 和 \( b_i \) 分别是输入门的权重矩阵和偏置项,\( W_C \) 和 \( b_C \) 分别是用于计算候选单元状态的权重矩阵和偏置项。 ##### 单元状态更新 单元状态更新是将遗忘门和输入门的输出结合起来,更新单元状态的过程。具体来说,先使用遗忘门丢弃掉单元状态中的部分信息,然后再添加新的候选单元状态信息。 **数学表达式**: \[ C_t = f_t \circ C_{t-1} + i_t \circ \tilde{C}_t \] 其中,\( \circ \) 表示逐元素乘法。 ##### 输出门(Output Gate) 输出门决定哪些信息将被输出作为当前时刻的隐藏状态 \( h_t \)。这个输出将基于更新后的单元状态 \( C_t \),但首先会通过一个sigmoid层来决定哪些部分将被输出。然后,单元状态 \( C_t \) 通过一个tanh层(将值规范到-1到1之间),再与sigmoid层的输出相乘,最终得到 \( h_t \)。 **数学表达式**: \[ o_t = \sigma(W_o[h_{t-1}, x_t] + b_o) \] \[ h_t = o_t \circ \tanh(C_t) \] 其中,\( W_o \) 和 \( b_o \) 分别是输出门的权重矩阵和偏置项。 #### LSTM的应用 LSTM由于其能够处理长期依赖的能力,在多个领域有着广泛的应用: - **自然语言处理(NLP)**:如文本生成、机器翻译、情感分析等。 - **语音识别**:将音频序列转换为文本序列。 - **时间序列预测**:如股票价格预测、天气预测等。 - **推荐系统**:通过分析用户的历史行为来预测用户可能感兴趣的内容。 #### 总结 LSTM是一种强大的循环神经网络架构,它通过引入门机制有效地解决了传统RNN在处理长期依赖时遇到的问题。LSTM的广泛应用证明了它在处理序列数据方面的能力。此外,LSTM的核心思想在于引入了一种类似于“传输带”的机制——单元状态(Cell State),这使得LSTM能够在长序列中保持信息不变,避免了梯度消失的问题。 #### 参数数量 LSTM具有四个主要参数矩阵,每个参数矩阵的行数为状态向量 \( h \) 的维度,列数为状态向量 \( h \) 的维度加上输入向量 \( x \) 的维度。因此,LSTM的参数数量(不包括偏置项)为: \[ 4 \times \text{shape}(h) \times [\text{shape}(h) + \text{shape}(x)] \] #### 实践案例 例如,在IMDB影评分类任务中,设置以下超参数: - 词典大小 \( \text{vocabulary} = 10000 \) - 词嵌入维度 \( \text{embedding_dim}=32 \) - 每条评论的单词数 \( \text{word_num} = 500 \) - 状态向量维度 \( \text{state_dim} = 32 \) 构建模型时,可以采用以下步骤: 1. 创建Sequential模型。 2. 添加Embedding层,该层将单词映射到低维空间中的向量。 3. 添加LSTM层,该层处理序列数据并捕获长期依赖关系。 4. 添加Dense层,用于最终的分类输出。 LSTM作为一种特殊的循环神经网络架构,不仅有效解决了传统RNN存在的梯度消失或梯度爆炸问题,而且通过其独特的门机制实现了对序列数据中长期依赖的有效捕捉和处理,这使得LSTM在众多实际应用场景中表现出色。

剩余11页未读,继续阅读

- 粉丝: 7167

- 资源: 373

我的内容管理

展开

我的内容管理

展开

我的资源

快来上传第一个资源

我的资源

快来上传第一个资源

我的收益 登录查看自己的收益

我的收益 登录查看自己的收益 我的积分

登录查看自己的积分

我的积分

登录查看自己的积分

我的C币

登录后查看C币余额

我的C币

登录后查看C币余额

我的收藏

我的收藏  我的下载

我的下载  下载帮助

下载帮助

前往需求广场,查看用户热搜

前往需求广场,查看用户热搜最新资源

- 基于Java开发的简洁方便ORM工具BeetlSQL设计源码

- 基于Java语言的Reactor-QL:用SQL简化Reactor API实时数据处理设计源码

- 基于Java的tio-http-server演示学习源码

- 基于Java和C#的C#课程实验与Winform学习及Android实验设计源码

- 基于Java的电厂职工管理系统设计源码

- 基于Python的RSA+AES加密的SecureHTTP设计源码

- 基于Java平台的集成nsg-dao设计源码,涵盖jdbc、hibernate、mybatis框架

- 基于Vue的Java+JavaScript+CSS+HTML搭建的二手交易平台设计源码

- 基于Java和Vue的Spring Boot博客系统设计源码

- 基于MS51单片机的eeprom32与sst39vf040存储器读写设计源码

信息提交成功

信息提交成功