NExT-GPT: Any-to-Any Multimodal LLM

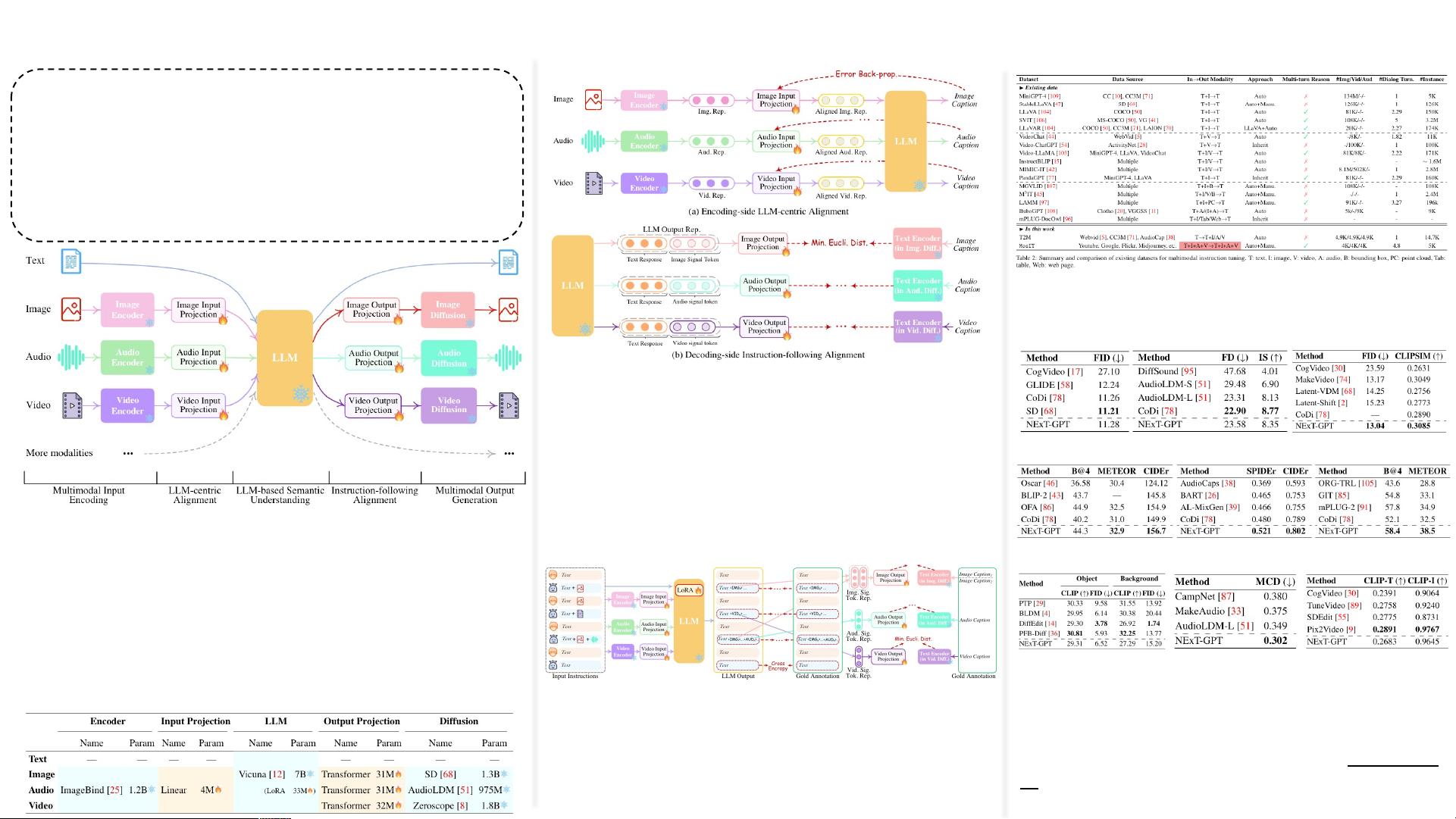

NExT-GPT:Any-to-Any Multimodal LLM NExT-GPT是一种Any-to-Any Multimodal语言模型(LLM),旨在解决现有视觉语言模型受到多模态输入端理解的限制,无法以多种模态生成内容的问题。该模型通过将LLM与多模态适配器和不同的扩散解码器进行连接,能够接受和生成多模态内容。 模型架构分为三个阶段:多模态编码阶段、LLM理解与推理阶段和多模态生成阶段。在多模态编码阶段,模型使用现有比较完善的模型对各种模式的输入进行编码。在LLM理解与推理阶段,模型选择一个LLM作为核心Agent,其负责接收不同模态信息并进行理解和推理,输出分为两种:文本形式的回复和每种模态的signal tokens用于解码。在多模态生成阶段,从LLM接收具有特定指令的多模态信号,基于Transformer的输出投影层将信号标记表示映射为后续多模态解码器可以理解的表示形式。 为了弥合不同模态特征空间之间的差距,并确保不同输入的流畅语义理解,模型使用对齐学习。对齐学习分为两部分:编码侧和解码侧。在编码侧,模型基于现有与语料库和benchmark准备X-caption对,X表示图片、视频、音频,实现其他模态与文本模态的对齐。在解码侧,模型为了让LLM输出的signal token中蕴含更有效的模态信息用于扩散模型,最小化signal token与扩散模型的条件文本表示之间的距离。 模型还需要进行指令微调,以确保整个系统可以忠实地遵循和理解用户的指令。使用(输入,输出)对进行指令微调,并使用对应的Loss进行优化。 实验结果表明,该模型取得了较优的实验结果,证明了方案的可行性。实验分析较少,但模型在不同模态设置下进行了详细的实验验证,通过与各个模态设置的基线方法进行对比。 NExT-GPT模型的贡献在于: 1. 实现Any-to-Any Multimodal生成,解决了现有视觉语言模型受到多模态输入端理解的限制的问题。 2. 提出了一个新的多模态适配器和不同的扩散解码器,能够接受和生成多模态内容。 3. 使用对齐学习和指令微调,确保不同输入的流畅语义理解和整个系统可以忠实地遵循和理解用户的指令。 NExT-GPT模型是一种创新性的多模态语言模型,能够接受和生成多模态内容,解决了现有视觉语言模型的限制,具有广泛的应用前景。

- 粉丝: 79

- 资源: 2

我的内容管理

展开

我的内容管理

展开

我的资源

快来上传第一个资源

我的资源

快来上传第一个资源

我的收益 登录查看自己的收益

我的收益 登录查看自己的收益 我的积分

登录查看自己的积分

我的积分

登录查看自己的积分

我的C币

登录后查看C币余额

我的C币

登录后查看C币余额

我的收藏

我的收藏  我的下载

我的下载  下载帮助

下载帮助

前往需求广场,查看用户热搜

前往需求广场,查看用户热搜最新资源

信息提交成功

信息提交成功