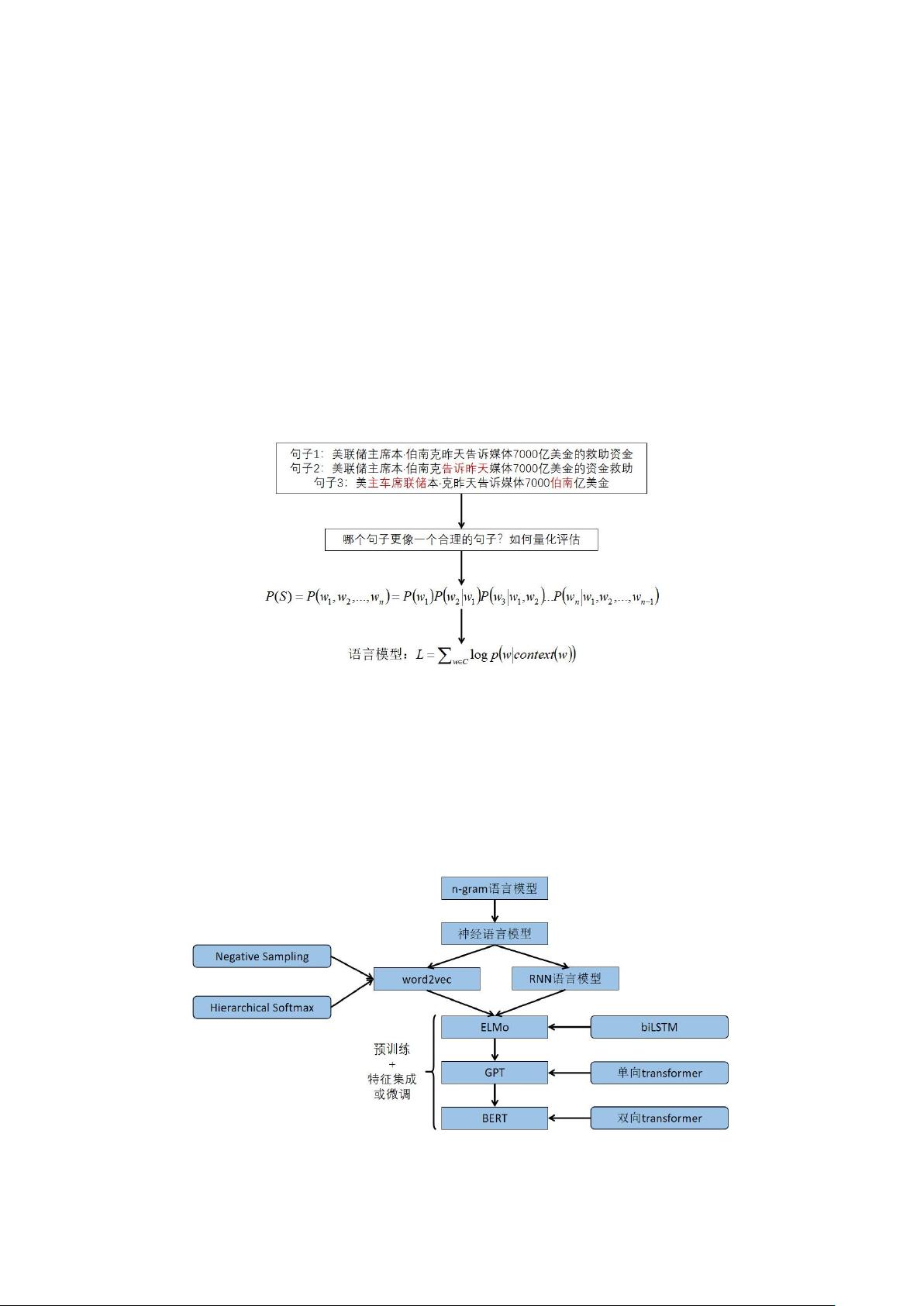

讲述语言模型的发展历史,对阶段性较有代表性的工作进行了简述,同时对一些重要的技术细节展开了分析,主要从n-gram语言模型到BERT预训练语言模型,同时对这些模型的应用场景也进行了阐述,可以帮助我们整理思路,提供学习素材。 自然语言处理任务中,语言模型扮演着至关重要的角色,它旨在评估句子的合理性,并通过学习大量无标注的语料库来获取丰富的语义知识。语言模型最初应用于语音识别,如今在各种自然语言处理应用中均有广泛应用,如机器翻译、情感分析、问答系统等。 统计语言模型是早期的语言模型,主要代表是n-gram模型。n-gram模型基于马尔可夫假设,即当前词的出现概率只与其前面的n-1个词相关。例如,一阶马尔可夫模型(bigram)假设当前词只依赖于前一个词,而二阶马尔可夫模型(trigram)则考虑前两个词。尽管n-gram模型简单实用,但存在“数据稀疏”问题,即许多n-gram组合在实际语料中未出现,导致模型预测能力受限。 随着计算能力的提升,神经网络语言模型应运而生,其中包括词嵌入模型如word2vec和GloVe,它们通过学习词的分布式表示来捕获词汇间的语义关系。词嵌入模型的成功激发了基于循环神经网络(RNN)的语言模型,如LSTM和GRU,这些模型能够考虑更长的上下文信息。然而,RNN在处理长距离依赖时仍有挑战。 ELMo(Embeddings from Language Models)引入了上下文敏感的词向量,通过预训练的深度双向RNN来生成不同位置词的不同表示。这一进步为理解句子的复杂结构提供了更强大的工具。随后,Transformer架构的GPT(Generative Pre-training)模型进一步革新了语言模型,通过自注意力机制解决了RNN的长距离依赖问题,提高了模型的并行计算效率。 BERT(Bidirectional Encoder Representations from Transformers)则是预训练语言模型的最新里程碑,它首次实现了双向预训练,使得模型能够充分利用前后文信息。BERT通过 masked language modeling 和 next sentence prediction 任务在大规模无标注数据上进行预训练,然后在特定任务上进行微调,从而在多个自然语言处理任务上取得了前所未有的效果。 这些语言模型的发展历程反映了自然语言处理领域不断追求更准确、更全面理解和生成自然语言的过程。从n-gram到BERT,模型的复杂性和表达能力逐步增强,但也带来了计算资源的需求增加。未来的研究可能会继续探索更高效、更强大的模型,以更好地模拟人类的语言理解和生成能力。同时,预训练与微调的范式已成为主流,预训练模型的泛化能力和适应性将继续推动自然语言处理技术的前进。

剩余38页未读,继续阅读

- 粉丝: 19

- 资源: 4

我的内容管理

展开

我的内容管理

展开

我的资源

快来上传第一个资源

我的资源

快来上传第一个资源

我的收益 登录查看自己的收益

我的收益 登录查看自己的收益 我的积分

登录查看自己的积分

我的积分

登录查看自己的积分

我的C币

登录后查看C币余额

我的C币

登录后查看C币余额

我的收藏

我的收藏  我的下载

我的下载  下载帮助

下载帮助

前往需求广场,查看用户热搜

前往需求广场,查看用户热搜最新资源

信息提交成功

信息提交成功