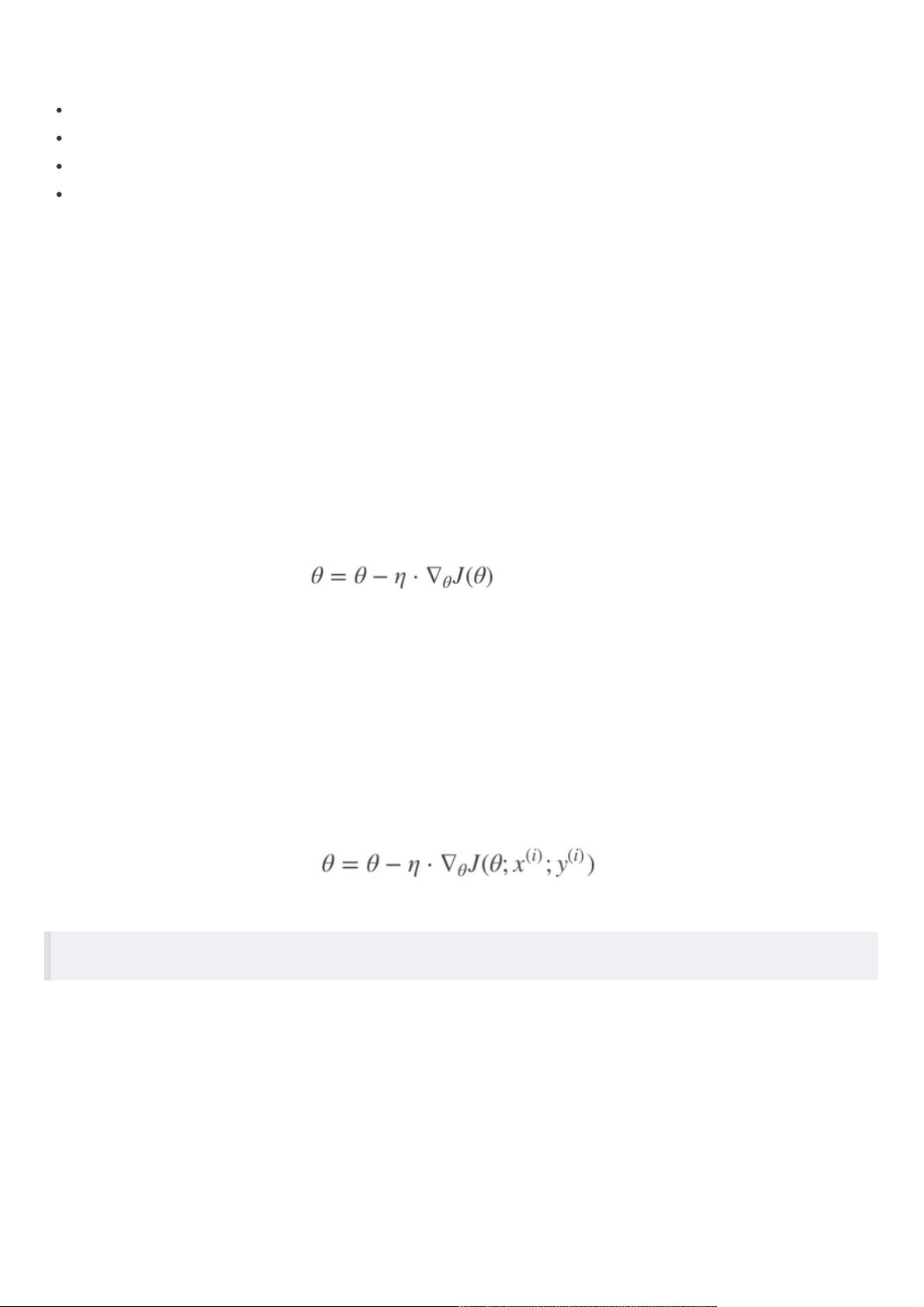

梯度下降法全梯度下降算法(Full gradient descent), 随机梯度下降算法(Stochastic gradient descent), 随机平均梯度下降算法(Stochastic average gradient descent) ⼩批量梯度下降算法(Mini-batch gradient descent), 梯度下降法是机器学习和优化领域中一种广泛使用的算法,用于寻找函数最小值。它主要分为四种变体:全梯度下降法、随机梯度下降法、小批量梯度下降法以及随机平均梯度下降法。 1. 全梯度下降算法(Full Gradient Descent, FG): 全梯度下降是最基础的形式,它在每次迭代时计算整个训练集的梯度,从而更新权重。这种算法保证了每次更新都是沿着全局梯度方向进行,因此在理论上能保证收敛到全局最小值。然而,由于需要遍历所有样本,对于大规模数据集,计算时间和资源需求较大,不适用于实时或在线学习。 2. 随机梯度下降算法(Stochastic Gradient Descent, SGD): SGD在每次迭代时只使用一个随机选取的样本进行梯度计算和更新,大大减少了计算量,适合处理大数据集。由于每次只考虑一个样本,SGD可能会在局部最优解附近震荡,导致收敛速度不均匀,但总体趋势仍是向全局最小值靠近。它也能适应在线学习,即在新数据到来时立即更新模型。 3. 小批量梯度下降算法(Mini-batch Gradient Descent): 小批量梯度下降是FG和SGD的折衷方案,每次迭代使用一小部分随机选取的样本(batch_size)来计算梯度。这样既降低了每次迭代的计算复杂度,又能获得比SGD更稳定的更新方向。batch_size的选择会影响算法的性能,通常设置为2的幂次方以优化GPU计算效率。当batch_size等于1时,小批量梯度下降退化为SGD;当batch_size等于训练样本总数n时,就变为全梯度下降。 4. 随机平均梯度下降算法(Stochastic Average Gradient, SAG): SAG在内存中为每个样本维护一个梯度的平均值,每次更新时仅计算一个样本的新梯度并更新该样本的平均值,而其他样本的平均梯度保持不变。这使得SAG能够更快地收敛,同时保持了SGD的低计算成本。与FG和SGD相比,SAG在处理大规模数据时具有更好的性能。 在实际应用中,选择哪种梯度下降方法取决于具体问题的规模、计算资源和对收敛速度的要求。对于大型数据集,SGD和小批量梯度下降更为实用,而SAG则提供了更快的收敛速度。全梯度下降在小数据集或计算资源充足的情况下可能更有优势。通过实验比较,例如在逻辑二分类任务中,可以清晰地看到不同算法在迭代次数、收敛速度和计算时间上的差异。

- 粉丝: 800

- 资源: 232

我的内容管理

展开

我的内容管理

展开

我的资源

快来上传第一个资源

我的资源

快来上传第一个资源

我的收益 登录查看自己的收益

我的收益 登录查看自己的收益 我的积分

登录查看自己的积分

我的积分

登录查看自己的积分

我的C币

登录后查看C币余额

我的C币

登录后查看C币余额

我的收藏

我的收藏  我的下载

我的下载  下载帮助

下载帮助

前往需求广场,查看用户热搜

前往需求广场,查看用户热搜最新资源

- 技术资料分享TF卡资料很好的技术资料.zip

- 技术资料分享TF介绍很好的技术资料.zip

- 10、安徽省大学生学科和技能竞赛A、B类项目列表(2019年版).xlsx

- 9、教育主管部门公布学科竞赛(2015版)-方喻飞

- C语言-leetcode题解之83-remove-duplicates-from-sorted-list.c

- C语言-leetcode题解之79-word-search.c

- C语言-leetcode题解之78-subsets.c

- C语言-leetcode题解之75-sort-colors.c

- C语言-leetcode题解之74-search-a-2d-matrix.c

- C语言-leetcode题解之73-set-matrix-zeroes.c

信息提交成功

信息提交成功