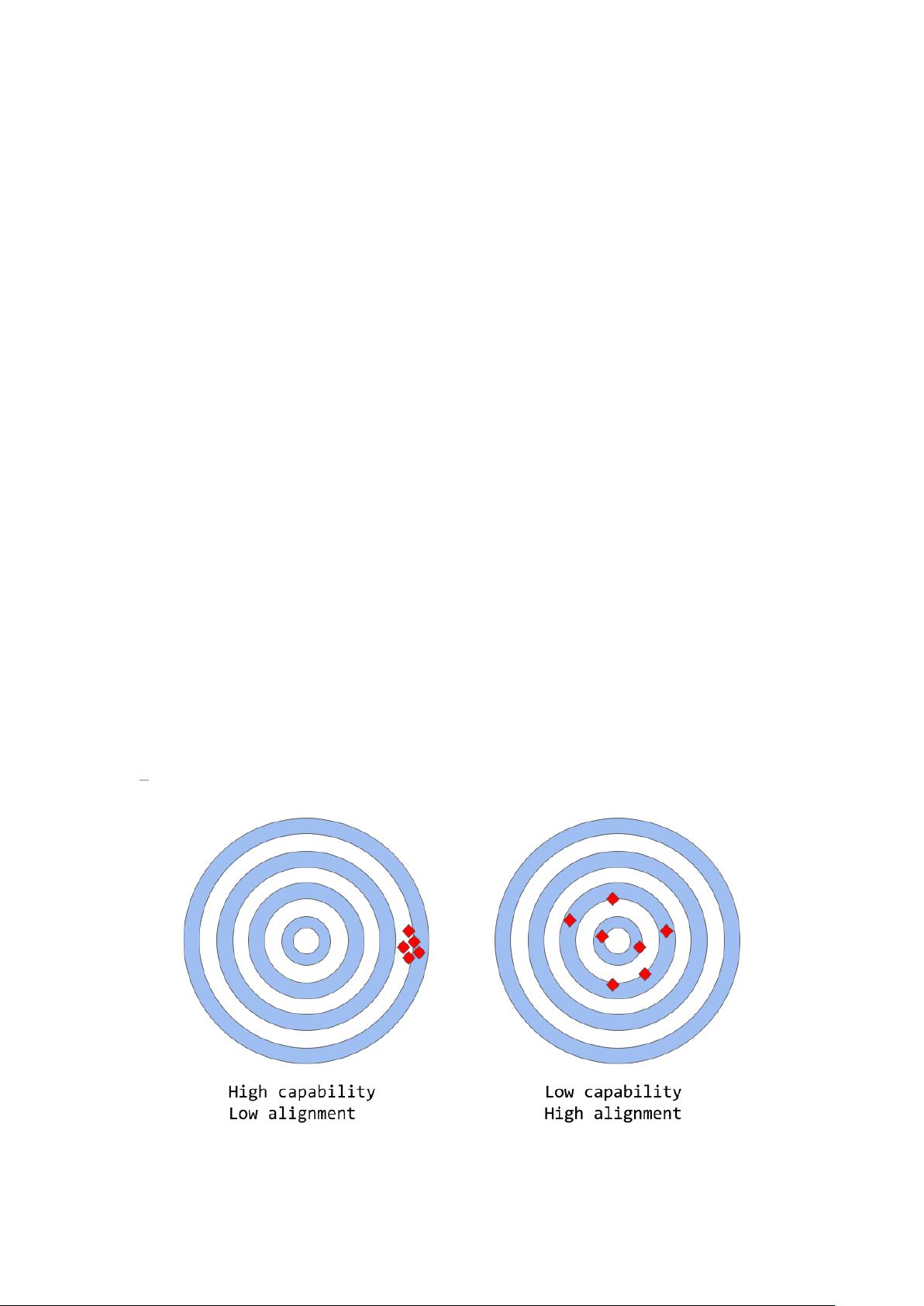

ChatGPT是一个由OpenAI开发的先进语言模型,它的出现引起了公众极大的兴趣。ChatGPT是基于GPT-3的改进版本,具有更高的精确度、细节性和连贯性,尤其在交互式对话方面表现出色。它的工作原理主要依赖于两个关键的机器学习技术:监督学习和强化学习。 在传统的监督学习中,模型通过大量标记的数据进行训练,以学习输入与输出之间的关系。然而,ChatGPT的训练过程包含了一种名为人类反馈强化学习(RLHF)的独特技术。这一方法利用人类的反馈来调整模型的行为,使其输出更加符合人类的价值观和期望。在RLHF过程中,首先使用监督学习预训练模型,然后通过一系列迭代,模型的输出会被人类评审员评估,评审员的反馈被用来调整模型的权重,以减少有害、不真实或有偏见的回答。 GPT-3等大型语言模型的局限性在于它们的训练目标与实际期望的输出可能存在偏差,即“对齐”问题。模型的能力(accuracy)是指模型执行特定任务的效率,而对齐(alignment)则关注模型的行为是否符合人类的意图。例如,GPT-3的目标是预测文本序列中的下一个单词,而非确保生成的文本准确、连贯且无偏见。这导致了模型可能产生误导性的回答、幻觉(创造不存在的事实)、难以解释的决策以及潜在的有偏见输出。 语言模型的训练策略,如下一词预测和掩码语言建模,虽然有助于学习语言的统计结构,但也可能导致对齐问题。在这些方法中,模型仅需考虑上下文来预测下一个单词,而忽视了语境的深层含义和人类的推理能力。为了改善这一点,ChatGPT通过强化学习,特别是RLHF,让模型在实际交互中不断学习并优化其响应,以更接近人类的期望。 然而,即使采用了RLHF,ChatGPT仍然存在局限性。例如,由于模型的复杂性,理解和解释其决策过程可能很困难,而且模型可能会在某些情况下未能完全消除有害或有偏见的输出。此外,训练过程中需要大量的人力反馈,这既昂贵又耗时,限制了模型的快速更新和改进。 ChatGPT的工作原理是通过深度学习和强化学习的结合,努力在生成自然语言的同时保持与人类意图的一致性。它在对话理解和交互方面的进步是人工智能领域的一大突破,但同时也暴露出对齐问题这一挑战,这是未来研究和发展的重点。随着技术的不断发展,我们期待看到更加智能、安全且与人类价值观一致的对话系统出现。

剩余11页未读,继续阅读

- 粉丝: 1w+

- 资源: 491

我的内容管理

展开

我的内容管理

展开

我的资源

快来上传第一个资源

我的资源

快来上传第一个资源

我的收益 登录查看自己的收益

我的收益 登录查看自己的收益 我的积分

登录查看自己的积分

我的积分

登录查看自己的积分

我的C币

登录后查看C币余额

我的C币

登录后查看C币余额

我的收藏

我的收藏  我的下载

我的下载  下载帮助

下载帮助

前往需求广场,查看用户热搜

前往需求广场,查看用户热搜最新资源

- 基于java的教学资料管理系统的设计和实现.docx

- 基于java的老年人体检管理系统的设计和实现.docx

- 基于java的旅游推荐系统的设计和实现.docx

- 基于java的旅游网站的设计和实现.docx

- 基于java的美妆购物网站的设计和实现.docx

- 基于java的绿城郑州爱心公益网站的设计和实现.docx

- 基于java的民宿管理系统的设计和实现.docx

- 基于java的民族婚纱预定系统的设计和实现.docx

- 基于java的民谣网站的设计和实现.docx

- 基于java的企业信息管理系统的设计和实现.docx

- 基于java的企业OA管理系统的设计和实现.docx

- 基于java的农产品直卖平台的设计和实现.docx

- 基于java的汽车维修预约服务系统的设计和实现.docx

- 基于java的汽车租赁系统的设计和实现.docx

- 基于java的汽车销售系统的设计和实现.docx

- 基于java的社区医疗综合服务平台的设计和实现.docx

信息提交成功

信息提交成功