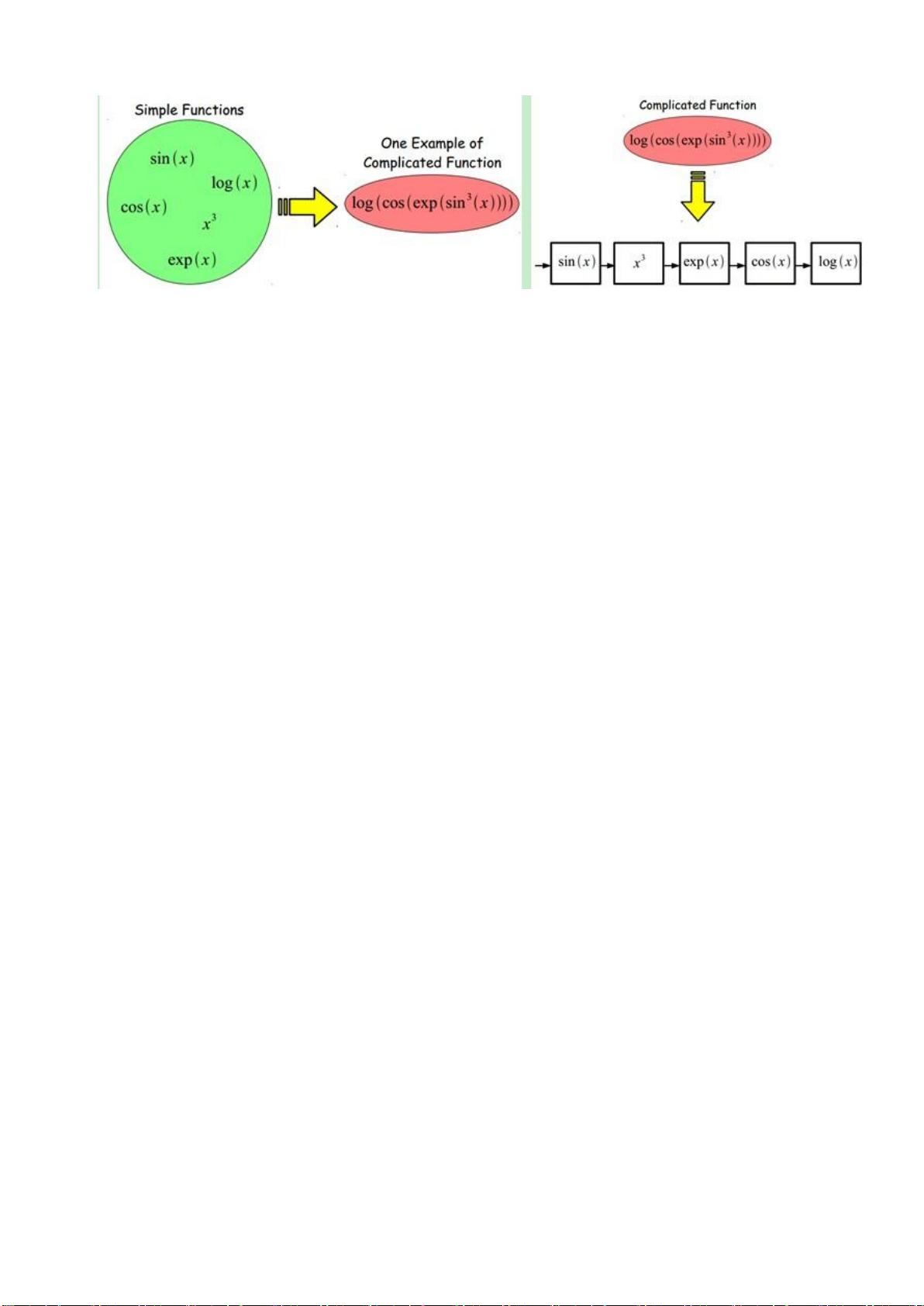

深度学习入门书籍零基础深度学习 一、深度学习简介 深度学习是一种机器学习方法,旨在自动学习特征,解决实际问题。手工选取特征是一件非常费力、启发式的方法,深度学习可以自动地学习一些特征。深度学习的思想是堆叠多个层,每一层的输出作为下一层的输入,通过这种方式,可以实现对输入信息进行分级表达。 二、深度学习的基本思想 深度学习的基本思想是假设我们有一个系统 S,它有 n 层,每一层的输出作为下一层的输入。通过调整系统中参数,使得它的输出仍然是输入 I,那么我们就可以自动地获取得到输入 I 的一系列层次特征。 三、浅层学习(Shallow Learning)和深度学习(Deep Learning) 浅层学习是机器学习的第一次浪潮,利用 BP 算法可以让一个人工神经网络模型从大量训练样本中学习统计规律,从而对未知事件做预测。深度学习是堆叠多个层,每一层的输出作为下一层的输入,可以实现对输入信息进行分级表达。 四、卷积神经网络(CNN) 卷积神经网络(Convolutional Neural Networks,CNN)是一种深度学习算法,主要用于图像识别、自然语言处理等领域。CNN 由多个卷积层和池化层组成,每个卷积层都可以学习到图像的某些特征,然后通过池化层减少维度,最后通过全连接层输出结果。 五、卷积神经网络的反向求导 卷积神经网络的反向求导是指在训练过程中,计算损失函数对模型参数的梯度,用于更新模型参数。反向求导可以通过链式法则实现,链式法则是指将损失函数对模型参数的梯度计算拆分成多个小部分,每个小部分对应一个模型参数,然后将所有小部分组合起来获得最终的梯度。 六、CNN 卷积神经网络(一)深度解析 CNN CNN 卷积神经网络可以分为多个层,每个层都可以学习到图像的某些特征。卷积层可以学习到图像的边缘、 texture 等特征,池化层可以减少维度,最后通过全连接层输出结果。 七、CNN 卷积神经网络(二)文字识别系统 LeNet-5 LeNet-5 是一个经典的文字识别系统,使用 CNN 来识别手写数字。LeNet-5 由多个卷积层和池化层组成,每个卷积层都可以学习到图像的某些特征,然后通过池化层减少维度,最后通过全连接层输出结果。 八、CNN 卷积神经网络(三)CNN 常见问题总结 CNN 卷积神经网络常见的问题包括过拟合、欠拟合、梯度消失等。过拟合是指模型对训练数据过于拟合,导致模型无法泛化到新的数据。欠拟合是指模型对训练数据的拟合不够,导致模型无法学习到有用的特征。梯度消失是指在反向传播过程中,梯度变得越来越小,导致模型无法更新参数。 九、深度学习讨论班 苏州大学强化学习讨论班是一个深度学习讨论平台,旨在分享深度学习的知识和经验。讨论班涵盖了深度学习的各个方面,包括深度学习的基本思想、卷积神经网络、反向求导等。

剩余72页未读,继续阅读

- 粉丝: 8

- 资源: 380

我的内容管理

展开

我的内容管理

展开

我的资源

快来上传第一个资源

我的资源

快来上传第一个资源

我的收益 登录查看自己的收益

我的收益 登录查看自己的收益 我的积分

登录查看自己的积分

我的积分

登录查看自己的积分

我的C币

登录后查看C币余额

我的C币

登录后查看C币余额

我的收藏

我的收藏  我的下载

我的下载  下载帮助

下载帮助

前往需求广场,查看用户热搜

前往需求广场,查看用户热搜最新资源

- 面向初学者的 Java 教程(包含 500 个代码示例).zip

- 阿里云OSS Java版SDK.zip

- 阿里云api网关请求签名示例(java实现).zip

- 通过示例学习 Android 的 RxJava.zip

- 通过多线程编程在 Java 中发现并发模式和特性 线程、锁、原子等等 .zip

- 通过在终端中进行探索来学习 JavaScript .zip

- 通过不仅针对初学者而且针对 JavaScript 爱好者(无论他们的专业水平如何)设计的编码挑战,自然而自信地拥抱 JavaScript .zip

- 适用于 Kotlin 和 Java 的现代 JSON 库 .zip

- AppPay-安卓开发资源

- yolo5实战-yolo资源

信息提交成功

信息提交成功