上交大最优化方法笔记 (18讲) (极简)

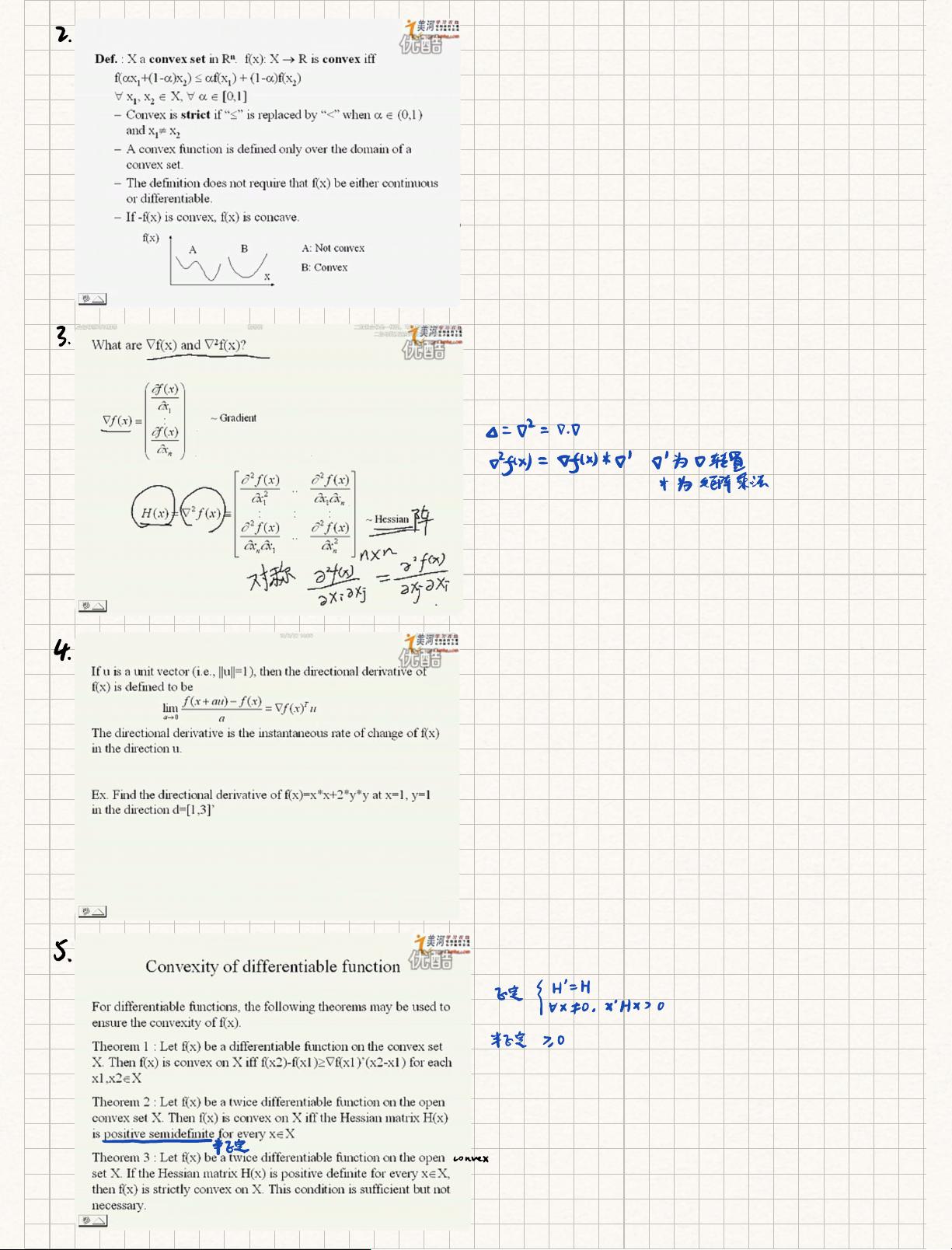

最优化方法是数学、机器学习等领域中的核心概念,用于寻找函数的最小值或最大值。在本课程“上交大最优化方法笔记”中,主要讲解了优化问题的基本理论和实用技术。以下是笔记的关键知识点: 1. **最优性条件**:对于一个点成为局部最小点,需要满足一阶和二阶必要条件。一阶必要条件指出,如果某点是局部最小点,则该点处的梯度为零,即函数的一阶导数为零。二阶必要条件涉及到Hessian矩阵(函数的二阶导数矩阵),若该点是局部最小点,Hessian矩阵在该点必须是对称的,并且是半正定的。 2. **二次可微性**:在讨论最优化问题时,通常假设目标函数是两次连续可微的,这意味着在某个区域内,函数的梯度和Hessian矩阵都存在且连续。这是确保二阶条件成立的基础。 3. **局部最小点和全局最小点**:局部最小点是函数在其邻域内取得的最小值,但不一定是全局最小点。全局最小点是函数在整个定义域内取得的最小值。如果函数在开凸集上是凸的,并且Hessian矩阵在所有点非奇异且为正定,那么该点是全局最小点。 4. **奇异点**:奇异点是二阶导数矩阵(Hessian矩阵)奇异的点,即其行列式为零,这表明二阶条件无法应用。奇异点可能是局部最小点,但不是全局最小点,处理起来较为复杂。 5. **存在性定理**:在某些条件下,最优化问题的解总是存在的。例如,如果函数在闭集上是下界的,并且是强制性的(随着距离无限远,函数值趋于无穷大),那么至少存在一个全局最小点。此外,如果函数在开凸集上是连续可微的,并且Hessian矩阵非负定,那么存在局部最小点。 6. **一维搜索技术**:这些技术用于在单变量函数中寻找最小值。包括迭代下降法,它从初始点开始,通过评估函数值选择下降方向找到下一个点,直到无法进一步下降为止。还有等分搜索、二分搜索和斐波那契搜索等,它们通过不断缩小搜索区间来逼近最小值。 7. **等分搜索**:等分搜索将区间分为相等的部分,每次迭代都将区间减半,直到找到最小值。这种技术简单但效率较低。 8. **斐波那契搜索**:斐波那契搜索利用斐波那契数列来确定搜索区间的划分,它比等分搜索更快地收敛到最小值,减少了迭代次数。 9. **无梯度计算的算法**:有些优化方法不需要计算梯度,如固定步长的迭代下降法。这类方法通常在计算资源有限或者梯度难以获取的情况下使用。它们可能需要存储有限的样本点,通过比较损失函数来调整搜索方向。 10. **最优化算法的选择**:根据问题的具体特性,如函数的光滑性、约束条件以及计算资源,可以选择不同的最优化算法。在实际应用中,通常需要权衡计算复杂度、收敛速度和稳定性。 总结来说,最优化方法是一门涉及广泛理论和实践的学科,涵盖了从基础的优化条件到复杂的搜索策略。理解和掌握这些知识对于解决数学、工程和机器学习中的优化问题至关重要。通过学习“上交大最优化方法笔记”,我们可以系统地了解和应用这些理论,以更有效地求解实际问题。

剩余10页未读,继续阅读

- 粉丝: 28

- 资源: 12

我的内容管理

展开

我的内容管理

展开

我的资源

快来上传第一个资源

我的资源

快来上传第一个资源

我的收益 登录查看自己的收益

我的收益 登录查看自己的收益 我的积分

登录查看自己的积分

我的积分

登录查看自己的积分

我的C币

登录后查看C币余额

我的C币

登录后查看C币余额

我的收藏

我的收藏  我的下载

我的下载  下载帮助

下载帮助

前往需求广场,查看用户热搜

前往需求广场,查看用户热搜最新资源

信息提交成功

信息提交成功