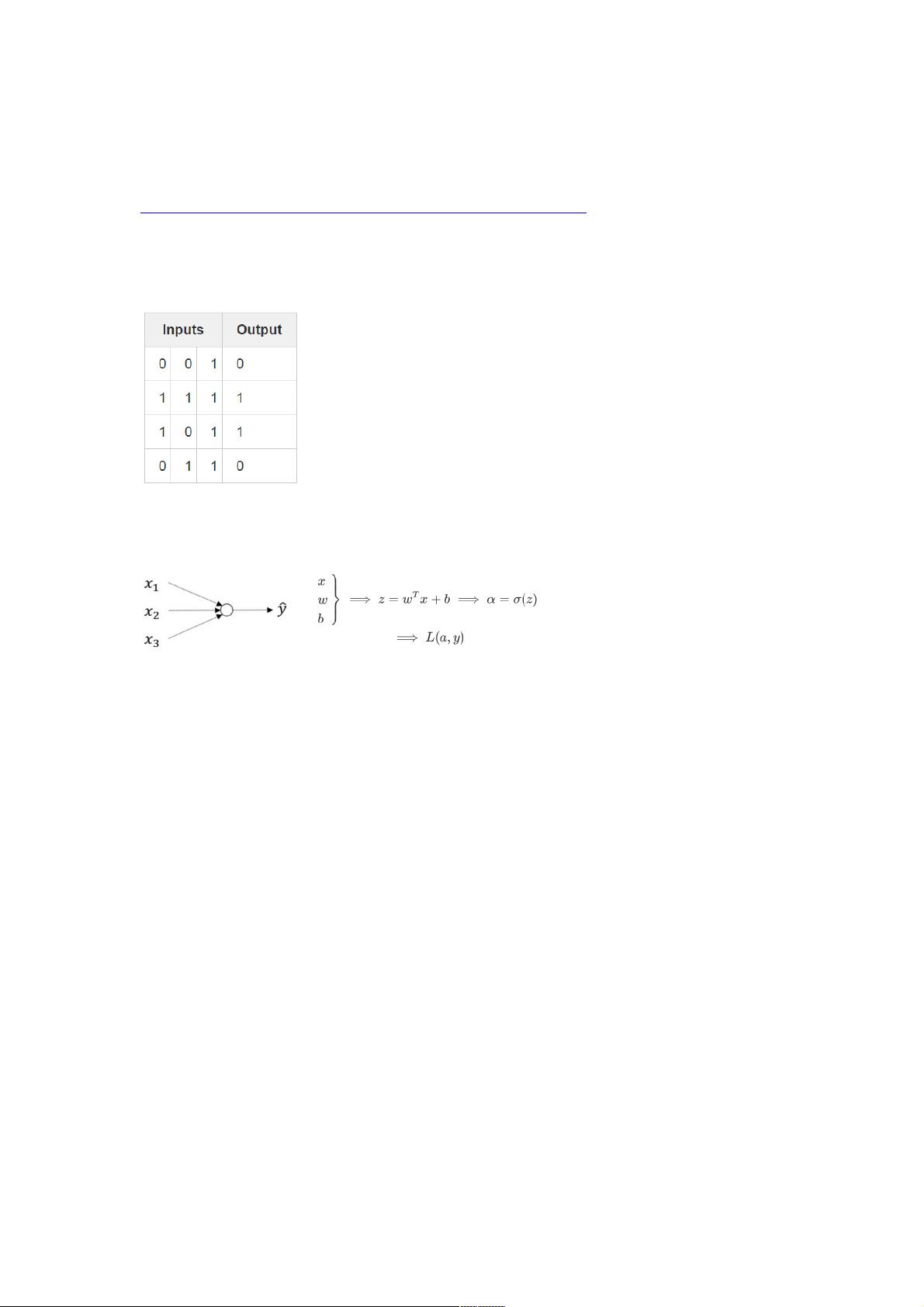

根据给定文件信息,本篇文章将详细介绍如何仅用11行Python代码构建一个简单的神经网络,并且在文档中通过实例讲解了单层和双层神经网络的基本原理。为帮助初学者更好地理解反向传播算法和梯度下降法,文档还详细推导了相关的数学公式。 文章介绍了单层神经网络的构建过程,具体包含以下几个要点: 1. 导入numpy库并定义非线性激活函数。激活函数选择的是Sigmoid函数,因为它的数学表达简单,并且易于梯度计算。文档中的非线性函数为: def nonlin(x, deriv=False): if deriv: return x*(1-x) return 1/(1+np.exp(-x)) 2. 初始化输入数据集X和输出数据集y。在此基础上,使用随机数初始化权重,并通过设定随机种子以保证每次运行代码时的初始化值相同。 X=np.array([[0,0,1],[0,1,1],[1,0,1],[1,1,1]]) y=np.array([[0],[1],[1],[0]]) np.random.seed(1) syn0=2*np.random.random((3,1))-1 3. 通过前向传播(forward propagation)计算网络输出,并通过代价函数计算输出值和实际值之间的误差。代价函数采用的是均方误差(MSE)。 l0=X l1=nonlin(np.dot(l0,syn0)) l1_error=y-l1 4. 通过反向传播(backpropagation)计算误差关于权重的梯度,并更新权重。这里使用了梯度下降法进行权重更新,学习率(learning rate)设置为1。 syn0+=np.dot(l0.T,l1_delta) 对于双层神经网络,其构建过程和单层神经网络类似,只不过增加了一个隐藏层。这使得模型拥有更强的表达能力。主要变化点包括: 1. 初始化两个权重矩阵,分别对应输入层到隐藏层和隐藏层到输出层的权重。 syn0=2*np.random.random((3,4))-1 syn1=2*np.random.random((4,1))-1 2. 通过前向传播计算出最终的输出值l2,并计算误差。然后进行反向传播,求出两个隐藏层相对于输出层的误差(l2_error)和输入层相对于隐藏层的误差(l1_error)。 l2=nonlin(np.dot(l1,syn1)) l2_error=y-l2 l1_error=l2_delta.dot(syn1.T) 3. 更新权重。对于每个隐藏层,都使用梯度下降法来更新权重。更新规则与单层神经网络相同。 syn1+=l1.T.dot(l2_delta) syn0+=l0.T.dot(l1_delta) 文章中的详细公式推导有助于理解在单层神经网络和双层神经网络中权重更新的具体过程。文档通过逐步演示如何使用Python实现这一算法,并解释了相应的数学原理,使得初学者能够清晰地看到从数据输入到最终权重更新的整个过程。 总结来看,本篇文章通过具体的代码实例和公式推导,详细介绍了神经网络的基本结构、前向传播、误差计算、反向传播和权重更新等关键概念。这对于学习神经网络的基础知识和理解其工作原理具有重要的意义。通过本文的学习,初学者不仅能掌握简单的Python实现神经网络的方法,还能深入了解反向传播算法的数学原理,为进一步学习深度学习打下坚实的基础。

剩余7页未读,继续阅读

- 粉丝: 0

- 资源: 7

我的内容管理

展开

我的内容管理

展开

我的资源

快来上传第一个资源

我的资源

快来上传第一个资源

我的收益 登录查看自己的收益

我的收益 登录查看自己的收益 我的积分

登录查看自己的积分

我的积分

登录查看自己的积分

我的C币

登录后查看C币余额

我的C币

登录后查看C币余额

我的收藏

我的收藏  我的下载

我的下载  下载帮助

下载帮助

前往需求广场,查看用户热搜

前往需求广场,查看用户热搜最新资源

信息提交成功

信息提交成功