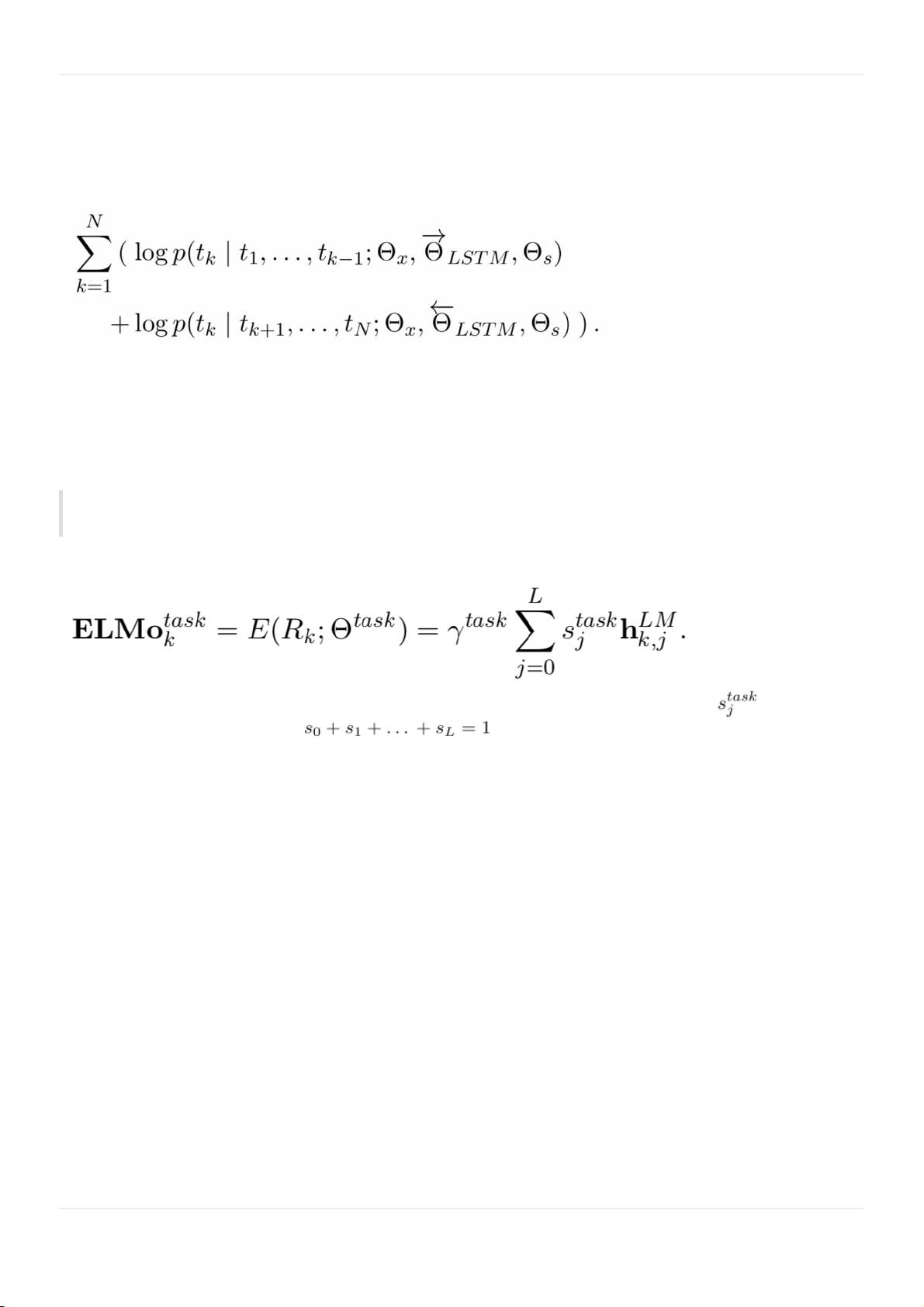

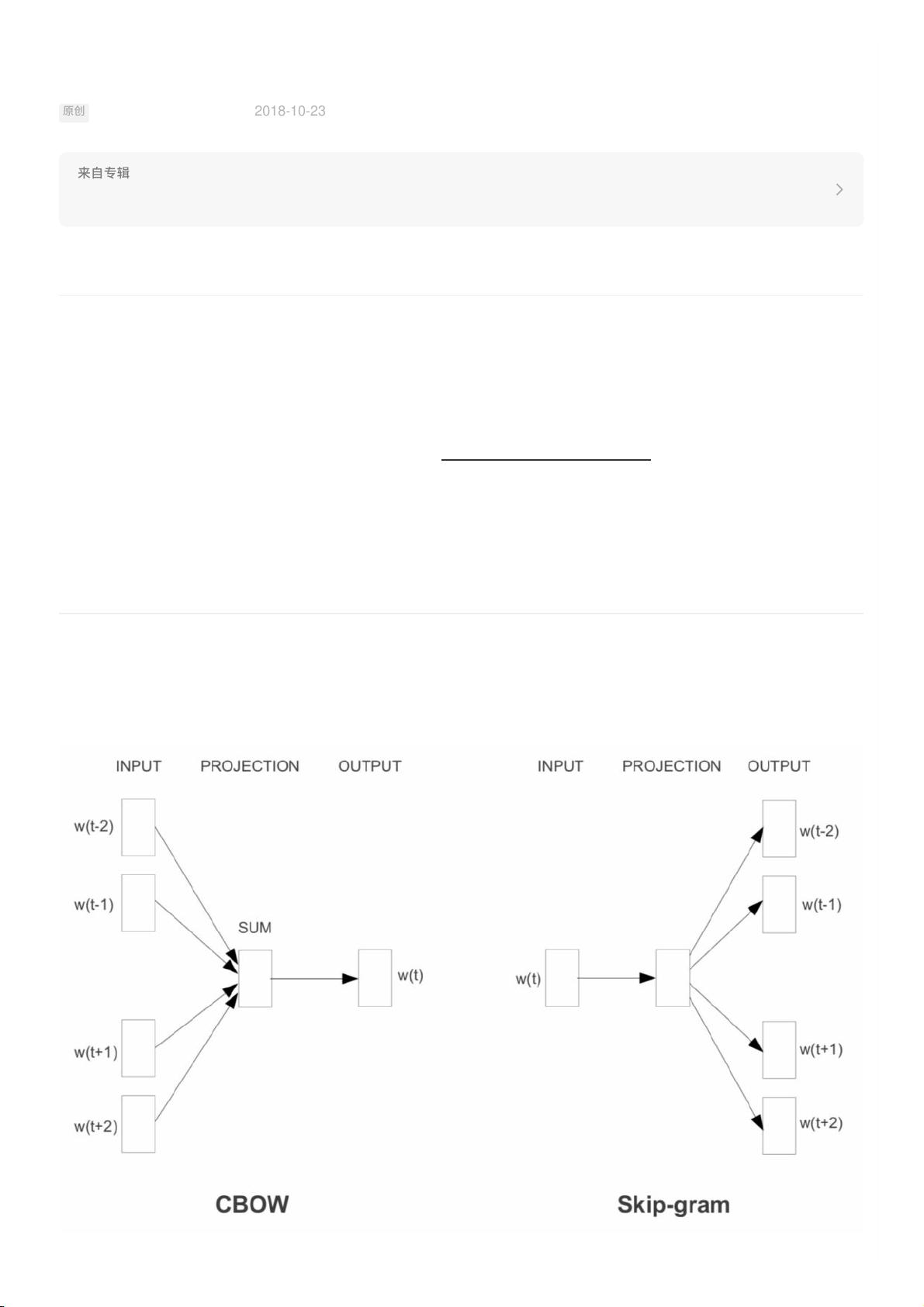

自然语言处理(NLP)是计算机科学领域的一个关键分支,其目标是使计算机能够理解和生成人类语言。在过去的几年里,NLP领域的进展显著,尤其是从word2vec、ELMo到BERT的演变,极大地推动了这个领域的发展。这些模型不仅改变了我们处理文本的方式,也重新定义了NLP游戏的规则。 word2vec是一种用于学习词向量的算法,由Google的研究人员在2013年提出。它有两种主要的实现方式:CBOW(Continuous Bag of Words)和Skip-gram。word2vec的核心思想是通过上下文来理解词汇的含义,即“词的含义由其上下文决定”。通过训练神经网络,word2vec能够将每个单词映射到一个高维空间中的向量,使得语义相似的词在该空间中的距离相近。例如,“国王”和“王后”的向量可能比“国王”和“建筑”的向量更接近。这种方法极大地改善了NLP任务的性能,如词性标注、命名实体识别和机器翻译。 然而,word2vec仅考虑了单个词的上下文,忽略了词语在句子中的顺序和深度语义信息。为解决这个问题,2018年,ELMo(Embeddings from Language Models)应运而生。ELMo是由Allen AI研究所开发的预训练语言模型,它引入了双向 LSTM(Long Short-Term Memory)网络。与word2vec不同,ELMo不是为每个词提供一个固定向量,而是根据词在句子中的位置和上下文动态生成向量,从而捕捉到了词的多义性和依赖于上下文的含义。这使得ELMo在许多NLP任务上取得了比word2vec更好的效果,尤其是在句法和语义分析方面。 BERT(Bidirectional Encoder Representations from Transformers)由Google在2018年发布,它标志着预训练语言模型的新里程碑。BERT基于Transformer架构,这是一种自注意力机制,允许模型同时考虑整个输入序列,而不仅仅是相邻的词。BERT通过两个预训练任务——掩码语言模型(Masked Language Modeling)和下一句预测(Next Sentence Prediction)进行训练,使其能够在理解语言的双向上下文中进行深度学习。这种全面的上下文理解使得BERT在多项NLP基准测试中刷新了记录,包括问答、情感分析和文本分类等任务。 总结来说,word2vec开启了将词语表示为向量的先河,ELMo则通过考虑词序和上下文改进了这一概念,而BERT通过Transformer架构和双向上下文学习进一步提升了NLP模型的性能。这三个模型的连续进步表明,NLP领域正不断向着更准确、更深入理解人类语言的方向发展,同时也为我们提供了更强大的工具来处理和分析文本数据。未来,我们可以期待更多创新技术的出现,继续推动NLP的边界。

NLP的游戏规则从此改写?从word2vec,-ELMo到BERT.rar (1个子文件)

NLP的游戏规则从此改写?从word2vec,-ELMo到BERT.rar (1个子文件)  NLP的游戏规则从此改写?从word2vec,-ELMo到BERT.pdf 1.04MB

NLP的游戏规则从此改写?从word2vec,-ELMo到BERT.pdf 1.04MB- 1

- 粉丝: 2w+

- 资源: 635

我的内容管理

展开

我的内容管理

展开

我的资源

快来上传第一个资源

我的资源

快来上传第一个资源

我的收益 登录查看自己的收益

我的收益 登录查看自己的收益 我的积分

登录查看自己的积分

我的积分

登录查看自己的积分

我的C币

登录后查看C币余额

我的C币

登录后查看C币余额

我的收藏

我的收藏  我的下载

我的下载  下载帮助

下载帮助

前往需求广场,查看用户热搜

前往需求广场,查看用户热搜最新资源

信息提交成功

信息提交成功