bert_jdevlin_PPT.pdf

2.虚拟产品一经售出概不退款(资源遇到问题,请及时私信上传者)

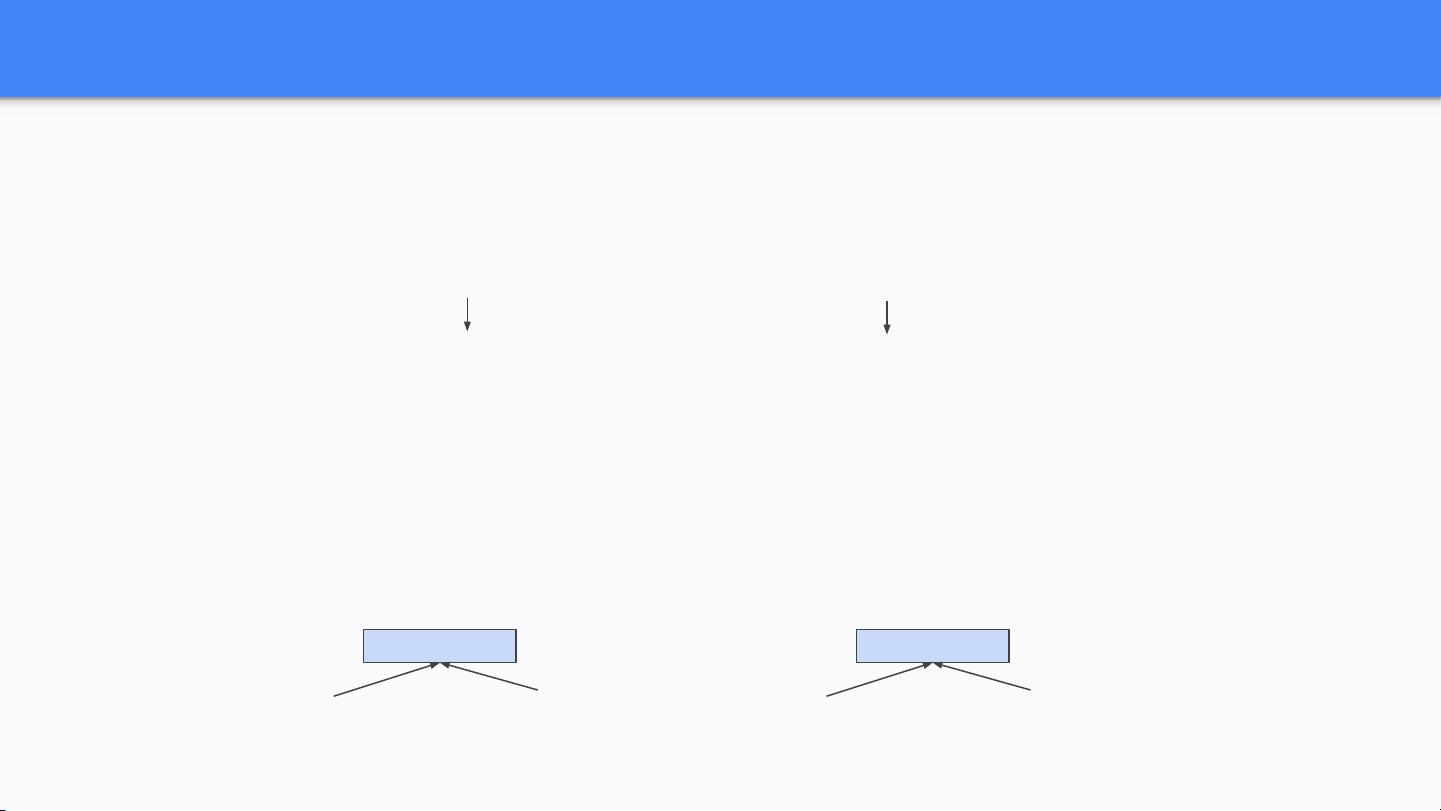

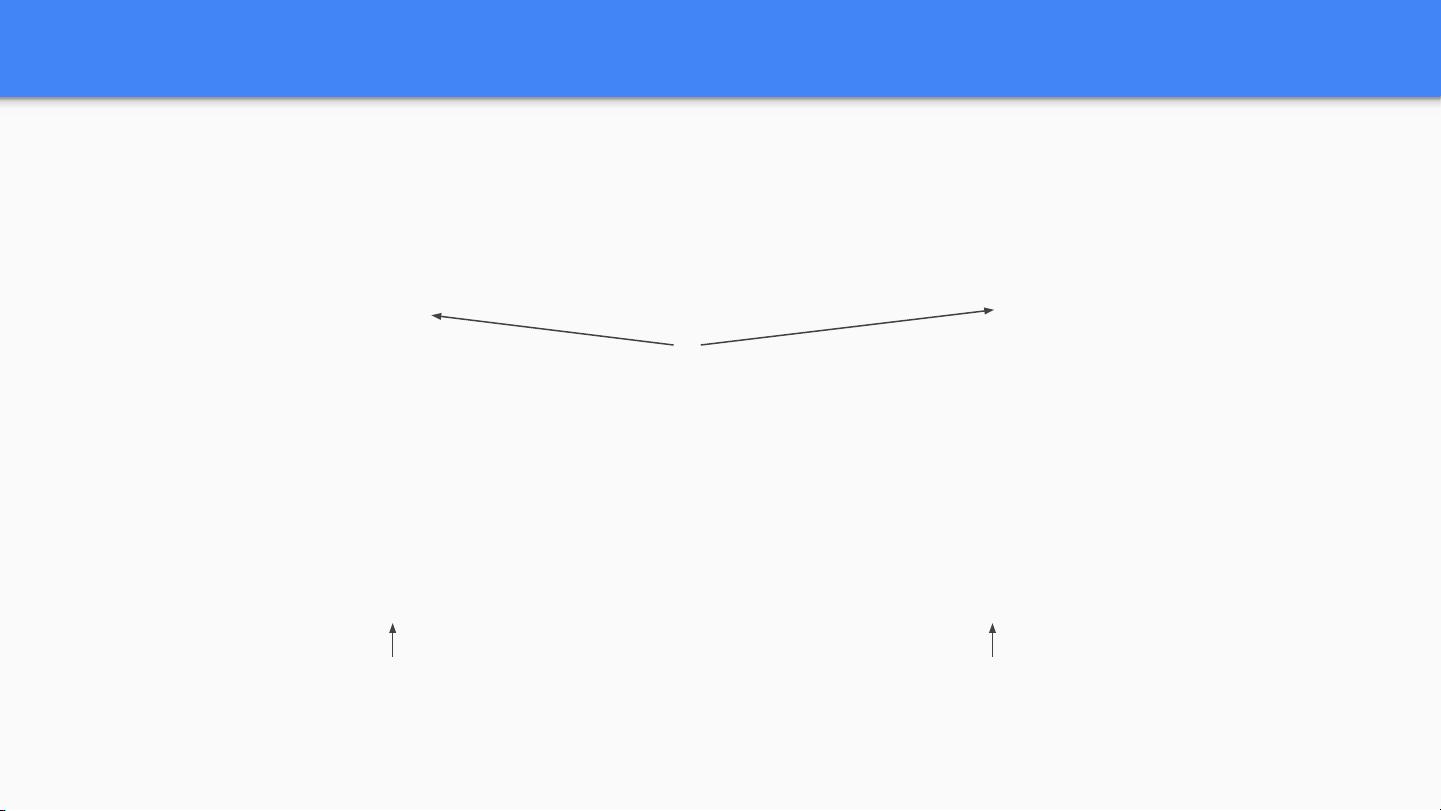

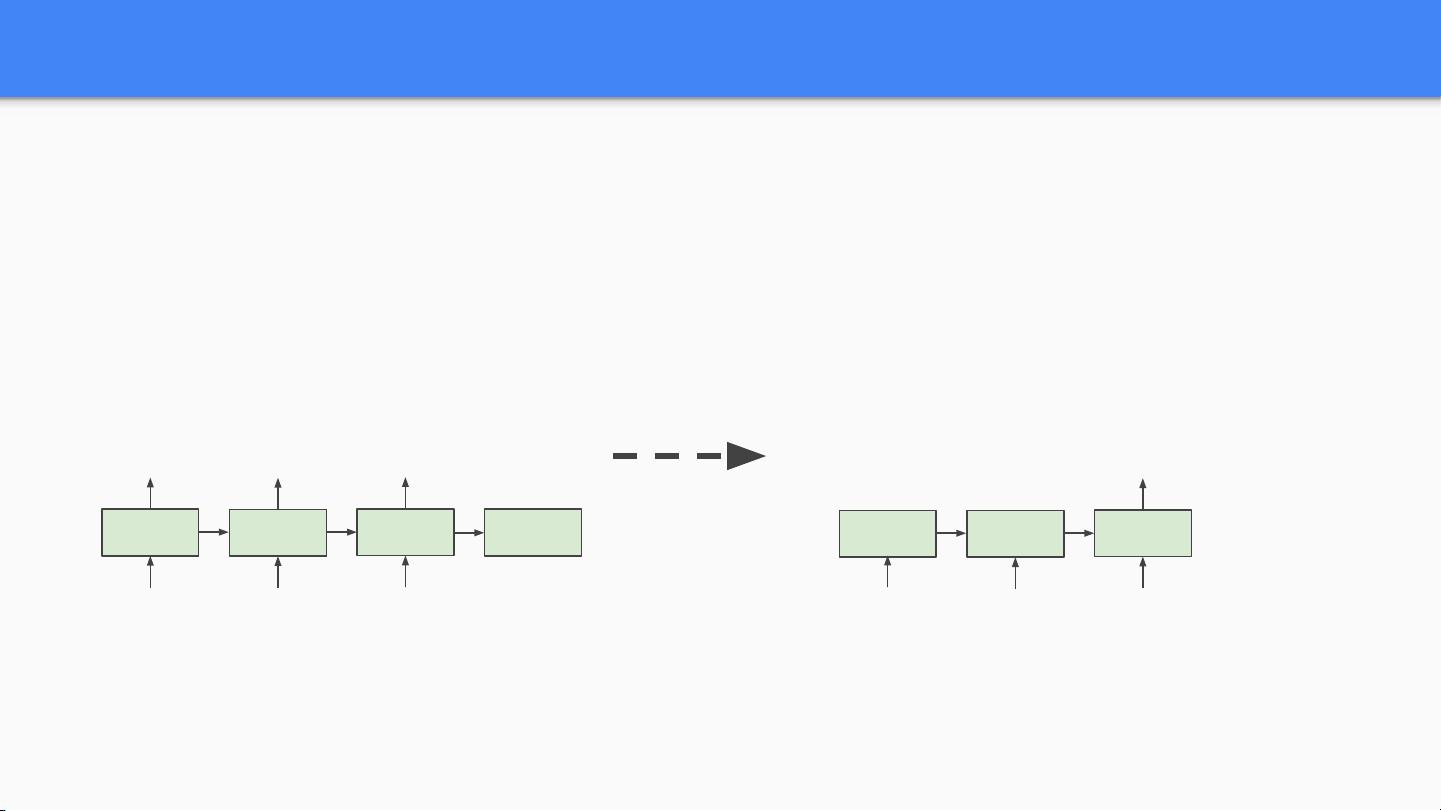

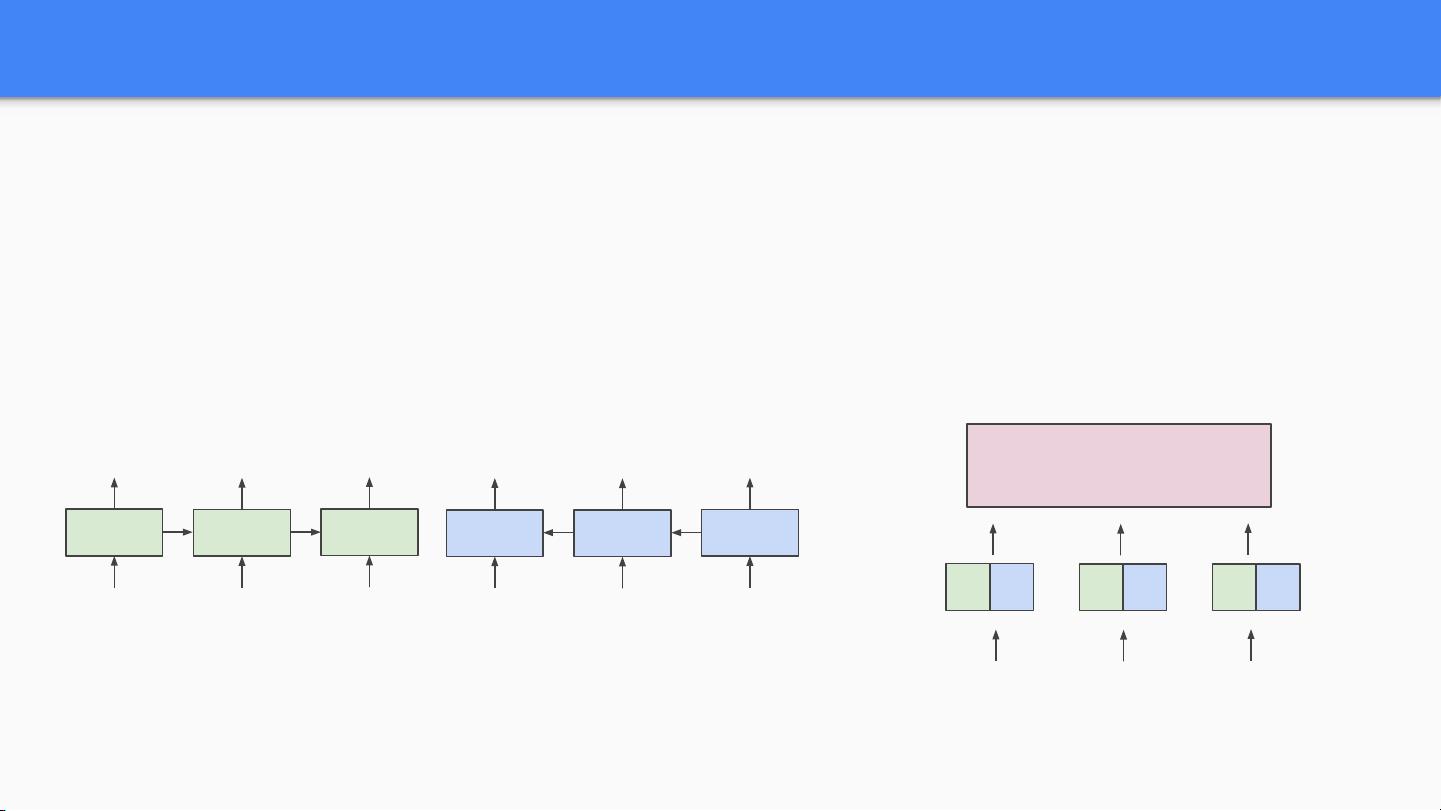

BERT(Bidirectional Encoder Representations from Transformers)是一种由Jacob Devlin及其在Google AI的研究团队提出的预训练语言表示模型,目的是在自然语言处理(NLP)领域进行深度双向的表示学习。它基于Transformer模型,利用注意力机制对文本进行编码,实现了对单词含义的深层理解,并在众多NLP任务中取得了突破性的成果。 在BERT出现之前,NLP领域广泛使用的是词嵌入(word embeddings),比如word2vec和GloVe等,它们通过在大规模文本语料库上根据单词共现统计信息进行预训练,得到静态的、上下文无关的向量表示。但是,这种方法的局限在于不能捕捉到单词在不同语境中的多义性和上下文依赖性,比如“bank”在“river bank”和“open a bank account”中意义不同。 为了解决这个问题,研究者们开发了上下文相关的词表示,比如ELMo模型,它通过分别训练从左到右和从右到左的两种语言模型,并将它们的输出结合起来作为预训练的词嵌入。OpenAI的GPT(Generative Pre-training)模型则进一步通过深层Transformer语言模型实现了从左到右的上下文建模。 然而,即使GPT等模型已经取得了巨大成功,它们仍然存在一个根本的限制,即它们是单向的,只利用了左侧或右侧的上下文信息。而BERT提出了一个革命性的解决方案:通过使用一个双向的Transformer作为基础结构,BERT能够同时考虑左侧和右侧的上下文来学习单词的表示。 BERT的预训练过程主要包含两个步骤:Masked Language Model(MLM)和Next Sentence Prediction(NSP)。MLM随机遮蔽部分输入单词,并要求模型预测这些被遮蔽的单词。NSP则是预测两个句子是否在原始文本中相互邻接。通过这样的预训练,BERT能够学习到深层次的语言理解能力。 BERT的一个关键优势是它能够通过简单的微调(fine-tuning)适配到各种各样的NLP下游任务,例如文本分类、命名实体识别、问答系统等。这意味着BERT能够利用在大规模数据上预训练得到的丰富知识,并针对特定任务进行微调,以获得最优的表现。 为了进一步提升模型性能,BERT引入了新的技术,如“注意力掩码”(Attention Mask),使得模型能在单个序列上学习到更复杂的表示。此外,BERT还设计了特殊的输入表示,将每个句子转换为一系列的向量,并添加了一个特殊的标记[CLS]作为序列开始的表示。 自从BERT问世以来,它成为了自然语言处理研究的基石,并催生了一大批新的预训练语言模型,如RoBERTa、ALBERT、DistilBERT等。这些模型在不同的方面对BERT进行了改进,比如训练速度的加快、模型大小的减小、性能的进一步提高等,它们共同推动了NLP技术的飞速发展。 BERT的诞生和成功,深刻反映了深度学习在自然语言处理领域的重要作用,并且极大地推动了基于Transformer的模型在各个NLP任务上的应用。这一成就的取得,与Jacob Devlin等研究人员的努力密不可分,他们的工作为后续研究者提供了强大的工具和灵感,使得语言模型的研究进入了一个全新的时代。

剩余34页未读,继续阅读

sinat_418077172021-10-25用户下载后在一定时间内未进行评价,系统默认好评。

sinat_418077172021-10-25用户下载后在一定时间内未进行评价,系统默认好评。

- 粉丝: 8

- 资源: 2

我的内容管理

展开

我的内容管理

展开

我的资源

快来上传第一个资源

我的资源

快来上传第一个资源

我的收益 登录查看自己的收益

我的收益 登录查看自己的收益 我的积分

登录查看自己的积分

我的积分

登录查看自己的积分

我的C币

登录后查看C币余额

我的C币

登录后查看C币余额

我的收藏

我的收藏  我的下载

我的下载  下载帮助

下载帮助

前往需求广场,查看用户热搜

前往需求广场,查看用户热搜最新资源

- 新版在线生成一合三网站缩微图工具PHP源码

- 基于vscode的c++图书管理系统

- 一体式湿式砂轮抛光机sw16可编辑全套技术资料100%好用.zip

- C语言进制转换啦啦啦啦啦啦啦啦啦啦啦啦

- rk3568,356x开发资料 硬件包括Demo原理图 pcb 有sdk等全套开发资料 allegro版,pads版 34G资料 包含sdk,原理图,pcb,直接就能使用

- 基于Python的虚假新闻检测多模态识别源代码+文档说明

- vl53l0x激光测距传感器驱动

- 在线Base64加解密HTML源码

- 海克斯康三坐标脱机编程测量软件 数模 2012-2019版本pc-dmis 如需要2020-2022版本 拿两份 联系卖家改价

- Postman-win64-9.3.1 老版本,可以不强制登录使用New Collection

- C语言 递归计算前20位数据啦啦啦啦啦啦啦

- 一模两穴自动化玻璃厚度平面度检测机pro5.0全套技术资料100%好用.zip

- 基于Vue和Gin的全栈开发平台,快速上手、功能丰富

- 圣诞树代码html飘雪花

- 骰子、硬币、网球检测13-YOLO(v5至v11)、COCO、CreateML、Paligemma、TFRecord、VOC数据集合集.rar

- Proteus仿真自动门控制系统

信息提交成功

信息提交成功