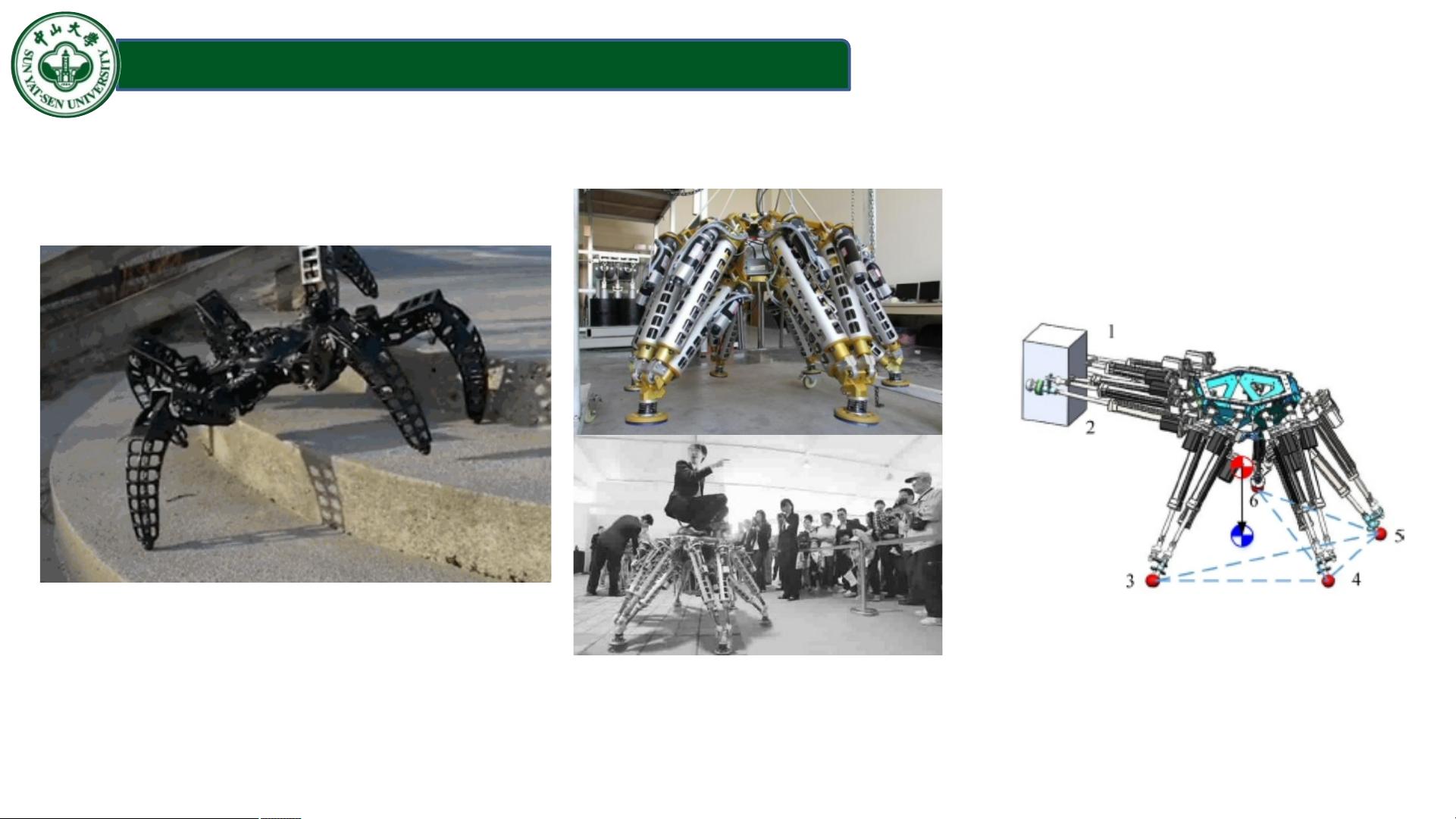

: "基于Q学习实现了六足机器人在不同地形下的路径规划和步态规划" 在人工智能领域,路径规划和步态规划是机器人自主行动的关键技术。本项目着重于运用Q学习这一强化学习算法,来解决六足机器人在复杂地形中的行走问题。Q学习是一种模型自由的强化学习方法,它通过与环境的交互来学习最优策略,适用于解决离散状态空间和动作空间的问题。 【Q学习】 Q学习是强化学习中的一种表格式学习方法,由Richard Sutton在1988年提出。其核心思想是通过更新Q表来逐步逼近一个理想的Q值,即最大化未来奖励的期望。Q表记录了在每个状态下执行每个动作的预期回报,随着时间的推移,通过经验学习不断优化这个表,最终找到从初始状态到目标状态的最优路径。 【六足机器人】 六足机器人,又称六腿机器人或蜘蛛机器人,由于其稳定性高、适应性强,常被用于科研和实际应用中。这类机器人的步态规划和路径规划是控制其在不同环境安全、高效移动的关键。步态规划是指确定机器人各关节在时间上的运动规律,以实现稳定行走;路径规划则是寻找从起点到终点的最优路径,避开障碍物。 【路径规划】 在六足机器人路径规划中,通常采用全局路径规划和局部路径规划相结合的方式。全局路径规划寻找从起点到终点的全局最优路径,考虑环境的整体结构;局部路径规划则是在机器人周围环境中进行实时调整,避免突然出现的障碍。常见的路径规划算法有A*算法、Dijkstra算法等。 【步态规划】 六足机器人的步态规划包括步态周期、步态模式和步态控制器的设计。步态周期是指机器人完成一次完整行走循环的时间,步态模式定义了每个腿在周期中的运动顺序和方式,步态控制器则根据环境反馈实时调整步态参数,确保稳定行走。 【不同地形】 六足机器人在不同地形下的行走需适应性地改变步态和路径策略。例如,在平地上,可能采用简单的交替步行步态;而在崎岖地形,可能需要复杂的步态模式以保持平衡。通过Q学习,机器人可以学习到不同地形对应的最优行走策略。 【深度学习】 尽管本项目主要使用Q学习,但深度学习也可以用于路径规划和步态规划。例如,通过构建深度Q网络(DQN),可以处理连续的动作空间,同时利用神经网络的泛化能力来适应复杂环境的变化。 本项目结合Q学习与六足机器人技术,为机器人在各种地形下的行走提供了智能解决方案,展示了人工智能在机器人领域的应用潜力。通过这样的毕业设计或课程设计,学生能够深入理解强化学习的原理,并将其应用于实际问题中,提高解决问题的能力。

基于Q学习实现了六足机器人在不同地形下的路径规划和步态规划.zip (118个子文件)

基于Q学习实现了六足机器人在不同地形下的路径规划和步态规划.zip (118个子文件)  Loss1.csv 73KB

Loss1.csv 73KB Loss.csv 24KB

Loss.csv 24KB 六足机器人趋向目标模块(不带步态)2000乘3000地图 最终展示版---图示-checkpoint.ipynb 1022KB

六足机器人趋向目标模块(不带步态)2000乘3000地图 最终展示版---图示-checkpoint.ipynb 1022KB 六足机器人趋向目标模块(不带步态)2000乘3000地图 最终展示版---图示.ipynb 1022KB

六足机器人趋向目标模块(不带步态)2000乘3000地图 最终展示版---图示.ipynb 1022KB 六足机器人趋向目标模块(角度+距离)Q表实现.ipynb 602KB

六足机器人趋向目标模块(角度+距离)Q表实现.ipynb 602KB 六足机器人趋向目标与避障模块结合 测试版.ipynb 174KB

六足机器人趋向目标与避障模块结合 测试版.ipynb 174KB 六足机器人趋向目标与避障结合(带步态)2000乘3000地图 --V2.ipynb 173KB

六足机器人趋向目标与避障结合(带步态)2000乘3000地图 --V2.ipynb 173KB 六足机器人趋向目标与避障结合(带步态)2000乘3000地图 --V2-checkpoint.ipynb 173KB

六足机器人趋向目标与避障结合(带步态)2000乘3000地图 --V2-checkpoint.ipynb 173KB 六足机器人趋向目标与避障模块结合.ipynb 173KB

六足机器人趋向目标与避障模块结合.ipynb 173KB 六足机器人趋向目标与避障模块结合-checkpoint.ipynb 173KB

六足机器人趋向目标与避障模块结合-checkpoint.ipynb 173KB 六足机器人趋向目标模块(带步态)3000乘3000地图 Q网络实现(未完成).ipynb 161KB

六足机器人趋向目标模块(带步态)3000乘3000地图 Q网络实现(未完成).ipynb 161KB 六足机器人趋向目标与避障结合 ---答辩效果图展示版.ipynb 159KB

六足机器人趋向目标与避障结合 ---答辩效果图展示版.ipynb 159KB 六足机器人趋向目标模块(带步态)2000乘3000地图 最终展示版---图示-checkpoint.ipynb 159KB

六足机器人趋向目标模块(带步态)2000乘3000地图 最终展示版---图示-checkpoint.ipynb 159KB 六足机器人趋向目标与避障结合 ---答辩效果图展示版-checkpoint.ipynb 159KB

六足机器人趋向目标与避障结合 ---答辩效果图展示版-checkpoint.ipynb 159KB 六足机器人趋向目标模块(不带步态)2000乘3000地图 --能查看训练效果-checkpoint.ipynb 151KB

六足机器人趋向目标模块(不带步态)2000乘3000地图 --能查看训练效果-checkpoint.ipynb 151KB 六足机器人趋向目标模块(带步态)2000乘3000地图 最终展示版---图示.ipynb 146KB

六足机器人趋向目标模块(带步态)2000乘3000地图 最终展示版---图示.ipynb 146KB 六足机器人趋向目标模块(角度+距离+不回退)Q表实现.ipynb 128KB

六足机器人趋向目标模块(角度+距离+不回退)Q表实现.ipynb 128KB 六足机器人趋向目标模块(不带步态)2000乘3000地图 --能查看训练效果.ipynb 110KB

六足机器人趋向目标模块(不带步态)2000乘3000地图 --能查看训练效果.ipynb 110KB Q表实现网格化(不同高度的障碍)路径规划.ipynb 99KB

Q表实现网格化(不同高度的障碍)路径规划.ipynb 99KB Q表实现网格化(不同高度的障碍)路径规划-checkpoint.ipynb 95KB

Q表实现网格化(不同高度的障碍)路径规划-checkpoint.ipynb 95KB Q神经网络训练 网格化地图六足机器人.ipynb 89KB

Q神经网络训练 网格化地图六足机器人.ipynb 89KB 六足机器人趋向目标模块(不带步态)2000乘3000地图 V_Test.ipynb 72KB

六足机器人趋向目标模块(不带步态)2000乘3000地图 V_Test.ipynb 72KB 六足机器人趋向目标模块(不带步态)2000乘3000地图 V_Test-checkpoint.ipynb 72KB

六足机器人趋向目标模块(不带步态)2000乘3000地图 V_Test-checkpoint.ipynb 72KB 六足机器人趋向目标模块(角度+距离+不回退)Q表实现-checkpoint.ipynb 70KB

六足机器人趋向目标模块(角度+距离+不回退)Q表实现-checkpoint.ipynb 70KB 六足机器人趋向目标模块(带步态)3000乘3000地图 Q网络实现2(未完成).ipynb 67KB

六足机器人趋向目标模块(带步态)3000乘3000地图 Q网络实现2(未完成).ipynb 67KB 六足机器人避障模块 Q表实现-checkpoint.ipynb 62KB

六足机器人避障模块 Q表实现-checkpoint.ipynb 62KB 六足机器人趋向目标模块Q表构建(不带步态) 最终展示版 图示 .ipynb 53KB

六足机器人趋向目标模块Q表构建(不带步态) 最终展示版 图示 .ipynb 53KB Q神经网络训练 网格化地图六足机器人-checkpoint.ipynb 52KB

Q神经网络训练 网格化地图六足机器人-checkpoint.ipynb 52KB Q_Learning 中期答辩3_3展示-checkpoint.ipynb 52KB

Q_Learning 中期答辩3_3展示-checkpoint.ipynb 52KB Q神经网络实现网格化(不同高度的障碍)路径规划-checkpoint.ipynb 42KB

Q神经网络实现网格化(不同高度的障碍)路径规划-checkpoint.ipynb 42KB Q神经网络训练 网格化地图六足机器人 V2-checkpoint.ipynb 41KB

Q神经网络训练 网格化地图六足机器人 V2-checkpoint.ipynb 41KB 六足机器人趋向目标模块(带步态)2000乘3000地图.ipynb 40KB

六足机器人趋向目标模块(带步态)2000乘3000地图.ipynb 40KB Q神经网络实现网格化(不同高度的障碍)路径规划.ipynb 40KB

Q神经网络实现网格化(不同高度的障碍)路径规划.ipynb 40KB 六足机器人趋向目标模块(带步态)3000乘3000地图 Q网络实现2(未完成)-checkpoint.ipynb 40KB

六足机器人趋向目标模块(带步态)3000乘3000地图 Q网络实现2(未完成)-checkpoint.ipynb 40KB 六足机器人避障模块 Q表实现.ipynb 37KB

六足机器人避障模块 Q表实现.ipynb 37KB 神经网络和Q学习网络构建参考.ipynb 37KB

神经网络和Q学习网络构建参考.ipynb 37KB 六足机器人趋向目标模块(带步态)3000乘3000地图 Q网络实现(未完成)-checkpoint.ipynb 33KB

六足机器人趋向目标模块(带步态)3000乘3000地图 Q网络实现(未完成)-checkpoint.ipynb 33KB 六足机器人躲避障碍模块(带步态)2000乘3000地图 最终展示版---图示-checkpoint.ipynb 31KB

六足机器人躲避障碍模块(带步态)2000乘3000地图 最终展示版---图示-checkpoint.ipynb 31KB 六足机器人趋向目标模块(带步态_不回退)Q表实现最终展示版---图示.ipynb 30KB

六足机器人趋向目标模块(带步态_不回退)Q表实现最终展示版---图示.ipynb 30KB 六足机器人趋向目标与避障模块结合 测试版-checkpoint.ipynb 30KB

六足机器人趋向目标与避障模块结合 测试版-checkpoint.ipynb 30KB 六足机器人躲避障碍模块(带步态)2000乘3000地图 最终展示版---图示.ipynb 29KB

六足机器人躲避障碍模块(带步态)2000乘3000地图 最终展示版---图示.ipynb 29KB Q神经网络训练 网格化地图六足机器人 V2.ipynb 28KB

Q神经网络训练 网格化地图六足机器人 V2.ipynb 28KB Q神经网络实现网格化(不同高度的障碍)路径规划-试验版-checkpoint.ipynb 23KB

Q神经网络实现网格化(不同高度的障碍)路径规划-试验版-checkpoint.ipynb 23KB Q神经网络实现网格化(不同高度的障碍)路径规划-试验版.ipynb 22KB

Q神经网络实现网格化(不同高度的障碍)路径规划-试验版.ipynb 22KB Q_Learning 中期答辩3_3展示.ipynb 21KB

Q_Learning 中期答辩3_3展示.ipynb 21KB 六足机器人趋向目标模块(带步态)2000乘3000地图-checkpoint.ipynb 19KB

六足机器人趋向目标模块(带步态)2000乘3000地图-checkpoint.ipynb 19KB 六足机器人趋向目标模块(角度+距离)Q表实现-checkpoint.ipynb 19KB

六足机器人趋向目标模块(角度+距离)Q表实现-checkpoint.ipynb 19KB Q表实现网格化(不同高度的障碍)路径规划2.ipynb 18KB

Q表实现网格化(不同高度的障碍)路径规划2.ipynb 18KB 六足机器人趋向目标模块Q表构建(不带步态) 最终展示版 图示 -checkpoint.ipynb 18KB

六足机器人趋向目标模块Q表构建(不带步态) 最终展示版 图示 -checkpoint.ipynb 18KB Support Vector Machine SVM-checkpoint.ipynb 17KB

Support Vector Machine SVM-checkpoint.ipynb 17KB 地图构建障碍灰度测试PIL_Image包.ipynb 15KB

地图构建障碍灰度测试PIL_Image包.ipynb 15KB 六足机器人趋向目标模块(带步态_不回退)Q表实现最终展示版---图示-checkpoint.ipynb 14KB

六足机器人趋向目标模块(带步态_不回退)Q表实现最终展示版---图示-checkpoint.ipynb 14KB Q表实现网格化(不同高度的障碍)路径规划2-checkpoint.ipynb 11KB

Q表实现网格化(不同高度的障碍)路径规划2-checkpoint.ipynb 11KB Q表 展示.ipynb 4KB

Q表 展示.ipynb 4KB 地图构建障碍灰度测试PIL_Image包-checkpoint.ipynb 3KB

地图构建障碍灰度测试PIL_Image包-checkpoint.ipynb 3KB 神经网络和Q学习网络构建参考-checkpoint.ipynb 72B

神经网络和Q学习网络构建参考-checkpoint.ipynb 72B Q表 展示-checkpoint.ipynb 72B

Q表 展示-checkpoint.ipynb 72B fig_dog.png 19KB

fig_dog.png 19KB ResultPresentation.pptx 15.63MB

ResultPresentation.pptx 15.63MB Test3plus_Table1.txt 18KB

Test3plus_Table1.txt 18KB Test3plus_Table4.txt 18KB

Test3plus_Table4.txt 18KB Test3_Table6.txt 18KB

Test3_Table6.txt 18KB Test3plus_Table2.txt 18KB

Test3plus_Table2.txt 18KB Test3_Table0.txt 18KB

Test3_Table0.txt 18KB Test2_Table1.txt 18KB

Test2_Table1.txt 18KB Test3_Table2.txt 18KB

Test3_Table2.txt 18KB Test3_Table11.txt 18KB

Test3_Table11.txt 18KB Test1_Table2.txt 18KB

Test1_Table2.txt 18KB Test4_Table1.txt 18KB

Test4_Table1.txt 18KB Test3_Table5.txt 18KB

Test3_Table5.txt 18KB Test1_Table1.txt 18KB

Test1_Table1.txt 18KB Test3_Table10.txt 18KB

Test3_Table10.txt 18KB Test3_Table4.txt 18KB

Test3_Table4.txt 18KB Test3_Table9.txt 18KB

Test3_Table9.txt 18KB Test3_Table3.txt 18KB

Test3_Table3.txt 18KB Test2_Table2.txt 18KB

Test2_Table2.txt 18KB Test3plus_Table3.txt 18KB

Test3plus_Table3.txt 18KB Test3_Table8.txt 18KB

Test3_Table8.txt 18KB Test4_Table2.txt 18KB

Test4_Table2.txt 18KB Test4_Table0.txt 18KB

Test4_Table0.txt 18KB Test3_Table7.txt 18KB

Test3_Table7.txt 18KB Test2_Table0.txt 18KB

Test2_Table0.txt 18KB Test3plus_Table0.txt 18KB

Test3plus_Table0.txt 18KB Test3_Table1.txt 18KB

Test3_Table1.txt 18KB Test1_Table0.txt 18KB

Test1_Table0.txt 18KB Q_Table_try.txt 6KB

Q_Table_try.txt 6KB Q_Table.txt 6KB

Q_Table.txt 6KB Q_Table2_001.txt 4KB

Q_Table2_001.txt 4KB Q_Table2_notgait2.txt 4KB

Q_Table2_notgait2.txt 4KB Test2_MaxQValueAction2.txt 4KB

Test2_MaxQValueAction2.txt 4KB Test3_MaxQValueAction8.txt 4KB

Test3_MaxQValueAction8.txt 4KB Test3plus_MaxQValueAction1.txt 4KB

Test3plus_MaxQValueAction1.txt 4KB Test2_MaxQValueAction1.txt 4KB

Test2_MaxQValueAction1.txt 4KB Test4_MaxQValueAction1.txt 4KB

Test4_MaxQValueAction1.txt 4KB Test3_MaxQValueAction7.txt 4KB

Test3_MaxQValueAction7.txt 4KB Test3_MaxQValueAction10.txt 4KB

Test3_MaxQValueAction10.txt 4KB Test3_MaxQValueAction5.txt 4KB

Test3_MaxQValueAction5.txt 4KB Test3_MaxQValueAction2.txt 4KB

Test3_MaxQValueAction2.txt 4KB Test3plus_MaxQValueAction4.txt 4KB

Test3plus_MaxQValueAction4.txt 4KB Test3_MaxQValueAction0.txt 4KB

Test3_MaxQValueAction0.txt 4KB- 1

- 2

- 粉丝: 1w+

- 资源: 3975

我的内容管理

展开

我的内容管理

展开

我的资源

快来上传第一个资源

我的资源

快来上传第一个资源

我的收益 登录查看自己的收益

我的收益 登录查看自己的收益 我的积分

登录查看自己的积分

我的积分

登录查看自己的积分

我的C币

登录后查看C币余额

我的C币

登录后查看C币余额

我的收藏

我的收藏  我的下载

我的下载  下载帮助

下载帮助

前往需求广场,查看用户热搜

前往需求广场,查看用户热搜最新资源

信息提交成功

信息提交成功