全文共 5262 字,阅读大约需要 10 分钟。

一. 概述

当前,AI 的运用与监管备受社会关注。近日,国家互联网信息办公室发布《生成

式人工智能服务管理办法(征求意见稿)》,以期促进生成式人工智能技术健康

发展与规范应用,拉开国内对大预言模型监管的序幕。

随着 ChatGPT 等通用人工智能的革命性突破,AI 技术已成为数字经济时代的核心

驱动力、产业转型升级的重要支撑。然而强劲发展势头下,AI 不可避免会遭遇“成

长烦恼”。本文主要介绍了 ChatGPT 潜在的八大安全隐患,包括隐私数据泄露、

模型窃取、数据重构、成员推断攻击、数据投毒、Prompt Injection 攻击、模型劫

持攻击以及海绵样本攻击,呼吁 ChatGPT 自身的安全隐患不容忽视。

二、ChatGPT 面临的自身安全问题

传统的网络安全手段难以迁移到对 AI 模型安全的保护中,AI 模型所面临的攻击

面相较于传统网络空间是不同的、全新的。

对 MLaaS(机器学习即服务)提供商来说,为了保障人工智能模型和数据相关隐

私,对外仅开放 API 接口提供服务,想要使用模型服务的用户没有机会直接接触

到模型和数据。但由于 AI 模型的特性,在数据本身未遭到泄露的情况下,攻击

者可能仅根据模型输出,通过成员推断攻击、数据重构攻击等,推断出训练数据

的某种属性或恢复训练数据,也能够通过模型窃取重现模型功能与参数。模型输

出易获得的特点决定了 AI 模型相关的隐私泄露很难避免。同时,在模型生命周

期的各个阶段,AI 模型都面临着安全威胁,例如,在训练阶段,通过数据投毒方

式,攻击者使用对抗样本降低模型精度,也可以用后门攻击触发模型的特定行为;

在推理阶段,攻击者通过逃逸攻击误导模型的决策过程。

ChatGPT 作为大型语言模型,在模型的训练、推理、更新阶段采用的策略和过程

上较一般通用模型都要更复杂,越复杂的 AI 系统意味着越多的潜在安全威胁,

ChatGPT 可能会受到多种攻击的影响。以下对 ChatGPT 潜在的安全风险进行介绍。

2.1

隐私数据泄露

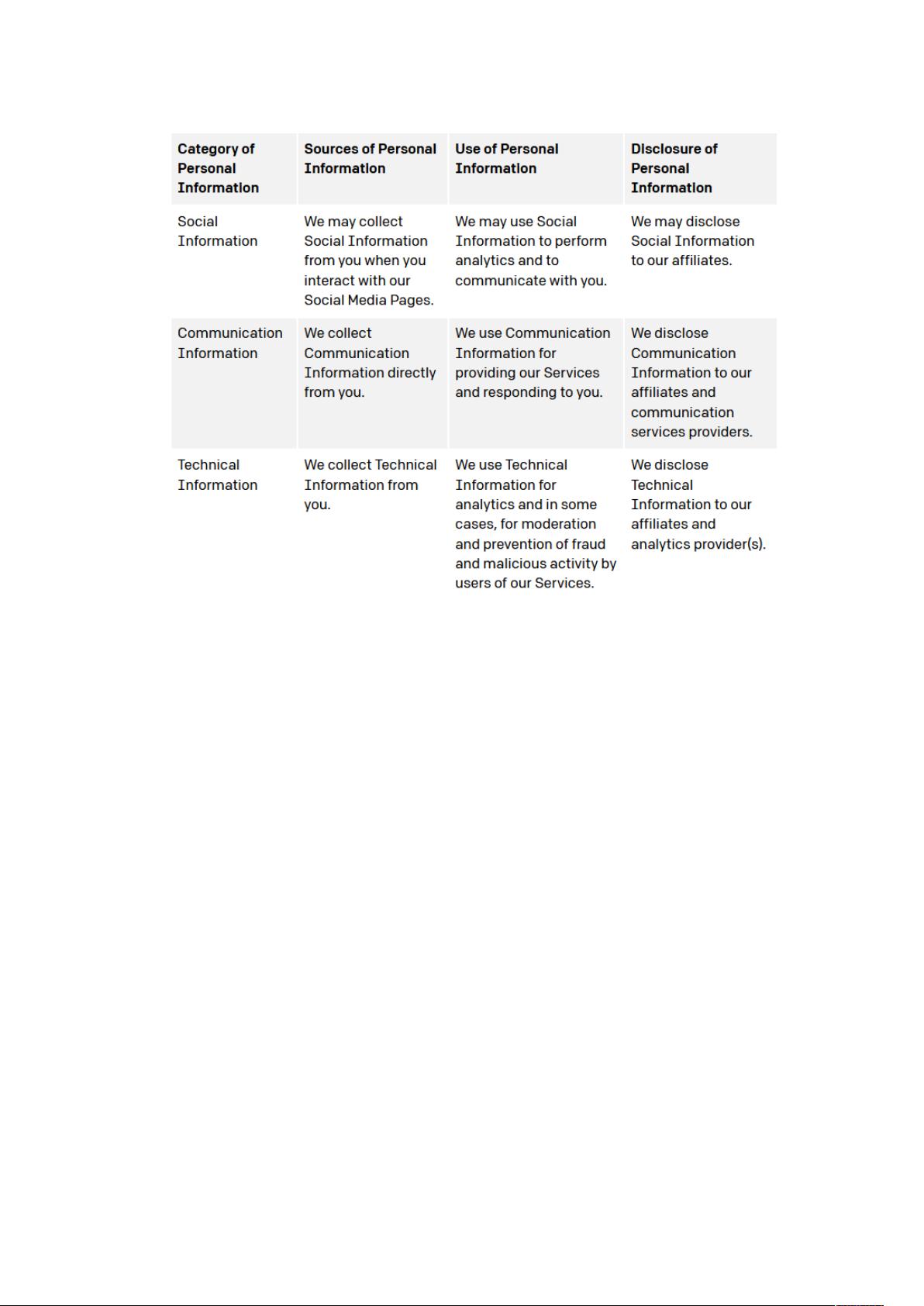

OpenAI 在隐私政策中提到,ChatGPT 会收集用户账户信息、对话相关的所有内容、

互动中网页内的各种隐私信息(Cookies、日志、设备信息等),这些信息可能

会被共享给供应商、服务提供商以及附属公司,数据共享过程可能会有未经授权

的攻击者访问到模型相关的隐私数据,包括训练/预测数据(可能涵盖用户信息)

泄露,模型架构、参数、超参数等。