2017美国NIPS大会谷歌研究院院长机器学习演讲

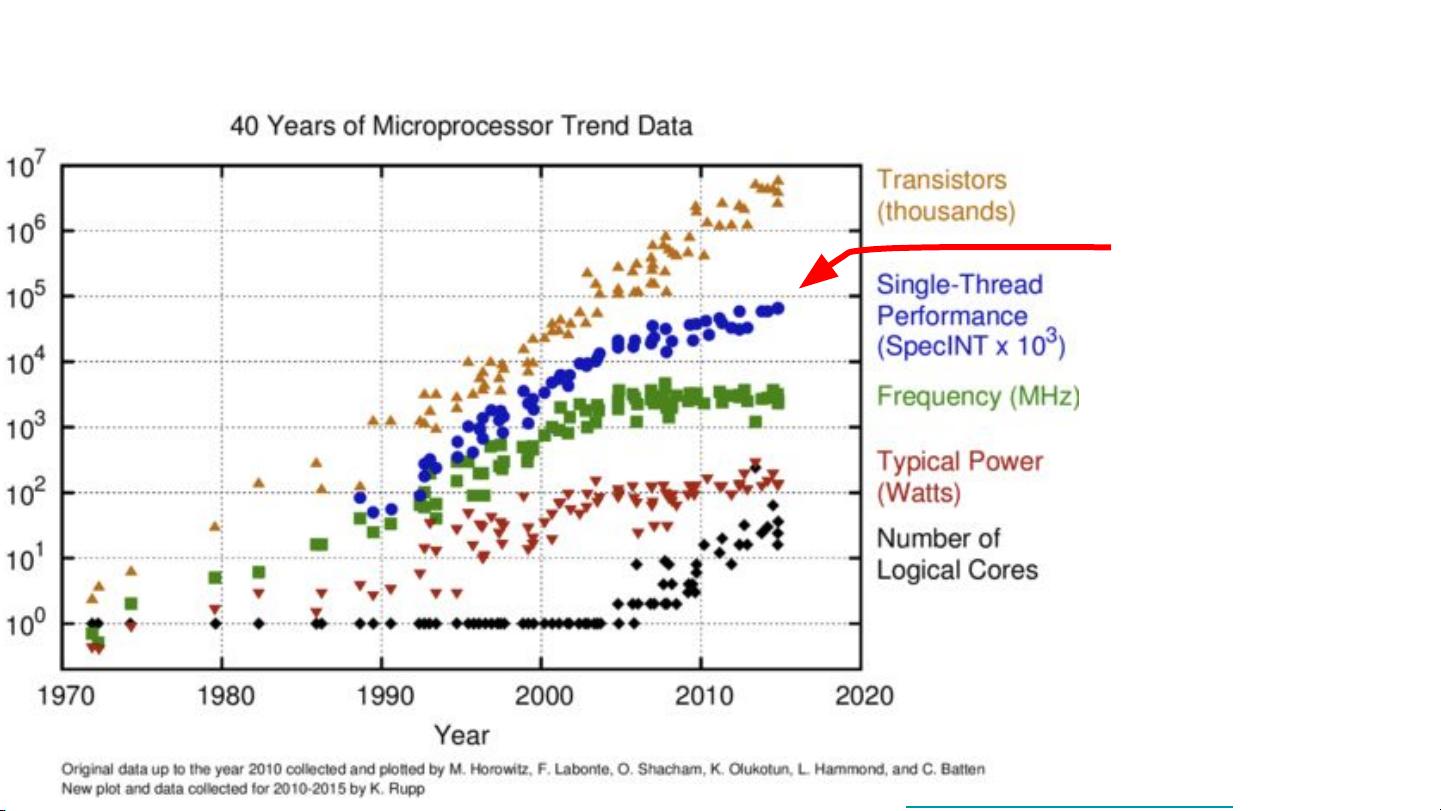

在2017年的NIPS大会(Neural Information Processing Systems Conference)上,谷歌研究院院长Jeff Dean发表了一篇关于机器学习在系统中的应用以及为机器学习设计的系统的演讲。在演讲中,他探讨了随着深度学习不断增长的计算需求,尤其是在处理大型数据集和复杂的深度模型时所需的计算能力。Jeff Dean强调了特殊的计算属性,例如降低计算精度的可行性,以及Google设计的专用芯片——Tensor Processing Units(TPUs),这些专用硬件加速器是如何显著提高机器学习的性能的。 Jeff Dean提到了通用处理器性能趋势的变化。他指出,在经历了几十年的指数级增长之后,单核处理器性能的增长已经趋缓,这是根据Karl Rupp发布的40年微处理器趋势数据得出的结论。这一趋势使得在单核处理器上实现进一步的性能提升变得越来越困难,这也间接促进了深度学习技术的发展。 接下来,Jeff Dean强调了深度学习如何正在改变计算机设计的方式。由于深度学习模型通常需要大量的计算资源,因此在处理TB或PB级别的训练数据集时,计算需求变得十分巨大。使用AutoML等技术(包括“学习如何学习”、神经架构搜索等)可以将所需的训练计算量增加5到1000倍。此外,在处理每秒数十万次请求、毫秒级别的延迟要求以及数十亿用户的情况下,传统的通用处理器无法满足这些实时推断的需求。因此,需要更多的计算能力来支持深度学习技术的发展。 对于减少计算精度的问题,Jeff Dean提出,在执行一些特定操作时,降低精度是可行的。换句话说,特定的深度学习运算(如矩阵乘法)可以在较低的精度下执行,而不显著影响最终的性能。这一方法对于在深度学习中实现更高效的计算十分重要。 接着,Jeff Dean介绍了Google设计的Tensor Processing Units(TPUs)。TPU是一种专为神经网络推理设计的芯片,已经在Google的产品中使用了大约36个月,用于搜索查询、神经机器翻译、语音识别、图像识别以及AlphaGo比赛等。根据在《2017年国际微处理器架构会议》(ISCA 2017)上发布的研究文章,在数据中心对TPU进行的性能分析显示,TPUv1对于推断任务大有帮助。 TPUv2是Google设计的用于神经网络训练和推断的设备。TPUv2芯片提供了16GB的高带宽内存(HBM)、600GB/s的内存带宽、32位浮点的标量/向量单元和最大45 TFLOPS的性能。相比TPUv1,TPUv2在硬件规格上有了显著的提升,为机器学习任务提供了更多的计算资源。 随着TPU技术的发展,Google能够在数据中心中快速部署和使用这些专用芯片,从而大幅加速机器学习模型的训练和推理过程。这种专用硬件的使用不仅提高了研究生产力,而且也使能够解决的问题规模大大增加。 在讨论了硬件加速的同时,Jeff Dean也提到了Google在机器学习系统设计方面的一些创新。这些创新包括使用AutoML技术自动化和加速深度学习模型的设计过程,以及如何更好地利用硬件资源来提升机器学习系统的性能。 总结来说,Jeff Dean在2017年NIPS大会上的演讲集中展示了深度学习在实际应用中遇到的计算挑战以及Google研究院如何通过设计和部署专用硬件,如TPUs,来满足这些挑战。这些专用硬件不仅提高了机器学习模型的训练和推断速度,也为深度学习领域带来了革命性的进展。通过降低计算精度和使用特殊计算属性的策略,Google展示了如何在保持可接受性能的同时,显著提升计算效率。这些见解不仅对学术界的研究人员具有重要意义,同时也对工业界实施大规模机器学习任务提供了指导。

剩余53页未读,继续阅读

- 粉丝: 19

- 资源: 436

我的内容管理

展开

我的内容管理

展开

我的资源

快来上传第一个资源

我的资源

快来上传第一个资源

我的收益 登录查看自己的收益

我的收益 登录查看自己的收益 我的积分

登录查看自己的积分

我的积分

登录查看自己的积分

我的C币

登录后查看C币余额

我的C币

登录后查看C币余额

我的收藏

我的收藏  我的下载

我的下载  下载帮助

下载帮助

前往需求广场,查看用户热搜

前往需求广场,查看用户热搜最新资源

- 【全年行事历】行政部全年活动计划表- A公司.xls

- 【全年行事历】活动复盘表.xlsx

- 【全年行事历】活动推广进度表.xlsx

- 【全年行事历】旅游团建行程安排表-XX山.xlsx

- 【全年行事历】旅行团建活动方案.pptx

- 【全年行事历】某公司团建活动方案-【户外烧烤】.doc.baiduyun.uploading.cfg

- 【全年行事历】企业文化年度活动计划表.xlsx

- 【全年行事历】年度员工关怀计划表.xlsx

- 【全年行事历】年度行政活动计划表.xlsx

- 【全年行事历】企业团队建设活动策划.pptx

- 【全年行事历】全年活动计划.xls

- 【全年行事历】团队建设企业文化行事历——工作计划.xlsx

- 【全年行事历】企业员工夏季团建活动策划一天.pptx

- 【全年行事历】团建费用分析.xlsx

- 【全年行事历】团建行程安排及出行清单.xlsx

- 【全年行事历】团建活动采购预算清单.xlsx

信息提交成功

信息提交成功