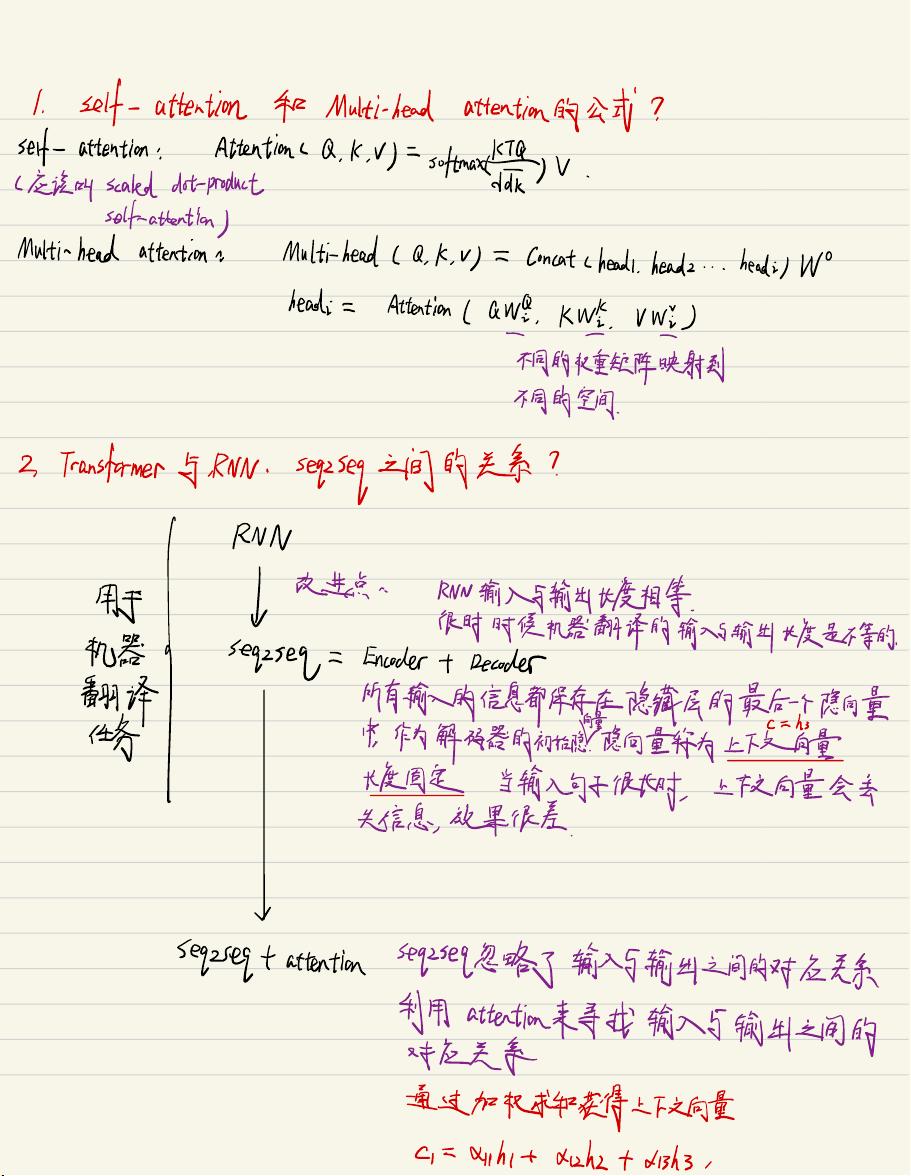

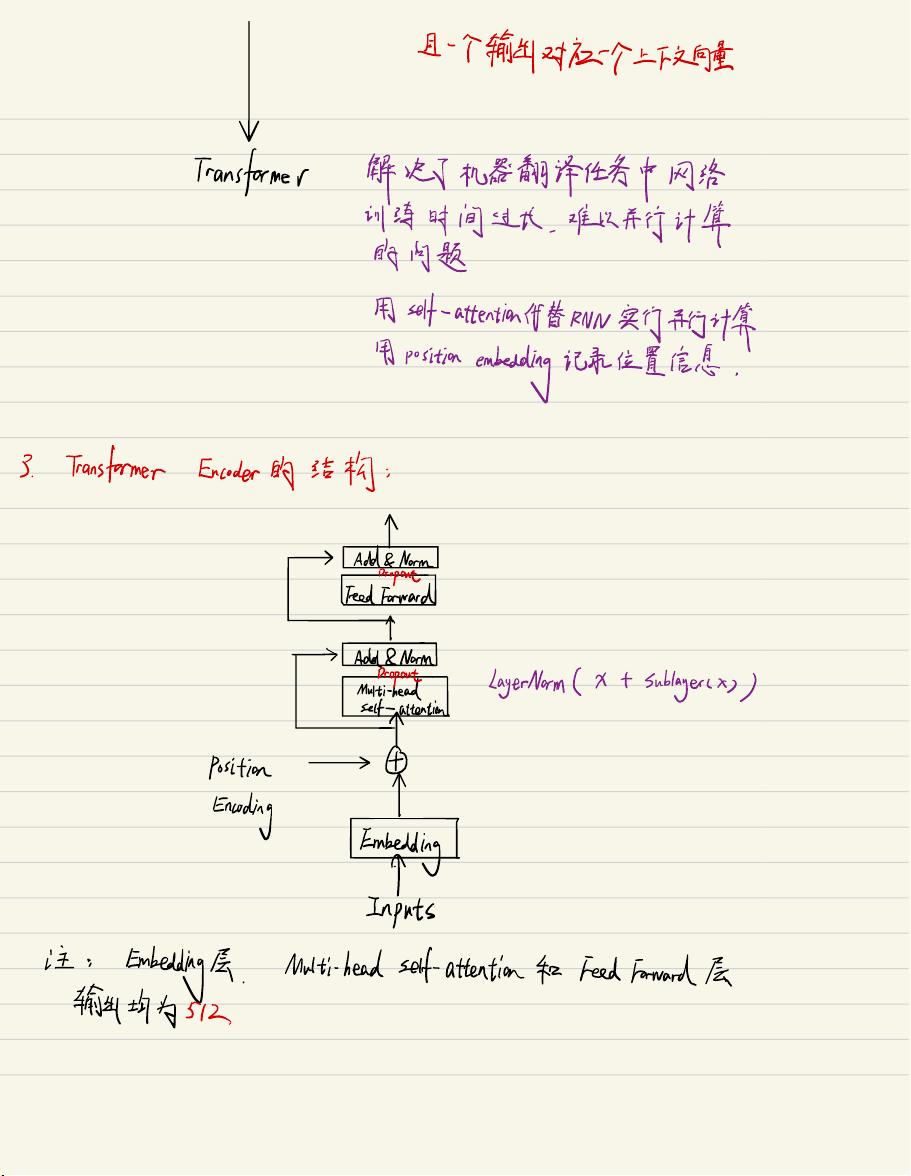

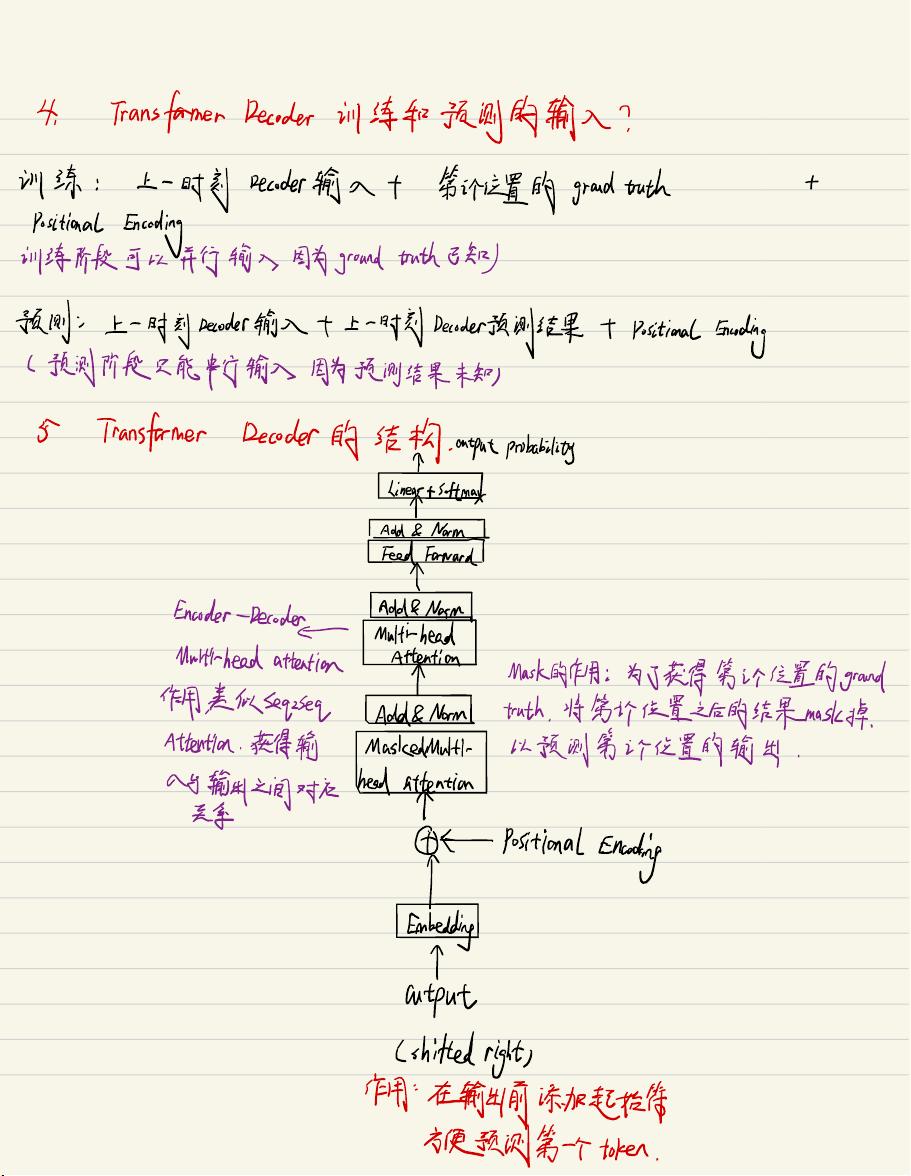

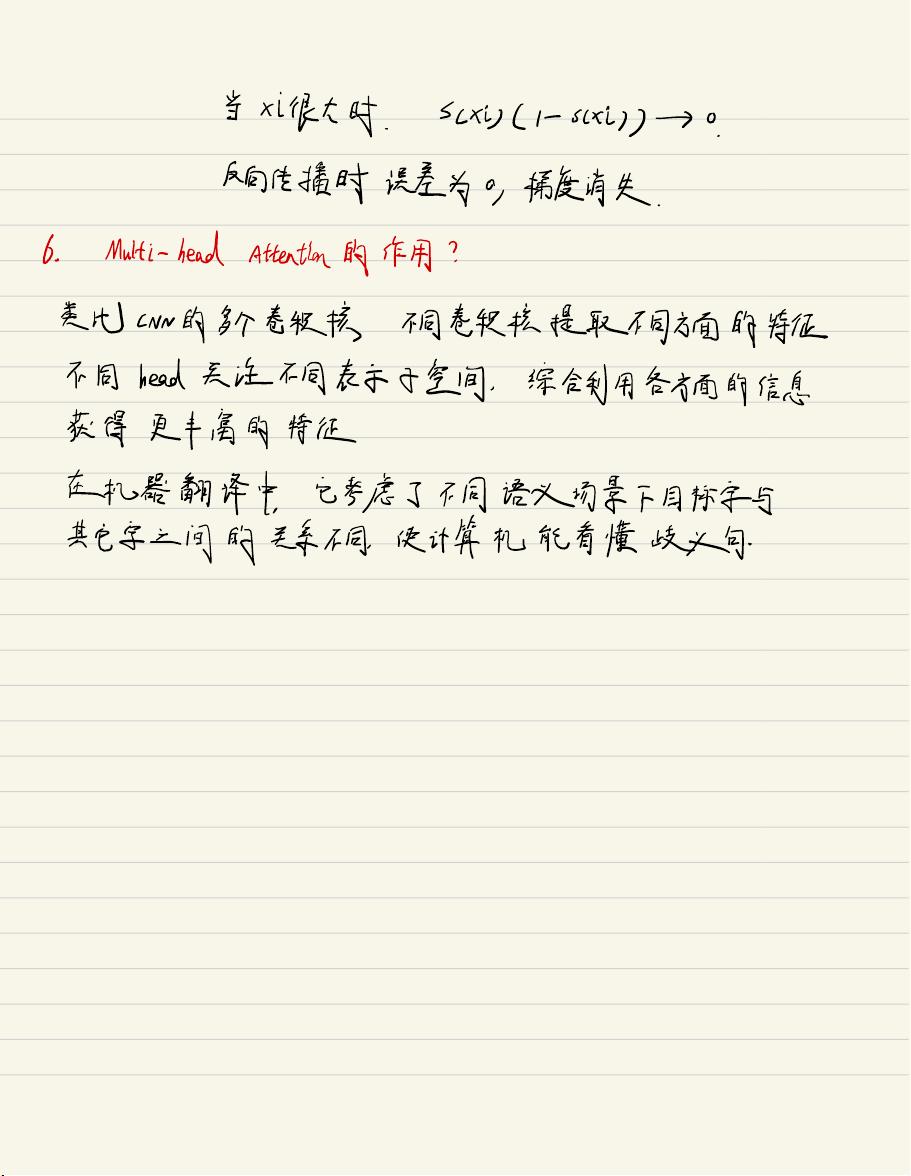

【算法面试必考点】主要涉及的是算法在求职面试中的重要性,特别是对于人工智能领域的职位。以下将详细解析其中的关键知识点: 1. **Attention机制**:Attention机制是深度学习中的一种重要概念,尤其在自然语言处理(NLP)任务中。Self-attention(自注意力)允许模型在处理序列数据时关注不同位置的重要性,而Multi-head attention则进一步增强了这种能力,通过多个独立的注意力机制关注输入的不同方面,从而获取更丰富的信息。 2. **Transformer与RNN的关系**:Transformer是一种基于自注意力机制的网络结构,与传统的循环神经网络(RNN)相比,Transformer解决了RNN在处理长序列时的效率问题,因为它可以并行计算。在机器翻译任务中,Transformer通过位置编码(Positional Encoding)来保留序列顺序信息,避免了RNN中因为固定长度的隐藏状态导致的信息丢失。 3. **Transformer Encoder和Decoder**:Transformer的结构包含Encoder和Decoder两部分。Encoder负责处理输入序列,通过多头注意力和Feedforward Network(FFN)提取特征。Decoder不仅应用了自注意力,还使用了遮罩机制(Masking),确保在预测序列的一个位置时,只能依赖于已知的前一个位置,防止未来信息的泄露。 4. **训练和预测阶段的区别**:在训练过程中,Transformer Decoder可以并行接收所有时间步的输入,而在预测阶段,由于不知道未来的输出,必须按顺序进行,每一步的输入基于前一步的解码结果。 5. **Scaling in Attention**:在Attention计算中,通常会对内积进行缩放,这是为了避免大向量之间的内积导致的梯度消失问题。较大的向量内积可能使得ReLU等激活函数的梯度变得非常小,影响模型的训练。 6. **Multi-head Attention的作用**:多头注意力机制可以看作是多个独立的注意力机制的结合,每个头关注输入的不同方面,从而捕获更复杂的依赖关系,特别是在处理自然语言中的歧义和上下文理解时。 7. **Feedforward Network(FFN)**:FFN是Transformer中的一个组件,通常由两个线性层组成,中间夹着一个非线性激活函数,如ReLU,用于对Attention机制的输出进行进一步处理。 8. **点乘Attention与加性Attention**:点乘Attention在计算效率和内存使用上优于加性Attention,因为它可以直接通过矩阵乘法实现,并且在优化时速度更快。 9. **概率密度函数与似然函数的区别**:概率密度函数描述了一个随机变量的概率分布,而似然函数是已知观测数据的情况下,给定模型参数的条件下,数据出现的概率。 10. **条件概率、贝叶斯定理与朴素贝叶斯分类**:条件概率是描述在已知一个事件发生的情况下,另一个事件发生的概率。贝叶斯定理提供了从观察数据反推模型参数的概率,朴素贝叶斯分类器则是基于贝叶斯定理,假设特征之间相互独立。 这些知识点都是算法面试中常见的问题,掌握它们对于理解和解决实际问题至关重要。在面试准备中,深入理解并能够灵活运用这些概念和技术,将有助于提升面试成功的机会。

剩余34页未读,继续阅读

- 粉丝: 0

- 资源: 5

我的内容管理

展开

我的内容管理

展开

我的资源

快来上传第一个资源

我的资源

快来上传第一个资源

我的收益 登录查看自己的收益

我的收益 登录查看自己的收益 我的积分

登录查看自己的积分

我的积分

登录查看自己的积分

我的C币

登录后查看C币余额

我的C币

登录后查看C币余额

我的收藏

我的收藏  我的下载

我的下载  下载帮助

下载帮助

前往需求广场,查看用户热搜

前往需求广场,查看用户热搜最新资源

信息提交成功

信息提交成功