IKAnalyzer中文分词器V3.2.8使用手册

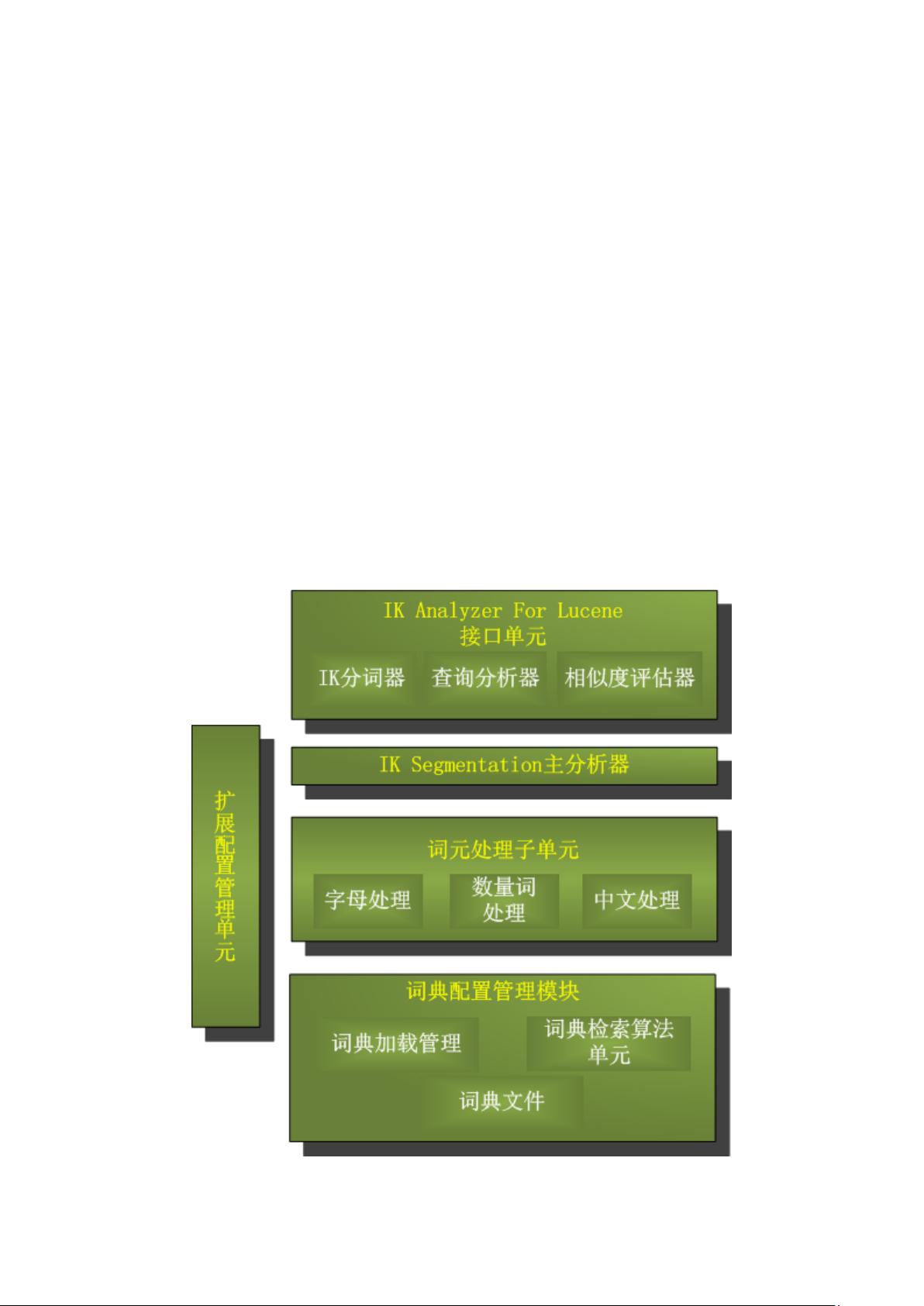

### IKAnalyzer中文分词器V3.2.8使用手册 #### 1. IKAnalyzer3.X介绍 IKAnalyzer是一款开源的、基于Java语言开发的轻量级中文分词工具包。自2006年12月发布1.0版以来,已经经历了多个大版本的迭代,目前最新版本为V3.2.8。最初,IKAnalyzer作为开源项目Lucene的一部分,主要服务于该搜索引擎库。随着时间的发展,IKAnalyzer逐渐演变为一个独立于Lucene之外的公共分词组件,并且仍然保留了针对Lucene的优化实现。 ##### 1.1 IKAnalyzer3.X结构设计 IKAnalyzer3.X采用了模块化的设计理念,使得其在功能上更加灵活、可扩展性强。它不仅仅限于中文分词,还支持英文字母、数字以及韩文、日文字符的处理,极大地拓宽了应用场景。 ##### 1.2 IKAnalyzer3.X特性 1. **高效的分词算法**:采用了特有的“正向迭代最细粒度切分算法”,支持细粒度和最大词长两种切分模式,能够根据实际需求选择最合适的分词策略。 2. **高速处理能力**:处理速度高达83万字/秒(1600KB/S),在处理大量数据时仍能保持高效稳定。 3. **多子处理器分析模式**:支持对不同类型的字符进行精确处理,包括但不限于英文字母、数字、中文词汇等。 4. **优化的词典存储**:通过优化词典的存储结构,减少了内存占用,使得IKAnalyzer能够在资源有限的环境下也能正常运行。 5. **用户词典扩展**:支持用户自定义词典扩展,可根据特定领域的需求添加新的词条,提高分词的准确性和针对性。 6. **针对Lucene优化的查询分析器**:IKQueryParser针对Lucene进行了专门优化,引入简单的搜索表达式,并采用歧义分析算法来优化查询关键字的搜索排列组合,显著提高了Lucene检索的命中率。 #### 1.3 分词效果示例 IKAnalyzer3.2.8版本支持两种不同的分词方式:细粒度切分和最大词长切分。以下是一些具体的例子: - **文本原文1**:“IKAnalyzer是一个开源的,基于java诧言开发的轻量级的中文分词工具包。从2006年12月推出1.0版开始,IKAnalyzer已经推出了3个大版本。” - **最大词长分词结果**:“ikanalyzer|是|一个|开源|的|基于|java|诧言|开发|的|轻量级|的|中文|分词|工具包|从|2006|年|12|月|推出|1.0|版|开始|ikanalyzer|已经|推出|出了|3|个|大|版本” - **最细粒度分词结果**:“ikanalyzer|是|一个|一|个|开源|的|基于|java|诧言|开发|的|轻|量级|量级|的|中文|分词|工具包|工具|从|2006|年|12|月|推出|1.0|版|开始|ikanalyzer|已经|推出|出了|3|个|大|版本” - **文本原文2**:“作者博客:linliangyi2007.javaeye.com电子邮件:linliangyi2005@gmail.com” - **最大词长分词结果**:“作者|博客|linliangyi2007.javaeye.com|电子邮件|linliangyi2005@gmail.com” - **最细粒度分词结果**:“作者|博客|linliangyi2007.javaeye.com|linliangyi|2007|javaeye|com|电子邮件|linliangyi2005@gmail.com|linliangyi|2005|gmail|com” - **文本原文3**:“古田县城关六一四路四百零五号” - **最大词长分词结果**:“古田县|县城|城关|六一四|路|四百零五|号” - **最细粒度分词结果**:“古田县|古田|县城|城关|六一四|六一|四|路|四百零五|四|百|零|五|号” - **文本原文4**:“曙光天阔I620r-G/A950r-F夏普SH9020C” - **最大词长分词结果**:“曙光|天|阔|i620r-g|a950r-f|夏普|sh9020c” - **最细粒度分词结果**:“曙光|天|阔|i620r-g|i|620|r|g|a950r-f|a|950|r|f|夏普|sh9020c|sh|9020|c” #### 2. 使用指南 ##### 2.1 下载地址 IKAnalyzer可在Google Code上找到开源项目和相关下载链接: - **Google Code 开源项目**:[http://code.google.com/p/ik-analyzer/](http://code.google.com/p/ik-analyzer/) - **Google Code SVN下载**:[http://ik-analyzer.googlecode.com/svn/trunk/](http://ik-analyzer.googlecode.com/svn/trunk/) ##### 2.2 与相关项目的版本兼容 IKAnalyzer的不同版本与其支持的Lucene和Solr版本之间存在一定的兼容性问题,具体如下: | IK分词器版本 | Lucene版本 | Solr版本 | | --- | --- | --- | | 3.1.3GA及先前版 | 兼容2.9.1及先前版本 | 没有solr接口 | | 3.1.5GA | 兼容2.9.1及先前版本 | 对solr1.3提供接口实现 | | 3.1.6GA | 兼容2.9.1及先前版本 | 对solr1.3、solr1.4提供接口实现 | | 3.2.0G及后续版本 | 兼容Lucene2.9及3.0版本 | 仅对solr1.4提供接口实现 | 请注意参考对应的版本使用手册以确保正确使用。 ##### 2.3 安装部署 IKAnalyzer的安装包包含了《IKAnalyzer中文分词器V3.X使用手册》,其中详细介绍了如何安装配置IKAnalyzer。此外,还需要注意的是,IKAnalyzer的具体安装步骤可能会因版本不同而有所差异,建议仔细阅读官方文档以确保顺利安装。 IKAnalyzer作为一款高性能的中文分词工具,在中文搜索引擎领域有着广泛的应用,其高效的分词算法和丰富的功能使其成为中文自然语言处理领域的佼佼者。无论是对于开发者还是研究者而言,掌握IKAnalyzer的使用方法都是非常有价值的。

剩余17页未读,继续阅读

coder_hui2013-01-14不错,可以用。

coder_hui2013-01-14不错,可以用。

- 粉丝: 0

- 资源: 4

我的内容管理

展开

我的内容管理

展开

我的资源

快来上传第一个资源

我的资源

快来上传第一个资源

我的收益 登录查看自己的收益

我的收益 登录查看自己的收益 我的积分

登录查看自己的积分

我的积分

登录查看自己的积分

我的C币

登录后查看C币余额

我的C币

登录后查看C币余额

我的收藏

我的收藏  我的下载

我的下载  下载帮助

下载帮助

前往需求广场,查看用户热搜

前往需求广场,查看用户热搜最新资源

信息提交成功

信息提交成功