分布式并行编程 (2).docx

2.虚拟产品一经售出概不退款(资源遇到问题,请及时私信上传者)

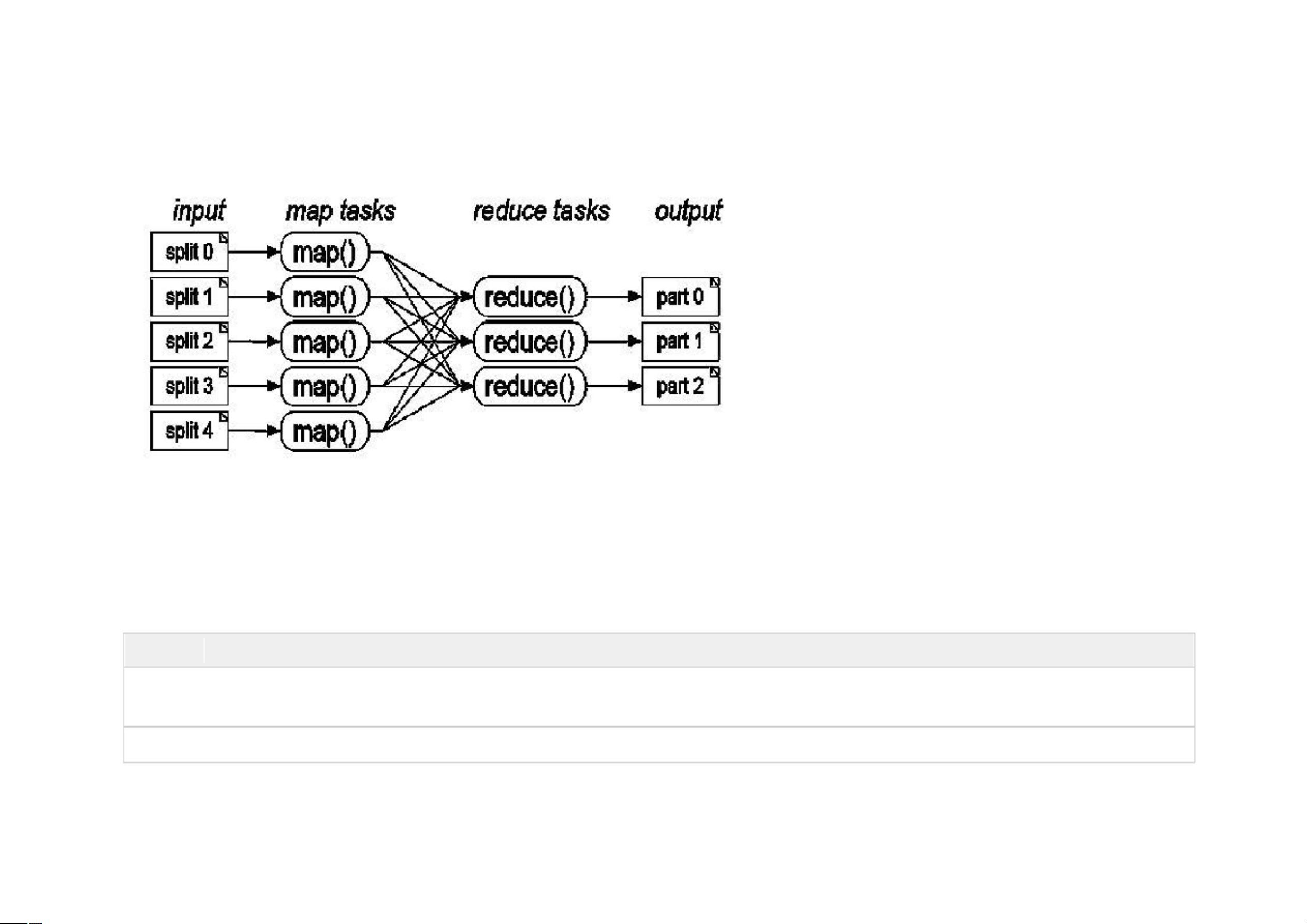

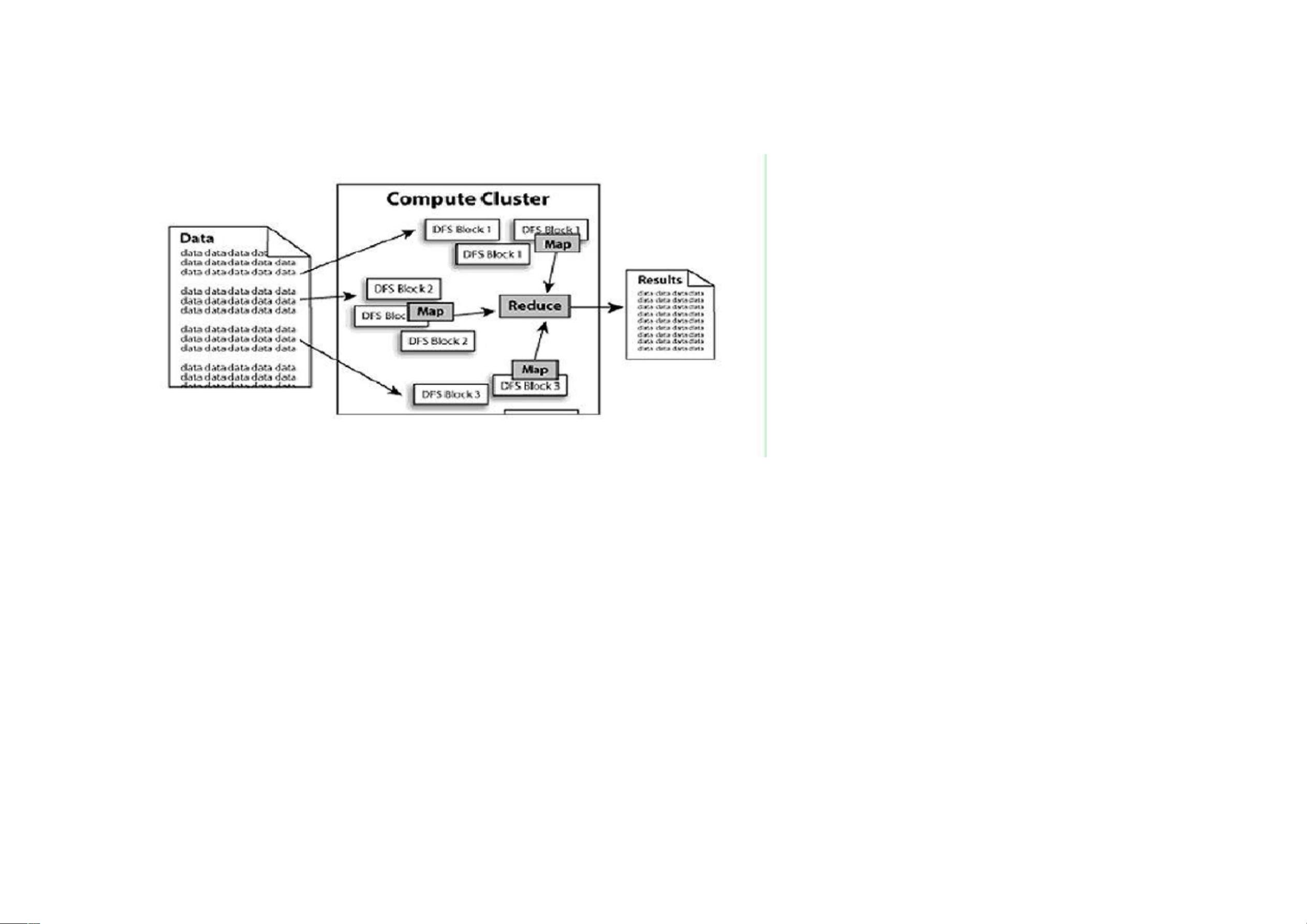

分布式并行编程是一种应对大数据处理和计算挑战的技术,它允许程序在多台计算机上同时运行,以提高效率和处理能力。Hadoop 是一个关键的开源框架,专门设计用于支持这种编程模型。该框架基于 MapReduce 计算模型,使得程序员可以轻松编写处理大量数据的分布式程序。 MapReduce 是一种编程范式,由Google提出,它将大型计算任务分解为两个主要阶段:Map(映射)和 Reduce(归约)。在Map阶段,原始数据被分成多个部分,然后在不同的计算节点上并行处理。Reduce阶段则将Map阶段的结果整合,生成最终的输出。Hadoop通过这种方式,能够在大规模集群上高效处理PB级别的数据。 Hadoop 包含两个核心组件:Hadoop Distributed File System (HDFS) 和 MapReduce 框架。HDFS 是一个高容错性的分布式文件系统,它允许数据在集群中的多台机器上冗余存储,确保即使有节点故障,数据仍然可以访问。MapReduce则负责数据的并行处理。 Hadoop 的起源可以追溯到Nutch和Lucene这两个开源项目。Lucene是一个强大的全文搜索库,而Nutch是在Lucene基础上构建的开源搜索引擎,它包含了分布式文件系统和MapReduce算法。随着Nutch的发展,Doug Cutting将其中的分布式文件系统和MapReduce部分独立出来,创建了Hadoop。 Hadoop 在云计算领域扮演着重要角色。雅虎、Amazon、IBM等大公司都在其云计算平台中使用Hadoop。例如,雅虎的Pig项目是一个基于Hadoop的数据分析平台,Amazon的S3和EC2服务也依赖Hadoop提供大规模数据存储和计算能力。IBM的“蓝云计划”同样将Hadoop作为基础组件。 随着多核处理器和互联网时代的到来,传统的单线程编程模式已无法满足性能需求。并发编程和分布式并行编程成为提升软件性能的关键。多核使得在同一台机器上可以执行多个线程,而分布式并行编程则利用网络中的多台计算机协同工作,提供近乎无限的计算资源。虽然这种编程方式带来了学习曲线的挑战,但它能有效解决大数据处理的问题,并在容错性和可扩展性方面表现出色。 总结起来,Hadoop作为分布式并行编程的重要工具,通过MapReduce模型简化了处理大规模数据的任务。它在云计算领域广泛应用,推动了软件编程方式的转变,适应了多核和分布式计算的需求,为大数据时代的数据处理提供了强大支持。学习和掌握Hadoop及其相关技术,对于应对未来的计算挑战至关重要。

剩余40页未读,继续阅读

- 粉丝: 6789

- 资源: 3万+

我的内容管理

展开

我的内容管理

展开

我的资源

快来上传第一个资源

我的资源

快来上传第一个资源

我的收益 登录查看自己的收益

我的收益 登录查看自己的收益 我的积分

登录查看自己的积分

我的积分

登录查看自己的积分

我的C币

登录后查看C币余额

我的C币

登录后查看C币余额

我的收藏

我的收藏  我的下载

我的下载  下载帮助

下载帮助

前往需求广场,查看用户热搜

前往需求广场,查看用户热搜最新资源

- 基于Qt的上海地铁换乘系统详细文档+全部资料+高分项目.zip

- 发那科机器人二次开发 C#读取和写入数据,可以获取点位信息

- 基于QT的人脸识别,定位导航,脑电心率测算,用GPRS传到服务端的疲劳驾驶检测系统详细文档+全部资料+高分项目.zip

- 基于Qt的图书管理系统普通用户操作界面详细文档+全部资料+高分项目.zip

- 基于Qt的文件共享系统,类似百度网盘详细文档+全部资料+高分项目.zip

- 基于QT的网络视频监控系统详细文档+全部资料+高分项目.zip

- 基于QT的图书管理系统详细文档+全部资料+高分项目.zip

- 基于QT的学生成绩管理系统,QSS界面设计,SQL数据库的使用详细文档+全部资料+高分项目.zip

- 基于Qt的物业管理系统详细文档+全部资料+高分项目.zip

- 基于QT的直播管理系统详细文档+全部资料+高分项目.zip

- 基于Qt的学生信息管理系统、教师端:支持增删查改,班级成绩分析。学生端:查看成绩详细文档+全部资料+高分项目.zip

- 基于Qt的智能病房系统详细文档+全部资料+高分项目.zip

- 基于Qt构建的目标检测系统。基于dlib_rear_end_vehicles数据集详细文档+全部资料+高分项目.zip

- 基于QT的智能家居系统详细文档+全部资料+高分项目.zip

- 基于Qt和Mysql的教务管理系统详细文档+全部资料+高分项目.zip

- 基于Qt和mysql的大学生二手管理系统详细文档+全部资料+高分项目.zip

信息提交成功

信息提交成功