实验8-TensorFlow基本操作.docx

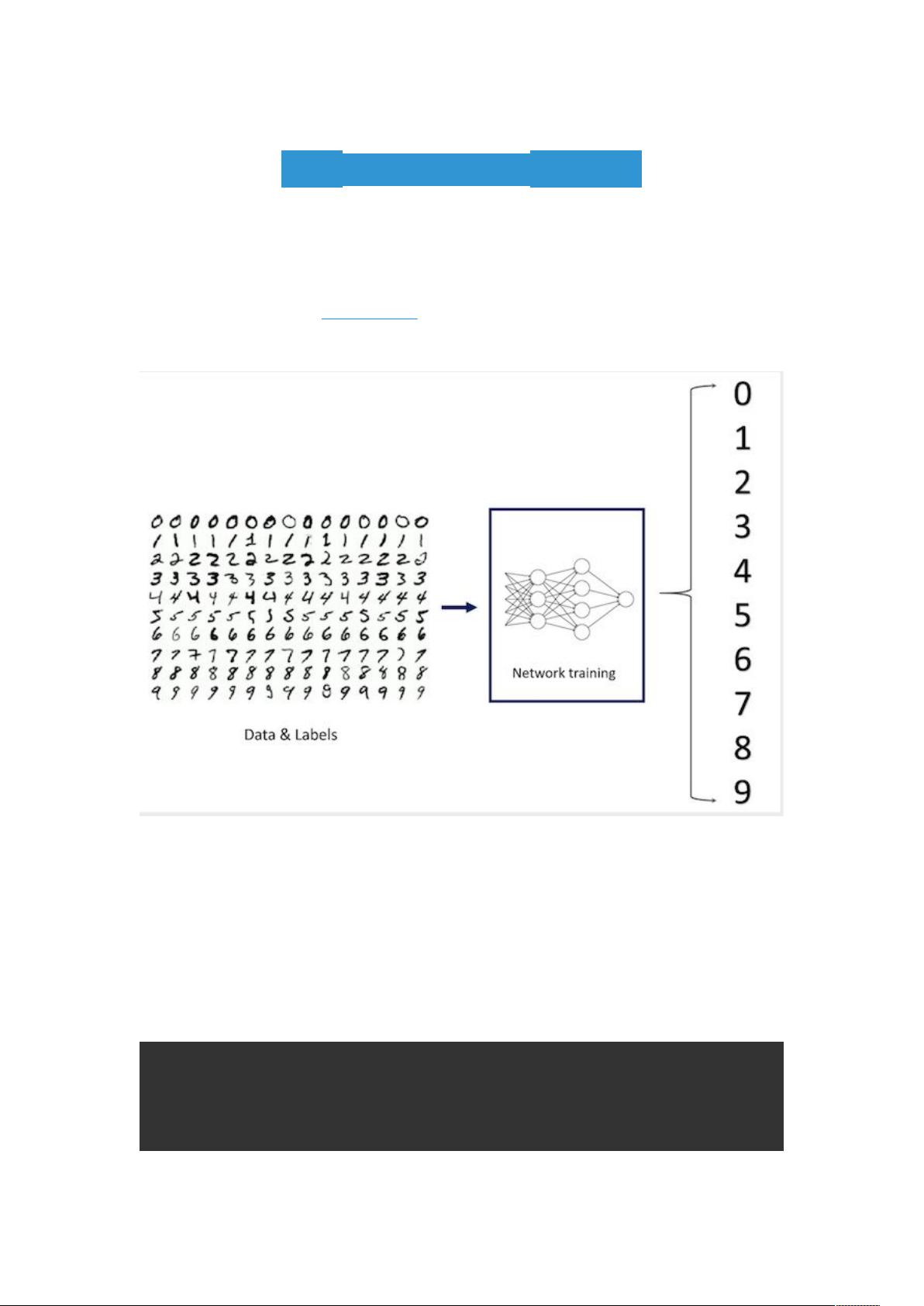

### 实验8-TensorFlow基本操作 #### 实验概述 本实验主要介绍如何利用TensorFlow这一流行的开源机器学习框架来构建、训练并评估一个简单的神经网络模型,特别针对的是手写数字识别问题。实验选用经典的MNIST数据集作为训练与测试的基础。 #### 实验目的 1. **理解TensorFlow的基本概念**:包括张量、会话、变量、占位符等。 2. **熟悉MNIST数据集**:了解其组成和用途。 3. **构建神经网络模型**:使用TensorFlow构建一个多层感知器(MLP)模型。 4. **模型训练**:通过调整权重和偏置参数来最小化损失函数。 5. **性能评估**:在测试集上评估模型的准确率。 #### 实验步骤详解 ##### 1. 加载MNIST数据集 实验中使用TensorFlow内置函数来加载MNIST数据集。MNIST数据集包含了大量手写数字的灰度图像及其对应的标签,通常用于训练各种图像处理系统。加载数据集的过程如下: ```python import tensorflow as tf from tensorflow.examples.tutorials.mnist import input_data # 读取数据 mnist = input_data.read_data_sets("MNIST_data/", one_hot=True) ``` 其中,`mnist`对象包含了训练集、验证集和测试集三个部分,每个部分都由特征向量和对应的标签构成。 ##### 2. 定义关键参数 在开始构建模型之前,需要定义一些关键参数,例如图像大小、类别数量、学习率等: ```python image_size = 28 # 图像尺寸为28x28像素 labels_size = 10 # 分类任务有10个类别(0-9) learning_rate = 0.05 # 学习率为0.05 steps_number = 1000 # 训练步数为1000 batch_size = 100 # 每批次样本数量为100 ``` ##### 3. 构建神经网络 接下来,需要构建神经网络的结构。首先定义输入输出占位符: ```python training_data = tf.placeholder(tf.float32, [None, image_size * image_size]) # 输入图像展平后的向量 labels = tf.placeholder(tf.float32, [None, labels_size]) # 输入标签 ``` 接着,定义网络中的变量,如权重和偏置: ```python W = tf.Variable(tf.truncated_normal([image_size * image_size, labels_size], stddev=0.1)) # 权重矩阵 b = tf.Variable(tf.constant(0.1, shape=[labels_size])) # 偏置向量 ``` 然后构建输出层: ```python output = tf.matmul(training_data, W) + b ``` 这里使用了矩阵乘法`tf.matmul()`来计算输入数据和权重矩阵的乘积,再加上偏置向量。 ##### 4. 定义损失函数与优化器 为了训练模型,需要定义损失函数并选择优化器来最小化这个损失函数。在这个实验中,采用交叉熵作为损失函数: ```python loss = tf.reduce_mean(tf.nn.softmax_cross_entropy_with_logits(labels=labels, logits=output)) ``` 接下来,选择梯度下降算法作为优化器: ```python train_step = tf.train.GradientDescentOptimizer(learning_rate).minimize(loss) ``` ##### 5. 性能评估 为了评估模型的性能,定义了一个准确率计算函数: ```python correct_prediction = tf.equal(tf.argmax(output, 1), tf.argmax(labels, 1)) accuracy = tf.reduce_mean(tf.cast(correct_prediction, tf.float32)) ``` 其中,`tf.argmax()`函数用于找到预测结果中概率最高的类别标签,`tf.equal()`则比较预测标签与真实标签是否一致。 ##### 6. 开始训练 可以初始化所有变量并在会话中启动训练过程。在每次迭代中,从训练集中随机抽取一批数据,用以更新模型参数。 ```python with tf.Session() as sess: sess.run(tf.global_variables_initializer()) for step in range(steps_number): batch_xs, batch_ys = mnist.train.next_batch(batch_size) sess.run(train_step, feed_dict={training_data: batch_xs, labels: batch_ys}) # 测试模型 test_accuracy = accuracy.eval(feed_dict={training_data: mnist.test.images, labels: mnist.test.labels}) print("Test accuracy:", test_accuracy) ``` 以上步骤完成了整个实验的流程。通过本实验的学习,可以熟练掌握如何使用TensorFlow构建、训练和评估一个简单的神经网络模型,并解决实际问题——手写数字识别。

- 粉丝: 1

- 资源: 8

我的内容管理

展开

我的内容管理

展开

我的资源

快来上传第一个资源

我的资源

快来上传第一个资源

我的收益 登录查看自己的收益

我的收益 登录查看自己的收益 我的积分

登录查看自己的积分

我的积分

登录查看自己的积分

我的C币

登录后查看C币余额

我的C币

登录后查看C币余额

我的收藏

我的收藏  我的下载

我的下载  下载帮助

下载帮助

前往需求广场,查看用户热搜

前往需求广场,查看用户热搜最新资源

- 五险一金年度成本统计图.xlsx

- 华为云全新设计的SDK V3版本,提供统一的SDK使用方式 通过添加依赖或下载的方式调用华为云API,访问华为云应用、资源和数据 无需关心请求细节即可快速使用弹性云服务器、虚拟私有云等多个华为云服务

- 数据分析-23-糖尿病预测(线性回归模型)(包含数据代码)

- AES128算法子VI,labview版本,全网不好找 已经在产线批量使用,某出口OEM控制器使用的秘钥算法

- Christmas.html

- 劳动法律法规工伤赔偿表格.xlsx

- 缴纳五险一金台账.xls

- 全国五险一金信息大全(多表格).xls

- 员工五险一金预算表(多省市)..xls

- ToDoer是一个Windows平台的桌面便签软件,基于QT Qml实现,支持用户自定义便签列表

- 宣城市五险一金办事指南 .docx

- 数据分析-24-母婴产品电商可视化分析(包含代码数据)

- 江门市五险一金办事指南.docx

- 梅州市五险一金办事指南.docx

- 深圳市五险一金办事指南.docx

- 中山市五险一金办事指南.docx

信息提交成功

信息提交成功