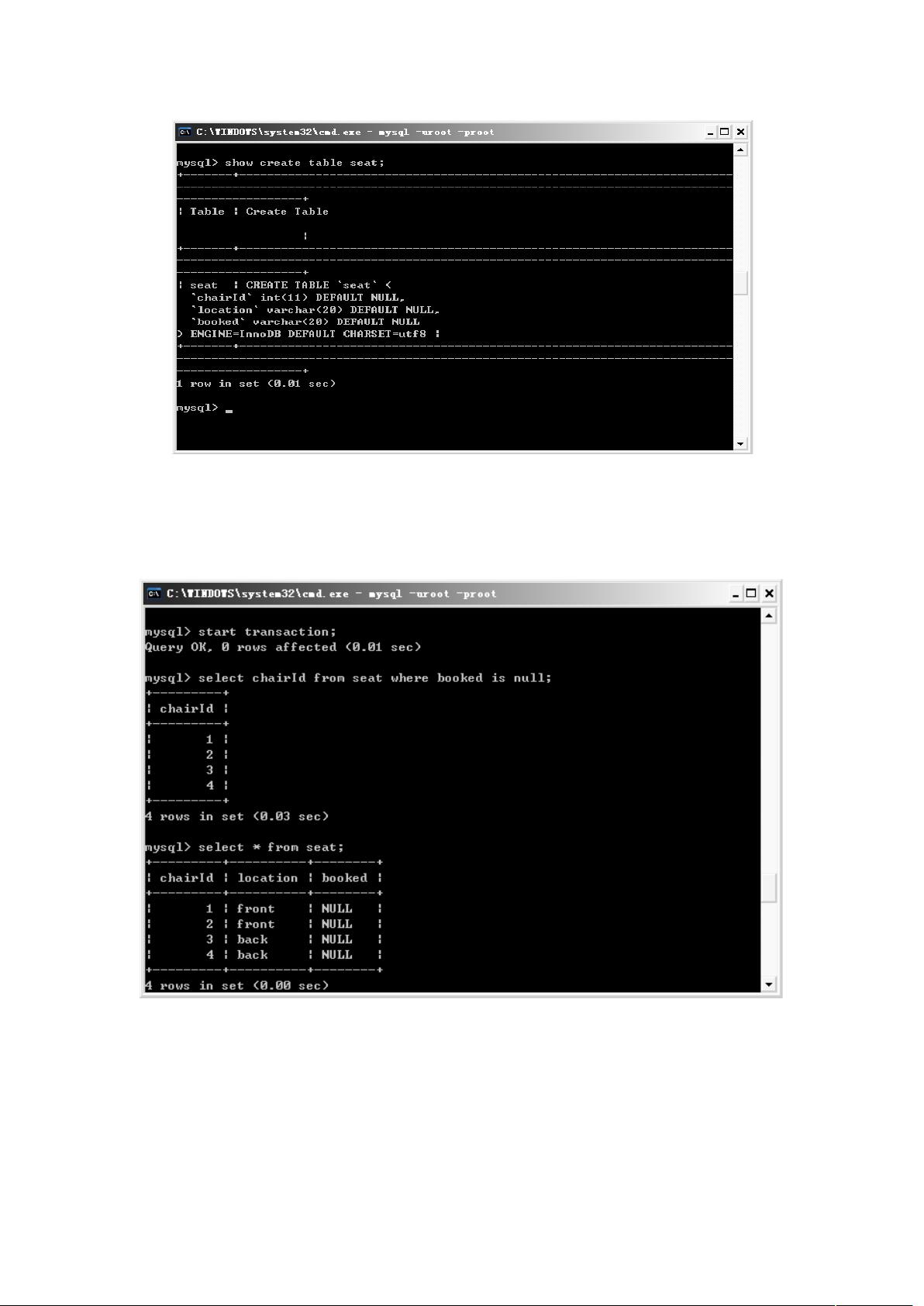

数据库加锁与性能分析是数据库管理中的核心议题,特别是在多用户并发访问的环境中。数据库作为一个共享资源,如何保证数据的一致性和事务的正确性至关重要。本文主要探讨了在单处理机和多处理机系统中数据库的并发执行方式,以及如何通过事务管理和锁机制来避免并发操作引发的数据不一致性问题。 事务是并发控制的基本单位,其ACID属性(原子性、一致性、隔离性、持久性)是确保数据完整性的基石。在实际开发中,程序员需要理解如何在SQL层面实现这些特性。本文作者通过使用MySQL、MS SQL Server、Oracle和PostgreSQL举例,详细讲解了并发操作可能导致的问题及其解决方案。 并发操作带来的数据不一致性主要包括丢失修改、不可重复读和脏读。丢失修改是指两个事务对同一数据进行更新,其中一个事务的更新被另一个事务覆盖。例如在火车站售票系统中,两个订票员同时尝试预订同一个座位,可能会导致其中一个订票操作丢失。解决这一问题通常有两种策略:一是提升事务隔离级别至Serializable,但这会牺牲性能;二是使用悲观锁,通过`SELECT ... FOR UPDATE`语句锁定要修改的数据,防止其他事务的并发修改。 不可重复读则涉及事务在不同时间读取相同数据得到不同结果的情况,包括幻影读。幻影读是指在同一事务中,多次读取相同条件的记录,但由于其他事务的插入或删除操作,导致读取的结果数量或内容发生变化。为避免幻影读,可以调整事务隔离级别,或者使用行级锁定,如在Oracle和MS SQL Server中,可以选择在特定范围内锁定数据。 脏读是指一个事务读取到了另一个事务未提交的修改,如果该事务回滚,那么脏读的数据就会变得无效。避免脏读通常通过设置事务隔离级别为Repeatable Read或更高来实现。 在实际应用中,选择合适的事务隔离级别和锁机制对于数据库性能和数据一致性至关重要。开发者需要根据系统的特性和需求权衡锁的粒度、事务的隔离级别以及可能产生的并发冲突,以达到最佳的系统性能和数据安全。在大数据集和高并发场景下,优化锁的使用和事务管理策略是性能调优的关键环节。 数据库加锁与性能分析是数据库管理员和开发者的必备知识,理解并熟练运用各种锁机制和事务处理策略,能够在保证数据一致性的同时,有效提升系统的并发处理能力和整体性能。

剩余9页未读,继续阅读

- 粉丝: 68

- 资源: 23

我的内容管理

展开

我的内容管理

展开

我的资源

快来上传第一个资源

我的资源

快来上传第一个资源

我的收益 登录查看自己的收益

我的收益 登录查看自己的收益 我的积分

登录查看自己的积分

我的积分

登录查看自己的积分

我的C币

登录后查看C币余额

我的C币

登录后查看C币余额

我的收藏

我的收藏  我的下载

我的下载  下载帮助

下载帮助

前往需求广场,查看用户热搜

前往需求广场,查看用户热搜最新资源

信息提交成功

信息提交成功