Prompt-Tuning:深度解读一种全新的微调范式

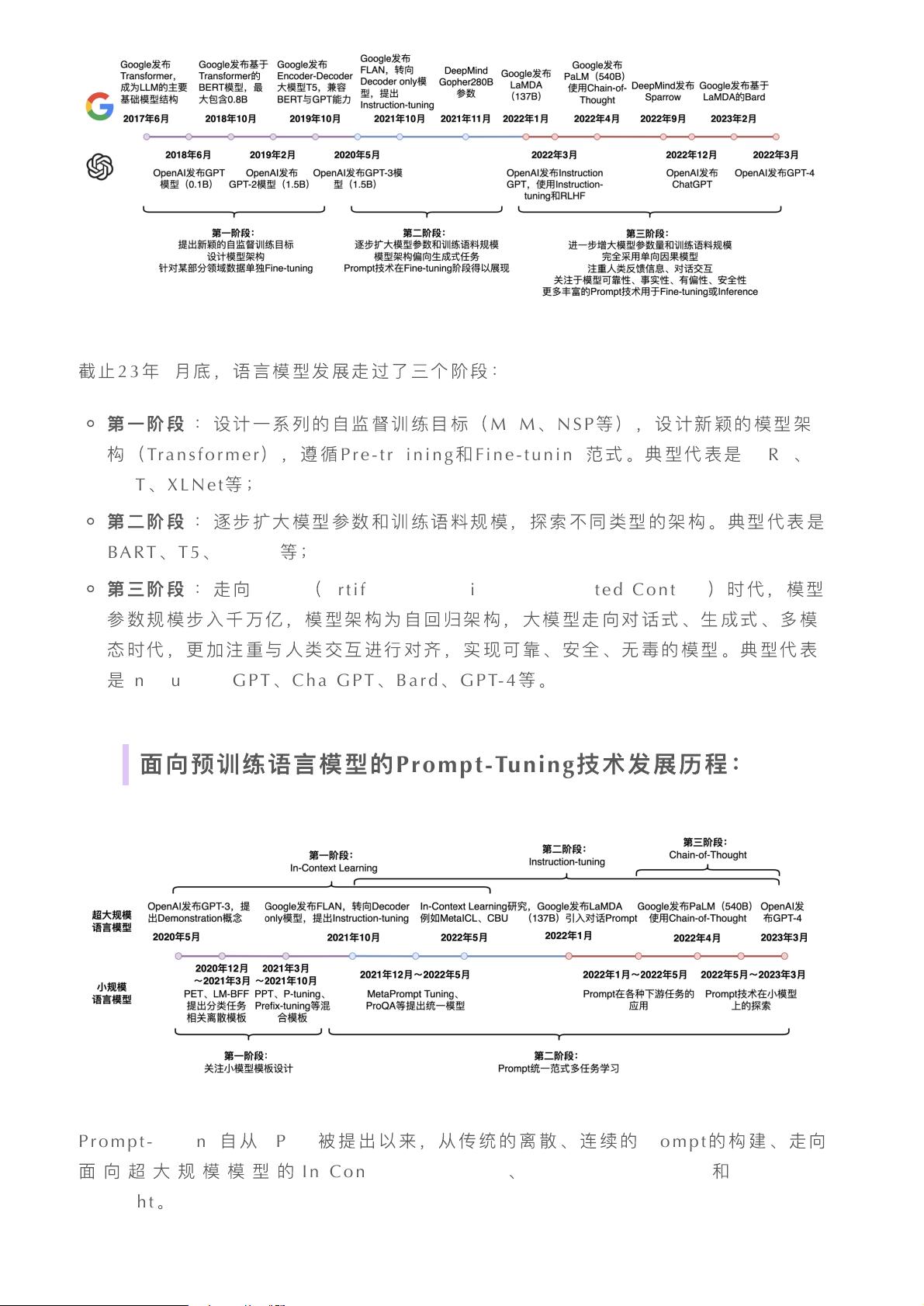

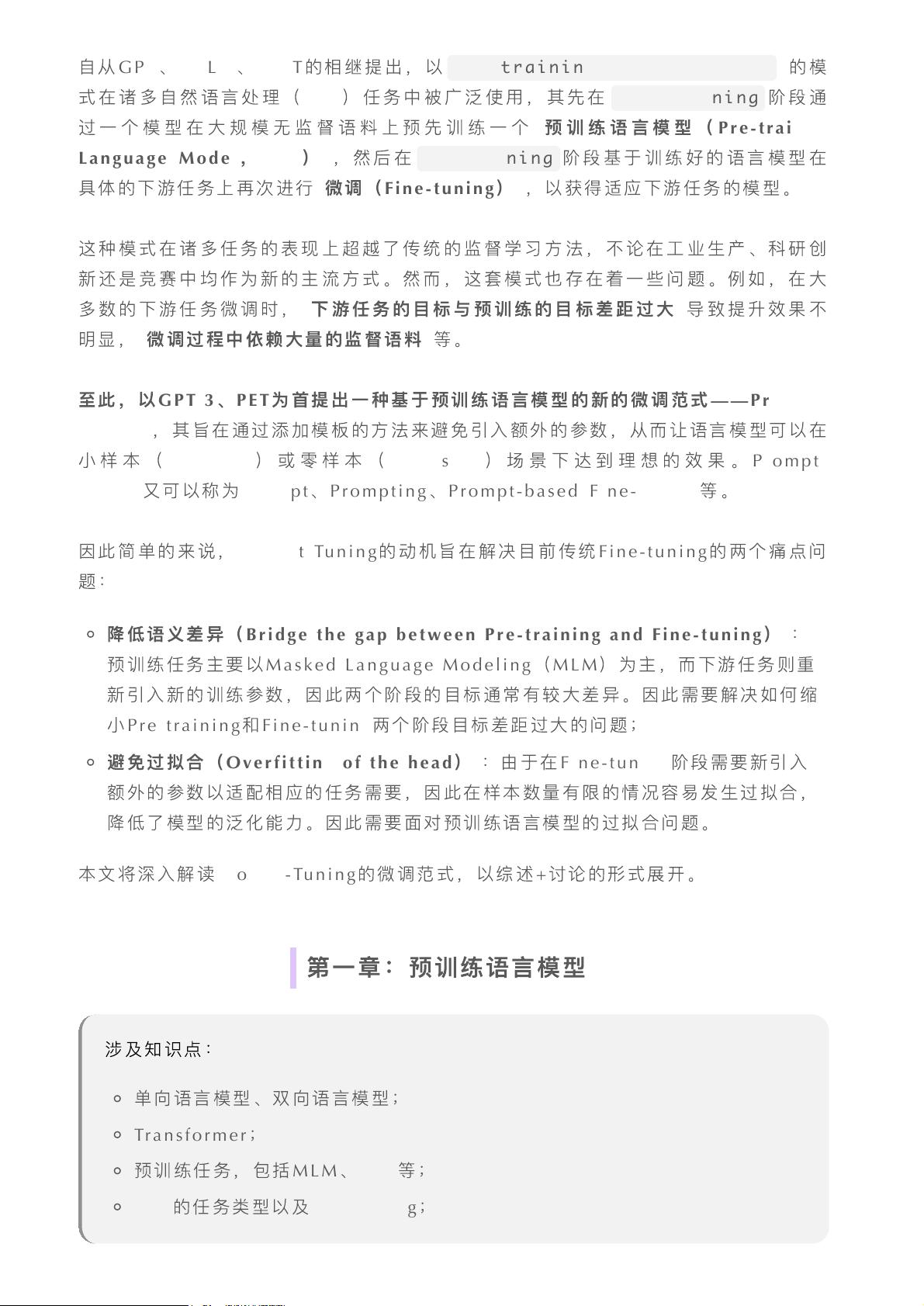

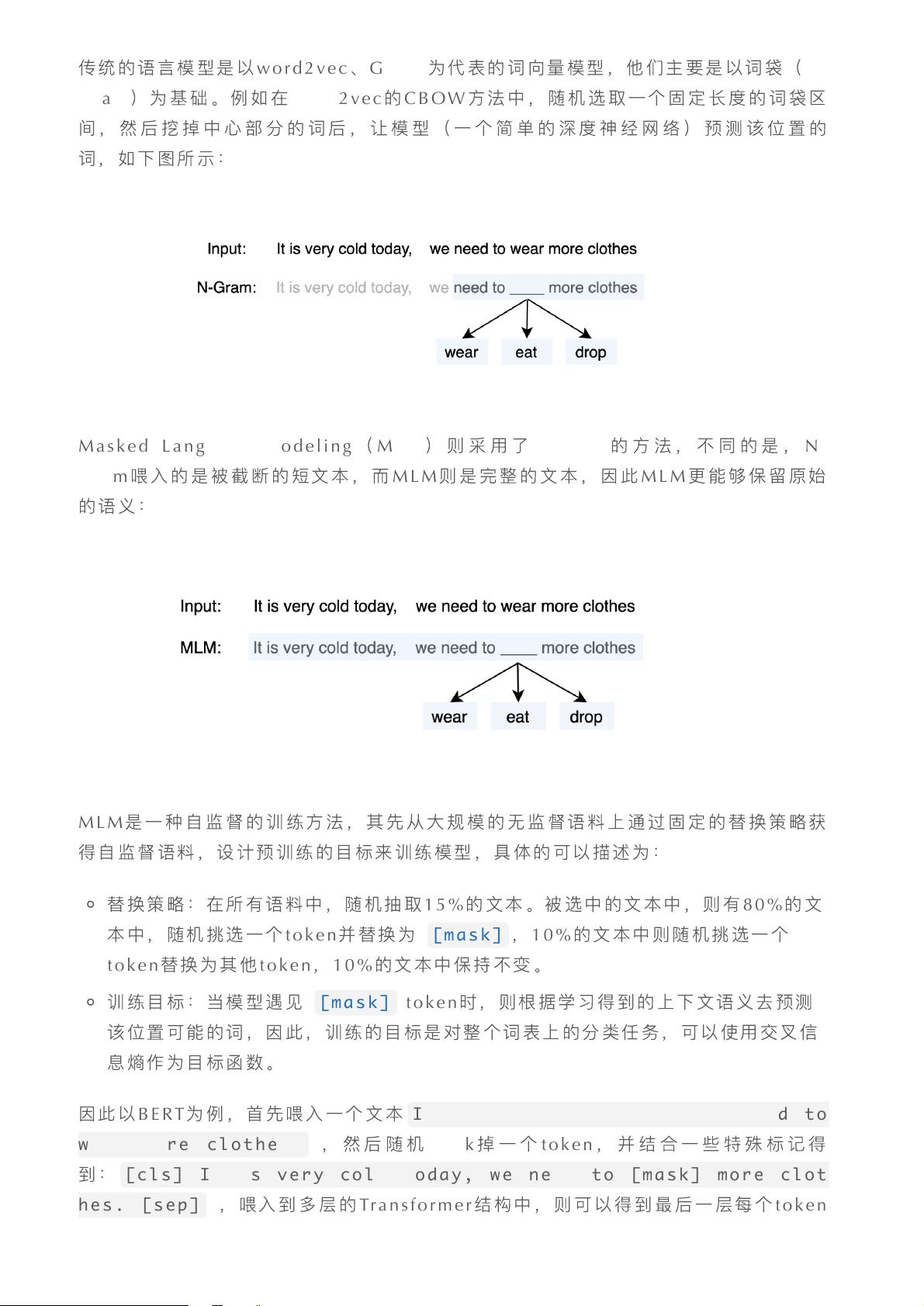

Prompt-Tuning是一种新兴的微调方法,它针对预训练语言模型(LLM)进行优化,以适应各种自然语言处理(NLP)任务。这一技术在人工智能生成内容(AIGC)时代尤其受到关注,因为超大规模模型如GPT-3等正逐渐成为对话式、生成式和多模态应用的核心。 预训练语言模型的发展经历了三个阶段。最初,模型通过自监督任务(如Masked Language Modeling, MLM和Next Sentence Prediction, NSP)进行预训练,例如BERT和GPT。接着,随着模型参数量和训练数据规模的扩大,出现了BART、T5等模型,它们探索了不同的架构类型。AIGC阶段,模型变得越来越大,如InstructionGPT、ChatGPT和GPT-4,它们强调与人类的交互,并致力于提供可靠、安全、无害的对话体验。 Prompt-Tuning起源于GPT-3,它尝试克服传统Fine-tuning的局限性。在传统Fine-tuning中,预训练模型在特定下游任务上微调时,需要大量监督数据,并且预训练和微调的目标之间可能存在显著差异。Prompt-Tuning通过引入“prompt”,即任务指令,来弥合这种差异。Prompt可以是离散的(如文本模板)或连续的(如嵌入向量),目的是让模型在少量样本或无样本的情况下理解并执行任务。 Prompt-Tuning有几种形式,包括In-Context Learning,其中模型在上下文中学习任务,通过观察示例输入和输出来推断任务模式。另一种是Chain-of-Thought,这种方法强调模型的推理过程,通过展示逻辑步骤帮助模型理解复杂任务。对于黑盒模型,prompt可以用来提供额外的上下文信息,帮助模型更好地理解和生成响应。 Prompt-Tuning的优势在于减少了对额外参数的需求,降低了训练成本,同时提高了模型在新任务上的泛化能力。它特别适用于处理超大规模模型,如GPT-3,这些模型的参数数量巨大,不适合传统的Fine-tuning方法。通过Prompt-Tuning,可以实现模型的高效利用,减少对大量标注数据的依赖,这对于资源有限的环境尤其有利。 随着研究的深入,Prompt的设计和选择成为关键问题。针对不同类型的NLP任务,可能需要设计特定的prompt结构和策略,以激发模型的潜在能力。此外,如何评估和优化prompt的有效性也是一个活跃的研究领域。 展望未来,Prompt-Tuning的研究将继续深化,可能的方向包括更智能的prompt生成、更有效的优化算法以及更广泛的适用场景。随着模型和算法的进步,prompt可能成为连接预训练模型与实际应用的重要桥梁,推动NLP领域的创新和发展。

剩余67页未读,继续阅读

- 粉丝: 0

- 资源: 5

我的内容管理

展开

我的内容管理

展开

我的资源

快来上传第一个资源

我的资源

快来上传第一个资源

我的收益 登录查看自己的收益

我的收益 登录查看自己的收益 我的积分

登录查看自己的积分

我的积分

登录查看自己的积分

我的C币

登录后查看C币余额

我的C币

登录后查看C币余额

我的收藏

我的收藏  我的下载

我的下载  下载帮助

下载帮助

前往需求广场,查看用户热搜

前往需求广场,查看用户热搜最新资源

- 培训效果评估调查问卷(修改版).docx

- 中国地级市CO2排放数据(2000-2023年).zip

- 基于MicroPython在ESP32上用TFT-LCD-ST7735显示图像

- 北大纵横—江西泓泰—1201人力资源管理概论培训.ppt

- 北大纵横—江西泓泰—泓泰培训制度-FINAL.doc

- 北大纵横—江西泓泰—江西泓泰工作分析培训报告-final.ppt

- 北大纵横—江西泓泰—人力资源规划制度培训.ppt

- 北大纵横—江西泓泰—瑞兴管理思想培训.ppt

- 北大纵横—江西泓泰—瑞兴人力资源管理培训-招聘和发展.ppt

- 北大纵横—江西泓泰—瑞兴人力资源管理培训-培训.ppt

- 北大纵横—金瀚—冬映红培训制度-0621.doc

- 北大纵横—金瀚—福科多培训制度-0621.doc

- 北大纵横—金瀚—金瀚集团全面预算管理培训报告.ppt

- 北大纵横—金瀚—培训制度-0618.doc

- 北大纵横—金瀚—全面预算管理培训-word.doc

- 2022-2023年度广东省职校信息安全管理与评估竞赛试题解析

信息提交成功

信息提交成功