datastage入门教程.docx

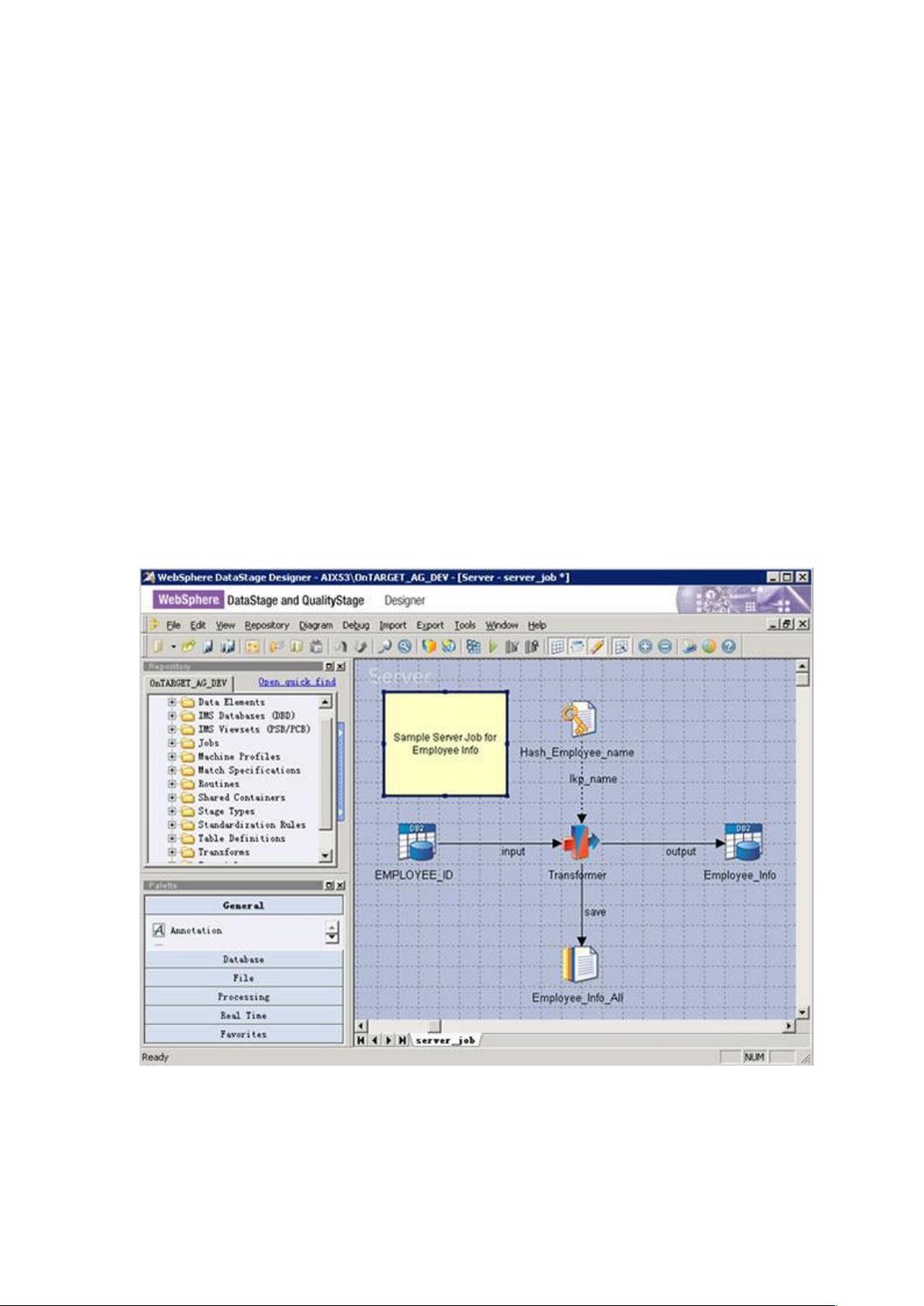

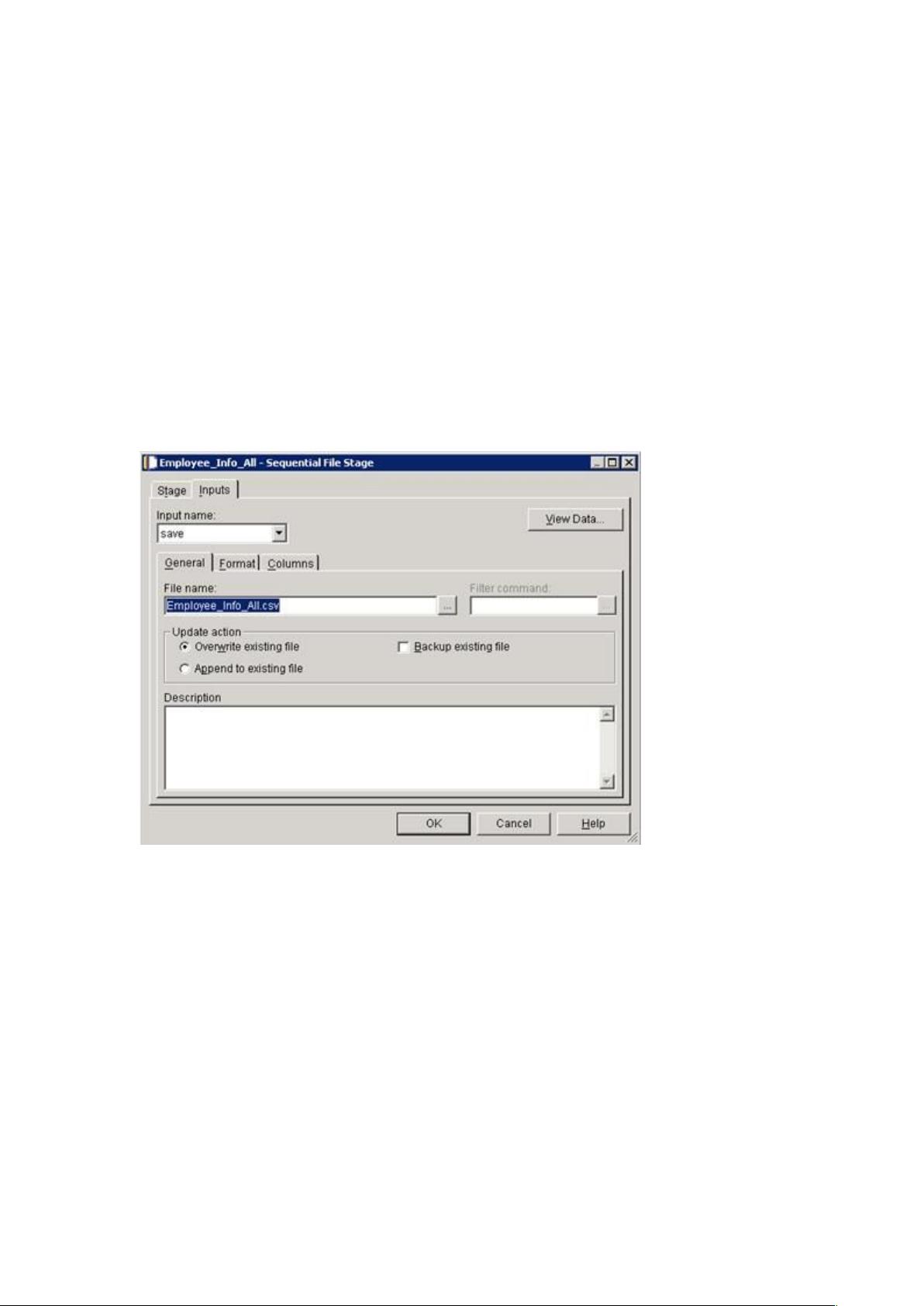

DataStage 使用了 Client-Server 架构,服务器端存储所有的项目和元数据,客户端 DataStage Designer 为整个 ETL 过程提供了一个图形化的开发环境,用所见即所得的方式设计数据的抽取清洗转换整合和加载的过程。 DataStage 是一款强大的数据集成工具,它采用 Client-Server 架构来管理和处理 ETL(Extract, Transform, Load)过程。在 DataStage 中,服务器端存储所有项目和元数据,而客户端的 DataStage Designer 提供了一个图形化界面,使得用户能够以直观的“所见即所得”方式设计数据抽取、清洗、转换、整合和加载的流程。 DataStage 的核心运行单元是 Job,分为 Server Job、Parallel Job 和 Mainframe Job。Server Job 是最基本的 Job 类型,适合初学者和简单的 ETL 需求。用户在 Designer 中可以拖放 Stage 到工作区,并通过连接线来定义数据流。Server Job 允许用户定义数据抽取规则、数据流程、数据集合、数据转换、数据约束、数据聚合和数据写入。这种方式使非程序员也能轻松设计复杂的 ETL 工作流。 Parallel Job 在 Server Job 的基础上增加了并行处理能力,尤其在多节点环境中,能显著提高数据处理速度。它包含更多种类的 Stage,但使用上可能有更严格的限制。Sequence Job 则用于协调多个 Job 的执行顺序,通过图形化方式定义 Job 间的逻辑关系和错误处理策略。 DataStage 支持多种数据源的连接,包括但不限于文本文件、XML 文件、企业应用(如 SAP、PeopleSoft 等)、各种数据库系统(如 DB2、Oracle、SQL Server 等)、Web 服务、SAS 和 WebSphere MQ。这种广泛的数据源支持使得 DataStage 成为了一个强大的数据整合平台。 在 Server Job 中,Stage 是构建 Job 的基础组件。Stage 主要有五类:General、Database、File、Processing 和 Real Time。例如,Sequential File Stage 用于处理顺序文件,用户需要指定文件路径、文件格式、列定义和写入类型(覆盖或追加)。而 Hash File Stage 用于创建基于主键的哈希文件,用于高效的数据查找,特别适用于参考查找场景。 DataStage 提供了一个强大的环境,让数据工程师能够高效地管理复杂的数据整合任务,同时通过其丰富的 Stage 类型和灵活的 Job 设计,满足了不同级别的数据处理需求。对于初学者来说,理解 Server Job 和 Parallel Job 的区别以及如何配置 Stage 是入门的关键。随着经验的积累,可以进一步探索更高级的特性,如并行处理和数据源的灵活利用,以优化整体的 ETL 效率。

剩余23页未读,继续阅读

- 粉丝: 1

- 资源: 2

我的内容管理

展开

我的内容管理

展开

我的资源

快来上传第一个资源

我的资源

快来上传第一个资源

我的收益 登录查看自己的收益

我的收益 登录查看自己的收益 我的积分

登录查看自己的积分

我的积分

登录查看自己的积分

我的C币

登录后查看C币余额

我的C币

登录后查看C币余额

我的收藏

我的收藏  我的下载

我的下载  下载帮助

下载帮助

前往需求广场,查看用户热搜

前往需求广场,查看用户热搜最新资源

信息提交成功

信息提交成功