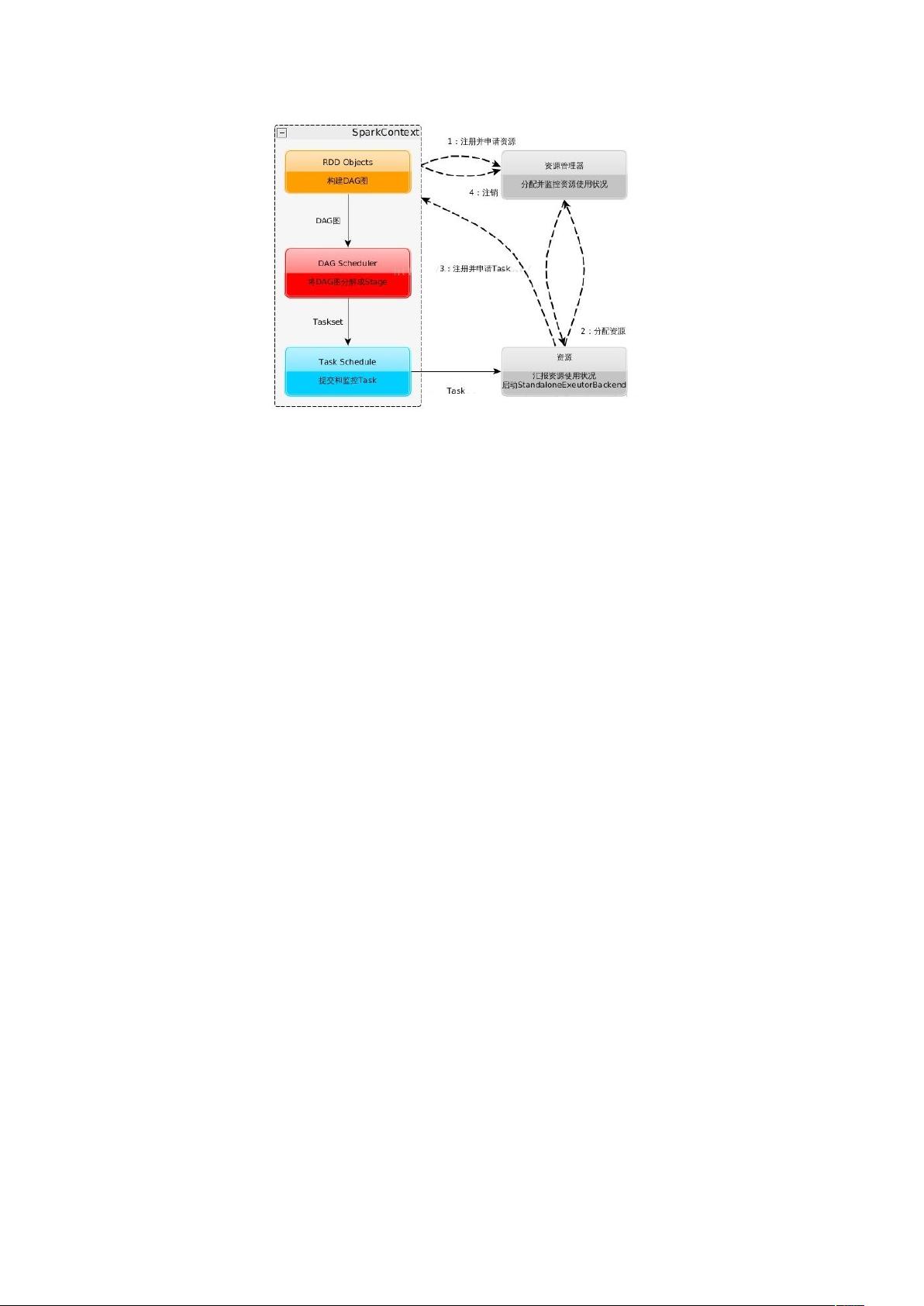

本次作业要完成在Hadoop平台搭建完成的基础上,利用Spark组件完成文本词频统计的任务,目标是学习Scala语言,理解Spark编程思想,基于Spark 思想,使用IDEA编写SparkWordCount程序,并能够在spark-shell中执行代码和分析执行过程。 【Spark技术实践——词频统计】在大数据领域,Spark作为一种高效的数据处理框架,以其快速、通用和可扩展性而受到广泛关注。本实践旨在基于已经搭建的Hadoop平台,利用Spark组件进行文本词频统计,以此深入理解Scala语言,并掌握Spark编程思想。 **一、Spark核心特性** Spark的核心在于其内存计算模型,它能够在内存中存储中间结果,避免频繁读写硬盘,极大地提高了数据处理速度。此外,Spark与Scala的紧密结合使得开发更为便捷,开发者可以像处理本地集合一样处理分布式数据集。Spark还支持多种工作模式,如Standalone、Mesos和Yarn,可以根据需求选择资源管理器。 **二、Spark运行流程** 1. **初始化SparkContext**:这是Spark应用程序的入口点,用于建立与Spark集群的连接。 2. **申请Executor资源**:SparkContext向资源管理器申请Executor资源,Executor是执行任务的工作节点。 3. **分配Task**:SparkContext将应用程序拆分为Task,并提交给Task Scheduler。 4. **DAG与Stage构建**:Spark会根据操作构建有向无环图(DAG),并将DAG划分为Stage,便于并行处理。 5. **Task执行**:Task Scheduler将Task发送给Executor执行,Executor在内存中处理数据。 6. **资源释放**:任务完成后,Executor释放资源,整个过程高效且灵活。 **三、Spark组件** 1. **Spark Core**:基础组件,提供RDD(弹性分布式数据集)和操作接口。 2. **Spark SQL**:允许通过SQL或HiveQL进行数据查询,将数据库表抽象为RDD。 3. **Spark Streaming**:处理实时数据流,支持连续计算和微批处理。 4. **MLlib**:包含各种机器学习算法,如分类、回归,适合大规模数据集的迭代运算。 5. **GraphX**:用于图计算,提供图操作和算法。 **四、实践步骤** 1. **环境准备**:安装Java、Scala、Python和IPython,确保基础环境满足要求。 2. **Spark安装**:下载合适的Spark版本,解压并移动到指定目录。 3. **编写SparkWordCount**:使用Scala在IDEA中编写Spark程序,实现词频统计功能。 4. **执行与分析**:在spark-shell中运行程序,观察执行过程,理解Spark如何处理数据。 **五、数据集说明** 本实践使用的数据集是一个小规模的文本数据,包含多行文本,如"How nice I love Spark I love Hadoop How good Hadoop is good Spark is fast"。通过Spark进行词频统计,可以找出数据集中出现最频繁的词语。 总结来说,Spark的词频统计实践涵盖了从环境配置、Spark应用开发到实际执行的全过程。通过这一实践,不仅可以深入理解Scala编程,还能掌握Spark的核心机制和分布式计算的思想,为后续的大数据处理项目奠定坚实的基础。同时,Spark的高效性和易用性使其成为大数据处理领域的重要工具,尤其在需要迭代计算和实时流处理的场景中,Spark的优势更为明显。

剩余13页未读,继续阅读

行走的瓶子Yolo2023-07-25这篇文章对Spark词频统计进行了详实的描述,并提供了一些实战案例,非常值得一读。

行走的瓶子Yolo2023-07-25这篇文章对Spark词频统计进行了详实的描述,并提供了一些实战案例,非常值得一读。 会飞的黄油2023-07-25作者深入浅出地阐述了Spark词频统计的原理和应用场景,对于新手来说也很友好。

会飞的黄油2023-07-25作者深入浅出地阐述了Spark词频统计的原理和应用场景,对于新手来说也很友好。 黄涵奕2023-07-25该文件的解释清晰,图文并茂,让人容易理解和跟随操作步骤。

黄涵奕2023-07-25该文件的解释清晰,图文并茂,让人容易理解和跟随操作步骤。 十二.122023-07-25文章的观点中肯,结合实际情况讲解了大数据技术中Spark词频统计的重要性。

十二.122023-07-25文章的观点中肯,结合实际情况讲解了大数据技术中Spark词频统计的重要性。 罗小熙2023-07-25这篇文件对Spark词频统计进行了实践,内容丰富,给予了很多有用的示例。

罗小熙2023-07-25这篇文件对Spark词频统计进行了实践,内容丰富,给予了很多有用的示例。

- 粉丝: 5

- 资源: 1

我的内容管理

展开

我的内容管理

展开

我的资源

快来上传第一个资源

我的资源

快来上传第一个资源

我的收益 登录查看自己的收益

我的收益 登录查看自己的收益 我的积分

登录查看自己的积分

我的积分

登录查看自己的积分

我的C币

登录后查看C币余额

我的C币

登录后查看C币余额

我的收藏

我的收藏  我的下载

我的下载  下载帮助

下载帮助

前往需求广场,查看用户热搜

前往需求广场,查看用户热搜最新资源

- 基于二阶自抗扰ADRC的轨迹跟踪控制,对车辆的不确定性和外界干扰具有一定抗干扰性,基于carsim和simulink仿真 跟踪轨迹为双移线,效果良好,有对应复现资料,是学习自抗扰技术快速入门很好的资料

- 基于python的网页自动化工具项目全套技术资料100%好用.zip

- MATLAB【逆变器二次调频模型】 微电网分布式电源逆变器DROOP控制二次调频模型,加入二次控制实现二次调频控制,及二次调压控制,程序可实现上图功能,工况有所改变 需要matlab2021A版

- 抢购软件:快速复制信息

- 单机无穷大系统发生各类(三相短路,单相接地,两相接地,两相相间短路)等短路故障,各类(单相断线,两相断线,三相断线)等断线故障,暂态稳定仿真分析

- 微信文章爬虫项目全套技术资料100%好用.zip

- 基于动态窗口算法的AGV仿真避障 可设置起点目标点,设置地图,设置移动障碍物起始点目标点,未知静态障碍物 动态窗口方法(DynamicWindowApproach) 是一种可以实现实时避障的局部规划算

- Power Quality Disturbance:基于MATLAB Simulink的各种电能质量扰动仿真模型,包括配电线路故障、感应电机启动、变压器励磁、单相 三相非线性负载等模型,可用于模拟各种

- 数据爬虫项目全套技术资料100%好用.zip

- 聊天系统项目全套技术资料100%好用.zip

信息提交成功

信息提交成功