信息论是一门研究信息传输、处理和传输中的基本问题的科学,其理论基础主要由克劳德·香农在20世纪40年代末奠定。信息论的核心概念包括信息量、熵、信道容量、编码定理等。以下是根据上述内容提供的知识点。

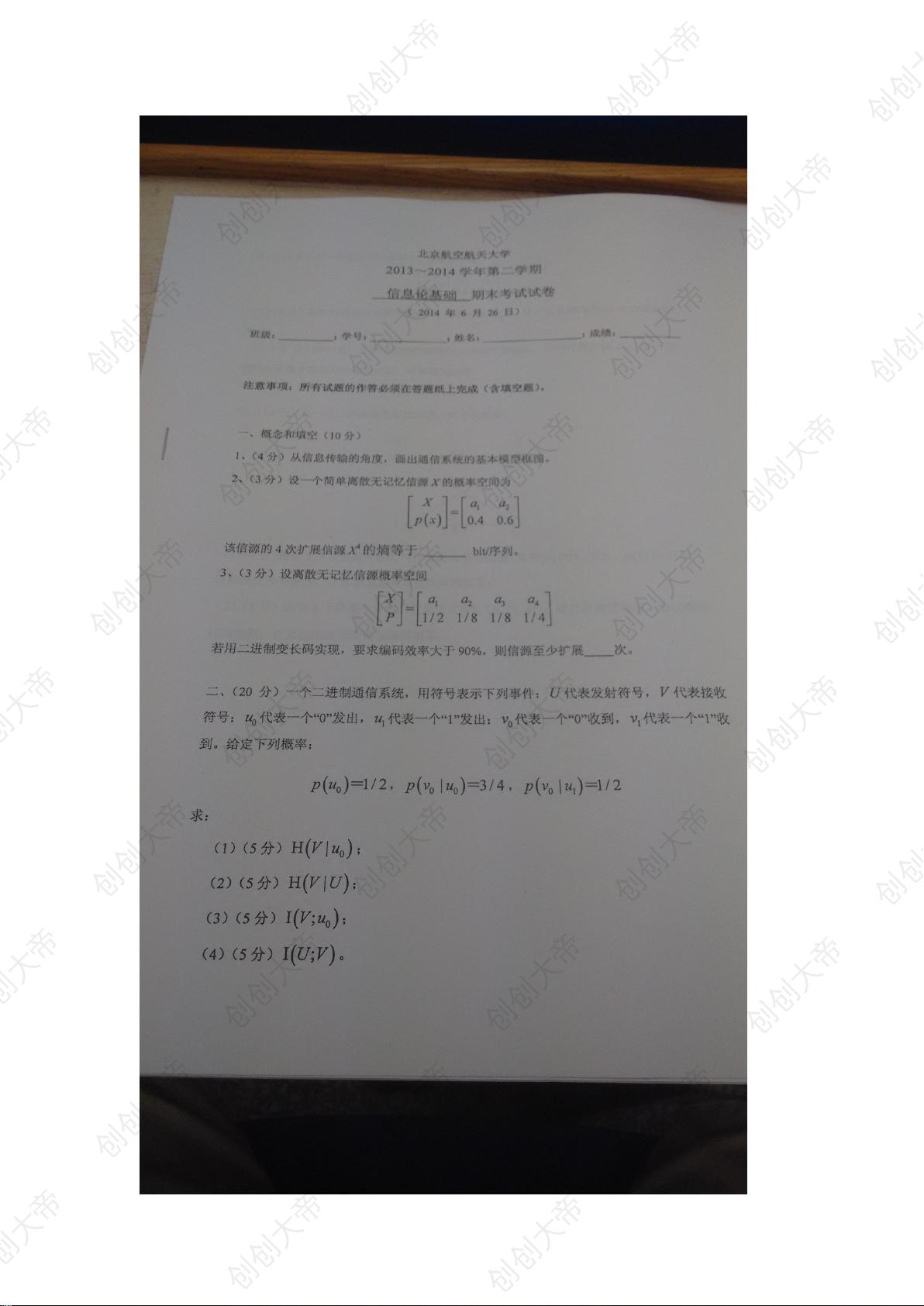

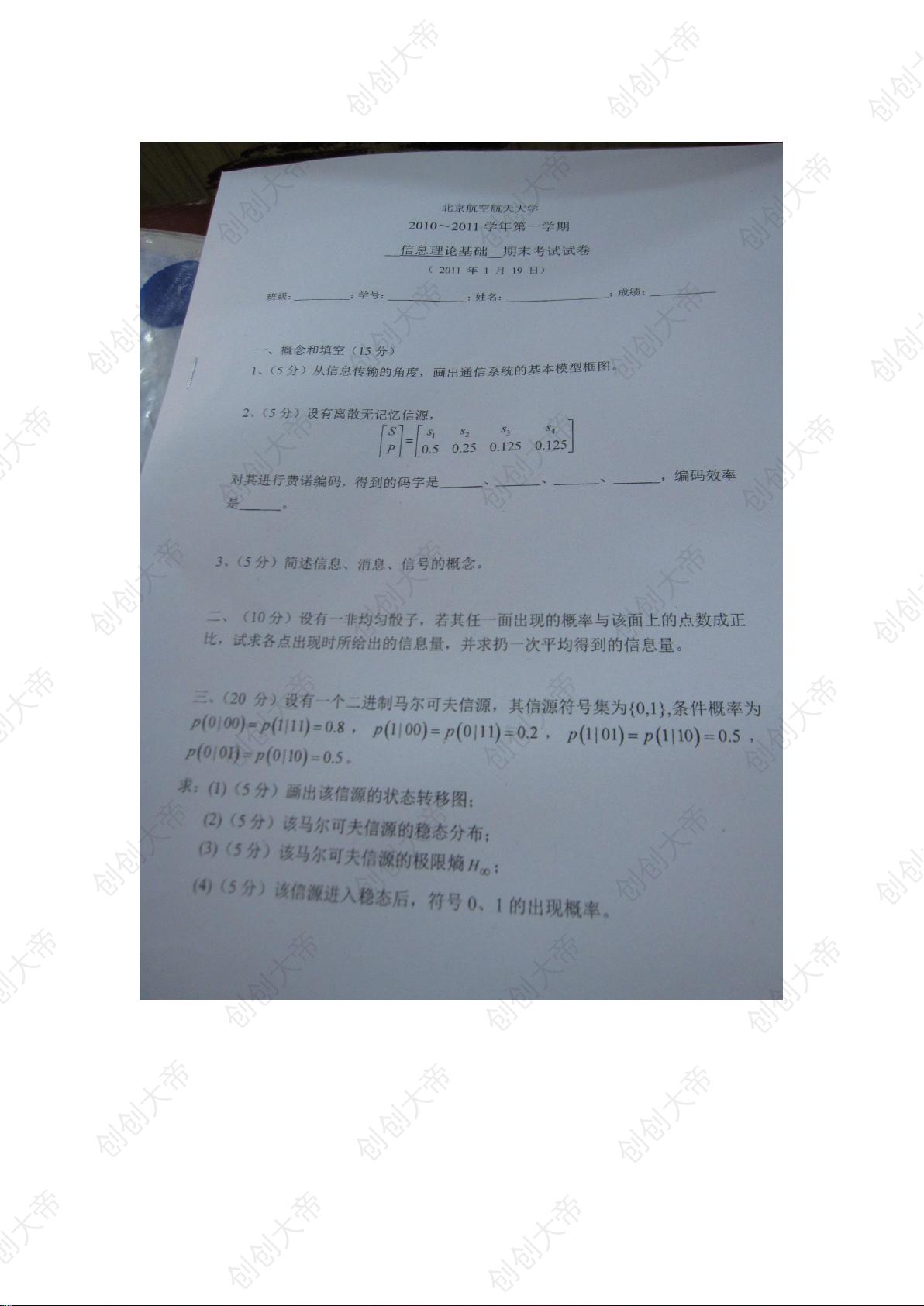

1. 通信系统的基本模型

通信系统的基本模型主要包括信源、信宿、编码器、信道、译码器、噪声源和反馈信息等部分。信源产生原始信息,编码器将信息转换为适合传输的形式,信道是信息传输的媒介,译码器则将传输的信息还原成原始信号,噪声源对传输过程中的信号产生干扰。

2. 信息的概念及特点

信息是指能够消除接收者不确定性的东西。信息的特点通常包括冗余性、可压缩性、可编码性等。冗余性是指信息中存在一定的可预测部分,可压缩性是指信息在不损失其本质特征的情况下可以被更简洁地表示,可编码性是指信息能够被转换成某种形式的信号以在通信系统中传输。

3. 信息、消息及信号三者之间的联系与区别

信息、消息和信号是通信过程中密切相关但又有所区别的概念。信息是指抽象的含义或知识内容,消息是信息的物理载体,是信息的具体表现形式,而信号则是消息的电信号或光信号形式,是在信道中传输的实体。

4. 数据处理定理的内容及其意义

数据处理定理主要说明了在消息传递过程中,不能无损地压缩信息而不损失某些内容。该定理的数学表述通常与熵有关,指出对于一个信道来说,输入的熵是大于或等于输出的熵减去信道的互信息量的。

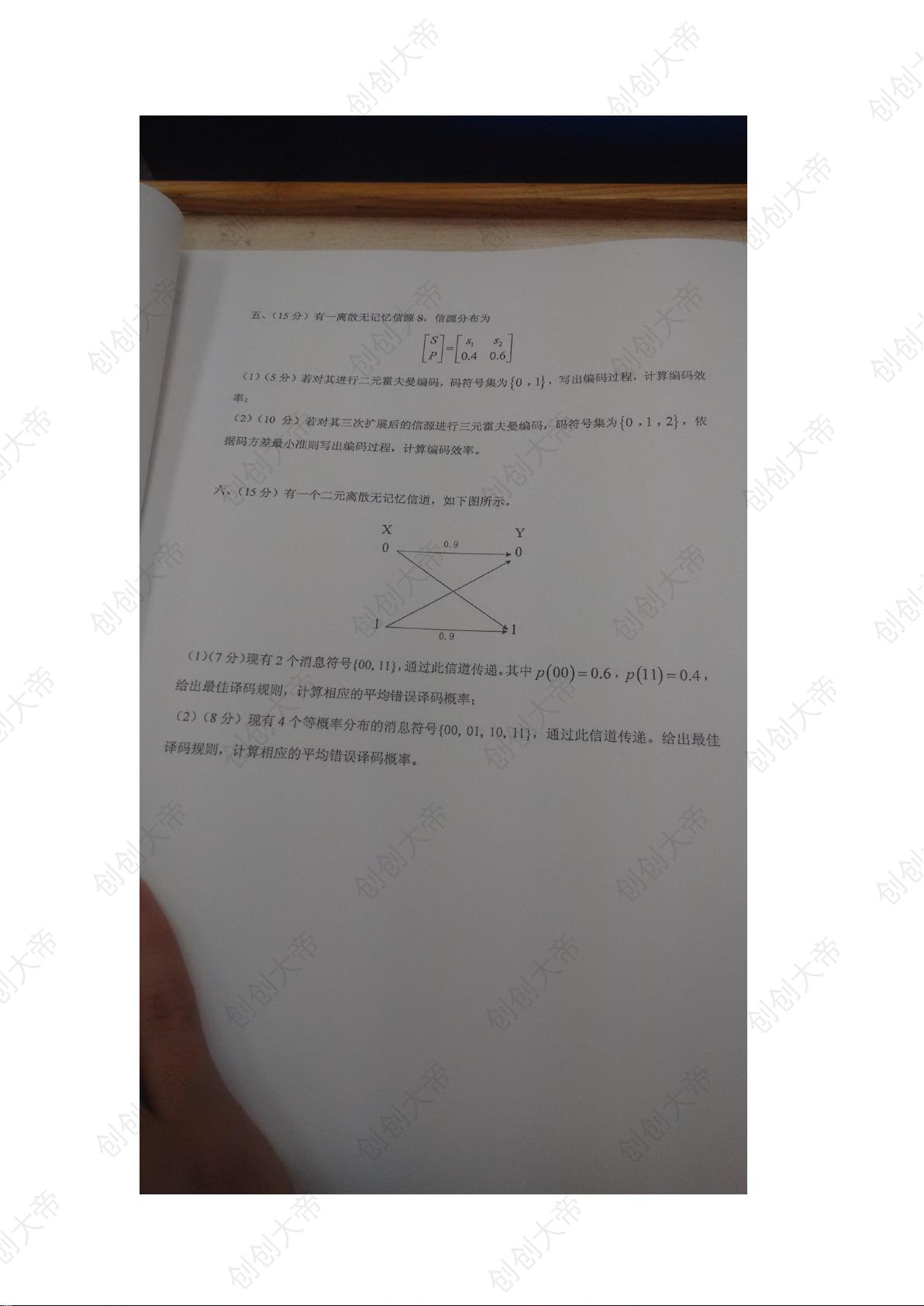

5. 香农第一定理(信道编码定理)

香农第一定理主要描述了在给定的通信信道中,存在一种编码方式,使得信息传输速率接近于信道容量而不产生错误。该定理说明了在有噪声的信道中,只要传输速率不超过信道容量,就可以通过适当的编码实现无差错的通信。

6. 学习信息论课程的体会

学生可以根据自身对信息论课程的学习体会,从理论知识掌握、问题解决能力、课程的趣味性、实用性和对未来职业的指导作用等方面进行谈论。

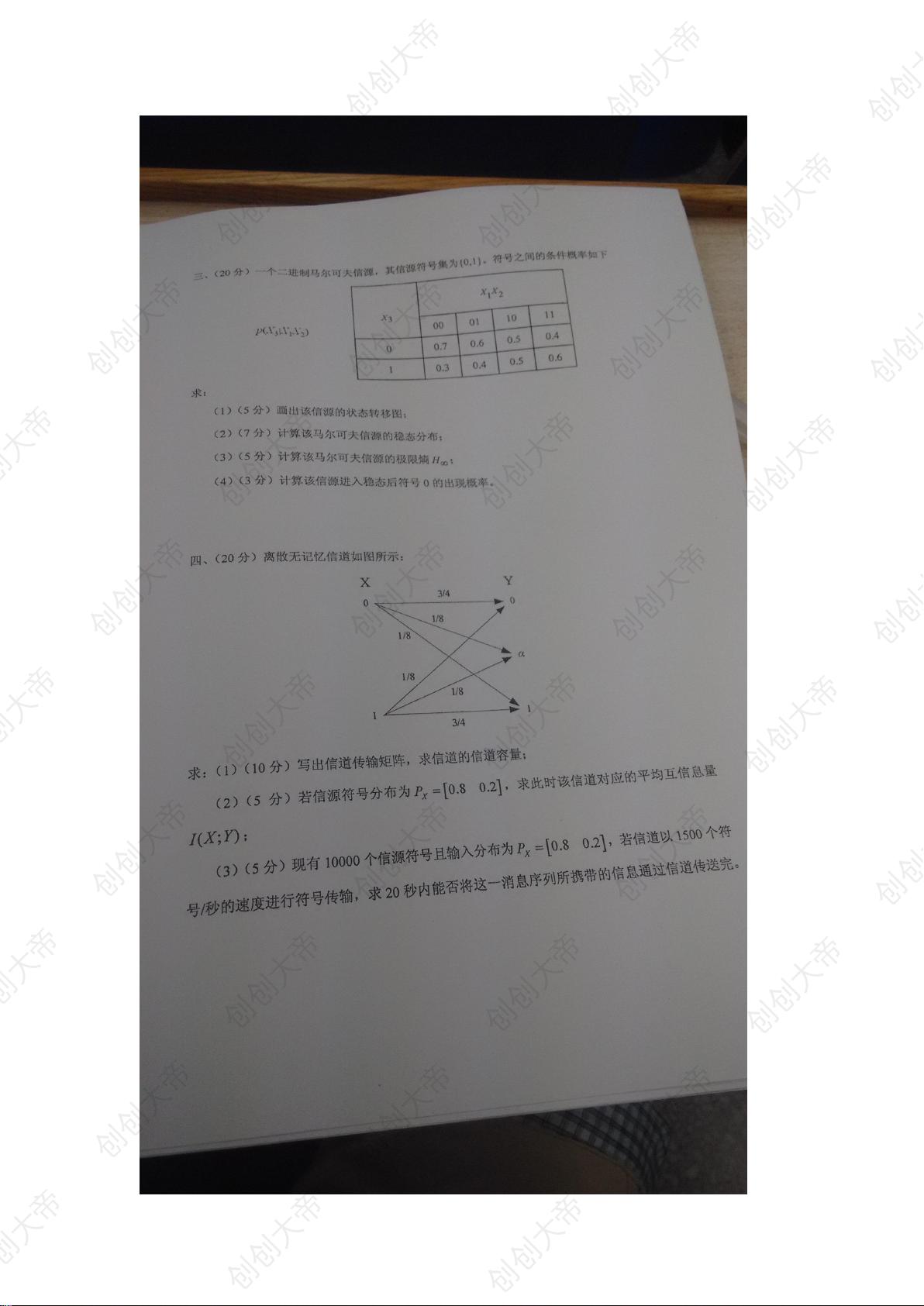

计算题涉及了多个核心概念的应用,包括:

- 熵(Entropy)H(X),是衡量信源不确定性的度量,是信息论中的一个基本概念,其值越大,信源的不确定性越大。

- 条件熵H(X|Y),指的是在已知接收端接收到的信号Y的条件下,信源产生的信息的平均不确定性。

- 互信息量I(X;Y),表示信源和信宿之间的信息共享量,即信宿能够从接收信号中获得关于信源消息的多少信息。

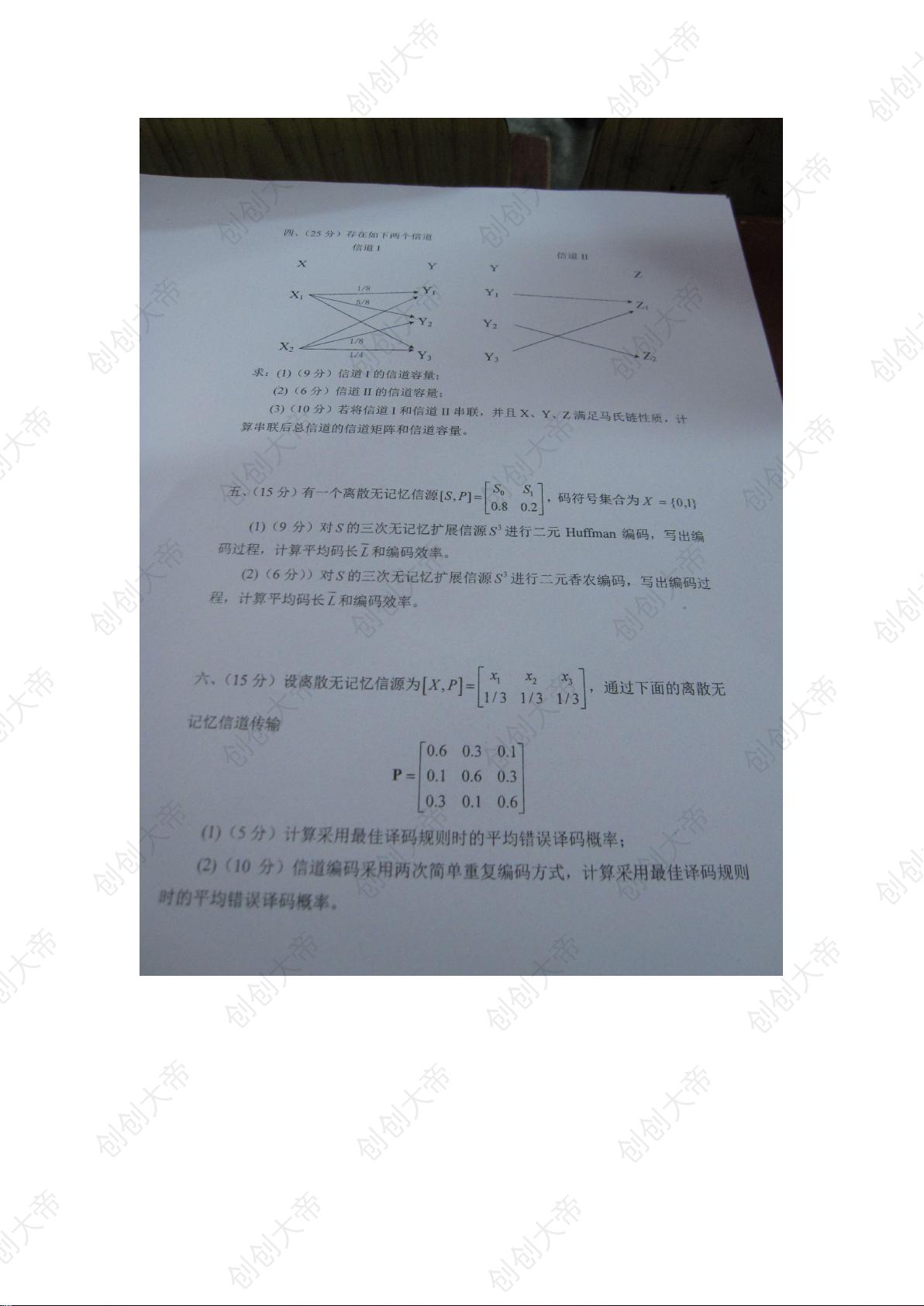

- 信道容量C,是信道能传输的最大信息速率,不能超过信道容量的限制来传输信息。

这些知识点在具体问题中应用时,需要利用概率论和数理统计的方法进行定量计算,解决通信中的具体问题。例如,在计算给定二进制离散信道的信息传输率时,需要用到信道容量公式C = max p(x) ∑_y p(y|x) log_2(1/p(y|x)),其中p(x)是输入概率分布,p(y|x)是在给定输入x的情况下输出y的概率。

计算题部分还涉及到了马尔可夫链和Huffman编码等概念。马尔可夫链是一种随时间变化的随机过程,其未来状态的概率分布只依赖于当前状态,而与过去的状态无关。Huffman编码是一种根据信源符号出现的概率来进行优化的变长编码方法,它能够有效地减少平均码长,并使得整体通信更为高效。

对于信息论的学习,学生不仅需要掌握上述理论知识点,还应学习如何将理论应用于实际问题中,例如如何设计高效的编码方案,如何计算和优化通信信道的传输速率,以及如何在噪声干扰下保证信息的准确传输等。

- 1

- 2

- 3

- 4

- 5

- 6

前往页