《动手学习深度学习》之二:注意力机制和Seq2seq模型(打卡2.2)

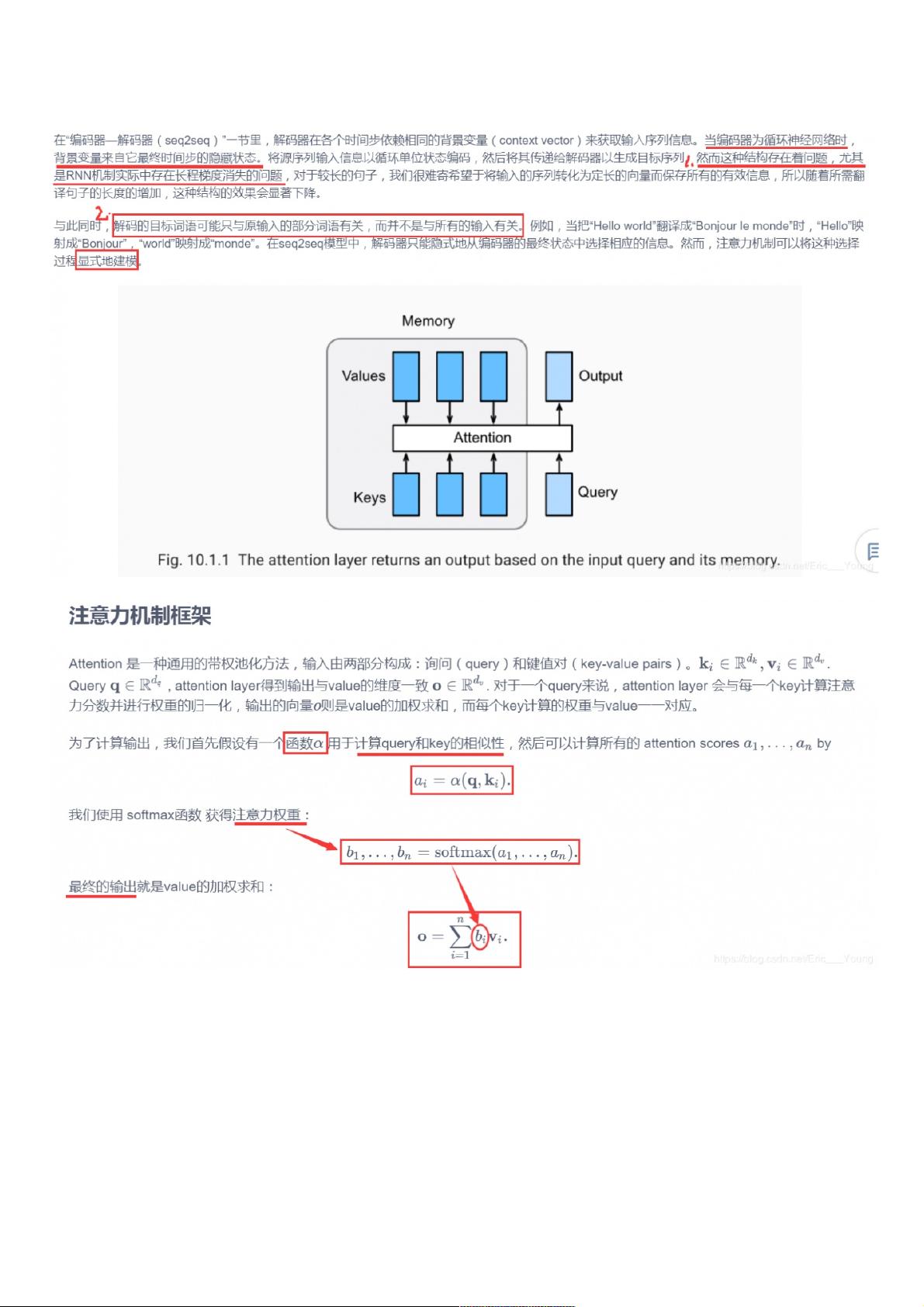

2.注意力机制和Seq2seq模型 2.1.注意力机制 2.1.1.概念 2.1.2.框架 •不同的attetion layer的区别在于score函数的选择,在本节的其余部分,我们将讨论两个常用的注意层 Dot-product Attention 和 Multilayer Perceptron Attention;随后我们将实现一个引入attention的seq2seq模型并在英法翻译语料上进行训练与测试。 import math import torch import torch.nn as nn import os def file_name_walk(file_dir): 在深度学习领域,注意力机制(Attention Mechanism)和Seq2seq模型是两个关键的概念,尤其在自然语言处理(NLP)任务中发挥着重要作用。本文将深入探讨这两个主题,并通过实际代码实现来加深理解。 注意力机制是解决传统RNN(循环神经网络)和CNN(卷积神经网络)中信息丢失问题的一种方法。在传统的序列到序列模型中,整个输入序列被编码为一个固定长度的向量,这可能导致关键信息的丢失。注意力机制允许模型在解码过程中动态地“关注”输入序列的特定部分,而不是仅仅依赖于全局编码。 2.1.1 注意力机制的概念: 注意力机制的核心思想是,对于解码过程中的每个时间步,模型不仅基于前一时刻的隐藏状态,还会根据输入序列的不同部分计算权重,这些权重反映了模型对不同部分的关注程度。通过这种方式,模型可以更加灵活地处理长序列信息,尤其是在翻译、问答等任务中。 2.1.2 注意力机制的框架: 常见的注意力层包括点积注意力(Dot-product Attention)和多层感知机注意力(Multilayer Perceptron Attention)。点积注意力计算查询(query)、键(key)和值(value)之间的相似度,然后通过softmax函数转换为权重,用于加权求和得到上下文向量。多层感知机注意力则引入了额外的神经网络层来计算得分,增加了模型的表达能力。 在点积注意力的实现中,我们通常会使用dropout层来防止过拟合,同时处理有效长度(valid_length)以排除填充(padding)位置的干扰。在代码中,`SequenceMask` 函数用于创建掩码,确保在softmax计算时不考虑填充元素。`masked_softmax` 则是在softmax函数基础上添加了掩码操作,确保只对有效元素进行softmax计算。 以下是一个简化的点积注意力层的定义: ```python class DotProductAttention(nn.Module): def __init__(self, dropout, **kwargs): super(DotProductAttention, self).__init__(**kwargs) self.dropout = nn.Dropout(dropout) def forward(self, query, key, value, valid_length=None): d = query.shape[-1] scores = torch.bmm(query, key.transpose(1, 2)) / math.sqrt(d) attention_weights = masked_softmax(scores, valid_length) return torch.bmm(attention_weights, value) ``` Seq2seq模型结合了编码器(Encoder)和解码器(Decoder),其中编码器将输入序列转化为上下文向量,解码器则根据上下文向量生成目标序列。引入注意力机制后,解码器在每个时间步不仅依赖于上下文向量,还根据输入序列动态生成注意力权重。 在实际应用中,例如英法翻译任务,我们可以构建一个包含注意力机制的Seq2seq模型,对训练数据进行训练,并在测试集上评估其性能。训练过程通常涉及优化损失函数,如交叉熵损失,并使用反向传播更新模型参数。 总结来说,注意力机制和Seq2seq模型是深度学习中处理序列数据的关键技术。通过注意力机制,模型能够更有效地处理长序列信息,提高解码的准确性和效率。而Seq2seq模型则提供了一种结构化的方法来从源序列生成目标序列,特别适用于机器翻译、对话系统等任务。通过实际编程实践,我们可以更好地理解和掌握这些概念。

- 粉丝: 5

- 资源: 909

我的内容管理

展开

我的内容管理

展开

我的资源

快来上传第一个资源

我的资源

快来上传第一个资源

我的收益 登录查看自己的收益

我的收益 登录查看自己的收益 我的积分

登录查看自己的积分

我的积分

登录查看自己的积分

我的C币

登录后查看C币余额

我的C币

登录后查看C币余额

我的收藏

我的收藏  我的下载

我的下载  下载帮助

下载帮助

前往需求广场,查看用户热搜

前往需求广场,查看用户热搜最新资源

信息提交成功

信息提交成功

评论0