《动手学深度学习——机器翻译及相关技术,注意力机制与seq2seq模型,Transformer》笔记

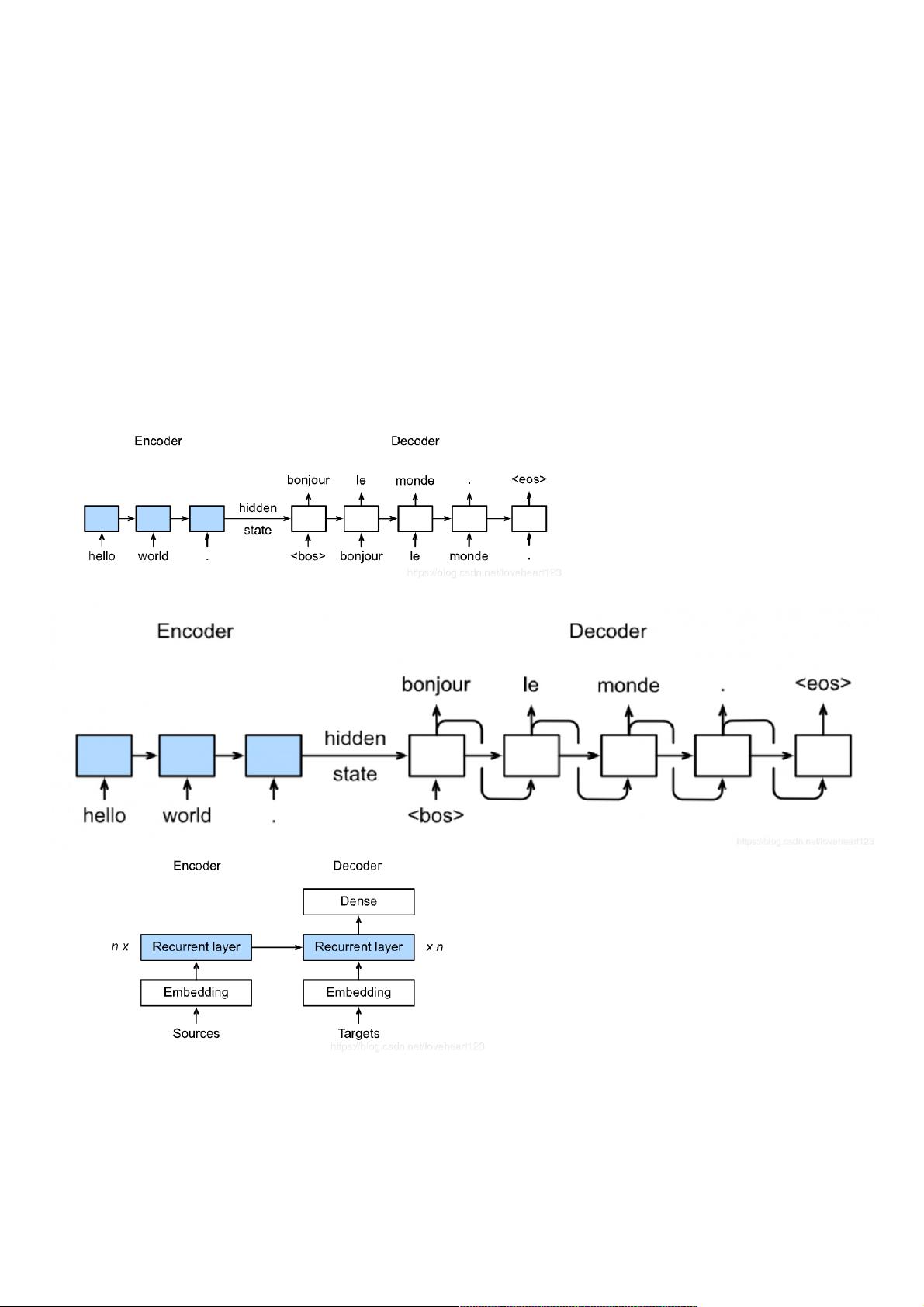

动手学深度学习:机器翻译及相关技术,注意力机制与seq2seq模型,Transformer 初次学习机器翻译相关,把课程的概念题都记录一下。 目录: 1、机器翻译及相关技术 2、注意力机制与seq2seq模型 3、Transformer 1、机器翻译以及相关技术 1、机器翻译以及相关技术 1、关于Sequence to Sequence模型说法错误的是: A 训练时decoder每个单元输出得到的单词作为下一个单元的输入单词。 B 预测时decoder每个单元输出得到的单词作为下一个单元的输入单词。 C 预测时decoder单元输出为句子结束符时跳出循环。 D 每个batch训练时encode 【机器翻译及相关技术】 机器翻译(Machine Translation, MT)是自然语言处理领域的重要研究方向,其目标是将文本从一种语言自动转换成另一种语言。神经机器翻译(Neural Machine Translation, NMT)是近年来发展迅速的技术,它利用神经网络模型处理输入和输出的序列数据。在NMT中,模型通常采用Sequence to Sequence(Seq2Seq)架构,由一个Encoder负责理解源语言句子的含义,而Decoder则生成目标语言的翻译。 Seq2Seq模型在训练和预测阶段有不同的行为。训练时,Decoder的输入是Encoder的输出和上一时间步的Decoder隐藏状态,而在预测时,Decoder的输入是上一时间步自己生成的单词。当Decoder输出句子结束符时,预测过程结束。在每个batch的训练过程中,Encoder和Decoder的输入长度需要保持一致,以便于计算损失函数和反向传播。 【注意力机制与seq2seq模型】 注意力机制(Attention Mechanism)是Seq2Seq模型的一个重要改进,它模仿人类的注意力模式,允许Decoder在生成目标序列时动态关注源序列的不同部分。这解决了标准Seq2Seq模型中编码器信息压缩丢失的问题。注意力机制包括几种类型,如点积注意力(Dot-Product Attention)和MLP注意力等,其中点积注意力要求key和query的维度相同,并通过除以d的平方根来归一化。 加入注意力机制的seq2seq模型,每个时间步Decoder产生的语境向量(context vector)会根据源序列的不同部分调整,从而提供更丰富的上下文信息。然而,注意力机制并不能加速模型训练,因为内部的RNN(如LSTM或GRU)仍然需要按顺序处理序列。 【Transformer模型】 Transformer是Google在2017年提出的一种新型的Seq2Seq模型,它完全基于自注意力(Self-Attention)机制,抛弃了传统的RNN或CNN结构,提高了并行计算能力,大大加快了训练速度。Transformer由多个编码器(Encoder)和解码器(Decoder)堆叠而成,每个编码器和解码器都包含多层自注意力层和前馈神经网络。 Transformer中的自注意力机制允许模型同时考虑整个输入序列的信息,而不再受限于单个时间步的上下文。此外,Transformer还引入了Masking技术,以防止在解码过程中直接看到未来的信息,保证了生成过程的因果性。 数据预处理在机器翻译中至关重要,包括获取数据生成器、建立词典、分词以及将单词转化为词向量。分词(Tokenization)是将文本拆分为单词或子词的步骤,为后续的模型处理做好准备。词向量(Word Embedding)则将每个单词转化为固定维度的向量,这些向量能够捕捉词汇之间的语义关系。 总结来说,机器翻译涉及多种技术,如Seq2Seq模型、注意力机制和Transformer,这些技术不断推动着自然语言处理领域的进步,使得机器翻译的准确性和效率得到了显著提升。

- 粉丝: 4

- 资源: 923

我的内容管理

展开

我的内容管理

展开

我的资源

快来上传第一个资源

我的资源

快来上传第一个资源

我的收益 登录查看自己的收益

我的收益 登录查看自己的收益 我的积分

登录查看自己的积分

我的积分

登录查看自己的积分

我的C币

登录后查看C币余额

我的C币

登录后查看C币余额

我的收藏

我的收藏  我的下载

我的下载  下载帮助

下载帮助

前往需求广场,查看用户热搜

前往需求广场,查看用户热搜 信息提交成功

信息提交成功

评论0