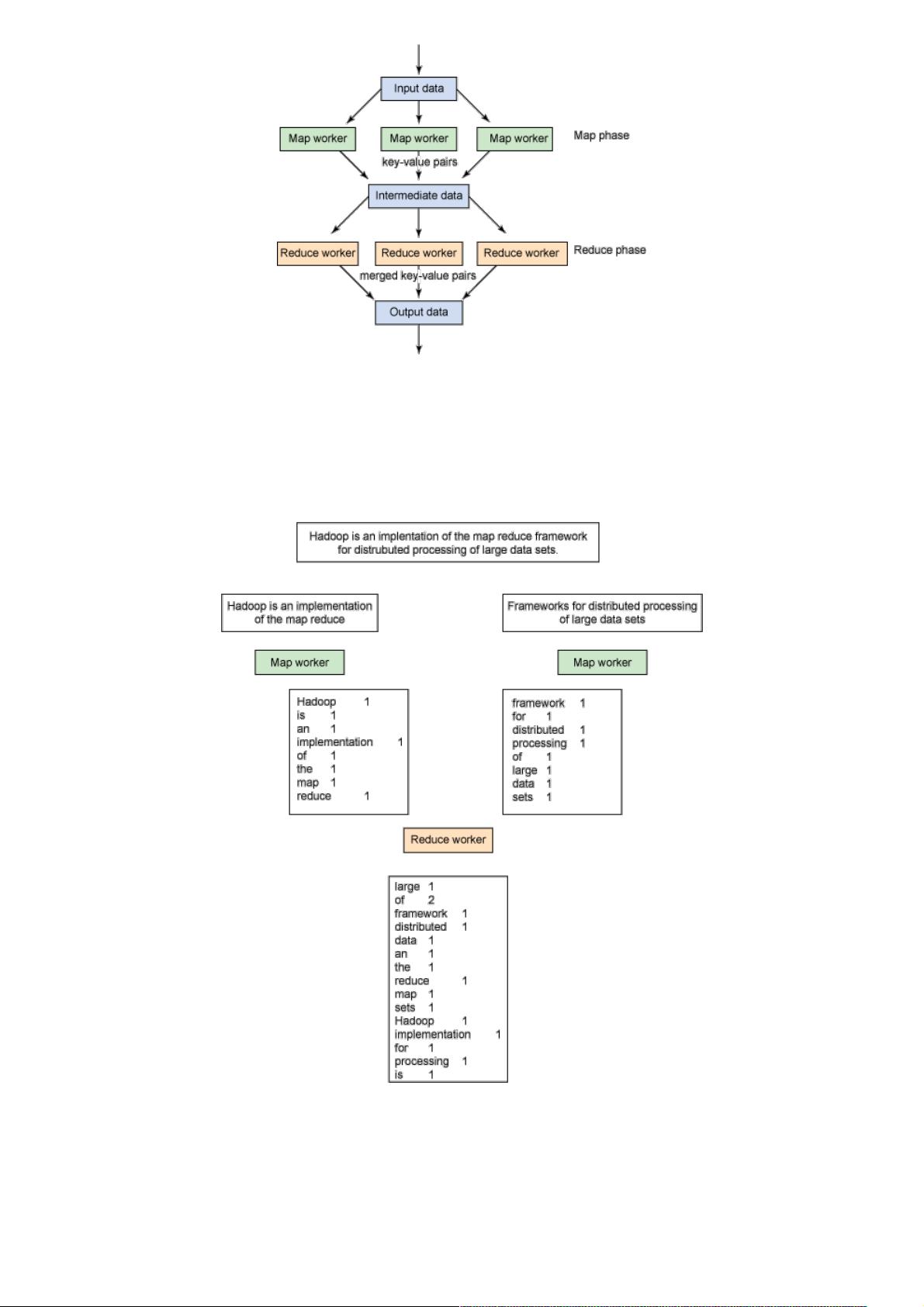

### 用Hadoop进行分布式数据处理:第3部分——应用程序开发 #### 一、引言 随着前两篇文章中对Hadoop单节点和多节点集群的安装与配置进行了详细介绍,本篇文章作为系列文章的最后一部分,将重点转向如何利用Hadoop进行应用程序的开发。通过具体的例子,我们将探索Hadoop API的基本概念以及数据流处理机制,特别是如何使用Ruby语言来编写MapReduce应用程序。 #### 二、MapReduce编程模型概述 ##### 2.1 MapReduce的起源 MapReduce编程模型的概念来源于功能性编程语言Lisp。Lisp语言由John McCarthy于1958年发明,最初是在IBM 704计算机上实现的。MapReduce编程范式的核心思想在于利用map和reduce这两个基本操作来处理大量数据。具体来说: - **Map**:该操作接收一组输入数据,并将其转换为一组键值对的中间集合。 - **Reduce**:该操作接收map阶段产生的中间键值对,并将具有相同键的多个值合并成较少数量的输出值。 ##### 2.2 Hadoop中的MapReduce Hadoop通过实现MapReduce编程模型,使得用户可以在分布式环境中高效处理大规模数据集。在Hadoop中,MapReduce工作流程可以概括如下: 1. **输入数据分片**:原始数据被分成若干个分片,每个分片都会被分配给一个map任务处理。 2. **Map任务**:每个map任务负责处理分配给它的数据分片,并将处理后的结果输出为一组键值对的中间集合。 3. **Shuffle和Sort**:map任务完成后,中间结果会被重新排序和分组,确保相同键的值会被同一个reduce任务处理。 4. **Reduce任务**:reduce任务将具有相同键的多个值合并成更少数量的输出值,最终形成处理结果。 #### 三、Map和Reduce操作详解 ##### 3.1 Map操作 Map函数处理输入数据并产生中间键值对集合。例如,在统计文本中单词频率的例子中,map函数会对输入的每行文本进行处理,将每行文本分割成单词,并为每个单词生成一个键值对(单词, 1)。 ##### 3.2 Reduce操作 Reduce函数接收来自多个map任务的相同键的所有值,并将这些值合并成一个较小的结果集。在单词计数的例子中,reduce函数会对每个单词出现的次数进行求和,输出每个单词及其总的出现次数。 #### 四、Hadoop API和流式API 在Hadoop中,除了传统的Java编程方式之外,还提供了流式API,使得开发者可以使用多种语言编写MapReduce程序。流式API允许开发者使用自定义的编程语言编写map和reduce函数,并通过标准输入输出流与Hadoop交互。这种方式极大地提高了灵活性,使得开发者能够根据项目需求选择最适合的语言。 #### 五、Ruby中的MapReduce应用程序开发 在本篇文章中,我们将以Ruby语言为例来展示如何编写MapReduce应用程序。Ruby是一种现代的面向对象脚本语言,易于学习且功能强大。下面是一个简单的Ruby代码示例,用于演示如何使用Ruby编写一个MapReduce程序来统计文本文件中单词的出现频率。 ```ruby # map.rb # 输入:文本文件 # 输出:单词及其出现次数 (word, 1) ARGF.each do |line| line.split(/\s+/).each do |word| puts "#{word}\t1" end end ``` ```ruby # reduce.rb # 输入:单词及其出现次数 (word, 1) # 输出:单词及其总出现次数 (word, count) last_key = nil value_sum = 0 while line = gets key, value = line.split(/\t/) if last_key == key value_sum += value.to_i else if last_key puts "#{last_key}\t#{value_sum}" end value_sum = value.to_i last_key = key end end puts "#{last_key}\t#{value_sum}" if last_key ``` 通过上述Ruby示例可以看出,即使没有使用Java,我们仍然可以利用Hadoop的强大功能来处理大规模数据集。 #### 六、总结 通过本篇文章的学习,读者不仅了解了MapReduce编程模型的基本原理,还掌握了如何使用Ruby语言来编写简单的MapReduce应用程序。Hadoop及其提供的流式API为开发者提供了一种灵活的方式来处理大规模数据集,使得开发者可以根据自己的偏好和项目的实际需求选择最适合的编程语言。在未来的学习和实践中,读者可以进一步探索Hadoop及其周边生态系统,如Hive、Pig等工具,以更高效地处理和分析大规模数据。

剩余6页未读,继续阅读

- 粉丝: 5

- 资源: 894

我的内容管理

展开

我的内容管理

展开

我的资源

快来上传第一个资源

我的资源

快来上传第一个资源

我的收益 登录查看自己的收益

我的收益 登录查看自己的收益 我的积分

登录查看自己的积分

我的积分

登录查看自己的积分

我的C币

登录后查看C币余额

我的C币

登录后查看C币余额

我的收藏

我的收藏  我的下载

我的下载  下载帮助

下载帮助

前往需求广场,查看用户热搜

前往需求广场,查看用户热搜最新资源

信息提交成功

信息提交成功