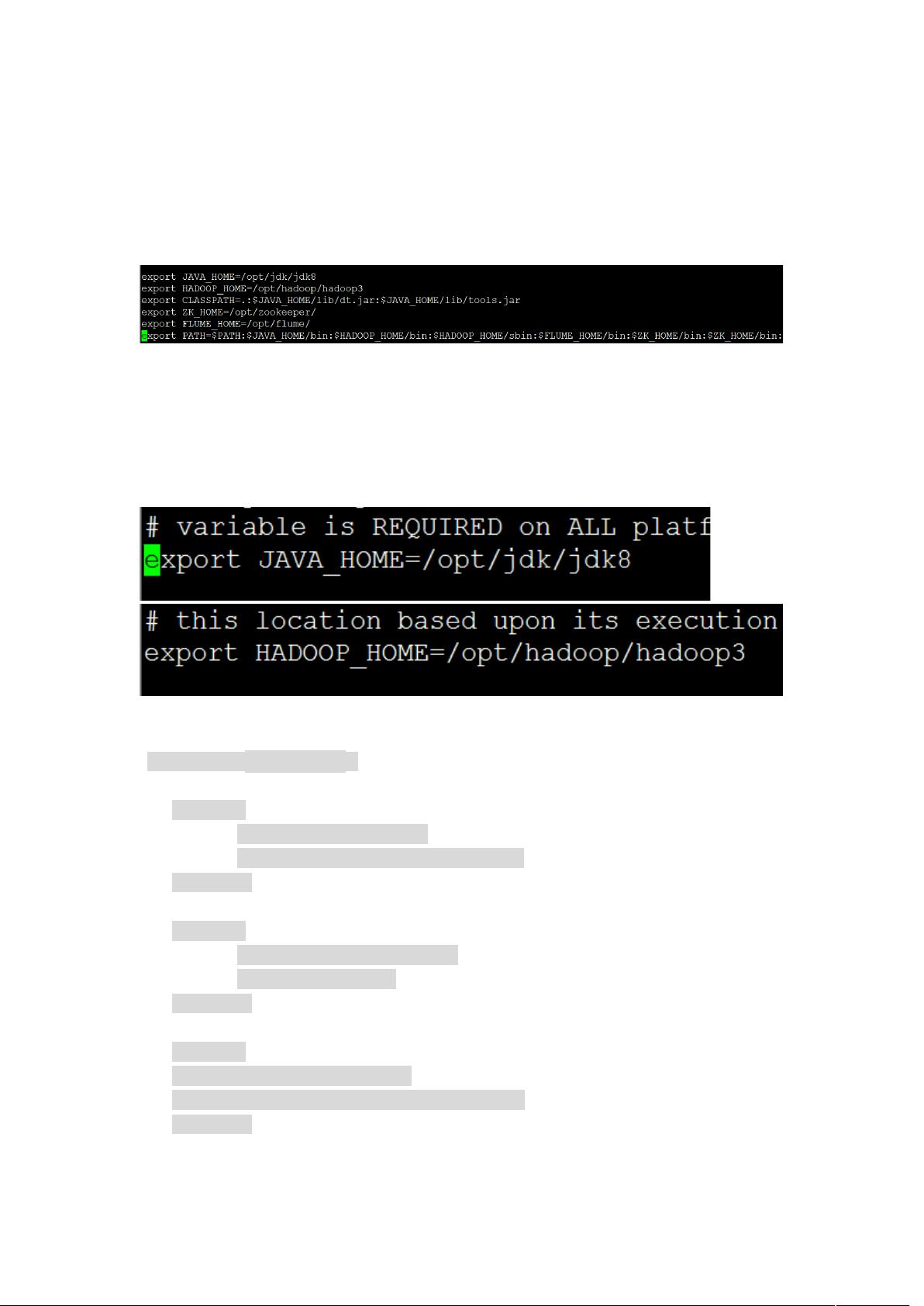

### Hadoop 3.0 分布式集群搭建详解 #### 一、概述 Hadoop 是一个能够对大量数据进行分布式处理的软件框架。Hadoop 的核心是 HDFS 和 MapReduce,其中 HDFS 用于存储数据,MapReduce 则提供了一个大规模数据集的并行运算框架。随着大数据技术的发展,Hadoop 不断更新迭代,3.0 版本更是引入了诸多新特性,如多 NameNode 支持、多容器支持等,进一步提升了系统的稳定性和扩展性。 #### 二、环境准备与配置 **2.1 JDK 安装** Hadoop 3.0 要求使用 JDK 8,因此首先需要安装 JDK 8。具体步骤如下: 1. **下载 JDK 8:** 可以从 Oracle 官方网站或其他可信源下载 JDK 8。 2. **解压 JDK 8:** 将下载好的 JDK 8 压缩包解压到指定目录,例如 `/usr/local`。 3. **配置环境变量:** 编辑 `/etc/profile` 文件,添加以下内容: ```bash export JAVA_HOME=/usr/local/jdk1.8.0_XXX export PATH=$JAVA_HOME/bin:$PATH ``` 其中 `XXX` 需替换为你实际解压后的 JDK 版本号。 4. **刷新环境变量:** 使用 `source /etc/profile` 命令使环境变量生效。 **2.2 Hadoop 解压** 接下来需要解压 Hadoop 3.0 压缩包,并将其放置在适当的位置,例如 `/usr/local` 目录下。 **2.3 配置 Hadoop 环境变量** 编辑 `/etc/profile` 文件,添加 Hadoop 的路径配置: ```bash export HADOOP_HOME=/usr/local/hadoop-3.0.0 export PATH=$HADOOP_HOME/bin:$PATH ``` 同样使用 `source /etc/profile` 命令使环境变量生效。 #### 三、配置 Hadoop 核心文件 配置 Hadoop 的核心文件,包括 `hadoop-env.sh`, `core-site.xml`, `hdfs-site.xml`, `yarn-site.xml` 等。 **3.1 配置 hadoop-env.sh** 在 `/etc/hadoop` 目录下找到 `hadoop-env.sh` 文件,配置 `JAVA_HOME` 和 `HADOOP_HOME` 的路径: ```bash # 设置 Java 的主目录 export JAVA_HOME=/usr/local/jdk1.8.0_XXX # 设置 Hadoop 主目录 export HADOOP_HOME=/usr/local/hadoop-3.0.0 ``` **3.2 配置 core-site.xml** 编辑 `core-site.xml` 文件,在 `<configuration>` 标签内添加如下配置: ```xml <property> <name>fs.defaultFS</name> <value>hdfs://192.168.10.21:8020</value> </property> <property> <name>io.file.buffer.size</name> <value>131072</value> </property> <property> <name>hadoop.tmp.dir</name> <value>file:///opt/hadoop/hadoop3/tmp</value> </property> ``` 这里的 `192.168.10.21` 是第一台节点 IP,即 NameNode 的 IP 地址。 **3.3 配置 hdfs-site.xml** 编辑 `hdfs-site.xml` 文件,在 `<configuration>` 标签内添加如下配置: ```xml <property> <name>dfs.namenode.name.dir</name> <value>file:///opt/dfs/name</value> </property> <property> <name>dfs.datanode.data.dir</name> <value>file:///opt/dfs/data</value> </property> <property> <name>dfs.http.address</name> <value>192.168.10.21:50070</value> </property> <property> <name>dfs.secondary.http.address</name> <value>192.168.10.22:50090</value> </property> <property> <name>dfs.replication</name> <value>3</value> </property> <property> <name>dfs.webhdfs.enabled</name> <value>true</value> </property> <property> <name>dfs.blocksize</name> <value>268435456</value> </property> ``` 这里需要注意的是 `192.168.10.22` 为 Secondary NameNode 的 IP 地址。 **3.4 配置 yarn-site.xml** 编辑 `yarn-site.xml` 文件,在 `<configuration>` 标签内添加如下配置: ```xml <property> <name>yarn.resourcemanager.hostname</name> <value>kelong1</value> </property> <property> <name>yarn.nodemanager.aux-services</name> <value>mapreduce_shuffle</value> </property> <property> <name>yarn.resourcemanager.address</name> <value>kelong1:8032</value> </property> <property> <name>yarn.resourcemanager.scheduler.address</name> <value>kelong1:8030</value> </property> <property> <name>yarn.resourcemanager.resource-tracker.address</name> <value>kelong1:8031</value> </property> <property> <name>yarn.resourcemanager.admin.address</name> <value>kelong1:8033</value> </property> ``` 其中 `kelong1` 为第一台节点的主机名。 #### 四、格式化 HDFS 并启动集群 完成上述配置后,需要格式化 HDFS 并启动 Hadoop 集群。 **4.1 格式化 HDFS** 使用以下命令格式化 HDFS: ```bash hdfs namenode -format ``` **4.2 启动集群** 使用以下命令启动 Hadoop 集群: ```bash sbin/start-dfs.sh sbin/start-yarn.sh ``` 至此,Hadoop 3.0 分布式集群的搭建完成。接下来可以进行相关的测试和数据分析工作。

- 粉丝: 3

- 资源: 5

我的内容管理

展开

我的内容管理

展开

我的资源

快来上传第一个资源

我的资源

快来上传第一个资源

我的收益 登录查看自己的收益

我的收益 登录查看自己的收益 我的积分

登录查看自己的积分

我的积分

登录查看自己的积分

我的C币

登录后查看C币余额

我的C币

登录后查看C币余额

我的收藏

我的收藏  我的下载

我的下载  下载帮助

下载帮助

前往需求广场,查看用户热搜

前往需求广场,查看用户热搜最新资源

- 【全年行事历】团建活动计划表.xlsx

- 【全年行事历】团建行程安排表-xx山.xlsx

- 【全年行事历】团建活动策划方案.docx

- 【全年行事历】团建开销费用分析.xlsx

- 【全年行事历】团建活动物料清单.xlsx

- 【全年行事历】团建文化衫尺码统计表.xlsx

- 【全年行事历】团建医药箱常备药清单.docx

- 【全年行事历】小型公司活动全年活动行事历.xlsx

- 【全年行事历】员工野外拓展活动方案.docx

- 四足机器人机械结构设计PDF

- 06-公司团建活动申请表.docx

- 03-团建活动策划方案.docx

- 07-团建活动采购预算清单.xlsx

- 08-团建日程计划表.xlsx

- 09-财务公司月度团建支出表.xlsx

- T-SQL查询高级SQLServer索引中的碎片和填充因子word文档doc格式最新版本

信息提交成功

信息提交成功