Flink笔记(十九):Flink 从 Checkpoint 中恢复数据

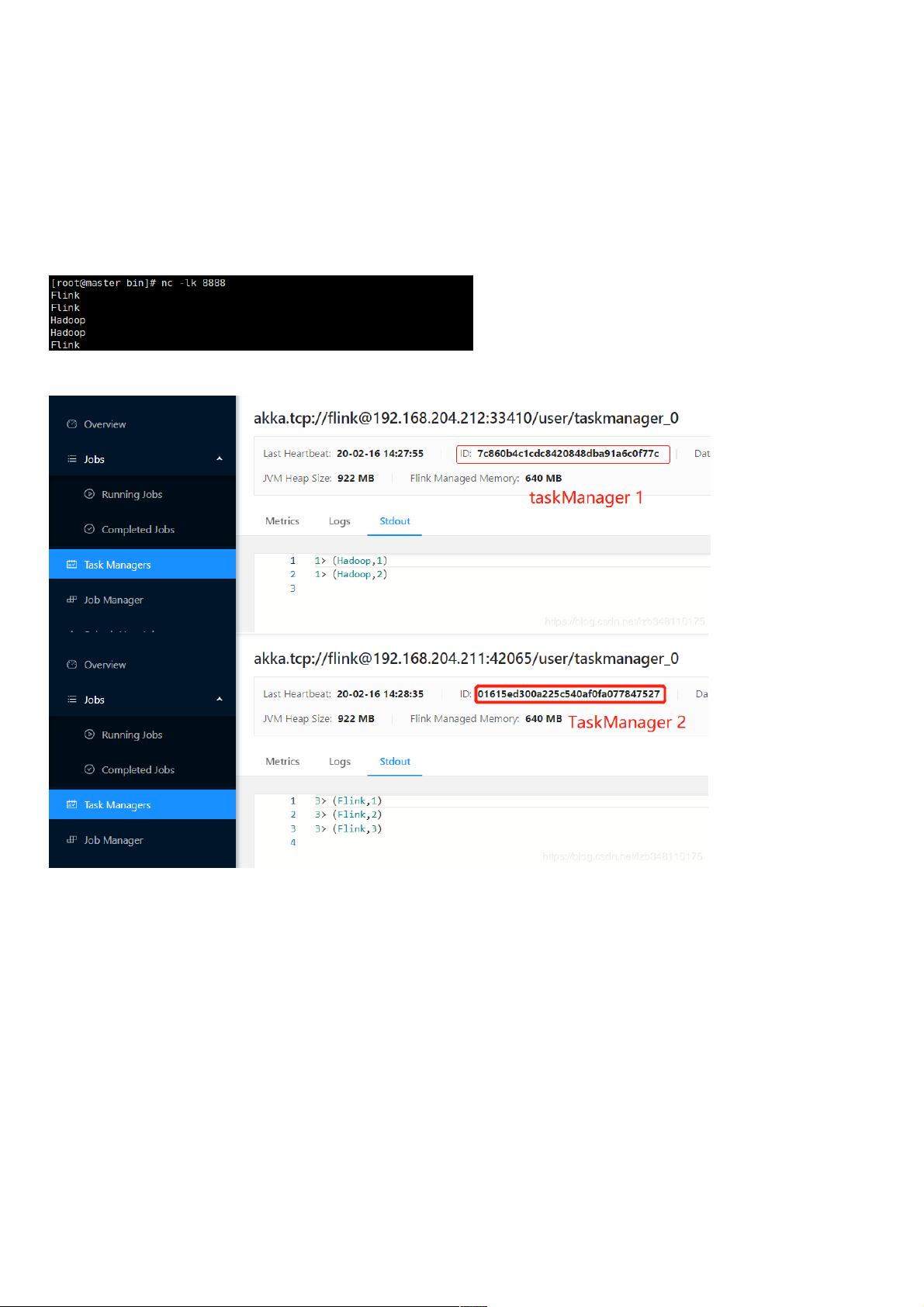

接上文:Flink笔记(十八):Flink 之 StateBackend 介绍 & 使用,本文介绍 Flink 从 Checkpoint 中恢复数据。 当 Flink 任务提交后,只有遇到 1.程序错误、2.人为 Cancel掉,任务就会停止。 1. 任务异常,设置保存 CheckPoint 中途数据不被删除 如果现在有个任务已经执行很长时间,这样就突然停止了,那么中间过程处理结果全丢了,重启后重跑岂不很浪费时间。这样显然是不行的,所以我们可以通过以下设置来保存任务处理中途的 CheckPoint 数据的(如果不设置,任务停止后CheckPoint数据会自动删除)。 //系统 在大数据流处理领域,Apache Flink 是一个关键的开源框架,它提供了强大的实时计算能力。在 Flink 中,为了应对程序错误或人为取消任务时的数据丢失问题,Checkpoint 机制是至关重要的。本篇将深入讲解如何利用 Flink 的 Checkpoint 机制从已保存的状态中恢复数据。 我们需要理解什么是 Flink 的 Checkpoint。Checkpoint 是 Flink 在处理无界数据流过程中的一种状态保存策略。当任务执行到某个检查点时,Flink 会将所有算子的状态持久化到外部存储系统,如 HDFS 或其他持久化存储。这样,即使任务因为故障或者人为操作而中断,也可以从最近的 Checkpoint 恢复,避免重新处理全部数据,从而节省大量的时间和资源。 在 Flink 中,若要确保 Checkpoint 数据在任务异常退出或人为取消后不被删除,可以在配置中启用外部化 Checkpoint,并设置清理策略为 `RETAIN_ON_CANCELLATION`。以下是启用这一功能的代码示例: ```java StreamExecutionEnvironment env = StreamExecutionEnvironment.getExecutionEnvironment(); env.getCheckpointConfig().enableExternalizedCheckpoints(CheckpointConfig.ExternalizedCheckpointCleanup.RETAIN_ON_CANCELLATION); ``` 这样,即使任务被取消,其 Checkpoint 数据也会被保留,可供后续恢复使用。 恢复数据的过程分为 Web 界面操作和命令行操作。在 Web 页面操作中,我们首先测试数据输入,然后执行计算,假设在两个 TaskManager 上得到了 (Hadoop, 2) 和 (Flink, 3) 的结果。接着,人为取消任务。在 Checkpoint 存储路径(例如 hdfs://192.168.204.210:9000/StateBackend/31f48d20d48f0bec256e6b4d24553b8a/chk-536)中找到最新的 Checkpoint,通过 Web 界面提交恢复任务。再次输入数据(如 Flink、Flink、Hadoop),恢复后的计算结果应为 (Hadoop, 3) 和 (Flink, 5),证明数据恢复成功。 对于命令行操作,可以使用 `-s` 参数指定 Checkpoint 路径,然后提交任务进行恢复。不过,相较于 Web 界面,命令行操作通常更为复杂,因此推荐使用 Web 端进行恢复操作。 Flink 的 Checkpoint 机制使得在任务失败或被取消时能够快速恢复到之前的状态,确保数据处理的连续性和一致性。正确配置 Checkpoint 保存策略并熟练掌握恢复操作,是 Flink 应用中不可或缺的技能,有助于提高系统的容错性和可靠性。通过本文的介绍,希望能帮助你更好地理解和应用 Flink 的 Checkpoint 与恢复机制。

- 粉丝: 3

- 资源: 978

我的内容管理

展开

我的内容管理

展开

我的资源

快来上传第一个资源

我的资源

快来上传第一个资源

我的收益 登录查看自己的收益

我的收益 登录查看自己的收益 我的积分

登录查看自己的积分

我的积分

登录查看自己的积分

我的C币

登录后查看C币余额

我的C币

登录后查看C币余额

我的收藏

我的收藏  我的下载

我的下载  下载帮助

下载帮助

前往需求广场,查看用户热搜

前往需求广场,查看用户热搜最新资源

- dnSpy-net-win32-222.zip

- mongoose-free-6.9

- 德普微一级代理 DP100N06MGL PDFN3.3*3.3 TRMOS N-MOSFET 60V, 8mΩ, 45A

- 【java毕业设计】SpringBoot+Vue幼儿园管理系统 源码+sql脚本+论文 完整版

- 德普微一级代理 DP021N03FGLI DFN5*6 DPMOS N-MOSFET 30V 180A 1.8mΩ

- 巨潮资讯网5000只股票orgId-dict加密字典

- 基于java实现的快速排序代码

- 德普微一级代理 DP3145D SOT23-6 USB PD 协议单口控制器

- 【一文搞懂:什么是集成学习-原理+python代码】

- 国际象棋检测7-YOLO(v5至v9)、COCO、CreateML、Darknet、Paligemma、TFRecord数据集合集.rar

信息提交成功

信息提交成功

评论0