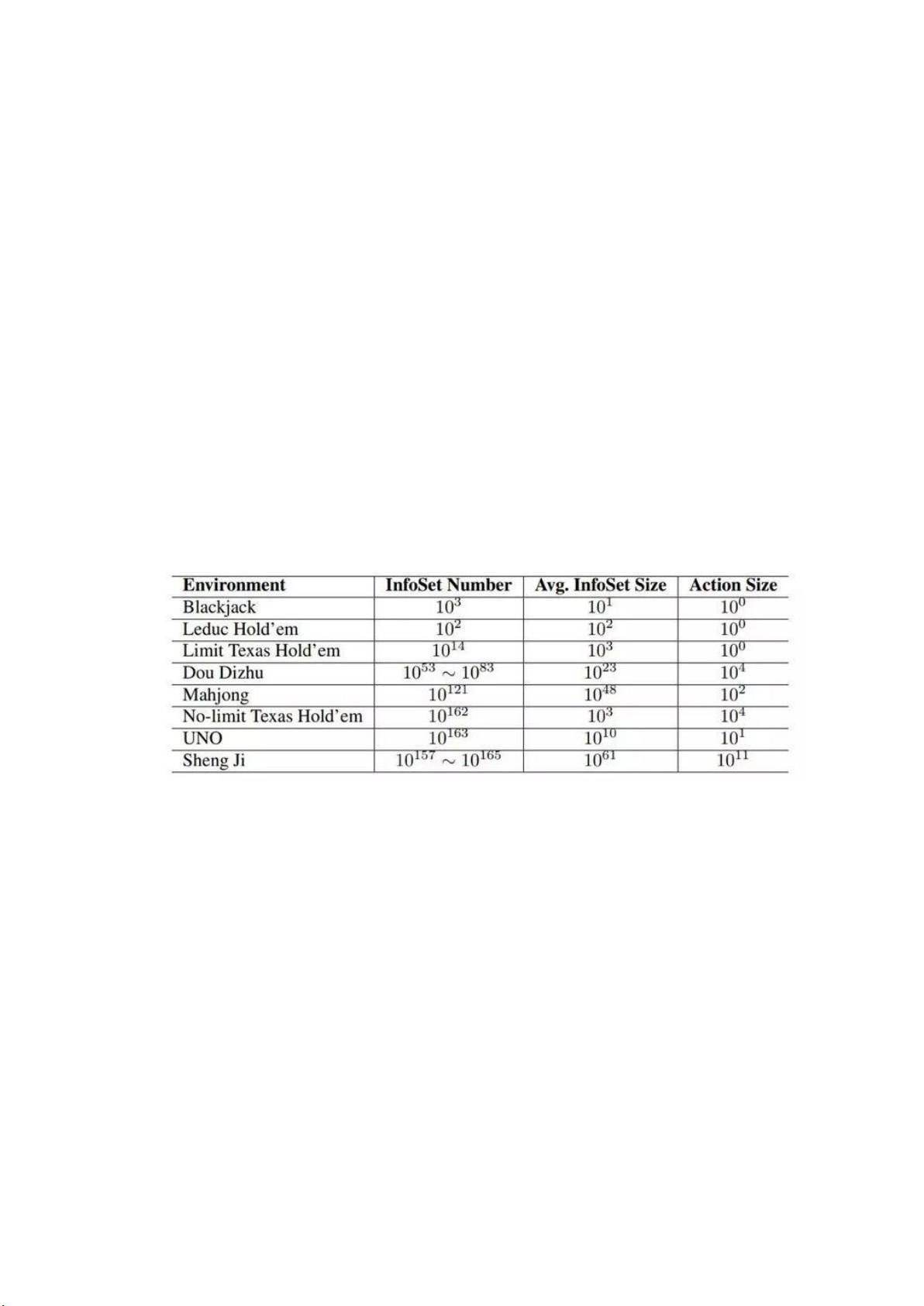

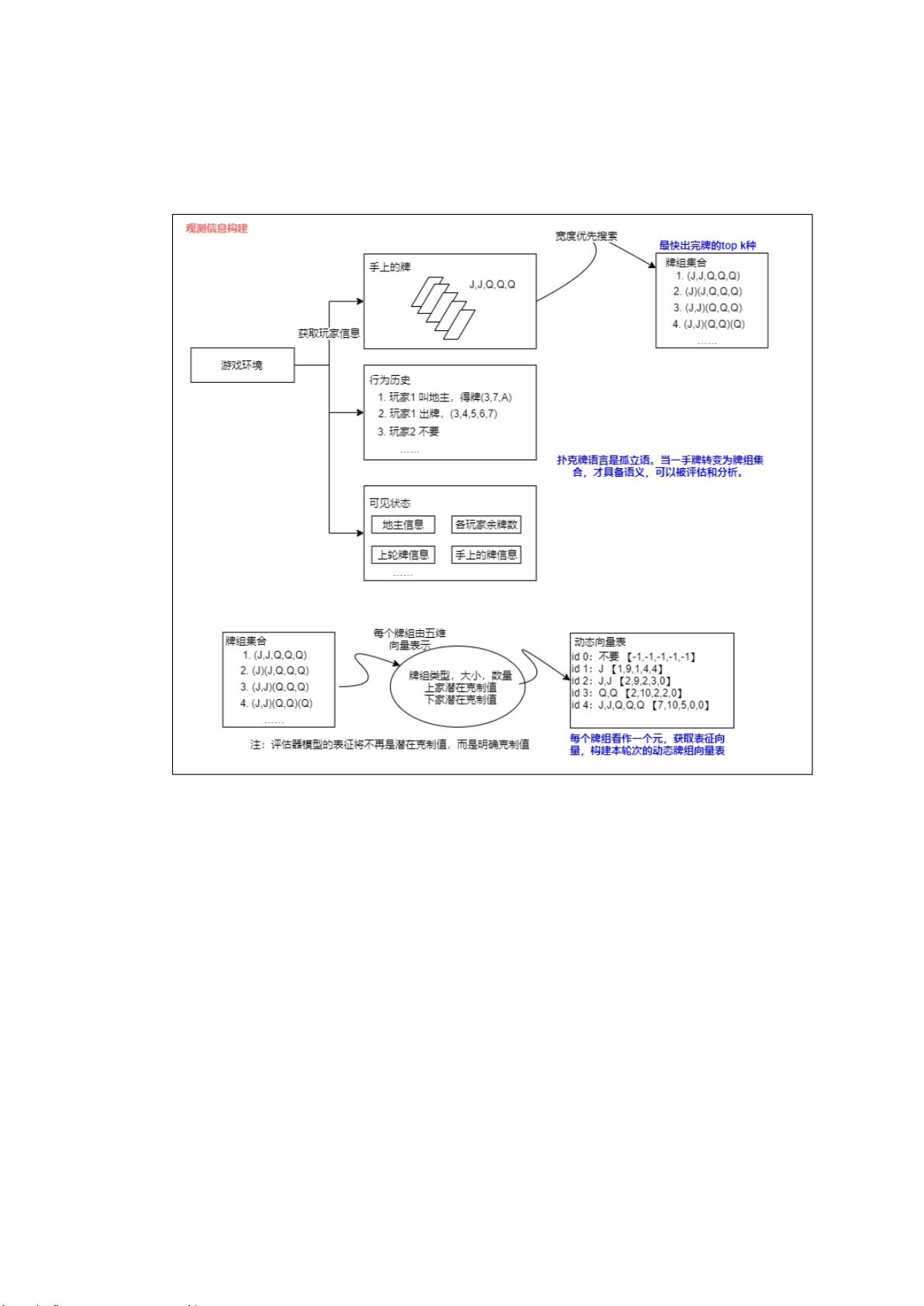

斗地主RL模型是将人工智能应用于斗地主游戏的一种方法,通过强化学习(RL)让计算机模拟人类玩家的决策过程。在这个模型中,有多个关键的知识点需要理解: 1. **行动空间庞大**:斗地主游戏的行动空间非常大,因为每一轮出牌有多种可能的组合,例如飞机带单张、对子等。为了处理这个问题,需要设计高效的搜索算法,如宽度优先搜索(BFS),来减少分析复杂度,并寻找最优解。 2. **动作价值估计**:在不同的游戏阶段和情境下,同一组牌的价值是变化的。模型需要能够估计不同出牌策略的价值,考虑当前的牌组、对家和队友的策略。这通常通过Q-learning或其他强化学习算法来实现,通过与环境的交互更新价值函数。 3. **不完全信息博弈**:在斗地主中,玩家无法看到所有人的手牌,增加了决策的困难。为了应对这种情况,模型可以利用部分信息和历史出牌推断对手的可能牌型,进行概率推理。 4. **身份和阶段分析**:作为地主和农民,决策策略是不同的。地主需要独立对抗两个农民,而农民则需要协作对抗地主。模型需要根据不同的角色调整其决策逻辑。 5. **人格揣测**:通过对玩家出牌习惯的观察,模型可以学习到玩家的风格,并据此预测他们的手牌,采取对应的策略。这涉及到了深度学习中的序列学习和注意力机制,以捕捉玩家的行为模式。 6. **实验环境与数据**:斗地主RL模型的训练需要大量玩家数据,不同的玩家策略要求模型具有泛化能力。重要性采样在这里扮演了关键角色,通过完全信息模型预估胜率,选择有意义的对局进行训练,提高资源利用率。 模型架构方面,通常包括以下组件: - **叫地主模型**:判断开局时是否要成为地主。 - **斗地主模型**:负责出牌阶段的决策,根据当前身份(地主或农民)做出最佳行动。 - **评估器模型**:用于减少不完全信息的影响,通过重要性采样加速训练,仅对胜负不明朗的对局进行训练。 建模理论基于两个核心假设: 1. **一手牌的强度**:牌的强度是由所有可能牌组的强度及其被采用的概率共同决定的,这涉及到对牌组价值的综合评估。 2. **可执行牌组的执行概率**:计算牌组执行概率时,需要考虑牌组在不同牌组集合中的概率,通过加权求和得到。 这些假设为构建深度强化学习模型提供了基础,结合深度优先搜索、动态向量表和注意力机制等技术,以更有效地处理斗地主游戏中的复杂性和不确定性。通过这样的模型,AI可以在斗地主游戏中展现出类似甚至超越人类的决策能力。

剩余8页未读,继续阅读

- 粉丝: 33

- 资源: 315

我的内容管理

展开

我的内容管理

展开

我的资源

快来上传第一个资源

我的资源

快来上传第一个资源

我的收益 登录查看自己的收益

我的收益 登录查看自己的收益 我的积分

登录查看自己的积分

我的积分

登录查看自己的积分

我的C币

登录后查看C币余额

我的C币

登录后查看C币余额

我的收藏

我的收藏  我的下载

我的下载  下载帮助

下载帮助

前往需求广场,查看用户热搜

前往需求广场,查看用户热搜 信息提交成功

信息提交成功

评论0