基于PyTorch的LSTM模型实现 人工智能1901 孙平炜 201912181

需积分: 0 107 浏览量

更新于2022-08-04

收藏 358KB PDF 举报

【正文】

基于PyTorch的LSTM模型是用于处理序列数据,特别是自然语言处理任务的一种高效工具。LSTM(长短期记忆网络)是RNN(循环神经网络)的一个变种,旨在解决传统RNN中的梯度消失和梯度爆炸问题,从而更好地处理长期依赖性。

1. LSTM模型原理分析

RNN是一种具有反馈机制的神经网络,通过在时间轴上共享权重,使得网络能够处理序列数据。但在处理长序列时,RNN模型往往难以捕捉远距离的依赖关系,因为信息会随时间逐渐丢失。为了解决这个问题,LSTM引入了门控机制。

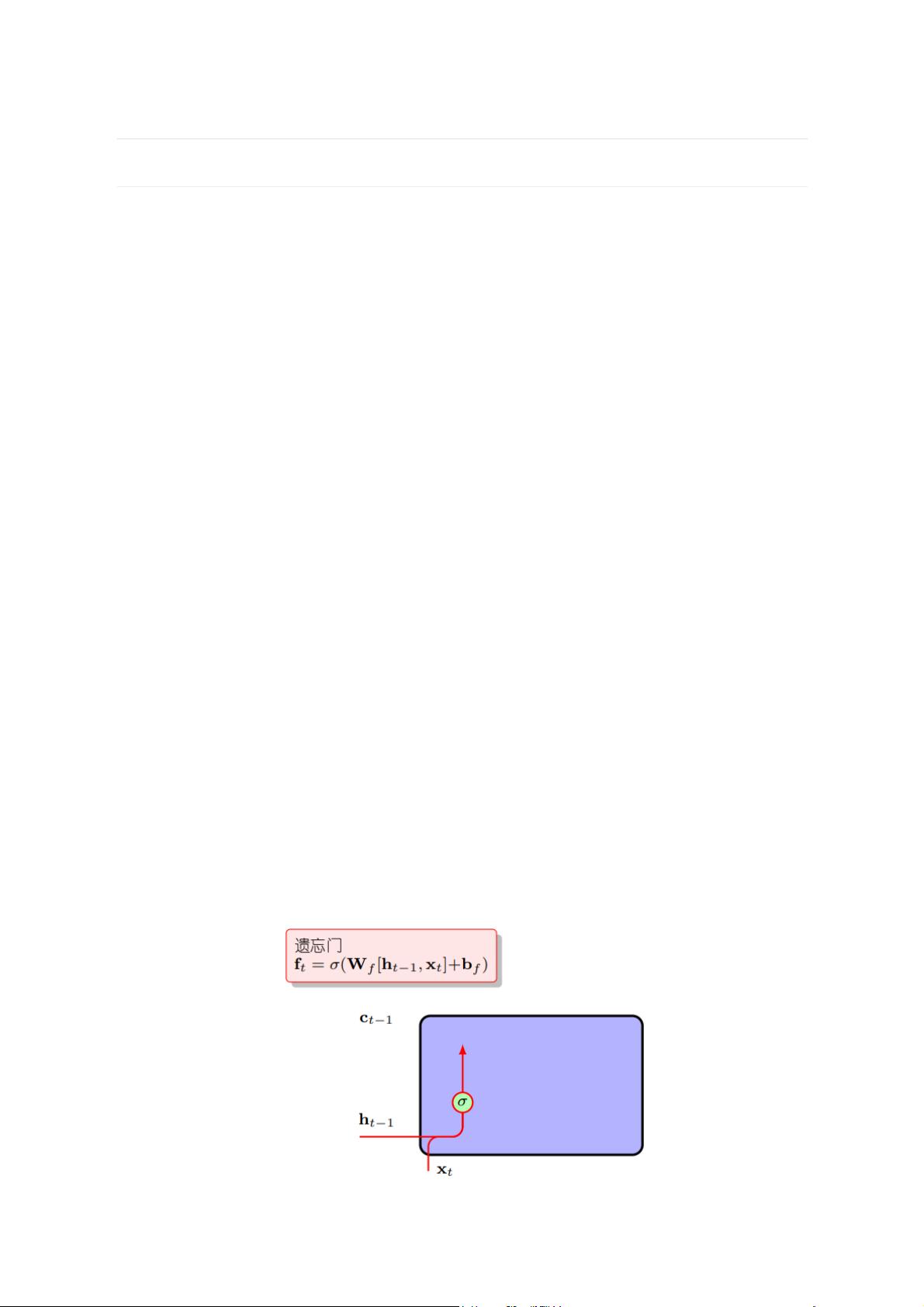

- 遗忘门:遗忘门允许LSTM网络决定在前一个时间步中哪些信息应该被丢弃。这有助于防止不重要的信息积累并干扰当前的决策。

- 输入门:输入门控制新信息如何被添加到细胞状态。它决定了新激活值对细胞状态的影响程度。

- 输出门:输出门控制在给定时间步中细胞状态的哪些部分应被输出到隐藏状态,进而影响当前时间步的预测。

通过这三扇门,LSTM能够有效地选择性地记住或忘记信息,从而在处理长序列时保持更好的性能。

2. LSTM模型的实现

在PyTorch中实现LSTM模型通常包括以下步骤:

- 数据预处理:需要将文本数据转换为数字表示。这通常包括创建词汇表,将单词映射到唯一的整数,以及填充和截断序列以适应固定的序列长度。例如,使用`make_dict`函数创建单词到数字的映射,并根据指定的`sequence_len`和`batch_size`准备训练样本。

- 构建LSTM模型:使用PyTorch的`nn.Module`构建模型,包括`nn.Embedding`层将数字词编码为词嵌入,`nn.LSTM`层实现LSTM单元,以及可能的全连接层(`nn.Linear`)进行分类或回归任务。此外,还可能需要添加`nn.Dropout`进行正则化,防止过拟合。

- 训练模型:定义损失函数(如交叉熵损失)和优化器(如Adam),然后在训练数据上迭代训练模型。在每个批次上,模型会更新其权重以最小化损失。

- 评估与预测:训练完成后,使用验证集评估模型性能,如准确率、F1分数等。然后可以使用训练好的模型进行预测,将新的序列数据输入模型,得到预测结果。

在实际应用中,还可以对LSTM模型进行扩展,如双向LSTM(同时考虑序列的前后信息)、深度LSTM(堆叠多个LSTM层)或者使用注意力机制来进一步提升模型的性能。

PyTorch提供了强大的框架来实现LSTM模型,通过理解和掌握LSTM的工作原理以及如何在PyTorch中构建和训练模型,可以有效地应用于各种序列数据处理任务,如文本生成、情感分析、机器翻译等。

乔木Leo

- 粉丝: 31

- 资源: 301

最新资源

- 塑料检测23-YOLO(v5至v11)、COCO、CreateML、Paligemma、TFRecord、VOC数据集合集.rar

- Python圣诞节倒计时与节日活动管理系统

- 数据结构之哈希查找方法

- 系统DLL文件修复工具

- 塑料、玻璃、金属、纸张、木材检测36-YOLO(v5至v11)、COCO、CreateML、Paligemma、TFRecord、VOC数据集合集.rar

- Python新年庆典倒计时与节日活动智能管理助手

- Nosql期末复习资料

- 数据结构排序算法:插入排序、希尔排序、冒泡排序及快速排序算法

- 2011-2024年各省数字普惠金融指数数据.zip

- 计算机程序设计员三级(选择题)