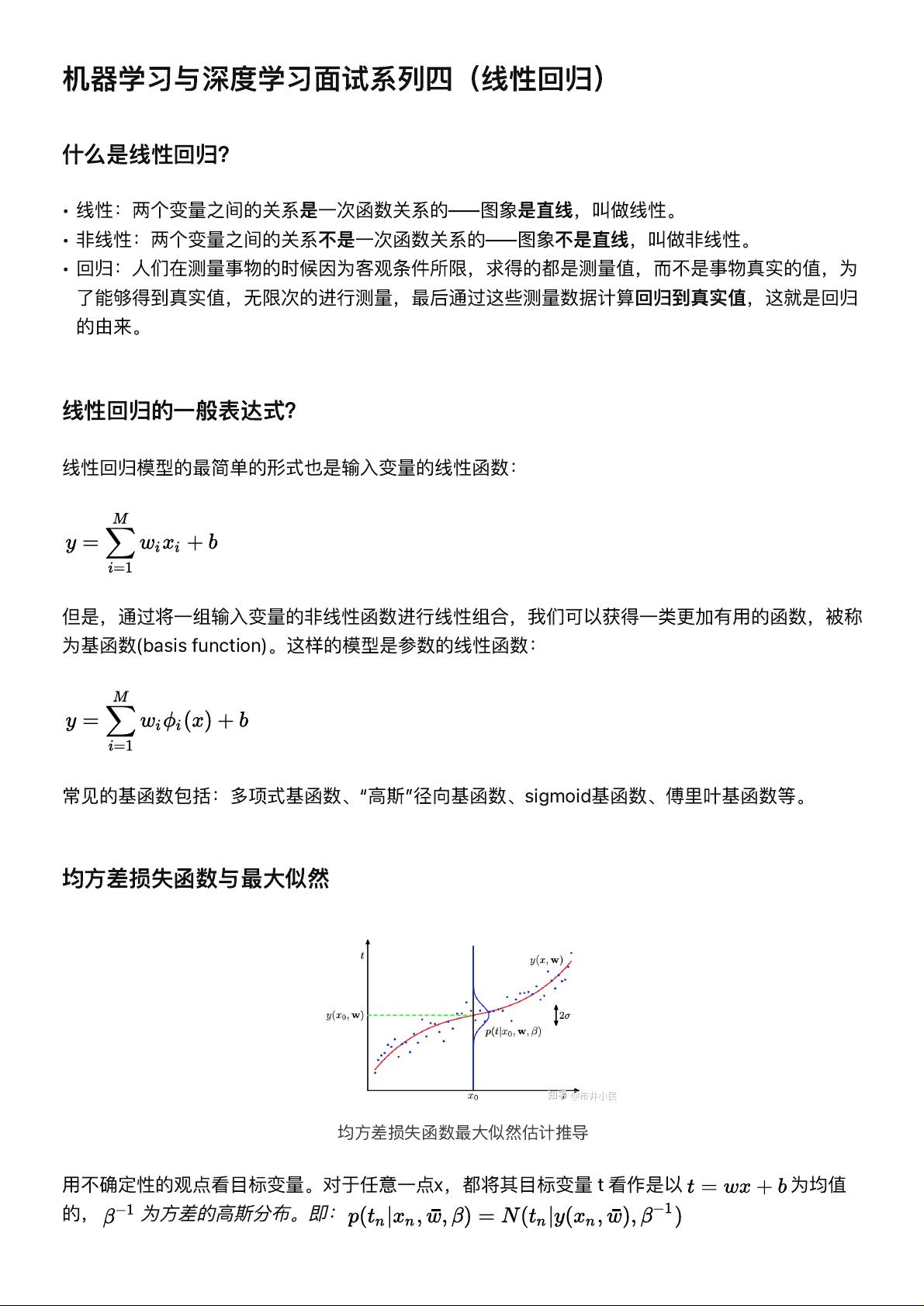

线性回归是机器学习中的一种基础算法,主要用来预测连续数值型的结果。在这个算法中,模型假设因变量和自变量之间存在线性关系,即输出是输入的线性函数。线性回归的一般表达式是 \( y = wx + b \),其中 \( y \) 是目标变量,\( x \) 是输入变量,\( w \) 是权重,\( b \) 是截距。 然而,实际问题中,数据并不总是呈现简单的线性模式。因此,引入非线性基函数(basis function)来扩展线性模型的能力,例如多项式基函数、高斯径向基函数、sigmoid函数和傅里叶基函数等,可以使模型更好地适应复杂的数据结构。 在训练线性回归模型时,通常采用最小化均方差损失函数来优化权重参数。损失函数衡量模型预测值与真实值之间的差异,而均方差损失是最常见的选择。最大似然估计是另一种确定模型参数的方法,它通过最大化数据生成过程的似然性来估计参数。当将目标变量视为均值为 \( w^Tx \)、方差为 \(\sigma^2\) 的高斯分布时,可以推导出最小化均方差损失函数与最大化对数似然函数是一致的。 在模型训练过程中,过拟合是一个常见的问题,表现为模型过度拟合训练数据,导致在未见过的新数据上表现不佳。为了缓解过拟合,可以应用正则化技术,如L1正则化(Lasso回归)、L2正则化(岭回归)和ElasticNet正则化。L1正则化倾向于产生稀疏解,即许多特征的权重变为0,有助于特征选择;L2正则化则通过让权重尽可能小但不为零来降低模型复杂度。ElasticNet结合了L1和L2的优点,适用于特征间可能存在共线性的情况。 正则化损失函数与最大后验估计之间存在联系,正则化可以看作是在损失函数中引入了对参数的先验分布。L1正则化对应拉普拉斯先验,L2正则化对应高斯先验,这都限制了模型参数的取值范围,从而降低模型的方差,防止过拟合。 线性回归是理解和掌握机器学习的基石,而正则化技术是其应对复杂数据和避免过拟合的关键。理解这些概念和技术对于深入学习深度学习以及进行有效的面试准备至关重要。

- 粉丝: 34

- 资源: 292

我的内容管理

展开

我的内容管理

展开

我的资源

快来上传第一个资源

我的资源

快来上传第一个资源

我的收益 登录查看自己的收益

我的收益 登录查看自己的收益 我的积分

登录查看自己的积分

我的积分

登录查看自己的积分

我的C币

登录后查看C币余额

我的C币

登录后查看C币余额

我的收藏

我的收藏  我的下载

我的下载  下载帮助

下载帮助

前往需求广场,查看用户热搜

前往需求广场,查看用户热搜最新资源

- Electron + Vue仿网易云音乐windows客户端.zip

- Dropzone.js 的 Vue.js 组件 - 带有图像预览的拖放文件上传实用程序.zip

- vue框架开发,如何在vue框架下编写代码介绍

- 移动机器人路径规划实战,入门教程实验代码

- Chart.js 的 Vue.js 包装器.zip

- BootstrapVue 为 Vue.js 提供了最全面的 Bootstrap v4 实现之一 具有广泛且自动化的 WAI-ARIA 可访问性标记 .zip

- Babel , Vue JSX 相关软件包的 monorepo.zip

- Java多线程基础学习指南:原理、实现与实战

- 西电微机原理实验:实验内容、步骤与实践指导 - 计算机科学与技术专业的教学辅助材料

- 计算机网络课程设计:选题指南与实践要点

信息提交成功

信息提交成功