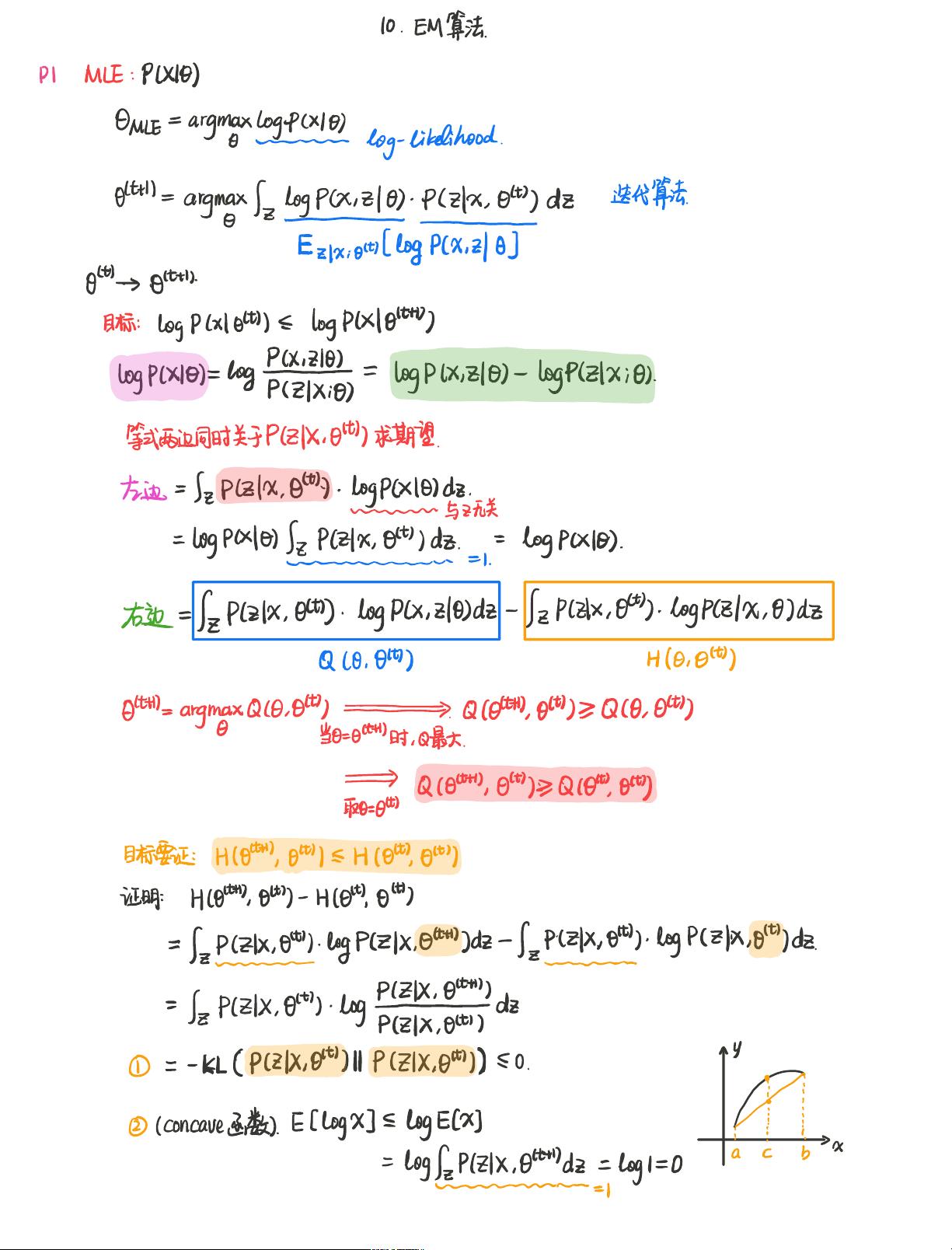

EM算法,全称为期望最大化(Expectation-Maximization)算法,是一种在统计学和机器学习领域广泛应用的迭代方法,主要用于处理含有隐藏变量的概率模型的参数估计问题。在模型中,我们通常可以观察到一部分数据(观测数据),但还有一部分数据是隐藏的或者不可见的(潜在数据)。EM算法通过迭代的方式,交替进行期望(E-step)和最大化(M-step)两个步骤,以优化模型的参数。

E-step(期望步):在这个步骤中,给定当前的参数估计值,算法计算每个观测数据点对应隐藏变量的期望值,也就是后验概率。具体来说,计算的是条件期望E[log p(x, z|θ)],其中x是观测数据,z是隐藏变量,θ是模型参数。这个期望值被用来作为下一次迭代的辅助函数。

M-step(最大化步):在E-step得到的期望值基础上,通过最大化这个辅助函数来更新模型参数。这一步骤的目标是找到使辅助函数Q达到最大的参数值。对于Gaussian Mixture Model(高斯混合模型)或 Hidden Markov Model(隐马尔科夫模型)等概率模型,这通常涉及到求解使得Q函数最大的θ的值。

EM算法的优化过程可以视为在每次迭代中寻找一个新的参数估计,使得观测数据的对数似然函数或者其下界ELBO(Evidence Lower Bound)增加。Jensen不等式在这里起着关键作用,它保证了在E-step和M-step之间进行的这种交替优化过程中,对数似然函数的值不会减少。

在EM算法的应用中,GMM(高斯混合模型)是一个常见的例子。GMM假设数据是由多个高斯分布混合生成的,而每个数据点属于哪个高斯分布是未知的,即隐藏变量。通过EM算法,我们可以有效地估计出每个高斯分量的均值、方差和权重。

在实际应用中,EM算法可能遇到局部最优的问题,即算法可能会收敛到一个非全局最优的解。为了解决这个问题,可以通过多次运行EM算法,每次都从不同的随机初始参数开始,然后选择导致最大似然估计的解。

EM算法是一种强大的工具,用于解决含有隐藏变量的概率模型的参数估计问题。它通过迭代的方式逐步改进参数估计,使得模型能够更好地解释观测数据。虽然存在局部最优的风险,但在许多实际场景下,EM算法仍然表现出色,并被广泛应用于各种领域,如图像识别、自然语言处理、生物信息学等。

评论0