考点整理1

需积分: 0 164 浏览量

更新于2022-08-08

收藏 921KB DOCX 举报

【考点整理1】

神经网络是深度学习的基础,其中包括多种架构,如深度神经网络(DNN)、卷积神经网络(CNN)、循环神经网络(RNN)以及门控循环单元(LSTM)。这些网络各有特点,适应不同的任务场景。

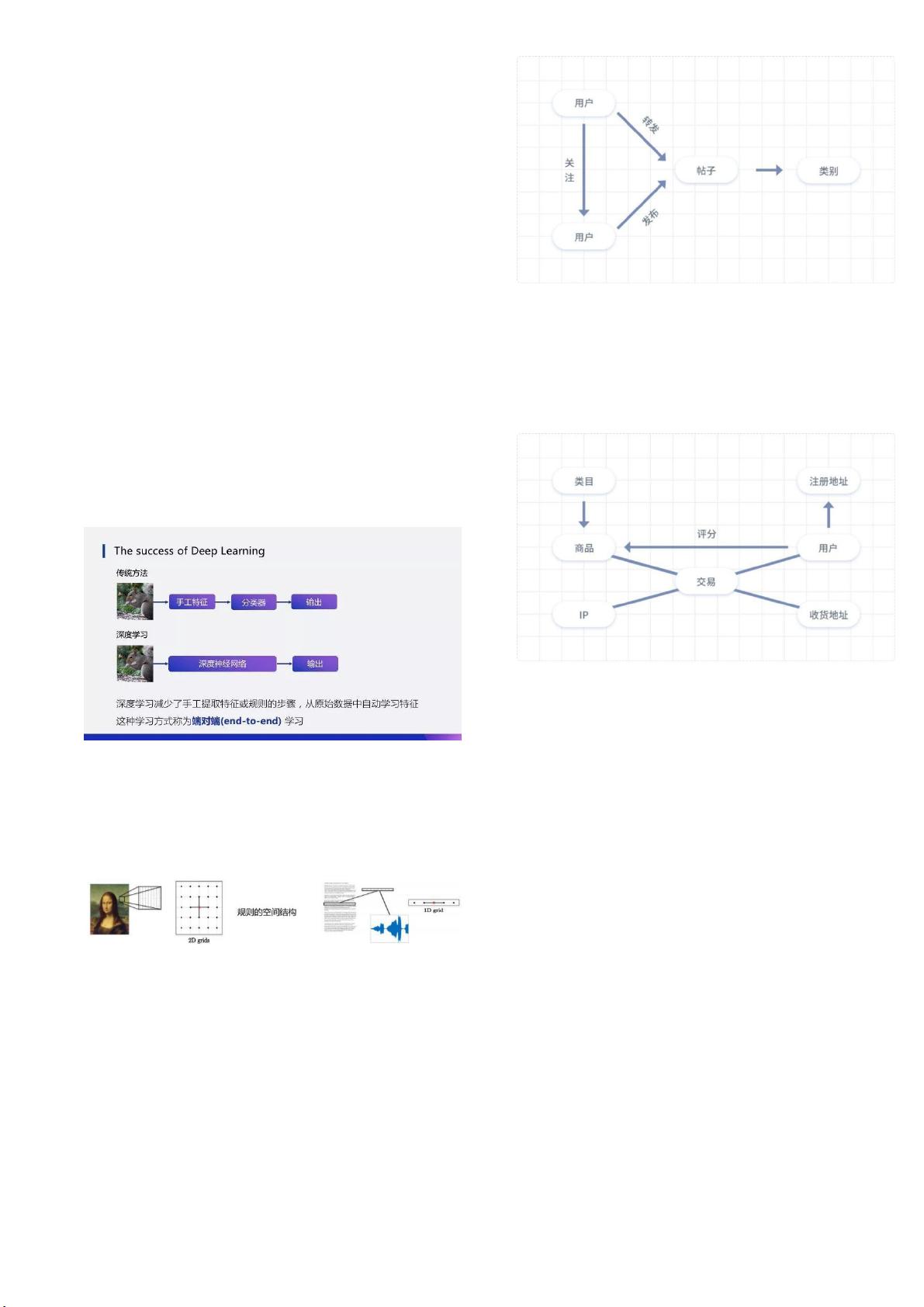

深度神经网络(DNN)是一种全连接的前馈神经网络,适合于分类任务,如数字识别。然而,由于全连接结构导致的大量参数,DNN在实际应用中需要大量标注数据以避免过拟合。相比之下,卷积神经网络(CNN)利用卷积层和池化层对图像等网格状数据进行处理,能够捕获空间上的局部特征,广泛应用于图像识别和计算机视觉任务。CNN的一个关键特性是权值共享,这减少了模型复杂度,同时提高了计算效率。

循环神经网络(RNN)则针对序列数据,如语音和文本,尤其适合处理有依赖关系的数据。RNN通过其循环结构保留了时间序列中的历史信息,但标准RNN在处理长序列时可能会遇到梯度消失或爆炸问题,因此LSTM被提出以改善这个问题。LSTM能更好地记住长期依赖,且在诸如机器翻译等任务中表现优异。

自编码器(Auto-encoder)是一种无监督学习方法,主要用于降维和数据恢复。去噪自编码器(Denoising Auto-encoder)能通过学习去除输入噪声,从而增强数据的表示能力。

图卷积网络(GCN)适用于处理图结构数据,例如社交网络和推荐系统。GCN通过图卷积操作实现了节点特征的传播,每个节点的特征是自身及邻居节点特征的加权和。这使得GCN在处理非欧几里得结构数据时展现出优势。

DNN与CNN的区别主要在于DNN对全局特征的提取,而CNN关注局部特征并通过卷积和池化保持空间信息。CNN的卷积层神经元仅与部分相邻神经元相连,共享权重,降低了模型复杂度。

DNN与GCN在节点分类任务上的区别在于,GCN利用图的拓扑结构进行特征传播,每一层节点特征是邻居节点特征的加权组合。相比DNN,GCN更适合处理非线性、非欧几里得结构的数据。

DNN与RNN的区别在于DNN无法捕捉时间序列信息,而RNN通过循环结构能处理任意长度的序列数据,其隐藏状态包含了历史信息,使其在处理时间相关任务时更为强大。

这些网络架构在深度学习中有各自的适用范围,选择哪种模型取决于具体任务的需求,如数据类型、特征结构以及是否存在时间序列依赖等。理解并熟练运用这些模型是提升模型性能的关键。

洪蛋蛋

- 粉丝: 31

- 资源: 334

最新资源

- 基于RedisSpider分布式爬虫实现高分项目+详细文档+全部资料.zip

- 基于scrapy的大规模定向爬虫高分项目+详细文档+全部资料.zip

- 基于scrapy的爬虫,抓取新华财经文章存入ES做为语料高分项目+详细文档+全部资料.zip

- 基于scrapy框架的爬虫,用以爬取中药材和中西成药的信息高分项目+详细文档+全部资料.zip

- 基于SSM+maven+httpClient+jsoup实现的java爬虫项目,一个完整的小说网站高分项目+详细文档+全部资料.zip

- 基于Scrapy爬虫获取相关旅游信息,并将数据可视化此项目为出游选择目的地提供解决方案高分项目+详细文档+全部资料.zip

- 基于WebMagic的b站视频爬虫高分项目+详细文档+全部资料.zip

- Lecture 9-August 30 (Tutorial).pptx

- 焊接相关国内外标准汇编.pdf

- Lecture 10-August 31.pptx

- Web网页设计期末大作业(完美大作业).zip

- 基于WebMagic封装的垂直爬虫高分项目+详细文档+全部资料.zip

- 基于Winform的一套商家管理工具,用来练习界面布局,自动更新,事件,异步,多线程,网络请求,缓存使用,任务存储,设计模式,爬虫流程,反爬虫机制等高分项目+详细文档+全部资料.zip

- 基于爬虫和文本挖掘技术对知乎上的主题进行分析高分项目+详细文档+全部资料.zip

- 基于豆瓣电影的爬虫实例高分项目+详细文档+全部资料.zip

- 基于若依的爬虫百度云爬虫高分项目+详细文档+全部资料.zip