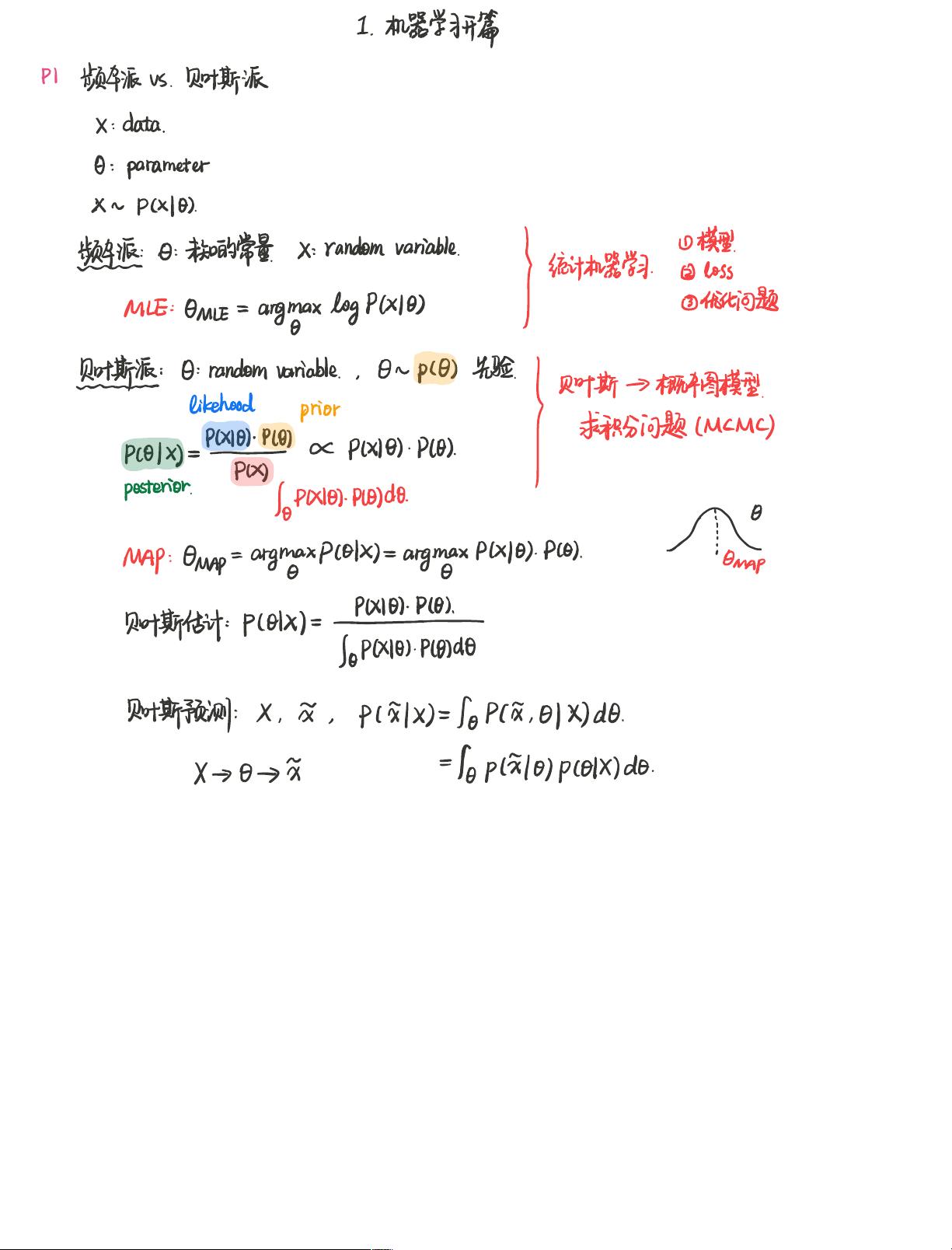

机器学习是计算机科学的一个分支,它涉及数据驱动的模型构建,通过分析大量数据来学习规律并做出预测或决策。在“01 机器学习开篇1”中,我们主要探讨了两种主流的方法论:频率主义派和贝叶斯派,以及它们在统计机器学习中的应用。同时,还涉及到了优化问题、随机变量、先验概率和积分计算等核心概念。

频率主义派主要关注数据集的统计特性,通过最大似然估计(MLE)来寻找模型参数。最大似然估计是一种估计参数的经典方法,其目标是找到一组参数,使得在给定数据下,模型的概率密度函数(PDF)最大。这个过程通常涉及到求解优化问题,如梯度下降法或牛顿法,来寻找使似然函数最大化的参数值。

与频率主义派相对的是贝叶斯派,它引入了先验知识。在贝叶斯派中,参数被视为随机变量,具有先验概率分布。当我们有新的观测数据时,通过贝叶斯公式,可以更新我们的先验知识,得到后验概率分布。后验概率是我们在已知数据和先验信息的情况下对模型参数的最新理解。在某些情况下,如图模型,我们需要解决积分问题来获得后验概率。这可能非常复杂,尤其是当模型具有大量的参数或变量时。

此外,我们还提到了最大后验概率估计(MAP),这是一种结合了最大似然估计和贝叶斯框架的方法。在MAP估计中,我们寻找使得后验概率最大的参数,即在考虑了先验知识的情况下,使得似然函数乘以先验概率最大的参数值。

在机器学习中,这些理论不仅用于模型训练,也用于预测。例如,贝叶斯预测是利用后验概率分布对新数据进行预测的过程。假设我们有一个观测数据集,并且已经得到了参数的后验分布,那么对于新的输入,我们可以计算其属于各个类别的后验概率,从而做出预测。

总结来说,“01 机器学习开篇1”涵盖了机器学习的基本思想,包括频率主义和贝叶斯统计,以及它们在模型参数估计和预测中的应用。优化技术、随机变量、先验和后验概率的概念是理解机器学习模型构建和学习过程的关键。这些知识对于进一步深入学习监督学习、非监督学习、深度学习等机器学习子领域至关重要。

评论0