CS231n课程笔记翻译:线性分类笔记(中) - 知乎专栏1

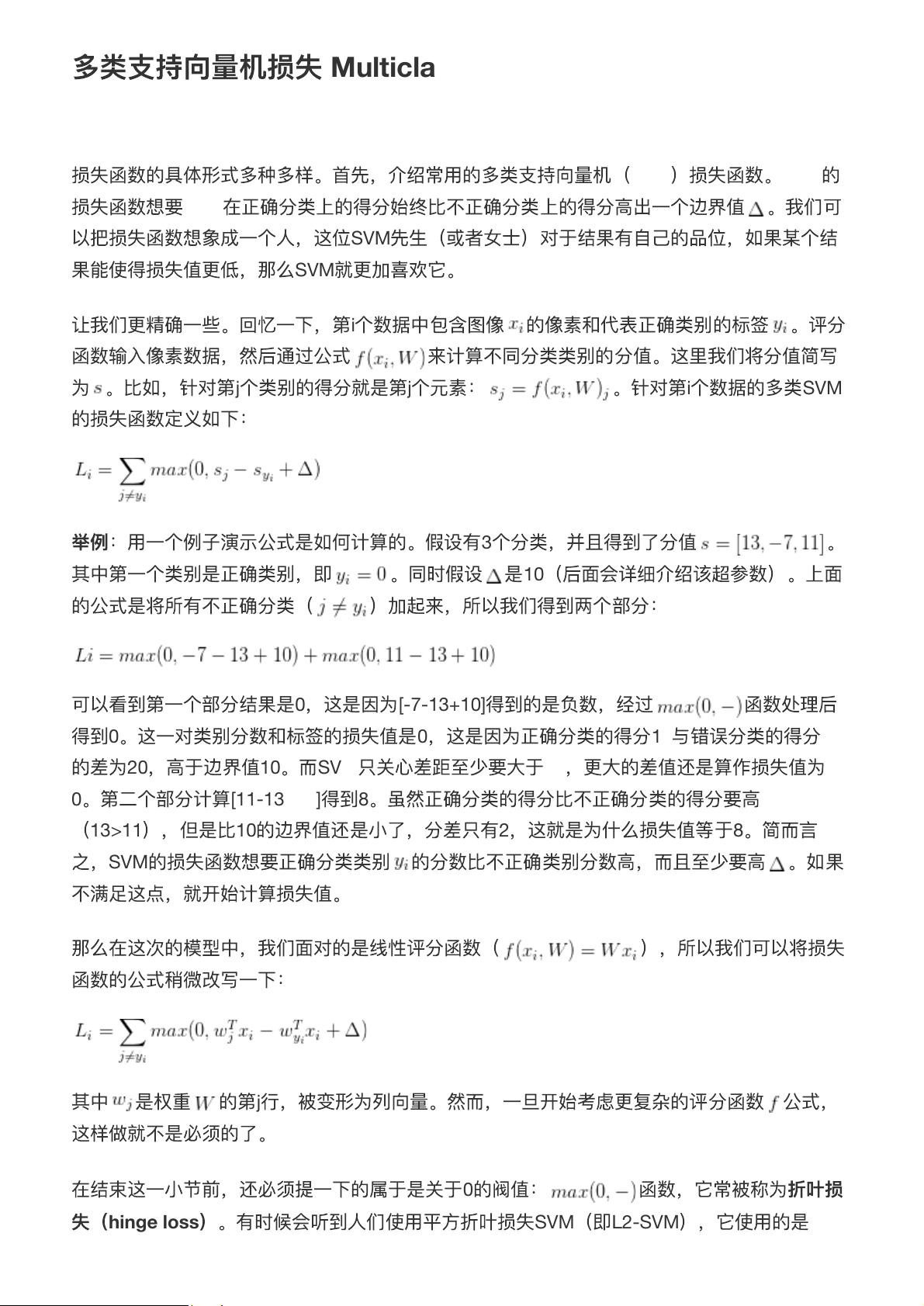

【线性分类简介】 线性分类是机器学习中一种基础且重要的方法,它通过构建一个线性函数,将输入特征映射到一个连续的评分,然后根据评分来判断输入属于哪个类别。线性分类器简单易理解,适用于解决特征与类别之间存在线性关系的问题。在图像识别、文本分类等任务中,线性分类器常作为初步模型或基础模块。 【线性评分函数阐明】 线性评分函数通常表示为,其中是输入样本,是权重矩阵,是偏置项。该函数计算出每个类别的评分,较高的评分意味着该样本更有可能属于该类别。例如,在多类分类问题中,每个样本会有针对每个类别的评分。 【线性分类器损失函数】 损失函数是用来评估模型性能的指标,它衡量模型预测结果与实际结果的差异。在上述内容中,提到了多类支持向量机(SVM)的损失函数。SVM损失函数,也称为折叶损失(Hinge Loss),其目标是确保正确分类类别的评分至少比其他类别高出一个阈值(delta)。如果这个条件未满足,损失函数就会计算超出阈值的部分。 损失函数的形式为: 这里的表示第i个样本,表示第j个类别的评分,表示正确类别的标签。如果,则第一部分损失为0;否则,损失为。第二部分损失是所有不正确类别的评分与正确类别评分之差减去的绝对值,但仅当这个差值小于时才计算损失。 【多类SVM与Softmax的比较】 多类SVM主要关注正确分类与其他分类之间的差距,而Softmax分类器则是一种概率模型,它通过softmax函数将每个类别的评分转换为概率分布,使得所有类别的概率和为1。相比于SVM,Softmax分类器提供了每个类别的相对可能性,更适合多分类问题,且可以自然地解释为概率估计。 【正则化】 正则化是防止模型过拟合的关键技术,通过添加一个正则项(如L1或L2范数)到损失函数中,限制权重矩阵的大小。在上述内容中提到,如果损失函数仅为0,意味着权重W可以有无数种解。通过引入正则化,我们可以选择具有最小正则化项的W,这通常会导致更简洁、泛化能力更强的模型。L1正则化倾向于产生稀疏权重,而L2正则化则使权重更平滑,防止权重过大导致过拟合。 线性分类是通过线性评分函数和合适的损失函数来实现的,而正则化则帮助我们在优化模型性能的同时防止过拟合。多类SVM和Softmax是两种常见的多分类方法,各有其优势和应用场景。理解并熟练运用这些概念和技术是提升机器学习模型性能的基础。

剩余6页未读,继续阅读

- 粉丝: 26

- 资源: 286

我的内容管理

展开

我的内容管理

展开

我的资源

快来上传第一个资源

我的资源

快来上传第一个资源

我的收益 登录查看自己的收益

我的收益 登录查看自己的收益 我的积分

登录查看自己的积分

我的积分

登录查看自己的积分

我的C币

登录后查看C币余额

我的C币

登录后查看C币余额

我的收藏

我的收藏  我的下载

我的下载  下载帮助

下载帮助

前往需求广场,查看用户热搜

前往需求广场,查看用户热搜最新资源

信息提交成功

信息提交成功

评论0