中文文本分类方法综述_于游1

需积分: 0 146 浏览量

更新于2022-08-03

收藏 847KB PDF 举报

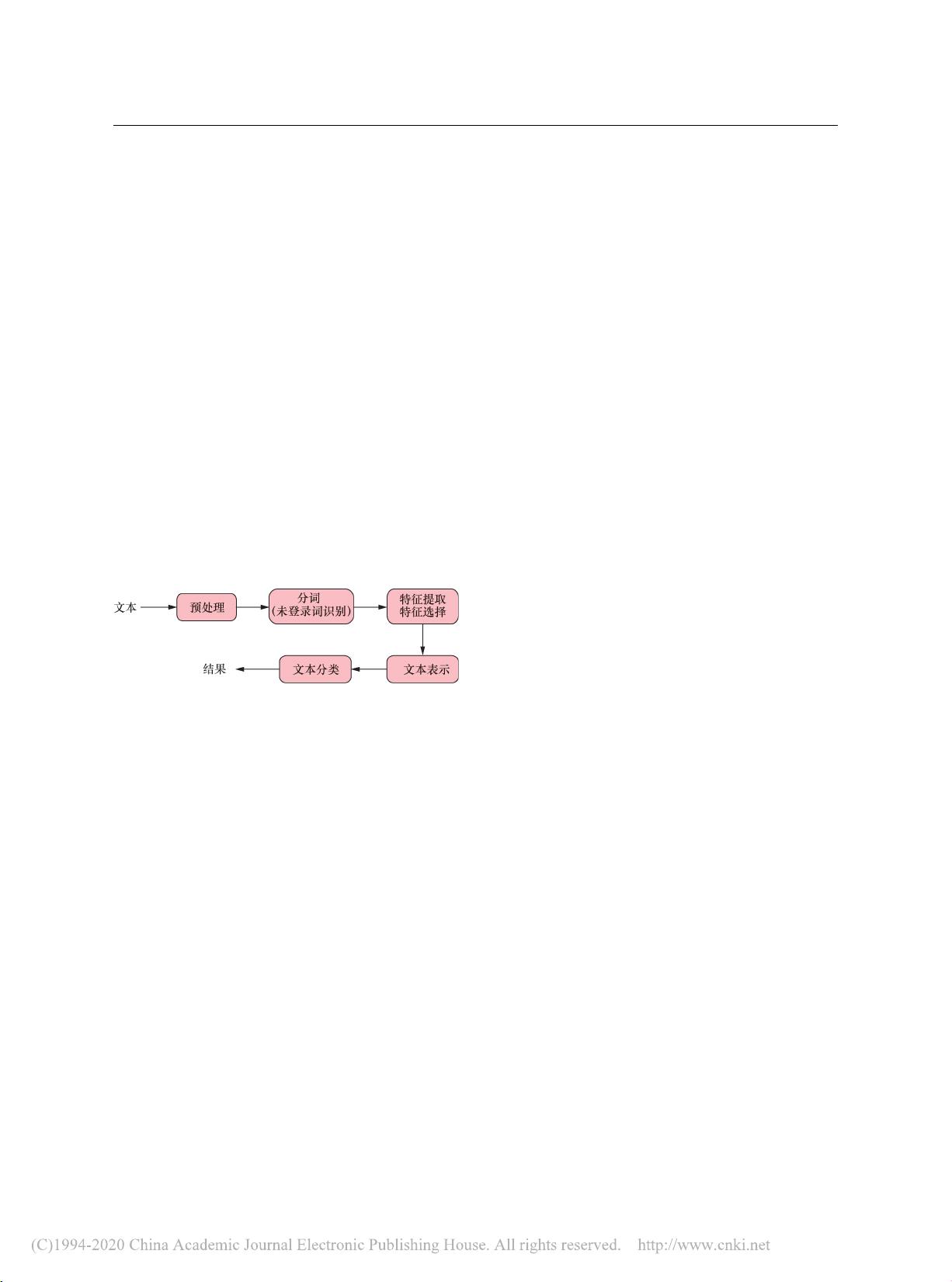

中文文本分类是当前信息技术领域的研究焦点,它涉及到如何高效地将大量文本数据归类到预定义的类别中。这一过程通常包括多个步骤,如文本预处理、分词、特征提取和分类模型的建立。文本分类在信息检索、智能推荐系统、社交媒体监控等多个领域都有广泛应用。

文本分类的概念是基于一定的分类标准或规则,将文本自动分配到相应的类别中。这个过程通常包含四个主要步骤:预处理、分词、特征提取和模型构建。预处理阶段是为了去除文本中的噪声,如标点符号、停用词等,以便更好地进行后续处理。分词是中文文本处理的关键,它将连续的字符序列切割成具有语义意义的词汇单元,对于中文来说,由于没有明显的空格分隔,这一过程相对复杂。分词技术包括基于词典的分词、统计分词和深度学习分词等方法。

接着,特征提取和选择是文本分类中的重要环节。特征是从原始文本中抽取出来,能够反映文本本质属性的信息。常见的特征表示方法有词袋模型(Bag-of-Words)、TF-IDF(Term Frequency-Inverse Document Frequency)以及词向量(Word Embedding)。特征选择则是在所有可能的特征中挑选出最具代表性和区分性的特征,以降低计算复杂度,提升分类效果。

文本分类的方法多样,传统的机器学习方法如朴素贝叶斯、支持向量机(SVM)、决策树等常被用于文本分类。近年来,随着深度学习的发展,卷积神经网络(CNN)、循环神经网络(RNN)、长短时记忆网络(LSTM)以及Transformer等模型在文本分类任务上展现出强大的性能,尤其在处理长文本和理解上下文方面。

然而,现有的文本分类技术还面临着一些挑战,如语义理解的难度、词序信息的处理、多义词和同义词的识别、大规模词汇表的管理以及实时性需求等。为了应对这些挑战,研究人员正在探索更先进的自然语言处理技术,如预训练模型(BERT、GPT等)和自注意力机制,以提高分类的准确性和泛化能力。

未来,文本分类的发展趋势可能包括以下几个方向:一是结合深度学习和传统机器学习的优势,发展混合模型;二是利用更强大的预训练模型提升文本理解能力;三是研究更有效的特征表示和选择方法;四是关注跨语言和跨领域的文本分类问题;五是提高分类系统的实时响应和适应性,以满足大数据环境下快速变化的需求。

中文文本分类是一个涉及多种技术、持续发展的研究领域,随着技术的进步,我们有望看到更高效、准确的文本分类解决方案,为信息管理和智能应用提供强大支持。

赵小杏儿

- 粉丝: 26

- 资源: 314

最新资源

- 数据库应用程序开发银行ATM存取款机系统

- 温度指示报警电路设计资料

- 基于深度学习的文本生成视频的实现源码(毕业设计)

- 机械设计自动拧螺钉阀体装配设备sw2017全套设计资料100%好用.zip

- 同步控制vsg 仿真模型 matlab simulink 电压电流双环控制 同步控制 svpwm 离网 并网均可运行 仿真模型 交流复杂突变 电网频率波动 有功指令突变 均可稳定运行

- 超市订单管理系统ssm

- 中医喉科精义.pdf

- 三相异步电机本体模型 Matlab Simulink仿真模型(成品) 本模型利用数学公式搭建了三相异步电机的模型,可以很好的模拟三相异步电机的运行性能,适合研究电机本体时修改参考,电机的各波形都很好可

- 代码-智能网联汽车先进驾驶辅助系统

- 中医临床经验汇编 第一辑.pdf

- 中医临床经验选编 续集.pdf

- 中医临床经验资料汇编 第二辑.pdf

- 中医临床验案汇辑 第六辑.pdf

- 中医临床经验资料汇编 第一辑.pdf

- 中医千古不传之秘——药性阴阳转变大法.pdf

- T0002 电池舱基础施工图 24.12.28.dwg