机器学习算法总结21

需积分: 0 20 浏览量

更新于2022-08-03

收藏 1.95MB PDF 举报

【机器学习算法总结21】

本文将探讨一种基础的机器学习算法——K近邻(K-Nearest Neighbors,简称KNN)。KNN是一种监督学习方法,用于分类和回归问题。其基本思想是:给定一个新的未知实例,通过查找训练集中与其最接近的K个已知实例(即K个“邻居”),并依据这些邻居的类别进行投票或平均来决定未知实例的类别。

KNN算法的工作原理如下:

1. 计算未知实例与所有训练实例之间的距离。

2. 选择距离最近的K个训练实例。

3. 根据这K个实例的类别进行投票,选择出现次数最多的类别作为未知实例的预测类别,或者对于回归问题,取这K个实例的平均值作为预测值。

在实际应用中,KNN算法面临几个关键问题:

- K值的选择:K值的大小会影响模型的复杂度和泛化能力。较小的K值可能导致过拟合,较大的K值可能增加噪声影响,降低模型的稳定性。

- 距离度量:如何衡量实例间的相似性,常用的有欧氏距离、曼哈顿距离、余弦相似度等。

- 处理类别不平衡:当不同类别的样本数量差距很大时,需要采取策略平衡影响,如加权投票。

- 计算效率:随着数据量的增大,KNN的计算复杂度会提高,因此需要优化搜索策略,如kd树、球树等数据结构。

接下来,我们转向朴素贝叶斯算法。这是一种基于贝叶斯定理和特征条件独立假设的分类方法。

朴素贝叶斯分类器的主要特点包括:

1. 基于贝叶斯定理计算后验概率,目标是最大化后验概率,即期望风险最小化。

2. 假设特征之间相互独立,这使得计算简化,但也是其“朴素”之处,因为现实中的特征往往并非完全独立。

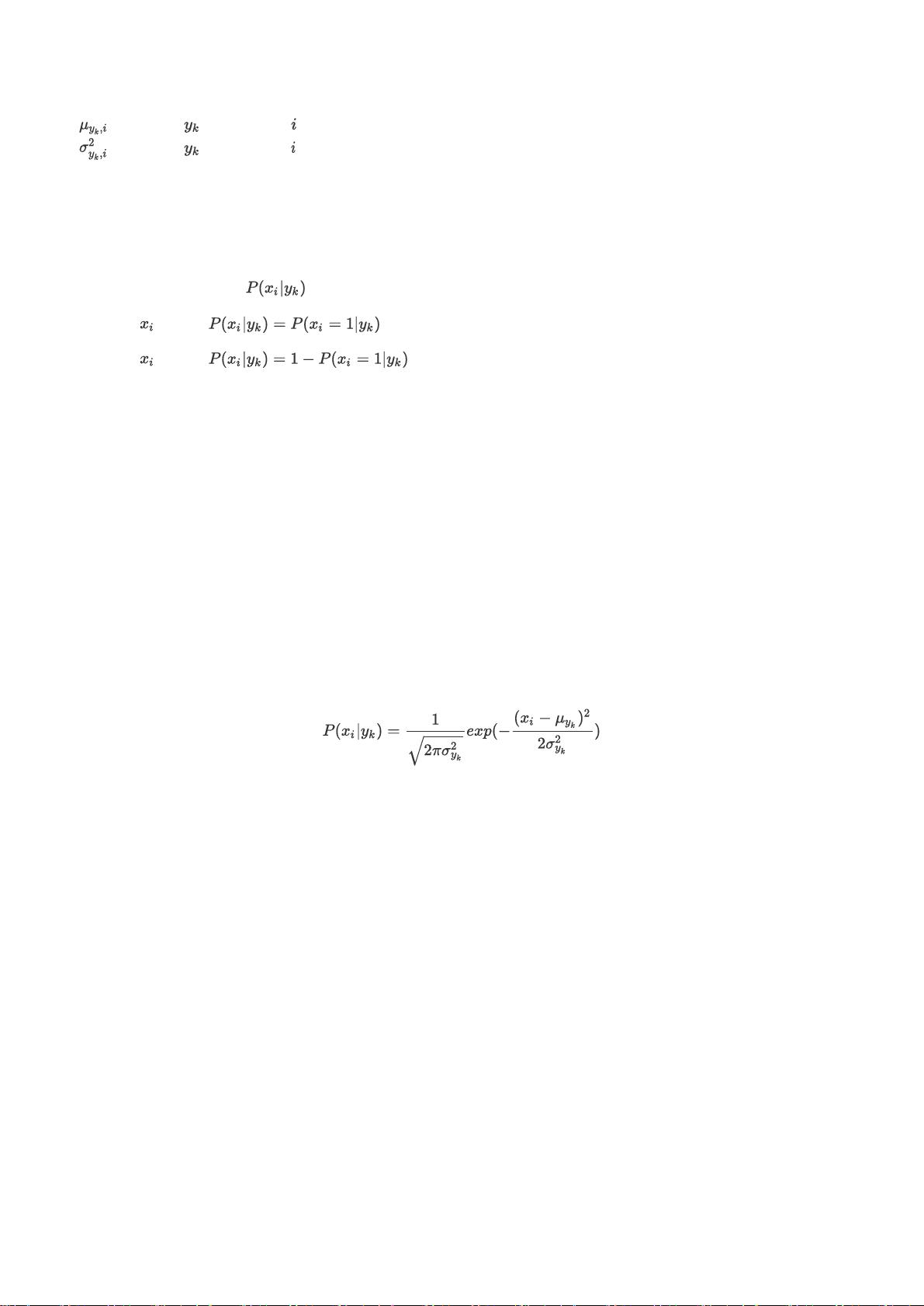

3. 参数估计通常采用极大似然估计,处理连续特征时使用高斯模型(假设特征服从正态分布),离散特征时则使用多项式模型(如拉普拉斯平滑)或伯努利模型(适用于二元特征)。

朴素贝叶斯算法的步骤包括:

1. 训练阶段:计算各类别的先验概率和每个特征对各类别的条件概率。

2. 应用阶段:根据输入的测试样本,通过贝叶斯公式计算后验概率,预测所属类别。

朴素贝叶斯的优点在于计算高效、易于理解,尤其适合大规模数据集。然而,其对特征独立的假设可能在实际问题中过于理想化,可能导致性能下降。相比之下,逻辑回归是一种判别模型,不需要条件独立假设,适应性更强,但在小数据集上可能不如朴素贝叶斯效果好。

在Python的scikit-learn库中,可以方便地实现朴素贝叶斯的各种模型,如GaussianNB(高斯朴素贝叶斯)、MultinomialNB(多项式朴素贝叶斯)和BernoulliNB(伯努利朴素贝叶斯)。

KNN和朴素贝叶斯是机器学习中两种重要的基础算法,各有优缺点,适用于不同的问题场景。理解和掌握这些算法有助于我们构建更强大的机器学习模型。

无声远望

- 粉丝: 1127

- 资源: 298

最新资源

- 课程答疑系统-springboot毕业项目,适合计算机毕-设、实训项目、大作业学习.zip

- 四机两区域,风储调频模型,渗透率可调 内含储能

- 林业产品推荐系统-springboot毕业项目,适合计算机毕-设、实训项目、大作业学习.zip

- 科研工作量管理系统的设计与实现-springboot毕业项目,适合计算机毕-设、实训项目、大作业学习.zip

- 旅游管理系统的设计与实现-springboot毕业项目,适合计算机毕-设、实训项目、大作业学习.zip

- 抗疫物资管理系统-springboot毕业项目,适合计算机毕-设、实训项目、大作业学习.rar

- 快速排序算法:原理、实现与性能分析pdf

- 企业oa管理系统-springboot毕业项目,适合计算机毕-设、实训项目、大作业学习.zip

- 企业级工位管理系统-springboot毕业项目,适合计算机毕-设、实训项目、大作业学习.zip

- 社区医院管理系统-springboot毕业项目,适合计算机毕-设、实训项目、大作业学习.zip

- 美发门店管理系统-springboot毕业项目,适合计算机毕-设、实训项目、大作业学习.zip

- 人格障碍诊断系统-springboot毕业项目,适合计算机毕-设、实训项目、大作业学习.zip

- 美食推荐商城的设计与实现-springboot毕业项目,适合计算机毕-设、实训项目、大作业学习.zip

- 精品在线试题库系统-springboot毕业项目,适合计算机毕-设、实训项目、大作业学习.rar

- 精准扶贫管理系统-springboot毕业项目,适合计算机毕-设、实训项目、大作业学习.zip

- 民宿在线预定平台-springboot毕业项目,适合计算机毕-设、实训项目、大作业学习.zip