资料来源:www.gwylab.com

生成模型---生成对抗网络

V2.0_2019 年 3 月 25 日更

目 录

第一章 初步了解 GANs ...................................................................................................................................3

1. 生成模型与判别模型 ...........................................................................................................................3

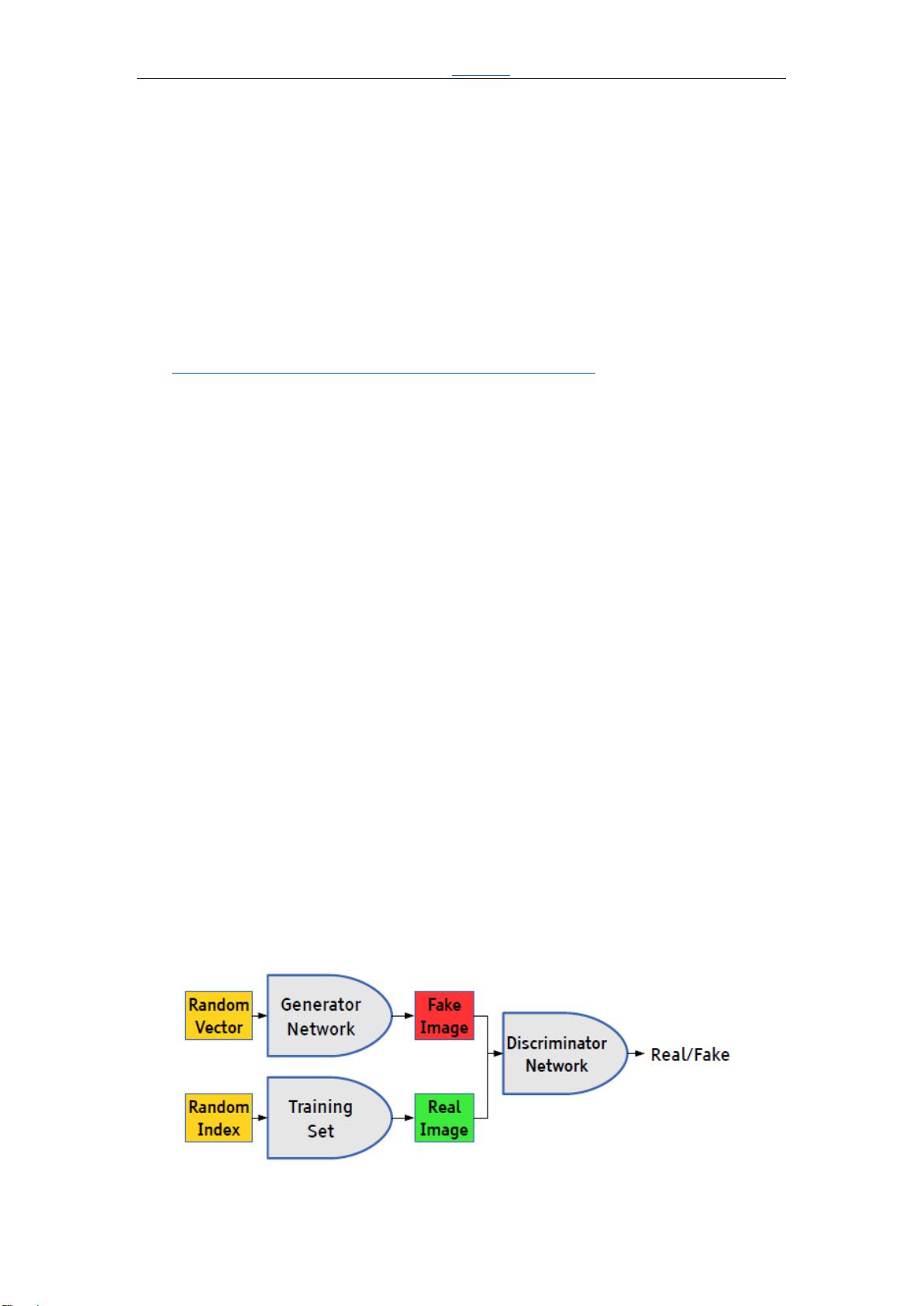

2. 对抗网络思想 ........................................................................................................................................3

3. 详细实现过程 ........................................................................................................................................3

3.1 前向传播阶段...................................................................................................................................4

3.2 反向传播阶段 ..................................................................................................................................4

4. GANs 大家族分类 .................................................................................................................................6

第二章 GANs 的理论与提升 ..........................................................................................................................7

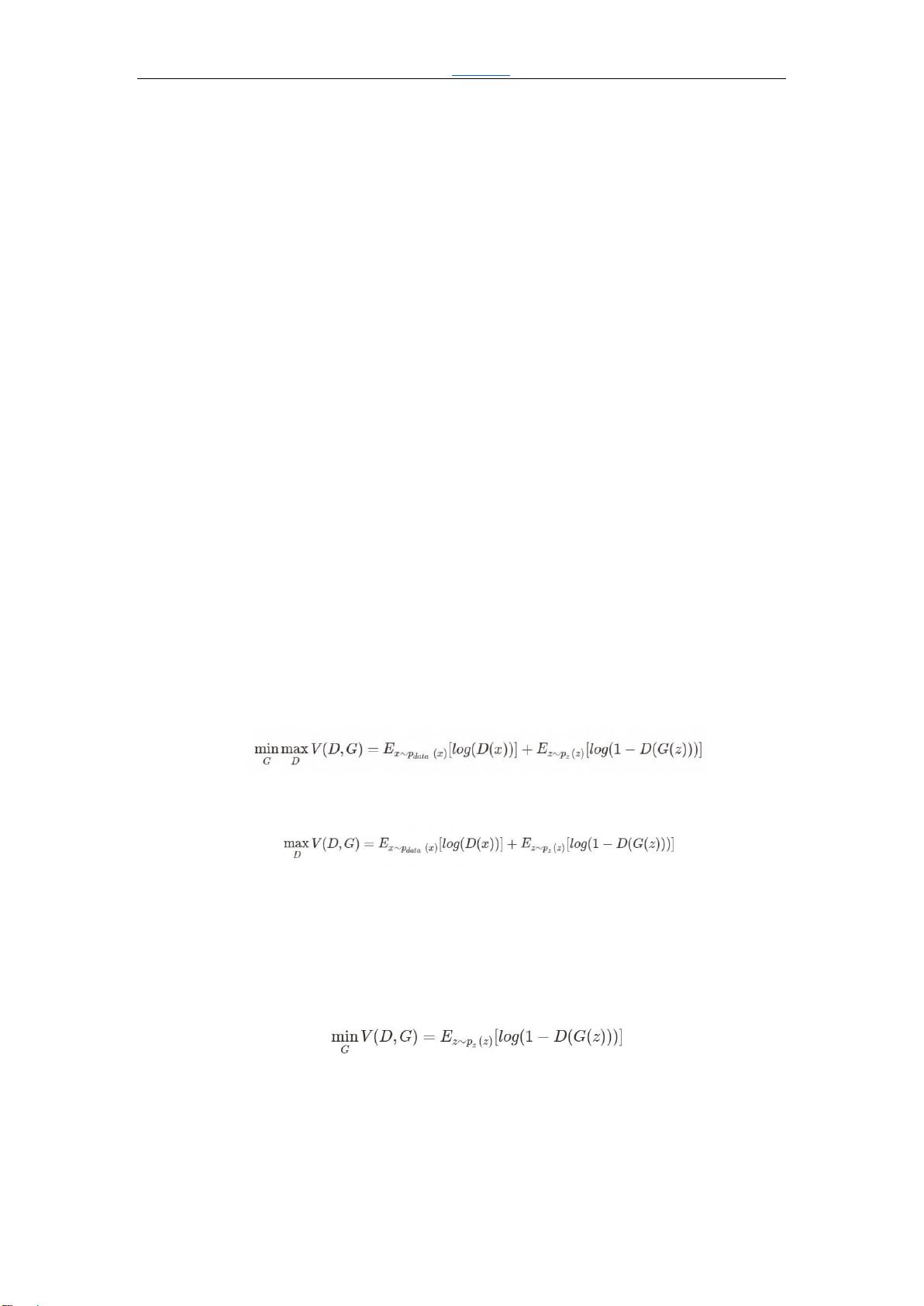

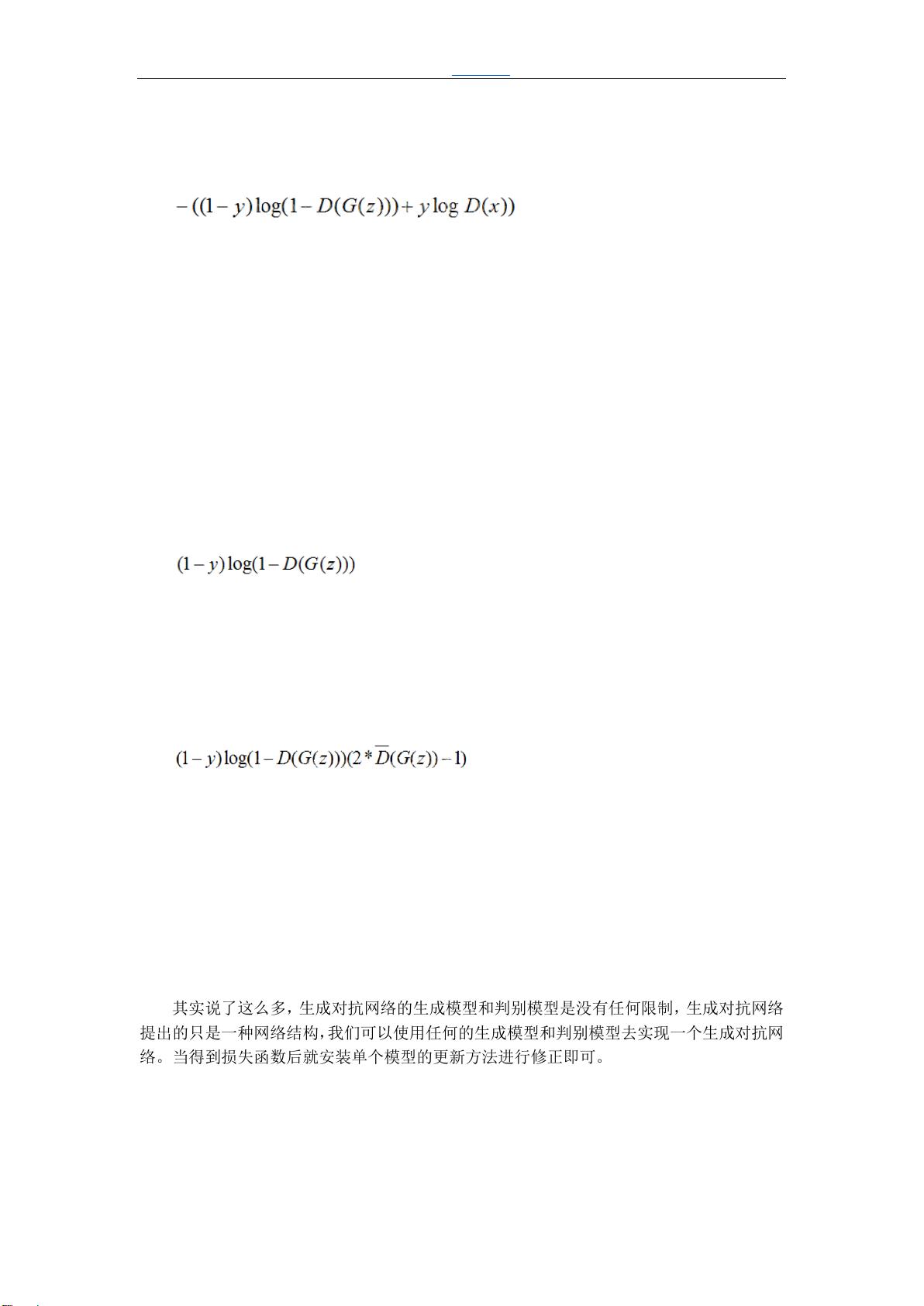

1. GANs 相关理论 ......................................................................................................................................7

Part1 GANs 基于 Div 的改进 .............................................................................................................. 12

1. GANs 并不完美 .......................................................................................................................... 12

2. fGAN——深度理解 GAN 理论 ............................................................................................. 15

3. JS Div 不是最佳的 Div ................................................................................................................... 19

4. LSGAN ............................................................................................................................................ 20

5. WGAN ............................................................................................................................................. 21

6. WGAN-GP ...................................................................................................................................... 24

7. SNGAN............................................................................................................................................ 26

Part2 GANs 基于 Network 的改进................................................................................................... 30

1. DCGAN ............................................................................................................................................ 30

2. ImprovedDCGAN .......................................................................................................................... 32

3. SAGAN ............................................................................................................................................ 34

4. BigGAN ........................................................................................................................................... 36

5. GAN ........................................................................................................................................... 41

Part3 GANs 的其他改进 ...................................................................................................................... 44

1. RGAN .............................................................................................................................................. 44

2. EBGAN ........................................................................................................................................... 46

3.* BEGAN.......................................................................................................................................... 47

第三章 GANs 的应用 ..................................................................................................................................... 48

Part1 GANs 在图像生成上的应用 ..................................................................................................... 48

1. CGAN ............................................................................................................................................ 48

2. TripleGAN .................................................................................................................................. 52

3. StackGAN .................................................................................................................................... 53

4. LapGAN ....................................................................................................................................... 56

5. ProGAN(也称 PGGAN) .................................................................................................... 58

6. StyleGAN ..................................................................................................................................... 60

7.* SRGAN ....................................................................................................................................... 64

Part2 GANs 在风格迁移上的应用 ..................................................................................................... 65

1. CycleGAN .................................................................................................................................... 65

2. StarGAN ...................................................................................................................................... 68

3. 如何解决 BIG TRANSFORMATION ............................................................................... 71