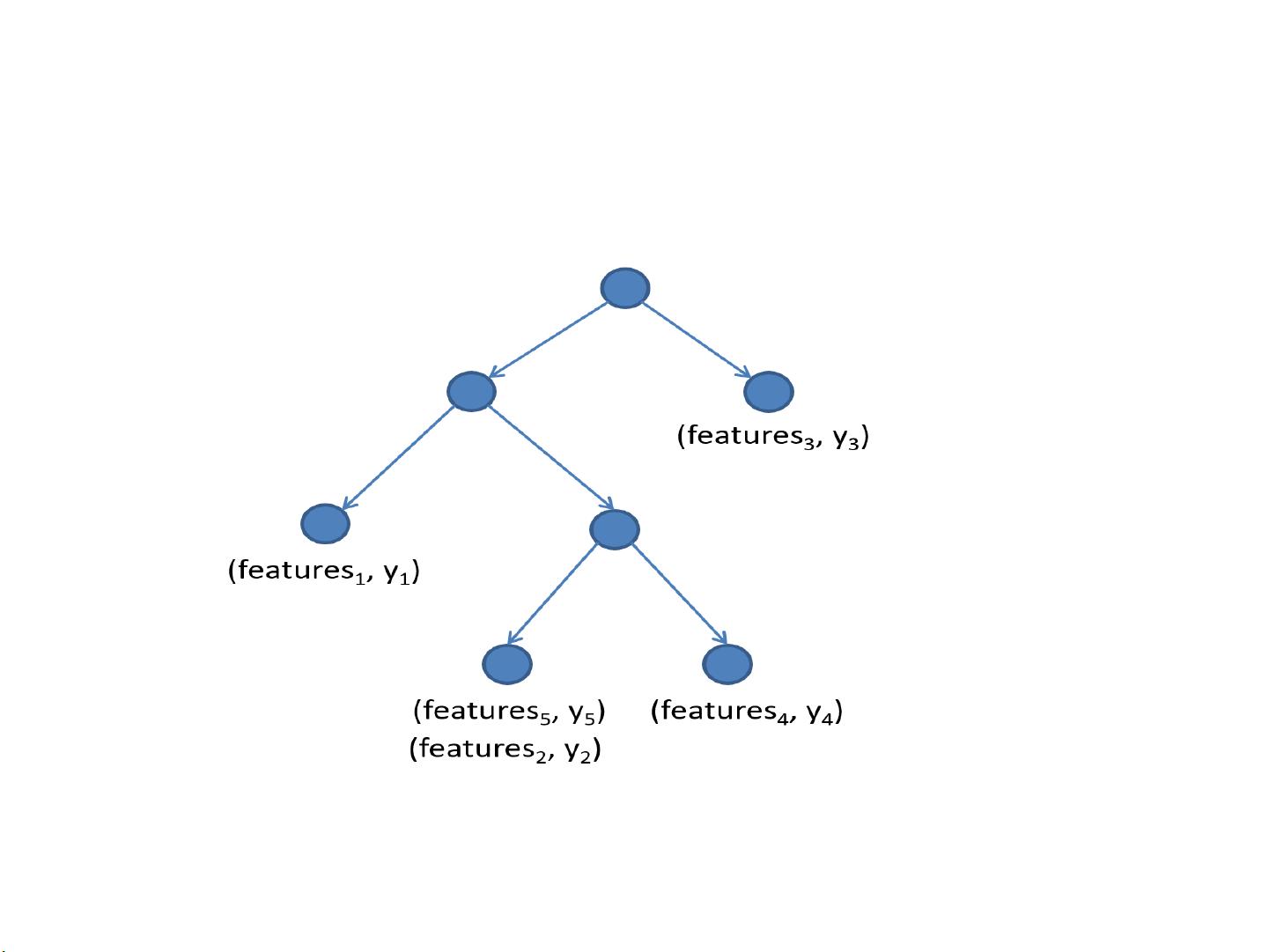

### LightGBM中的GBDT实现 #### GBDT简介与原理 Gradient Boosting Decision Tree (GBDT),即梯度提升决策树,是一种机器学习技术,主要用于解决分类与回归问题。它通过迭代的方式构建一系列弱分类器(通常是决策树),并将这些弱分类器组合成一个强大的分类器。GBDT的核心思想在于利用前一轮训练结果的残差来训练下一轮的弱分类器,以此逐步减少训练数据上的误差。 #### GBDT算法流程 GBDT的算法流程主要包括以下几个步骤: 1. **初始化**:对所有样本进行初始化预测值,通常可以设置为样本的目标值均值或某个常数值。 2. **梯度计算**:对于每个样本,计算其损失函数相对于当前预测值的负梯度,并将其作为新的目标值。 3. **基学习器训练**:基于计算出的新目标值,训练一个基学习器(通常是决策树)。 4. **预测值更新**:根据新训练出的基学习器对样本的预测值,更新每个样本的整体预测值。 5. **迭代过程**:重复步骤2至4,直至达到预设的迭代次数或满足停止条件。 #### LightGBM中的GBDT特点 LightGBM是一个高效的GBDT框架,它在传统GBDT的基础上进行了多项优化,以提高训练效率和降低内存消耗。LightGBM中的GBDT实现具有以下特点: 1. **速度快**:相比于XGBoost,LightGBM能够更快地完成训练过程。 2. **损失函数**:采用针对二分类任务的负二项式分布对数似然损失函数,使得模型在处理二分类问题时更加高效。 3. **内存占用调节**:用户可以根据需求调整模型的内存使用量,选择更高的速度或更低的内存消耗。 4. **特征权重打印**:支持打印模型中各个特征的重要性权重,有助于理解和解释模型。 5. **决策树路径打印**:支持打印出决策树的具体路径,方便用户理解模型如何进行决策。 6. **单次预测特征权重打印**:支持在单次预测过程中打印出每个特征的贡献权重。 7. **样本权重支持**:允许给不同样本分配不同的权重,以反映它们在训练过程中的相对重要性。 8. **Early Stop**:支持提前终止训练过程,避免过拟合。 9. **Bagging+GBDT**:计划支持Bagging与GBDT的结合使用,进一步提升模型的泛化能力。 #### LightGBM中的具体实现细节 1. **特征分桶**:对所有特征值进行分桶归一化处理,以加快直方图的构建过程。 2. **直方图构建**:计算每个特征的直方图统计信息,用于快速评估不同分裂点的增益情况。 3. **分裂收益计算**:根据直方图统计信息计算分裂增益,选择最优分裂特征和分裂阈值。 4. **树的构建**: - 计算直方图。 - 从直方图中获取分裂收益,选择最佳分裂特征和分裂阈值。 - 构建根节点。 - 按照最佳分裂特征和阈值划分样本,递归地构建子树。 - 直到达到预定的叶子节点数量或所有叶子节点都不能再进行分割为止。 5. **预测值更新**:更新每个样本的预测值,利用新训练出的树对样本进行预测,并将结果加权累加到总预测值中。 6. **梯度值更新**:根据当前模型的预测值更新每个样本的梯度值。 7. **并行加速**:利用OpenMP进行并行计算,加速训练过程。 #### 核心数据结构与优化 1. **实例表示**:LightGBM中的实例采用稀疏和稠密混合存储方式,根据特征的非零值比例自动选择存储类型。这种方式能够在保持较高的运算速度的同时降低内存消耗。 2. **二叉树表示**:LightGBM采用数组形式表示二叉树结构,包含右子树索引、左子树索引、叶子节点值、父节点索引等关键信息。 3. **并行加速**:通过OpenMP支持多线程并行计算,显著提高训练速度。 4. **避免重复计算直方图**:通过记录已计算过的直方图信息,避免对同一特征在多个节点上重复计算,从而减少计算量。 LightGBM通过对传统GBDT算法进行多项创新与优化,不仅提高了训练速度,还降低了资源消耗,使得它成为处理大规模数据集的理想选择。

剩余20页未读,继续阅读

zhuguanhao2018-04-10一个没有什么用的ppt,网上可以免费下载,地址大家可以搜索一下,很容易找到。

zhuguanhao2018-04-10一个没有什么用的ppt,网上可以免费下载,地址大家可以搜索一下,很容易找到。

- 粉丝: 0

- 资源: 4

我的内容管理

展开

我的内容管理

展开

我的资源

快来上传第一个资源

我的资源

快来上传第一个资源

我的收益 登录查看自己的收益

我的收益 登录查看自己的收益 我的积分

登录查看自己的积分

我的积分

登录查看自己的积分

我的C币

登录后查看C币余额

我的C币

登录后查看C币余额

我的收藏

我的收藏  我的下载

我的下载  下载帮助

下载帮助

前往需求广场,查看用户热搜

前往需求广场,查看用户热搜 信息提交成功

信息提交成功